参考文献:

嗯,英文论文真是一个好东西,百度到中文的资料真是太缺乏了~

1、Kinect v2和Kinect v1的性能表对比:

其中Kinect v2 的rgb视场(FOV)是84.1 x 53.8。

并且关于FOV的建模和模型可以参考下面的链接:

http://www.smeenk.com/webgl/kinectfovexplorer.html

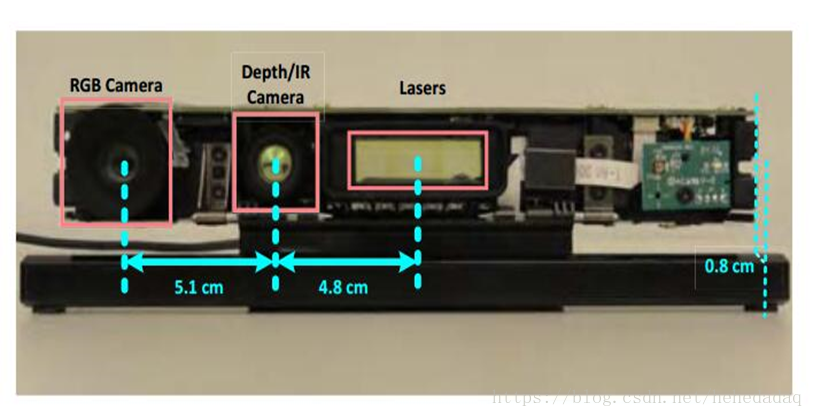

2、Kinect v2的详细结构参数图:

这个0.8cm不是很清楚到底是啥~

其实关于这个22mm,真的很重要,博主之前检测相机深度值是否准确的时候,总是会差一两厘米,也不好测出相机主点到外壳的距离,所以很是头大,上面论文的作者就比较厉害了,他们把相机拆开,真的是测出来了。。。。

3、接下来说一下深度值的问题:

我用过奥比中光的相机和kinect 2,基本上拿到的深度值,都是点到相机平面的距离,而不是点到传感器的直线距离,我就不太清楚这到底是怎么回事儿?之间经历过什么样的计算吗?

在中文网站上的这篇博客,我看到了这样的描述:

深度值和三维数据

只是它没有讲原因,我第一次拿到相机的时候,不是很理解,感觉应该depth是点到传感器的直线距离,但是后来,通过测试,发现应该确实是点到相机平面的距离。

期待大佬讲解其中转化的原理~