上两篇博文都是对深度学习进行一个简要的了解,见识一下这个新的世界。接下来继续学习。

Why Deep?

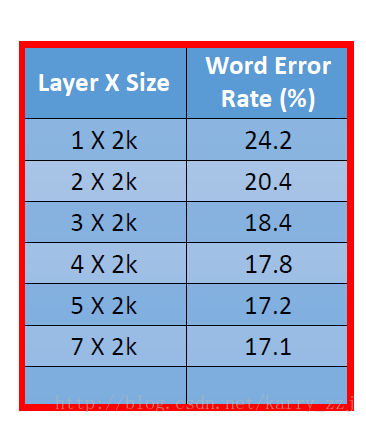

先看一个表格:

我们可以发现,当层X的size越大,出错率越低。所以参数越多,训练效果越好,这是不足为奇的!!

有一个普遍定理:

任何连续的函数

那么我们试想一下神经网络的结构,如果有相同数量的参数,是shallow的结构好呢??还是deep的结构好呢??实践证明,层数越多,训练效果越好,也就是说deep的结构更好。

文章解释到 Deep → Modularization(模块化)

整个训练过程就是一个模块化的过程,神经网络的每层都是一个分类器,经过多层的训练最后就能进行分类。