背景:由于首次安装和启动时,是以root用户进行的,导致很多问题没有被暴露出来,且在生产上也不可能以root用户进行操作,故对起进行重新部署。

1、首先对hadoop该文件夹进行所属用户的变更

chown -R hadoop:hadoop hadoop-2.8.1 注意:这里变更时要以root用户进行操作

2、配置hadoop用户免密钥登录

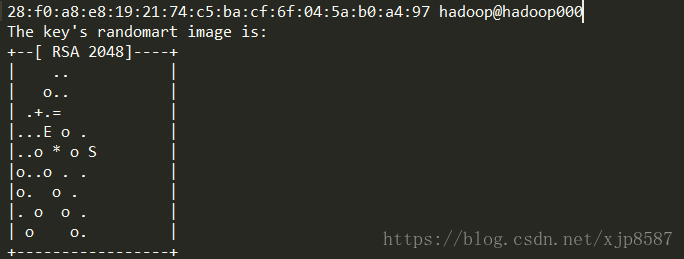

进入到hadoop的家目录 cd ~ 执行ssh-keygen,一致按回车。

接着进入到.ssh(cd .ssh)中,cat id_rsa.pub >> authorized_keys。

注:更具官网提示,这里需要对authorized_keys进行权限给定 chmod 600 authorized_keys

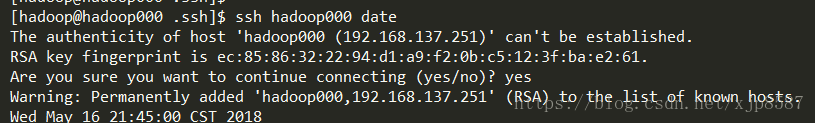

接着接可以通过ssh 连接了,第一次时需要输入yes

这样,hadoop用户的免密钥登录本机就设定好了。

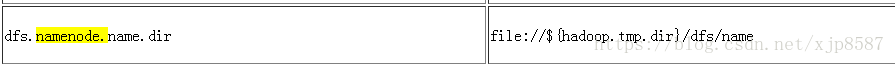

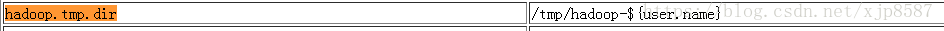

3、删除原来以root用户启动时产生的HDFS文件目录(我们可以将HDFS理解为一个存储,需要重新部署的话,需要把原来的存储的删掉)

可知,文件目录默认存在本机的/tmp/hadoop-*目录下

因此rm -rf /tmp/hadoop-* /tmp/hsperfdata-*

这样原来的文件目录就清理了。

接着对namenode进行格式化 hdfs namenode -format

4、修改配置文件

这里涉及到几个问题

(1)SNN的默认地址为0.0.0.0 这样每次启动时hadoop用户都要ssh该地址,但我们没有配置这个,且这个地址对外提供服务不方便,因此我们需要修改下SNN地址,改为本机的ip

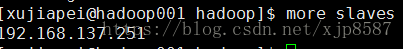

(2)修改slaves

slaves,存放的数据节点的地址,默认的为localhost,这里我们也修改为本机ip

5、这样就可以以hadoop用户进行启动HDFS了。