发现以前学的东西特别容易忘,还是得腾个地儿写一写,有新的理解会继续补充。

信息等基础见下面一篇博

http://leijun00.github.io/2014/07/information-theory/

https://www.cnblogs.com/fantasy01/p/4581803.html

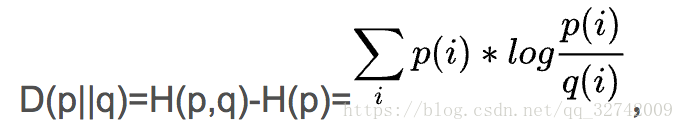

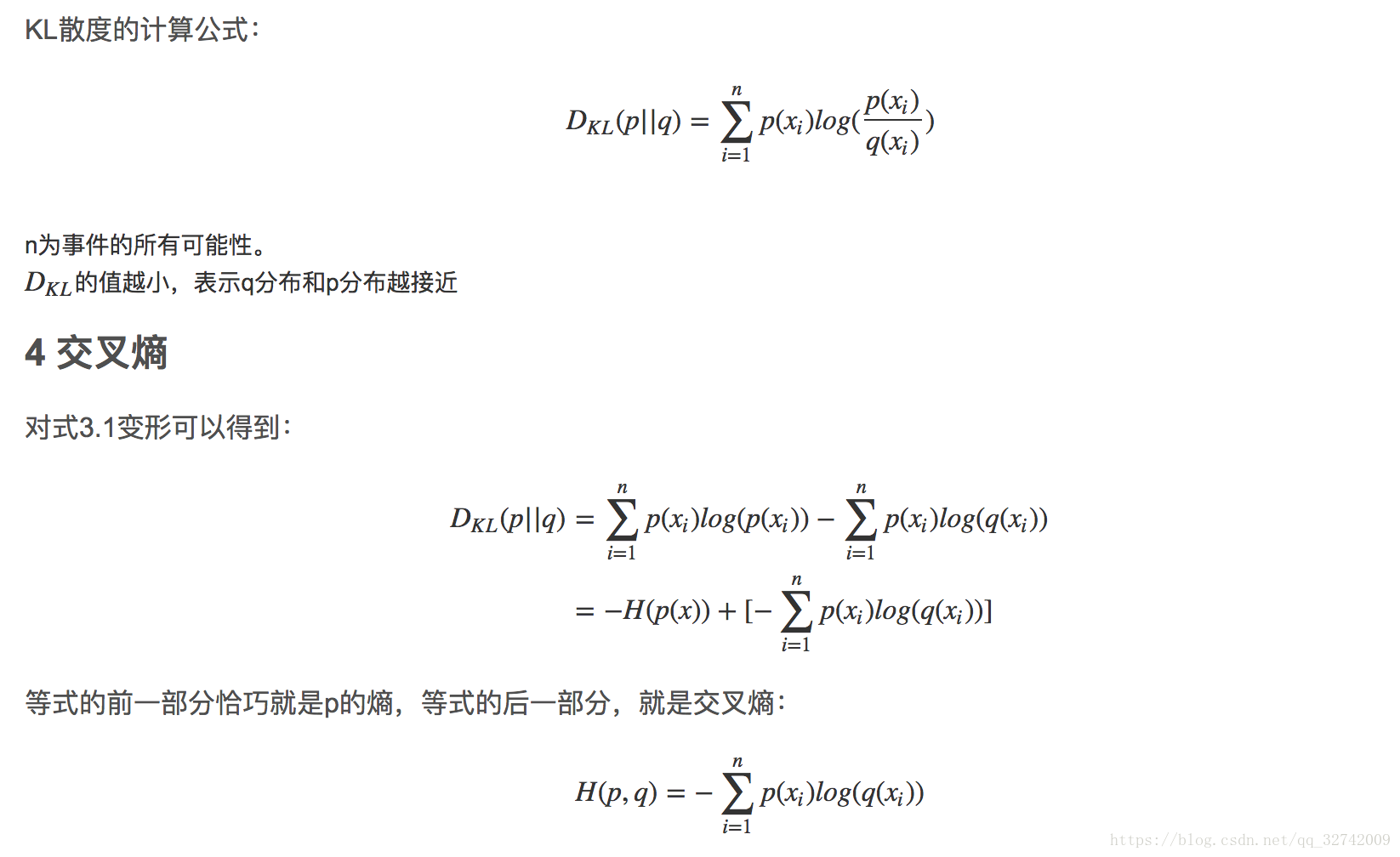

相对熵就是KL散度,表示q分布和p分布有多接近,越小越接近,就是p,q两者之间的交叉熵减去p自己的熵要越小,说明p,q两者之间的交叉熵就相当于是p自己的熵。p,q相同,则就相当于是p一个分布的熵。

H(p,q)即为交叉熵

表示2个函数或概率分布的差异性:差异越大则相对熵越大,差异越小则相对熵越小,特别地,若2者相同则熵为0。注意,KL散度的非对称性。

https://blog.csdn.net/u014465639/article/details/71637477

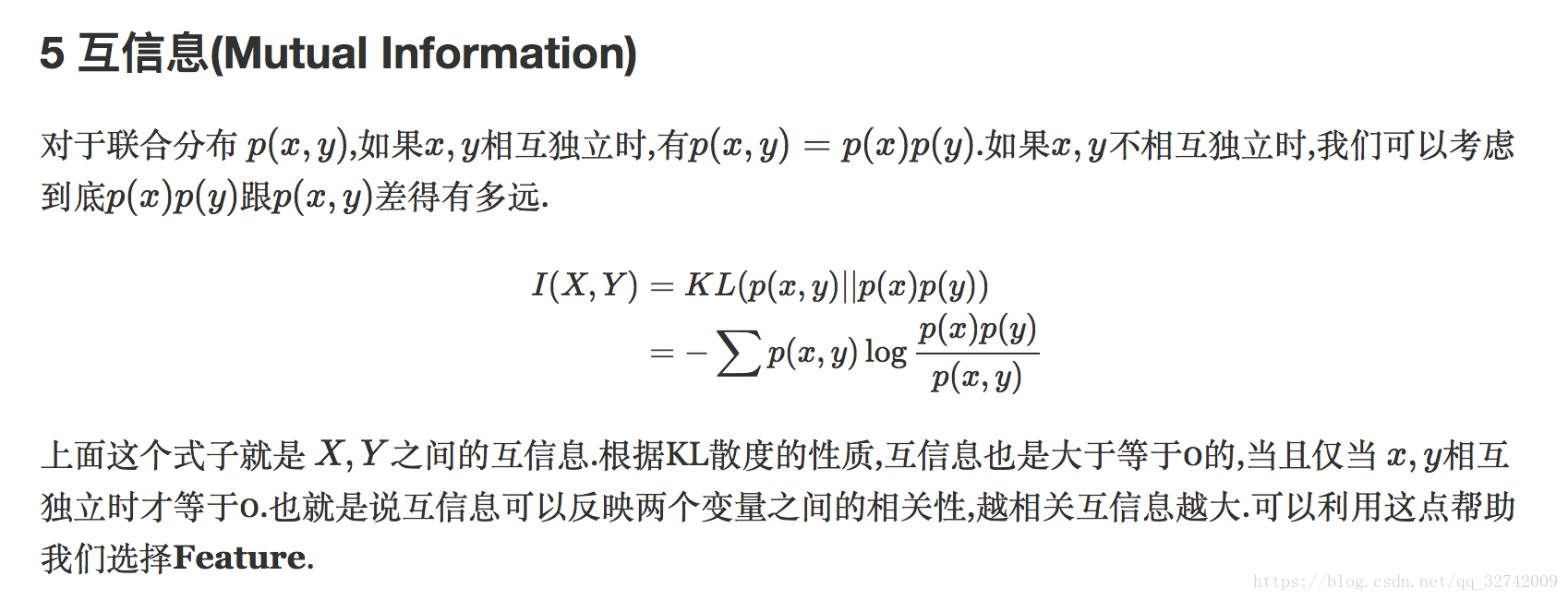

互信息

扫描二维码关注公众号,回复:

2522650 查看本文章

互信息其实就是所说的信息增益。