思考1

kNN算法是一种思想简单的分类算法,即计算预测结点距离它最近的k个结点,然后在这k个结点中看看属于哪个类别数量更多一些,就把它归为那一类。

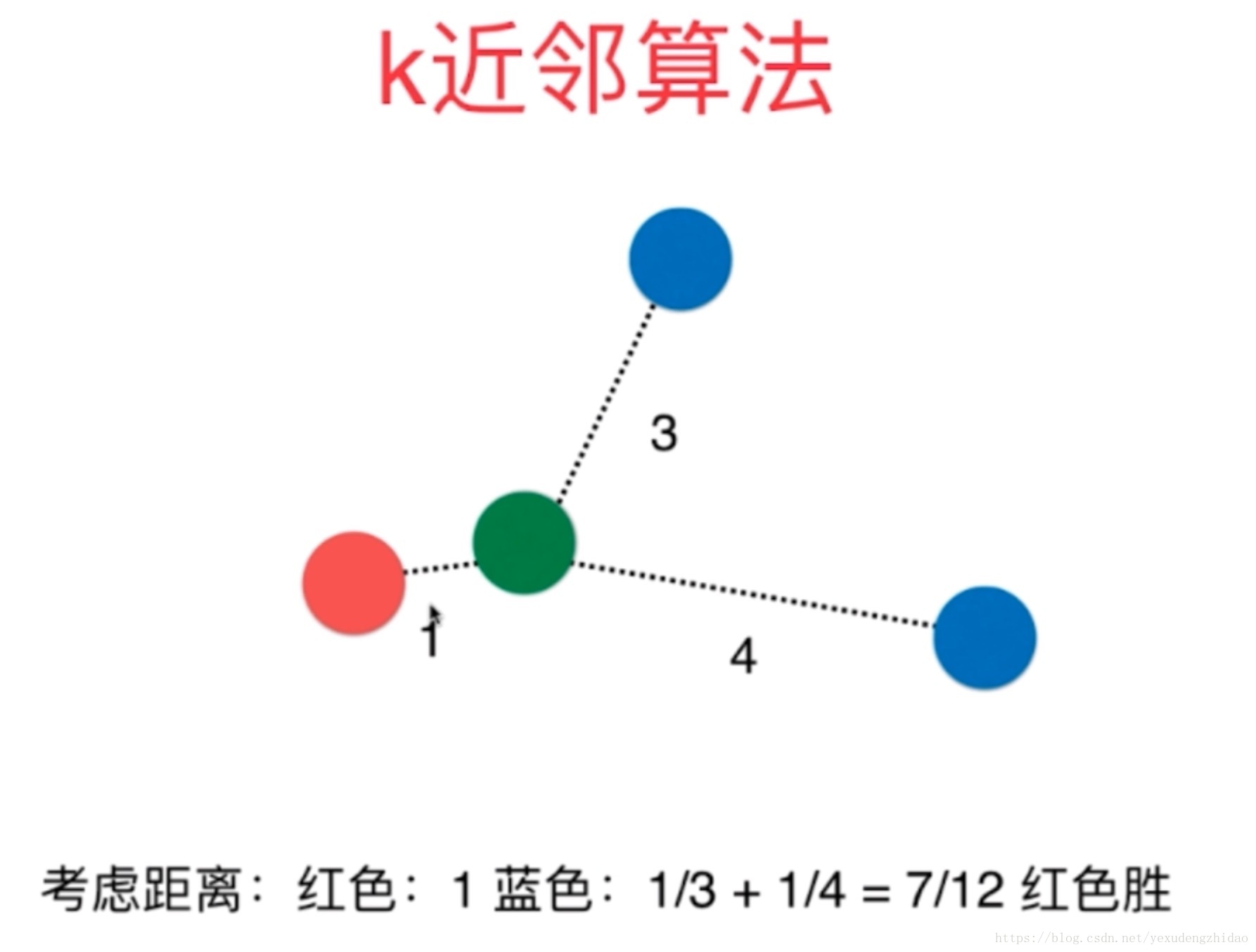

但是,我们忽略了一个问题,那就是距离的权重,如下图所示:我们应该把它归为哪一类呢?

我们可以考虑把距离的倒数作为权重,即:红色距离绿色的权重为1/1=1,蓝色距离绿色的距离为1/3+1/4 = 7/12。 而1 > 7/12,所以应该把绿色归为红色类里面。

思考2

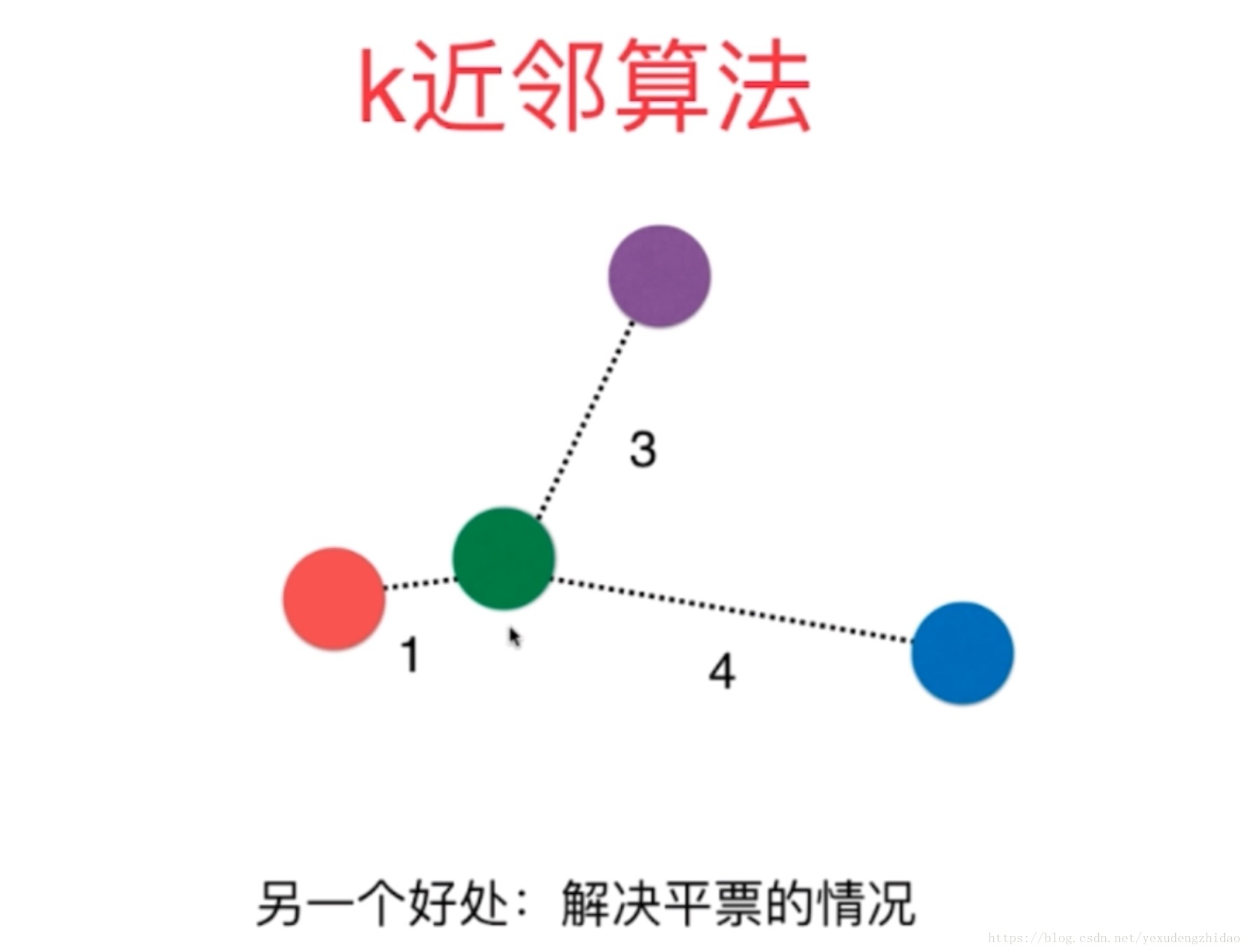

对于下图中的问题,如果按照距离最近的个数来进行分类的话,那么下图中出现了平票,但是如果给加上距离的权重,那么问题就迎刃而解了。

说明:

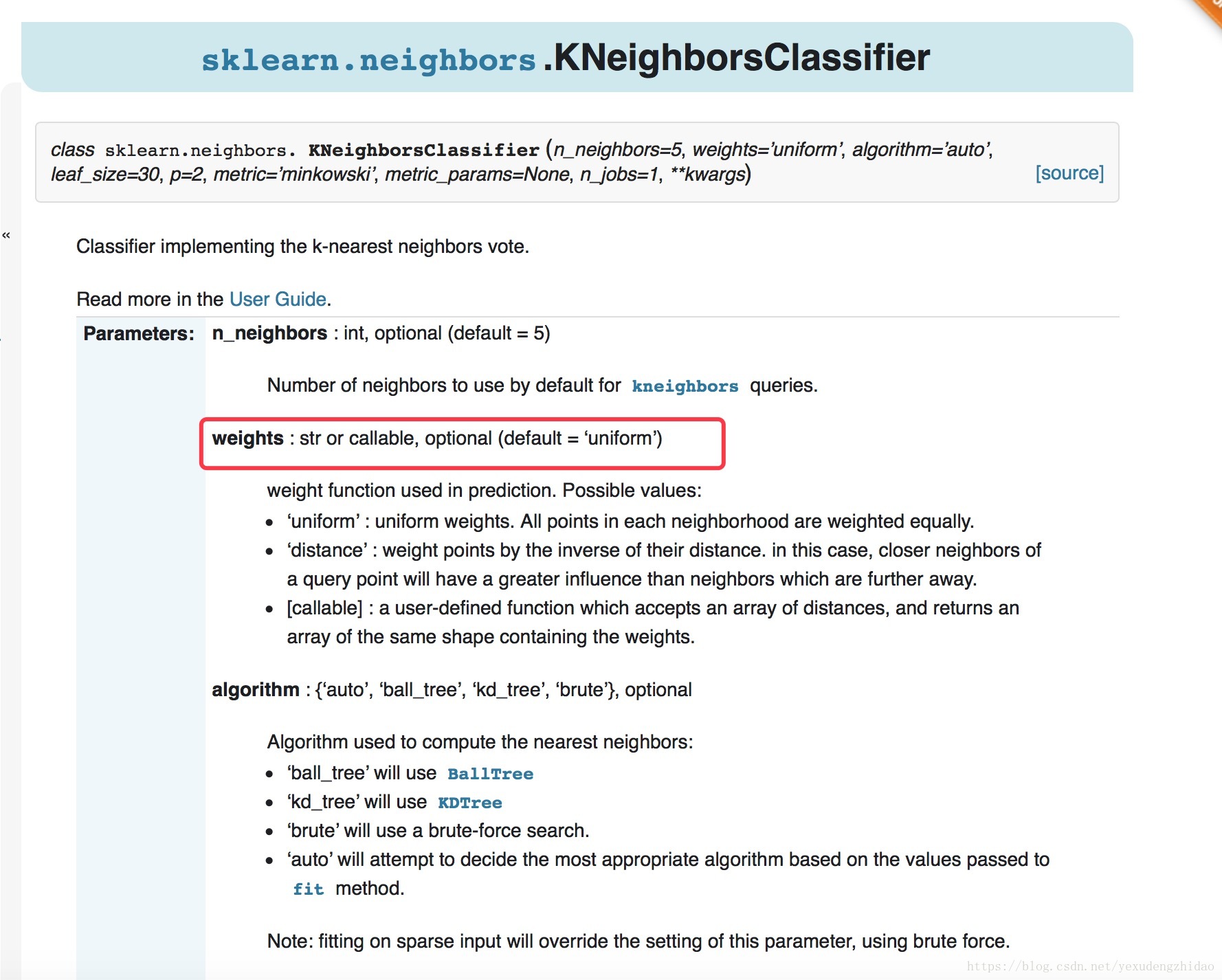

在scikit-learn中,对sklearn.neighbors.KNeighborsClassifier里的参数weight做了默认值为’uniform’即,不做处理。

但是,针对特殊情况,我们还需考虑这个权重的参数。

实战:

在手写识别中我们可以测验对于使用weights参数里的‘uniform’ 准确率更高一些还是使用’distance’准确率更高一些呢?(当然这个需要根据你当前项目跑一下)

for method in ['uniform', 'distance']:

for k in range(1, 11):

kNN_classifier = KNeighborsClassifier(n_neighbors=k, weights=method)

kNN_classifier.fit(X_train, y_train)

score = kNN_classifier.score(X_test, y_test)

if score > best_score:

best_score = score

best_k = k

best_method = method

print('best_k is %s'% best_k)

print('best_method is %s'% best_method)输出结果为:

best_k is 3

best_method is uniform