简单易懂的softmax交叉熵损失函数求导

本博客转自:http://m.blog.csdn.net/qian99/article/details/78046329

来写一个softmax求导的推导过程,不仅可以给自己理清思路,还可以造福大众,岂不美哉~

softmax经常被添加在分类任务的神经网络中的输出层,神经网络的反向传播中关键的步骤就是求导,从这个过程也可以更深刻地理解反向传播的过程,还可以对梯度传播的问题有更多的思考。

softmax 函数

softmax(柔性最大值)函数,一般在神经网络中, softmax可以作为分类任务的输出层。其实可以认为softmax输出的是几个类别选择的概率,比如我有一个分类任务,要分为三个类,softmax函数可以根据它们相对的大小,输出三个类别选取的概率,并且概率和为1。

softmax函数的公式是这种形式:

推导过程如下,记softmax函数为:

损失函数 loss function

在神经网络反向传播中,要求一个损失函数,这个损失函数其实表示的是真实值与网络的估计值的误差,知道误差了,才能知道怎样去修改网络中的权重。

损失函数可以有很多形式,这里用的是交叉熵函数,主要是由于这个求导结果比较简单,易于计算,并且交叉熵解决某些损失函数学习缓慢的问题。交叉熵的函数是这样的:

在这里,yi表示真实的分类结果。

首先,我们要明确一下我们要求什么,我们要求的是我们的loss对于神经元输出(zi)的梯度,即:

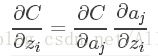

根据复合函数求导法则:

有人可能有疑问了,这里为什么是aj而不是ai,这里要看一下softmax的公式了,因为softmax公式的特性,它的分母包含了所有神经元的输出,所以,对于不等于i的其他输出里面,也包含着zi,所有的a都要纳入到计算范围中,并且后面的计算可以看到需要分为i=j和i≠j两种情况求导。

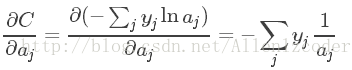

下面我们一个一个推:

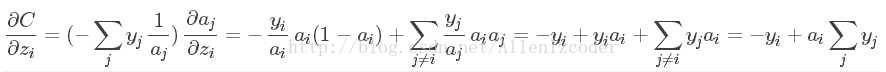

第二个稍微复杂一点,我们先把它分为两种情况:

①如果i=j:

②如果i≠j:

接下来我们只需要把上面的组合起来:

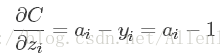

最后的结果看起来简单了很多,最后,针对分类问题,我们给定的结果yi最终只会有一个类别是1,其他类别都是0,因此,对于分类问题,这个梯度等于:

看起来清爽多了,我们算得的梯度就是神经元的输出-1,是不是很神奇呢~