0.前言:

在我们的工程实验中,我们建好了一个模型,数据输入的形状是我们不得不考虑的一个重要问题。我们查看论文,会发现EEG信号大多以a*a的shape作为输入,例如EEG.dara.shape=16*16,在(16,16)前再加上数据本身通道就成了(14,16,16)输入模型中再加上batch_size就变成了(batch_size,14,16,16)这就是4维信号了,但是单论数据来讲,他还是2维的,使用Conv2d网络训练即可。

但是,很少有论文会提及为何以这种shape作为输入,有的会一言两语提及,但是数据处理技术不公布,有的则连input.shape都没有。专门研究输入形状的论文也发表极少,一个研究方向的此类SCI文章几乎只有1~2篇甚至存世为0。这是一个发高水平文章的出发点,我查看了研究EEG.shape的论文,果然国外于2023.1.30日在JCR2区的一个很有分量的老牌期刊上发表了一篇研究shape的文章:Input Shape Effect on Classification Performance of Raw EEG Motor Imagery Signals with Convolutional Neural Networks for Use in Brain—Computer Interfaces,他研究的是我上篇博客提到的数据1维还是2维的输入对比,并没有将shape细分,若是细分的话工作量太大,这也是作者不做的原因吧。

本篇博客我会做一个消融实验,来说明四个问题,每个问题我会写上自己部分的结论,最后整个实验结论可以读者自己总结。

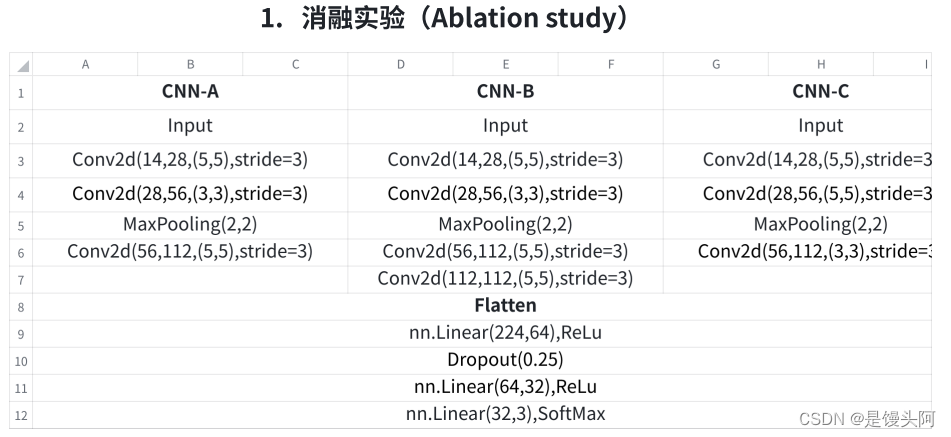

1.消融模型:

这里我建了三个CNN模型,结构如上,使用的数据是国外某实验室的脑力负荷数据集,该数据集14Channels,2.5minutes的数据量为19200,验证问题如下:

1、一维EEG信号是否需要升到二维

这里直接给出我的结论:需要升维,(batch_size,input_channels,H,W)可以探索H*W最佳输⼊尺⼨,ACC⽐(batch_size,input_channels,len(data))要⾼不少。

Conv1d(batch_size,input_channels,len(data))

Conv2d(batch_size,input_channels,H,W)

Conv3d(batch_size,input_channels,D,H,W)

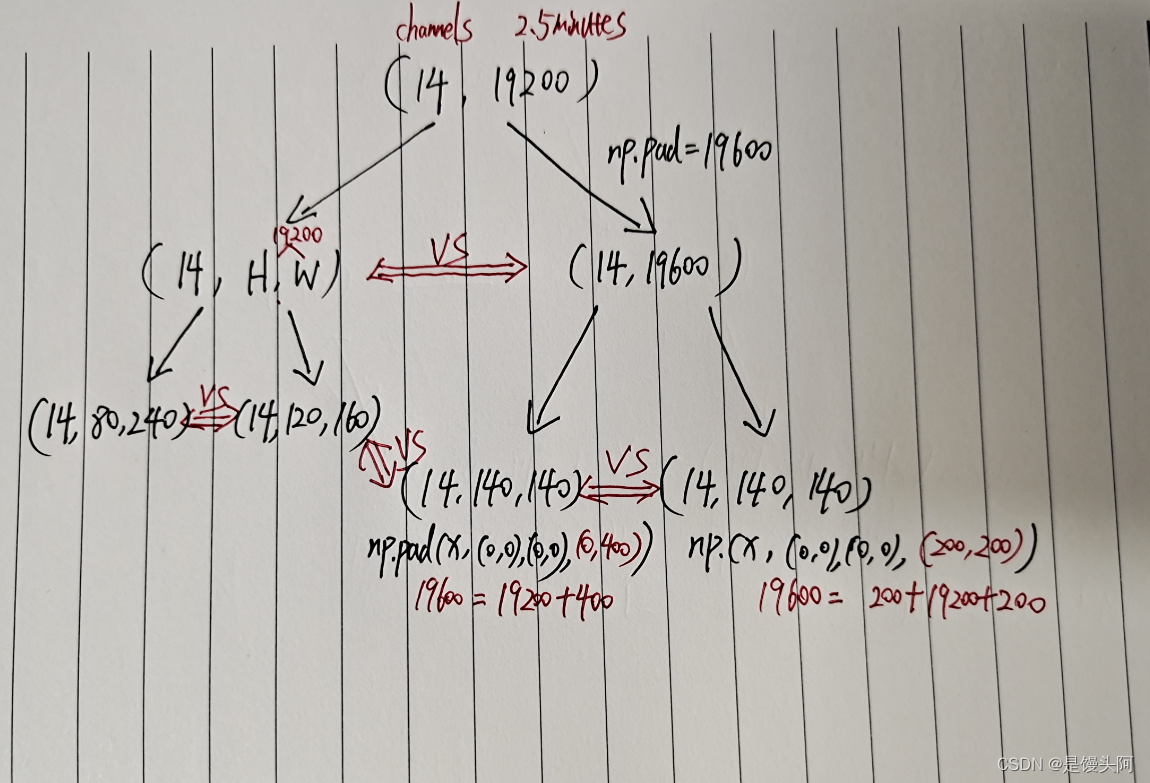

2、填充 or 直接分 (19200填充为19600分为a*a VS 19200直接分a*b)

数据分不成a*a的,也就是data开根号整除不了的,我们需要填充后开根号为a*a,或者直接把数据分开为a*b。

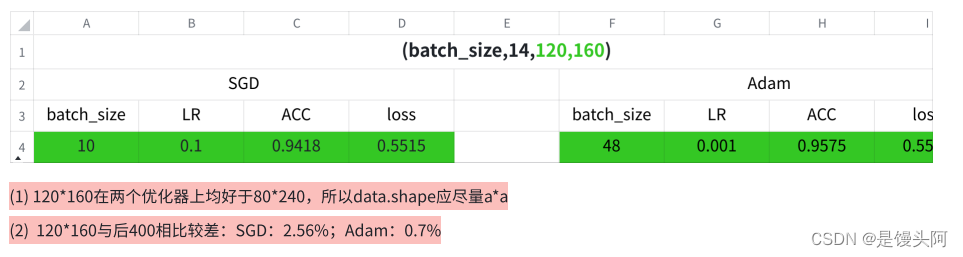

直接给出我的结论:数据填充后分为a*a⽐直接分为a*b更优: SGD:2.56%; Adam:0.71% 所以,若数据开根号整除不了,则需要向后填充使数据能够整除;若数据开根号能整除,则直接分为a*a。

3、填充方式(19200数据后⾯填充400个0变为19600 VS 前后填充200个0变为19600)

上总结:数据后⾯填充⽐前后填充更优:SGD 0.65% ; Adam:1.35%

4、优化器选择:SGD vs Adam

答:⽆论在哪个消融实验中,Adam优于SGD 2% 左右,但Adam需要更⼩的学习率,也验证了Adam对于Lr的不敏感性。这里结果证明并不是SGD不好,SGD难以训练,耗费时间较多,但是训练出来它最终的精度会比Adam高,我这里训练的次数少,所以SGD相当于没训练出来,但本次实验本质并不是探究到底哪个优化器更好的。

这里我说一下优化器选择根本策略:建议先用Adam训练模型,再使用SGD;若二选一,在一般情况下,选择Adam。

我画了个逻辑图,帮助你理清思路:

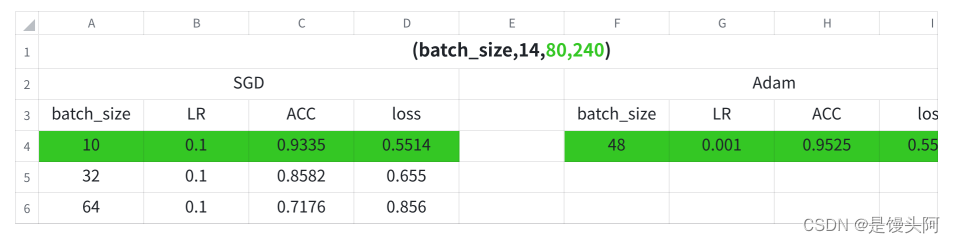

2.实验结果:以CNN-A模型为例

2.1 CNN-A结果(验证填充方式)

2.2 CNN-A结果(直接分 VS padding)

3. CNN-A、CNN-B、CNN-C对比:

使⽤Adam、np.pad(0,400)⽅式,以(batch_size,input_channels,140,140)的输⼊来对⽐CNN-A、CNN-B、CNN-C结果

CNN-A: ACC=0.9646

CNN-B: ACC=0.9399

CNN-C: ACC=0.9563

4.结语:

实验部分结论我写了一些,因为保密原因其他结论读者自行思考,严禁任何人以个人和机构名义以论文、学术讲座等形式发表本实验任何思路和结论,违者必究。

5.思考:

1)数据为何开根号整除为A*A形式输入效果好?试着想一下CNN模型最初用来做啥的,联想图片输入形式。

2)为何在后填充比前后填充效果好?

3) 三个模型为何CNN-A精度最高?