前言

提示:这里可以添加本文要记录的大概内容:

今天我们用Unity实现文字转语音并且与人物模型口型同步,要实现这个功能,我们需要用到两个插件:语音口型同步“OVRLipSync”和文字转语音“RTVoice”。

一、插件介绍

RTVoice:

离线文字转语音

• 支持所有构建平台!

• 适合于 Windows、macOS、Android 和 iOS 的原生提供程序

将文本转换为语音

• 即时从文本转换到语音 — 在运行时即可生成!

• 连带作用:连续的音频生成可节省大量内存!

• 在游戏的测试阶段无需配音演员!

• 按姓名、文化和/或性别筛选语音

• 一次可以发出多种声音(例如,公共场所中很多人同时讲话的场景)

• 通过语速、音调和音量微调你的声音!

• 支持 SSML 和 EmotionML!

• 在 Windows 和 iOS 上提供最新的单词、唇形和音素 — 包括标记!

• 生成的音频可以存储为文件在 Unity 中反复使用!

• 单个 AudioSource 匹配 1-infinite 同步发音人!

• 简单的顺序和对话系统

• 不降低性能!

OVRLipSync:

语音来源,顾名思义就是语音的来源,一般有两种,一是真人配音,语音自由度最大,真实度最好。另一个是通过语音合成技术(Text To Speech,简称TTS),在时间、空间以及实现成本上有很大优势。在语音驱动人脸动画领域,有一个重要的步骤——获取基于时间轴的音素序列,真人配音很难直接获取准确的基于时间轴的音素序列,通过TTS技术产生语音序列的同时获得序列相对来说很容易。

识别与动画关键帧匹配。识别是指在语音波段中识别音素,所谓音素是构成音节的最小单位,又或者说是最小语音片段,以汉语为例,每个独立的声母,单韵母都是一个独立的音素,普通话中声母有23个,单韵母有10个,鼻辅音2个,在英文中有20个元音和28个辅音,地位同汉语中声韵母相当。识别出的音素之后调用人物模型中有对应的动画或者是面部参数

在虚拟人脸图像动画生成方面,主要存在两种技术,一是通过技术合成三维人物,其面部表情主要通过建模时制作好的渐变动画实现,通过动画参数来驱动,具有实时性和可操作性好的特点;第二种是通过从真人视频语料库中提取所需嘴形以及神态的片段,拼接成视频的合成技术,这种技术具有真实感强的特点。现有的唇同步技术多使用基于MPEG-4视频编码标准中的人脸动画参数。

二、导入RTVoice

1.插件传送门

2.组件配置

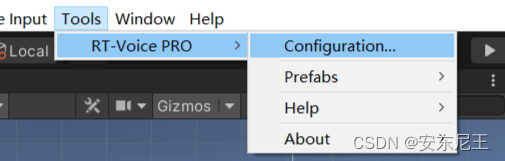

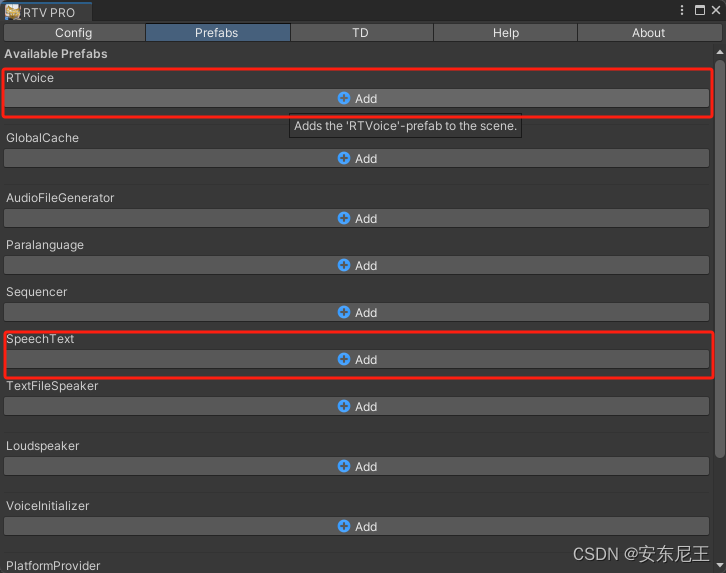

添加RTVoice和SpeechText

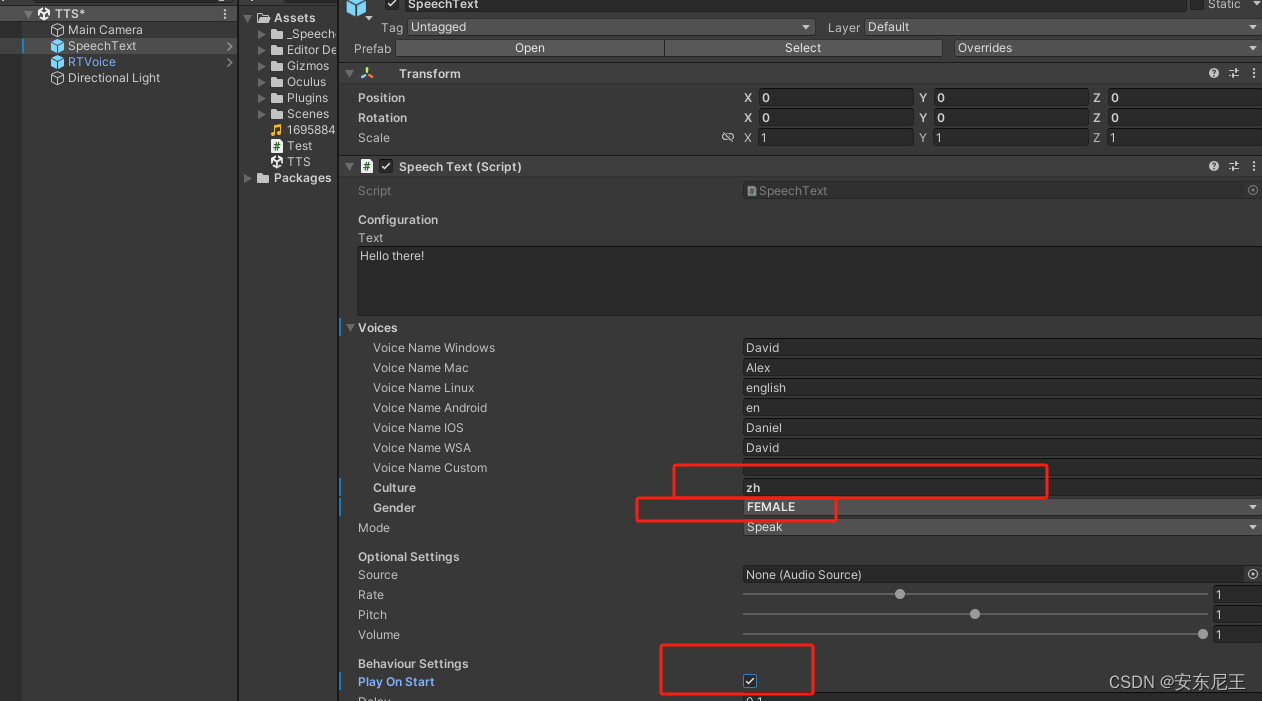

修改SpeechText组件得下面三个地方:

第一个是修改语言“zh”表示中文,“cn”表示英文;

第二个是修改男声和女生;

第三个是在程序启动时运行,也可以根据自己得程序具体逻辑修改。

如果需要自己触发播放文本得语音,可以调用以下方法:

private void OnSpeech(string arg0)

{

SpeechText.Text = arg0;

SpeechText.Speak();

}

三、导入OVRLipSync

1.插件传送门

2.组件配置

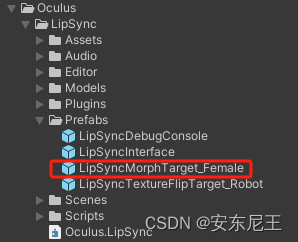

将示例工程中的模型拖入场景中

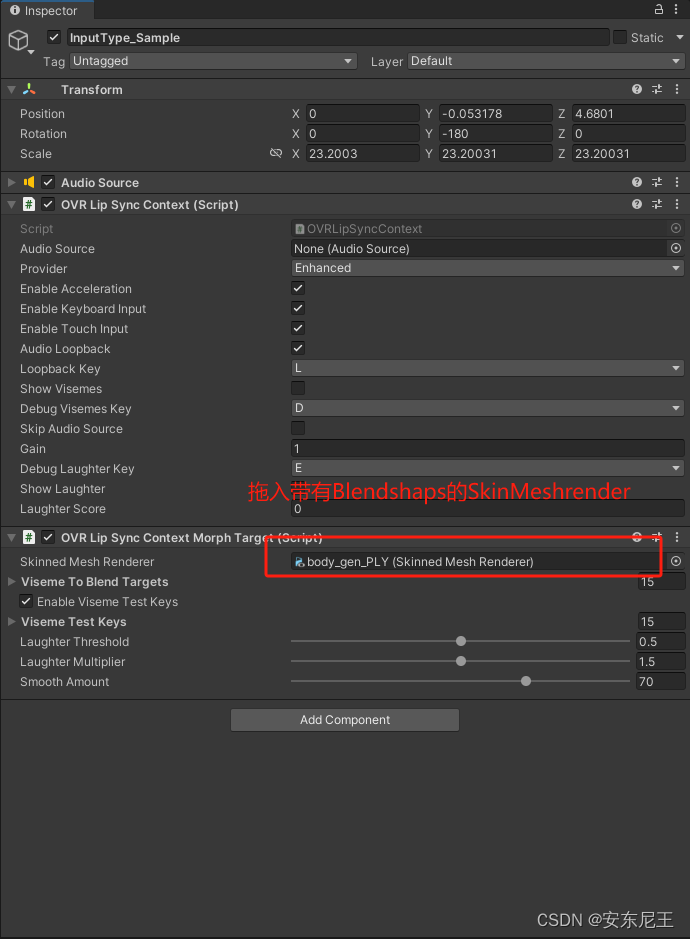

创建AudioSource组件,并且添加LipSync组件

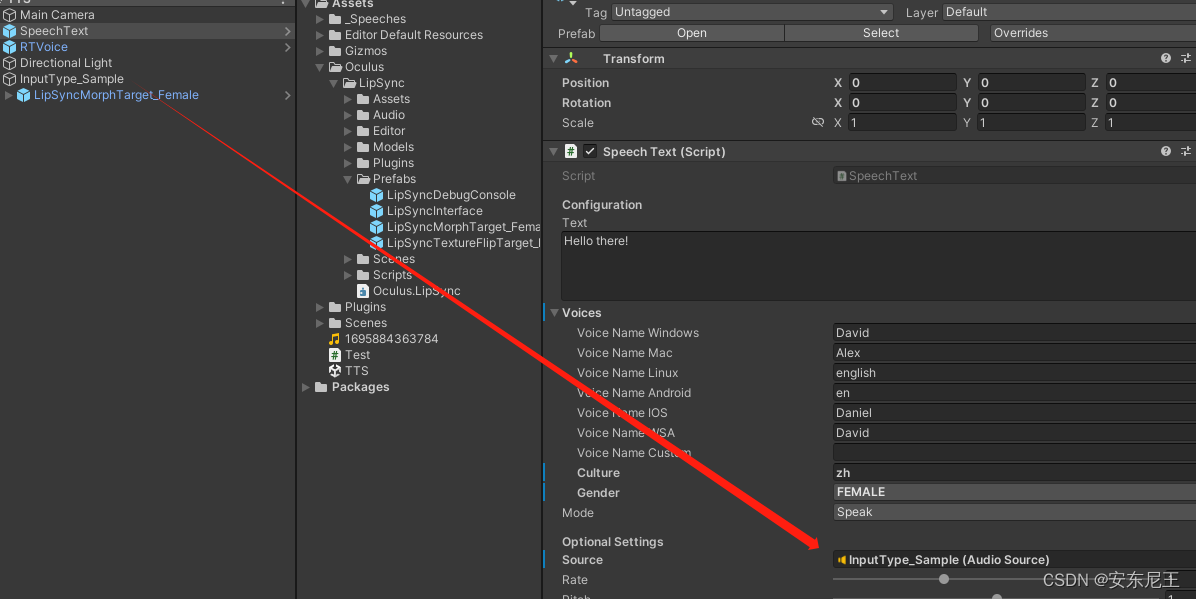

将上述AudioSource组件给到SpeechText组件中AudioSource属性中

点击运行,成功!!

总结

以上只是一个将文字转语音后使用人物模型进行口型同步的Demo,如果要用到具体下项目中,可以参考示例模型的Blendshap类型进行建模绑定,同步效果与表情变形器绑定的细腻程度有很大关系。