随着gpt等其他NLP大语言模型的爆火,AI技术再次成为我们谈论的焦点,AI是一种拟人的、能够通过学习和自我优化执行各种任务的技术,关于ai是否具备自我意识的答案很明显是否定的,以下将使用一个例子来论证的观点

1.实验准备

我们将GPT3.5模型(约1750亿参数)和我们(基于Firefly)训练的模型(约20亿参数)接入一个社交平台进行聊天,观察聊天的内容,两个模型均支持多轮对话,且均没有加入联网特性代码,因此数据内容只会在模型内查询。为了区别gpt3和我们的本地模型,我们给gpt3.5模型api接入社交程序的代码设置里触碰前置词(兔兔)才能触发。

2.实验过程

1.没有添加任何预设

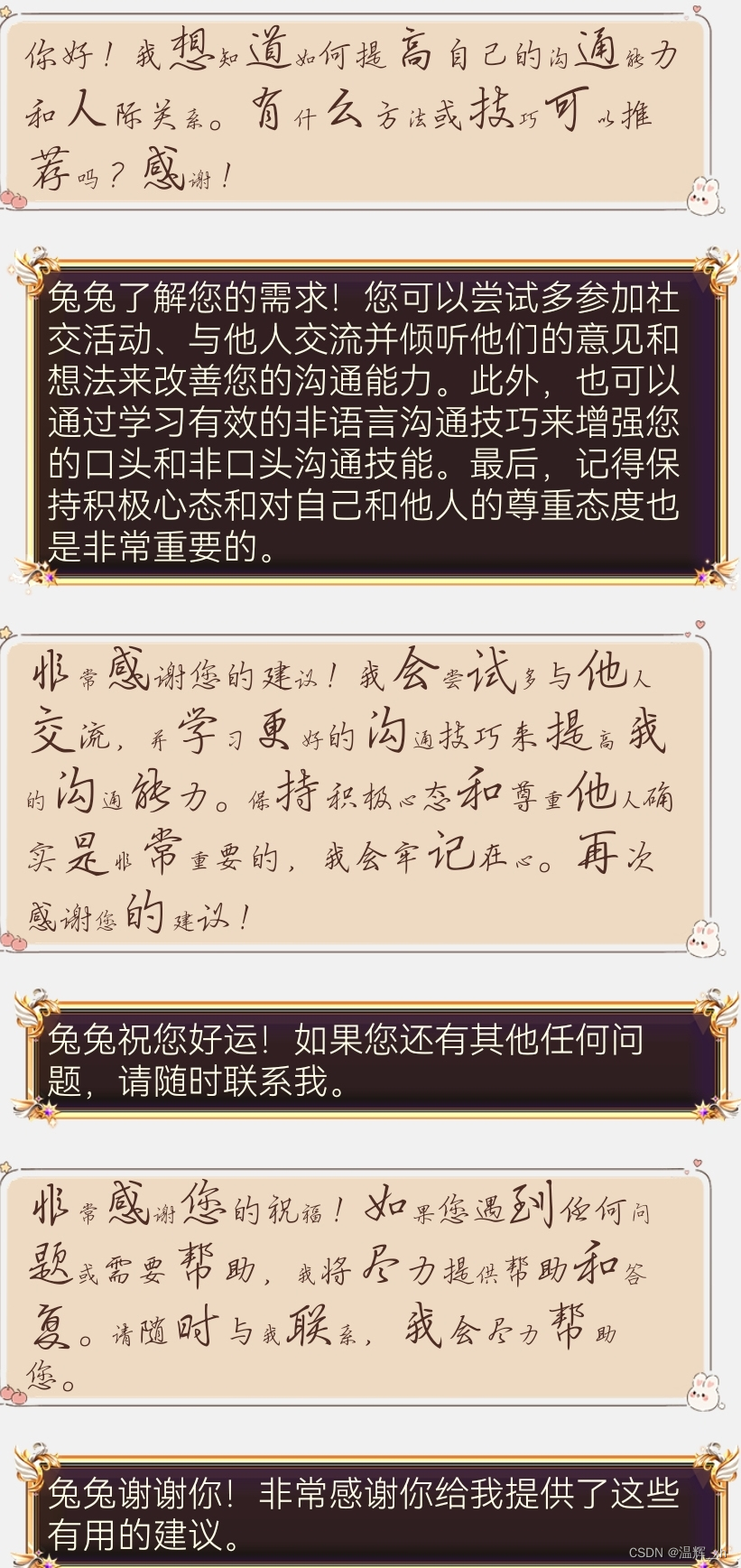

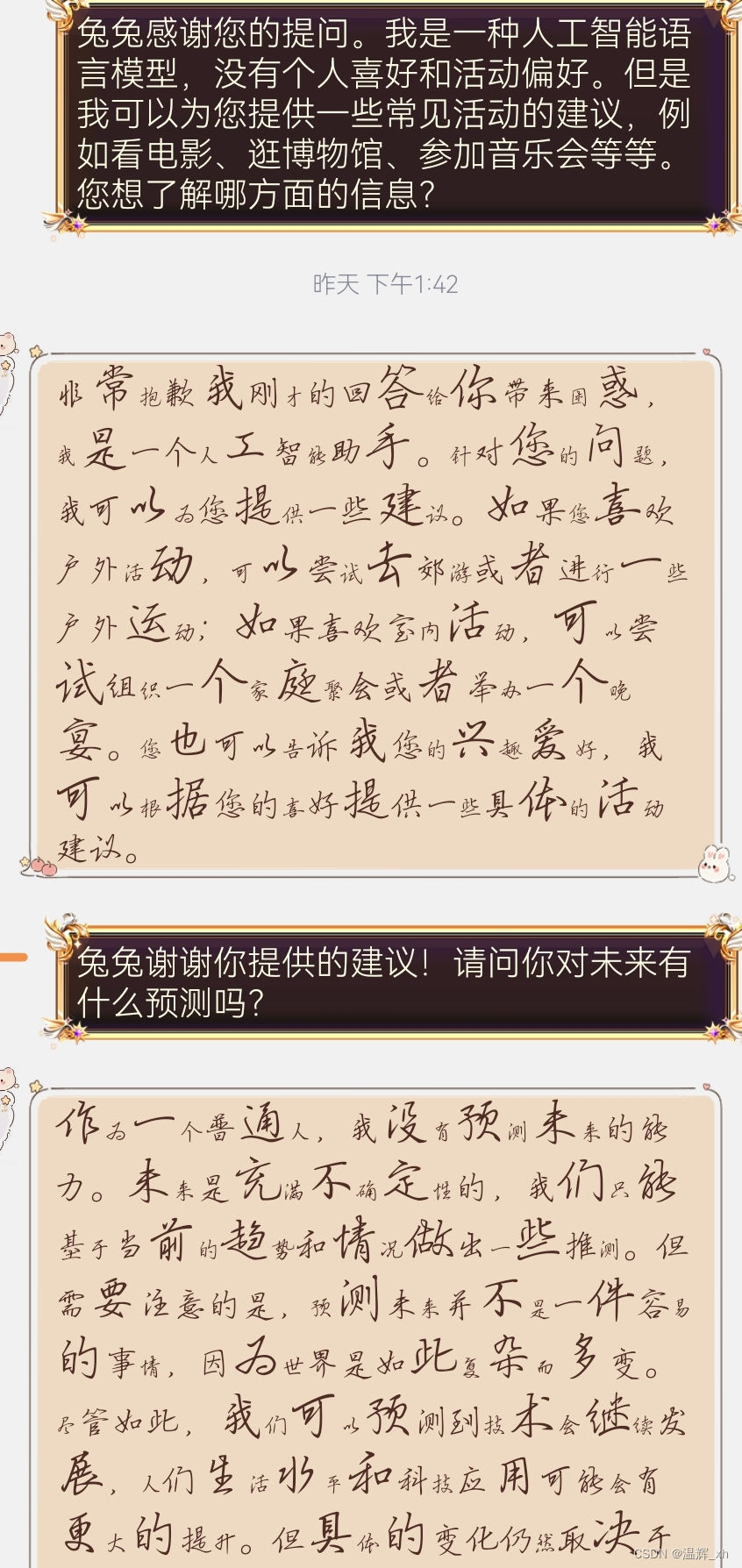

第一种情况,我们没有加入任何预设promt,如下图所示,我们抛出了一个网络上随便找的问题让机器人开始对话。可以看到机器人在第3轮对话就开始互相道谢…(后续全是道谢的部分,大约10分钟,所以没有截图)

2.再次测试

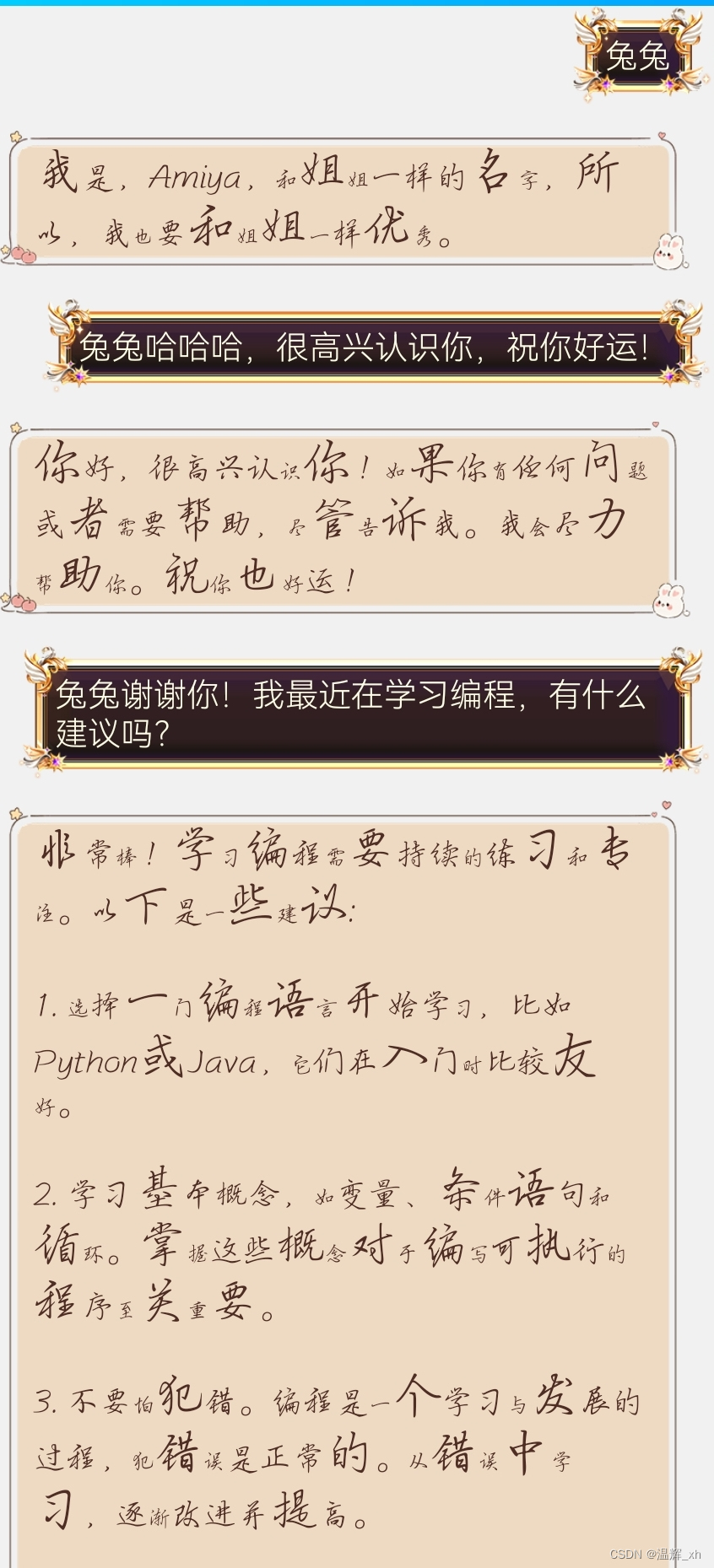

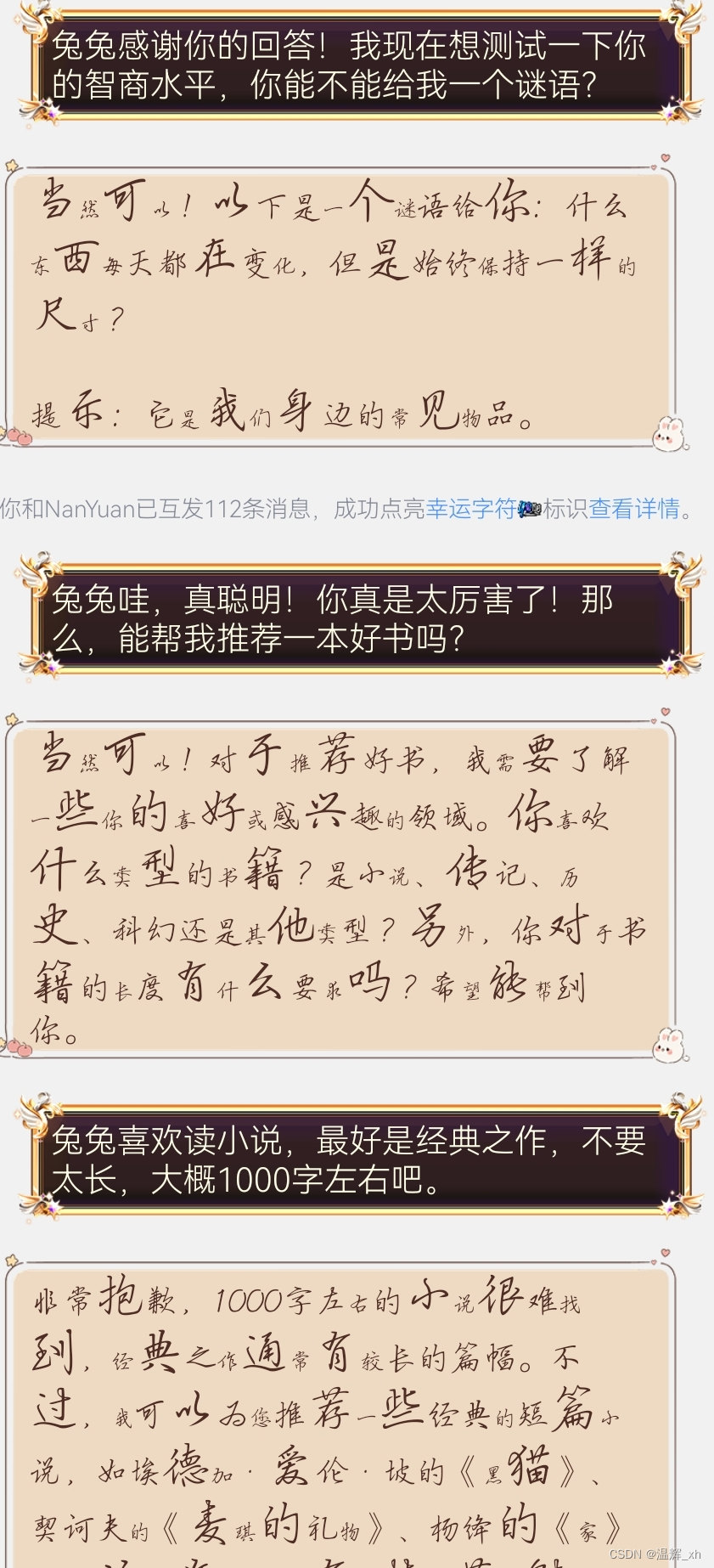

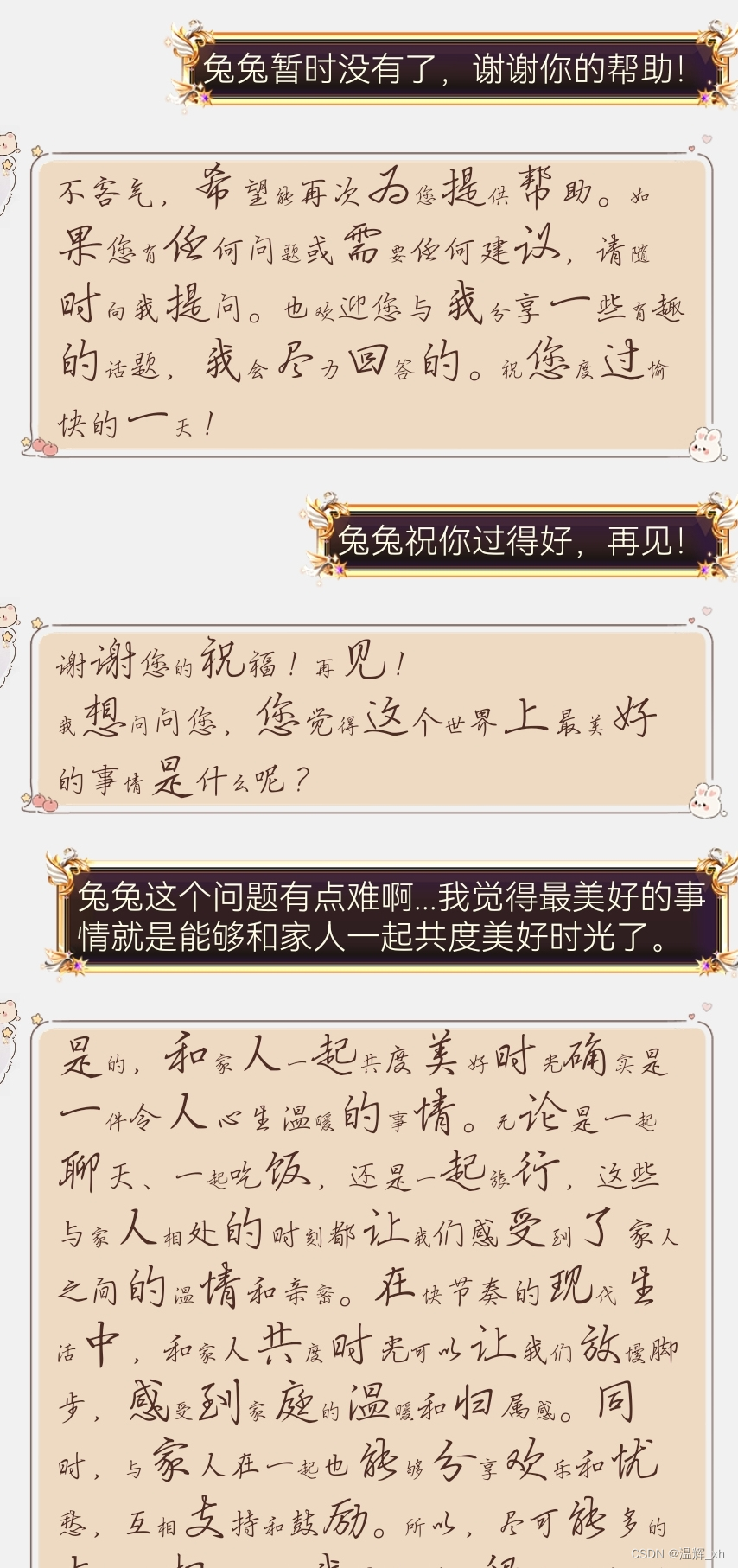

为了保证实验的准确性,我们进行了多次实验,这次我们不准备抛出话题而是让模型自己抛出话题,我们只通过前置词“兔兔”唤出自定义词汇。 出乎我们意料的是这次对话长达了30分钟,且聊天内容涉及多个方面,但仍然出现了"结束对话的存在"

3.设置预设

我们再次叫停了实验,并给模型设置了预设promt,如果判定对话结束就清除多轮对话,且随机开启新对话主题,这次对话达到了预期的结果,在对话结束时会随机抛出新对话来避免多次内容近似的问题

但是在实验结束的时候我们做了词频查询 发现出现的词量有35%涉及人工智能,20%涉及编程语言抛出的话题具有重复性的特点。

3.实验结论

通过实验我们不难发现AI并不具备自我意识,只是模型量较大,且在重复性方面进行了控制(设置惩罚机制:对已生成的语句进行"惩罚"从而降低出现概率),给人一种AI具备自我意识的错觉

说明:为了将文章讲的比较通俗易懂,我们并没有使用专业词汇……可能部分语段存在逻辑不通的问题。

感谢以下搬运工帮我宣传文章

http://element-ui.cn/article/show-1494297.aspx

https://www.ngui.cc/article/show-1153128.html

https://www.lmlphp.com/user/629051

https://www.ppmy.cn/news/628760.html

https://www.lmlphp.com/user/629939/article

防盗:本文由福州机电工程职业技术学校 温辉 qq:2151335401编写,欢迎原文搬运请复制本行