启发式方法

递增法:

先从x中选一个特征,构造分类器,计算准确率,然后再从x的剩余特征中选择一个特征,计算准确率,一直加,直到准确率开始下降。

递减法:

同上,只不过一开始是所有的特征,然后一个一个减,直到准确率下降。

基因算法

模拟退火算法

事实上,神经网络可以代替以上方法,随着不断训练网络,对于特征不明显的w值将不断减小。

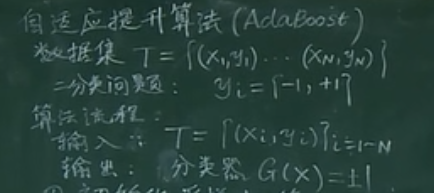

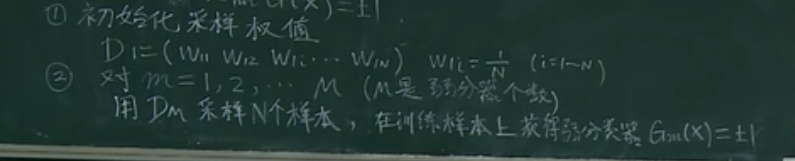

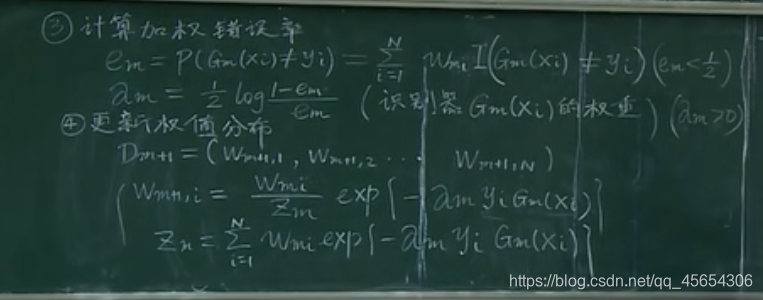

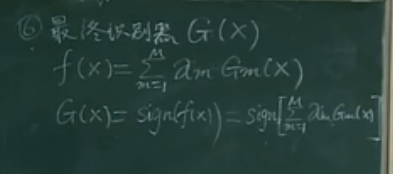

Adaboost

主要思想:找到尽可能少的特征(可能仅有一个),最大限度的将数据集分开,构成弱分类器。对这些弱分类器分错的样本进行加强训练(采样多次),分对的则相应减少样本,对这个样本,我们新找到一个或若干个特征,使其最大限度分开这一个数据集。如此循环,得到很多个分类器及特征。最后,我们按每个分类器的准确率为权重,得到所有的特征。

样本采样的概率是根据弱分类器的性能来定的,一开始是均匀采样,后来根据前面的先验不断调整样本被采样到的概率。

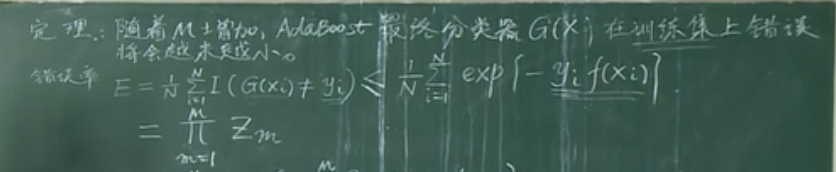

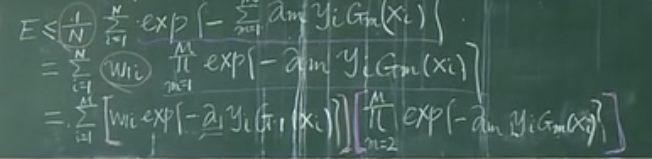

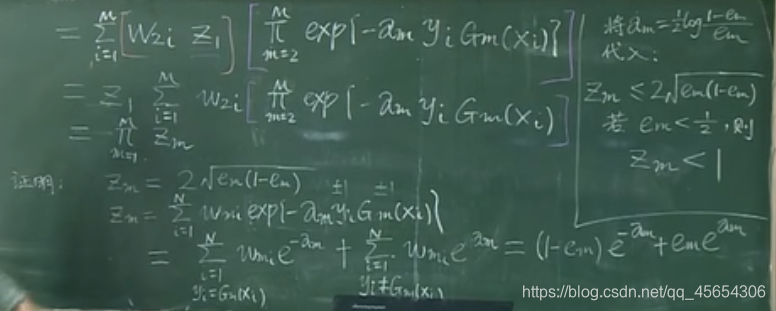

定理

i()指示函数,输入相同值为1,不同为0