- 新鲜出炉(好吧已经过了一个月了)的CVPR2023 exposure correction论文,合肥科技大学,提出了一个可以提高现有方法性能的操作。

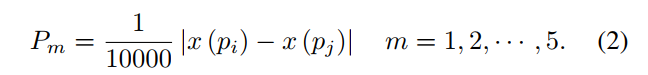

- 作者首先做了一个实验,它统计了1w个3x3的patch中5组不同相对位置的像素的差值,并求平均,如下公式

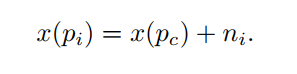

发现这些P1到P5分别是0.0077到0.0080,都是很小的值,因此可以认为统计上一个3x3patch内部的像素值相差不会太大,这称为局部平滑性假设。假设每个patch的中心像素为 x ( p c ) x(p_c) x(pc),那么这些像素可以表示为中心像素与一个偏置的和:

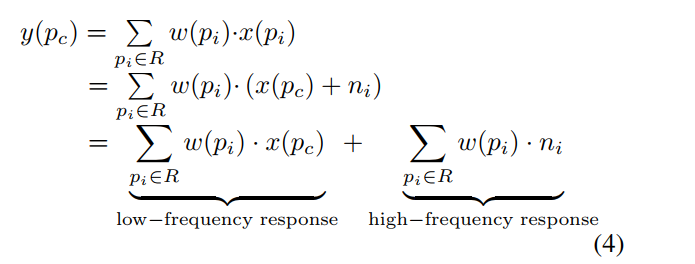

这个偏置可以认为是高频项而中心像素值认为是低频项,从而一个卷积可以分为如下两个求和:

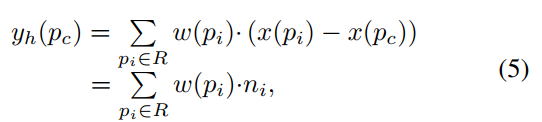

现有的卷积是混在一起求的,而本文想要把这两项分别求出来,所以要用到如下公式分离出高频项:

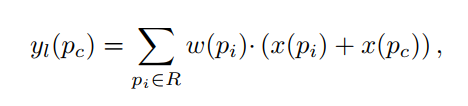

而直接减去高频项获得低频项会出现问题,文章解释是因为这里获得的高频项其实包含了噪声信息(我不认可,减去噪声信息不好吗),从而用另一个方式来获得低频项,即把低频项翻倍:

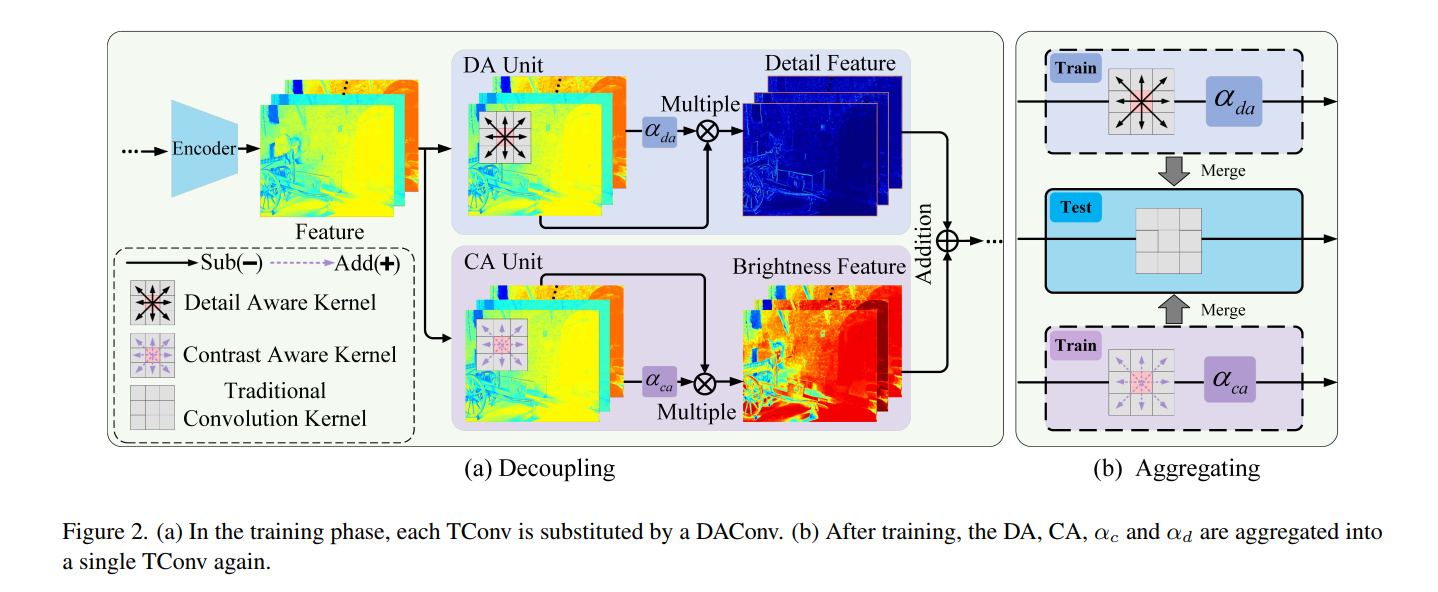

低频和高频的处理分别被称为contrast aware和detail aware kernel,两个并行处理可以用来代替传统的卷积核,然后再用两个参数来rescale这两个分量并加和回去,如下公式:

而在测试的时候,其实他们就可以等价为一个普通卷积核,把这两部分给合起来即可 - 操作图示如下。

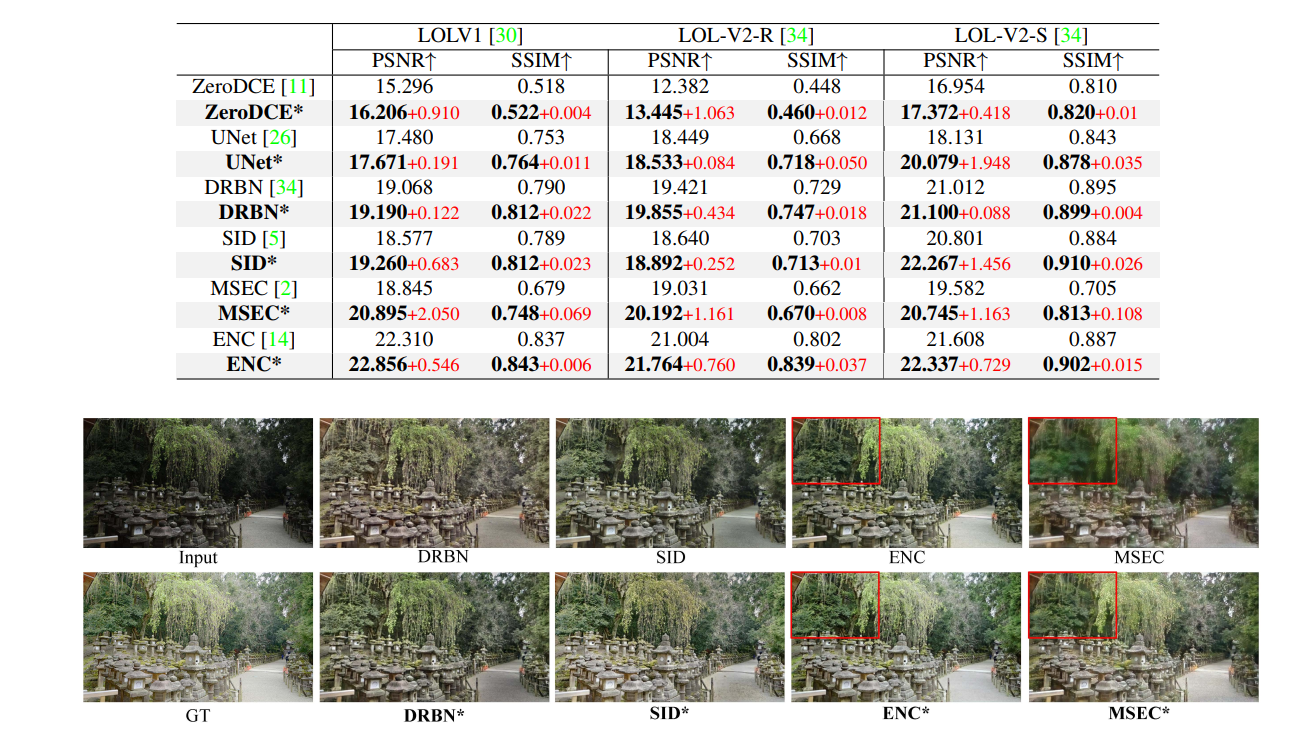

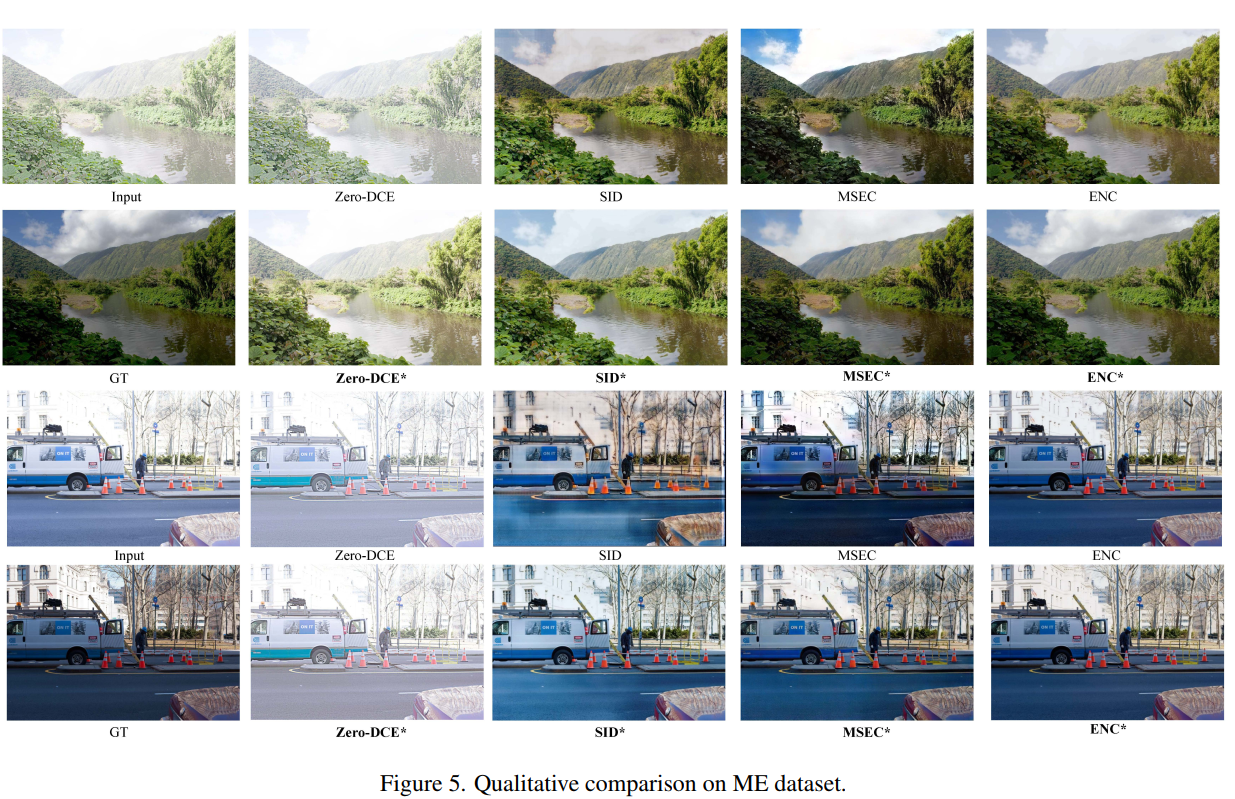

- 实验结果表明,在各个方法和各个数据集上将卷积核修改为如上的形式都能提高性能