LeNet、AlexNet、VGGNet总结

本节是参考文献3的章节习题:p 200 9.4小结

自己以这个题目做一个小结,如有不妥,敬请指正

1.LeNet-5、AlexNet、VGG-16网络模型各有什么特点?

LeNet-5:

详情查看:https://blog.csdn.net/seasonsyy/article/details/132639952?spm=1001.2014.3001.5502

卷积神经网络的雏形,1989年提出,由于计算机硬件能力限制,制约了发展。1998年出现改进版本LeNet-5,是卷积神经网络的经典之作和开山之作。最先被用于处理计算机视觉的问题,在识别手写体数字的准确性上取得了非常好的成绩。可视为学习其他深度网络模型的基础。

5层结构(两个卷积层、三个全连接层),最后通过softmax激活函数输出10个分类。

激活函数使用Tanh或Sigmoid函数

AlexNet:

详情查看:https://blog.csdn.net/seasonsyy/article/details/132640381?spm=1001.2014.3001.5502

AlexNet网络是2012年ILSVRC(ImageNet Large Scale Visual Recognition Challenge)竞赛(大规模视觉识别挑战赛)的冠军网络(分类赛冠军),分类准确率由传统的70%+提升到80%+。

-

首次利用GPU进行网络加速训练

-

使用了ReLU激活函数,而不是传统的Sigmoid激活函数以及Tanh激活函数。

- ReLU激活函数更简单,更容易训练

- (自此以后,ReLU函数及其变种成了卷积神经网络激活函数的通用标准)

-

使用了LRN局部响应归一化

-

LRN作用:用来对卷积层的输出进行规范化,促进网络收敛,增强泛化能力

注意:后来的研究中人们逐渐发现,局部相应归一化层的效果并不是很好,所以现在基本不再使用

-

-

随机失活神经元(减少过拟合)

-

重叠池化操作(池化步长小于池化核的尺寸)降低了错误率

VGG-16:

详情查看:https://blog.csdn.net/seasonsyy/article/details/132676351?spm=1001.2014.3001.5502

2014年由牛津大学著名研究组VGG(Visual Geometry Group,视觉几何组)提出,斩获该年ImageNet竞赛(ILSVRC)中Localization Task(定位任务)第一名和Classification Task(分类任务)第二名。

-

通过堆叠多个3×3的小卷积核来代替大尺度卷积核(5×5、11×11)

- 来减少计算量,并且小卷积核更有利于提取图像的微小视觉特征

-

可堆叠的块状网络结构

每次的卷积都采用Same卷积,图像的尺寸不发生改变,而提取的特征却在增多。

网络体系庞大结构十分简单,拓展性强,泛化能力也很好。

2.多维卷积是如何工作的?

三维卷积:卷积核是有深度的,卷积核的尺寸是f×f×3。

用这样一个三通道的卷积核在三维图像上滑动提取特征的过程就是三维卷积。

卷积核的通道数目由3推广到更多,就得到了多维卷积,其计算方法与三维卷积完全相同。

3.Same卷积的原理是什么?有什么特点?

- 原理:

本质上仍是一种普通卷积,计算公式仍然是

o u t p u t = [ ( i n p u t − f i l t e r S i z e + 2 ∗ p a d d i n g ) / s t r i d e ] + 1 output=[(input-filterSize+2*padding)/stride]+1 output=[(input−filterSize+2∗padding)/stride]+1

好处:没有在卷积之后缩小图像尺寸,也没有放过原图像中任何一个信息进行卷积,所以提取出的特征图会更加完整。

启发:当构建属于自己的网络的卷积神经网络的时候,在合适的时候采取Same卷积方法,可能会带来很好的性能,且代码十分简单,只需要按照Same卷积的要求设置响应的参数即可。

# 利用nn包构建采用Same卷积的卷积层

self.conv1=nn.Sequential(

nn.Conv2d

(

in_channels=1,

out_channels=6,

kernel_size=3,

stride=1, # 步长一定要设置为1

padding=1 # padding设置成1就实现了加边界

),

nn.ReLU(),

nn.MaxPool2d(kernel_size=2)

)

- 特点:图像的尺寸不发生改变,而提取的特征却在增多

4.Softmax分类器的原理是什么?有什么特点?

Softmax是Sigmoid二分类上的推广,只需要对数据进行两步处理:

- 首先利用指数函数将多分类的结果映射到零到正无穷

- 然后采取归一化方法得到结果映射的相应概率

假设现在需要对输出进行n种分类,那么该输出经过Softmax分类器之后就会得到n个概率,如下:

上式体现了Softmax分类器的本质:

- 分子代表处理的第一步:利用指数函数将多分类的结果映射到零到正无穷

- 分母:代表把所有的结果相加,对分子进行归一化

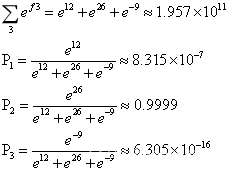

例子:假设网络需要输出一个三分类的结果,在一次训练过程中,网络输出了[12 26 -9]这样一个行向量,经过Softmax分类器的计算过程如下:

P2最接近1,表示第二种分类的可能性极大,已经接近100%,所以我们认为网络输出的分类结果为第二种分类。

参考文献

- 《深度学习与神经网络》 赵眸光 编著

出版社:电子工业出版社 2023年1月第一版

ISBN: 978-7-121-44429-6

- 《深度卷积神经网络 原理与实践》周浦城 李从利 王勇 韦哲 编著

出版社:北京:电子工业出版社,2020.10

ISBN: 978-7-121-39663-2

- 《Python神经网络 入门与实践》 王凯 编著

出版社:北京大学出版社

ISBN: 9787301316290