目录

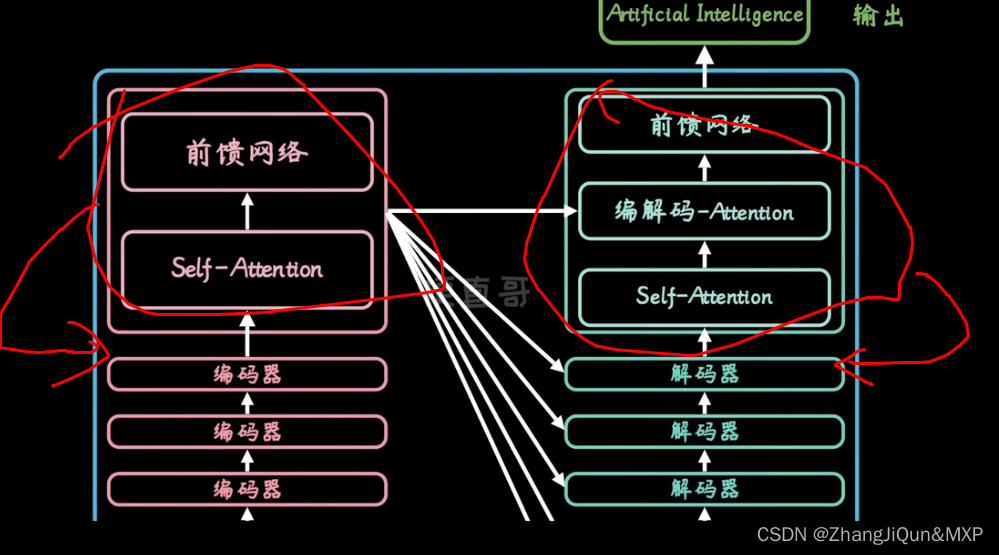

自注意力机制就是变形金刚的拆解对照:生成零部件V和权重K,前馈神经网络进行权重调节:初步变形

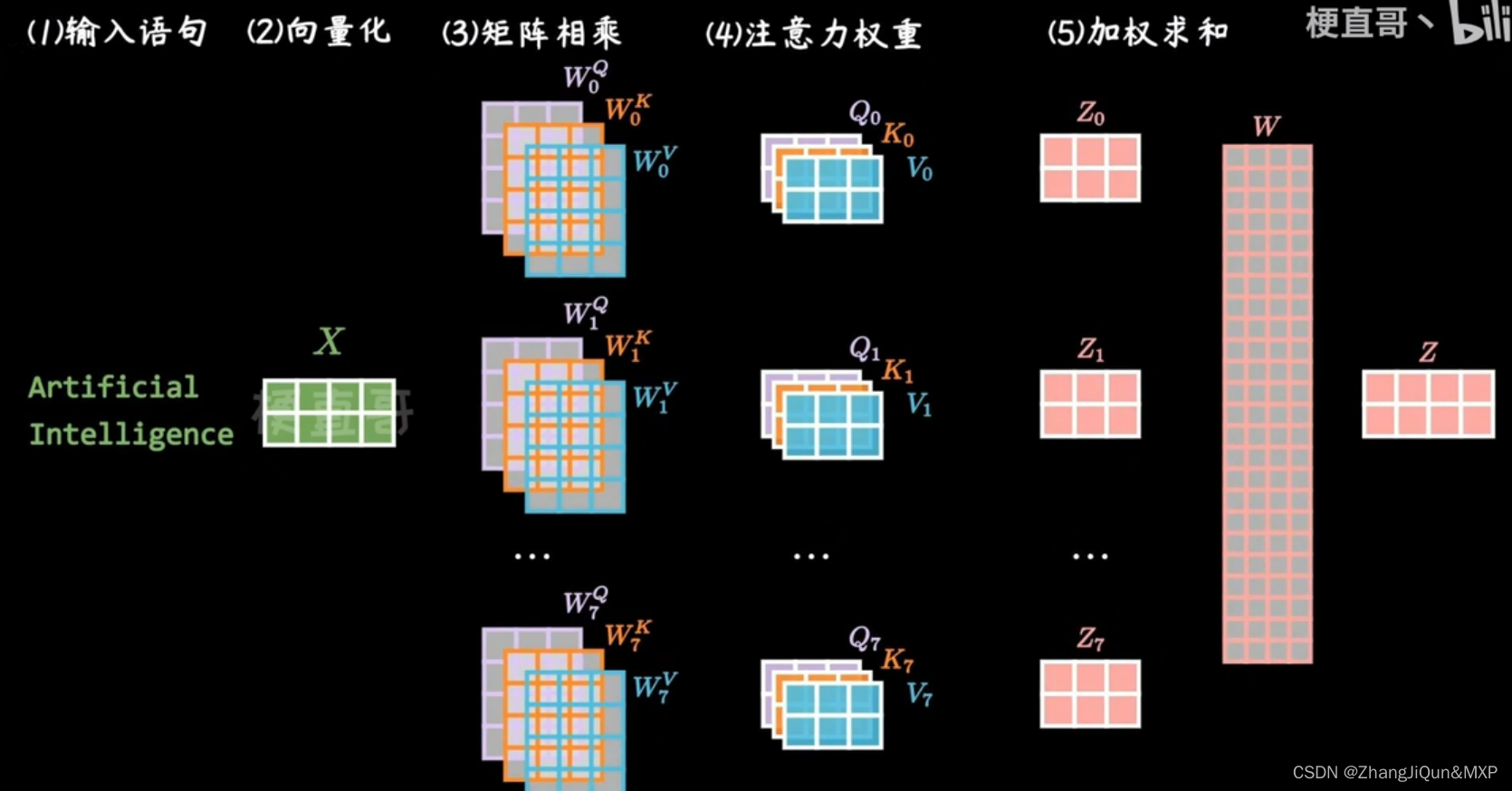

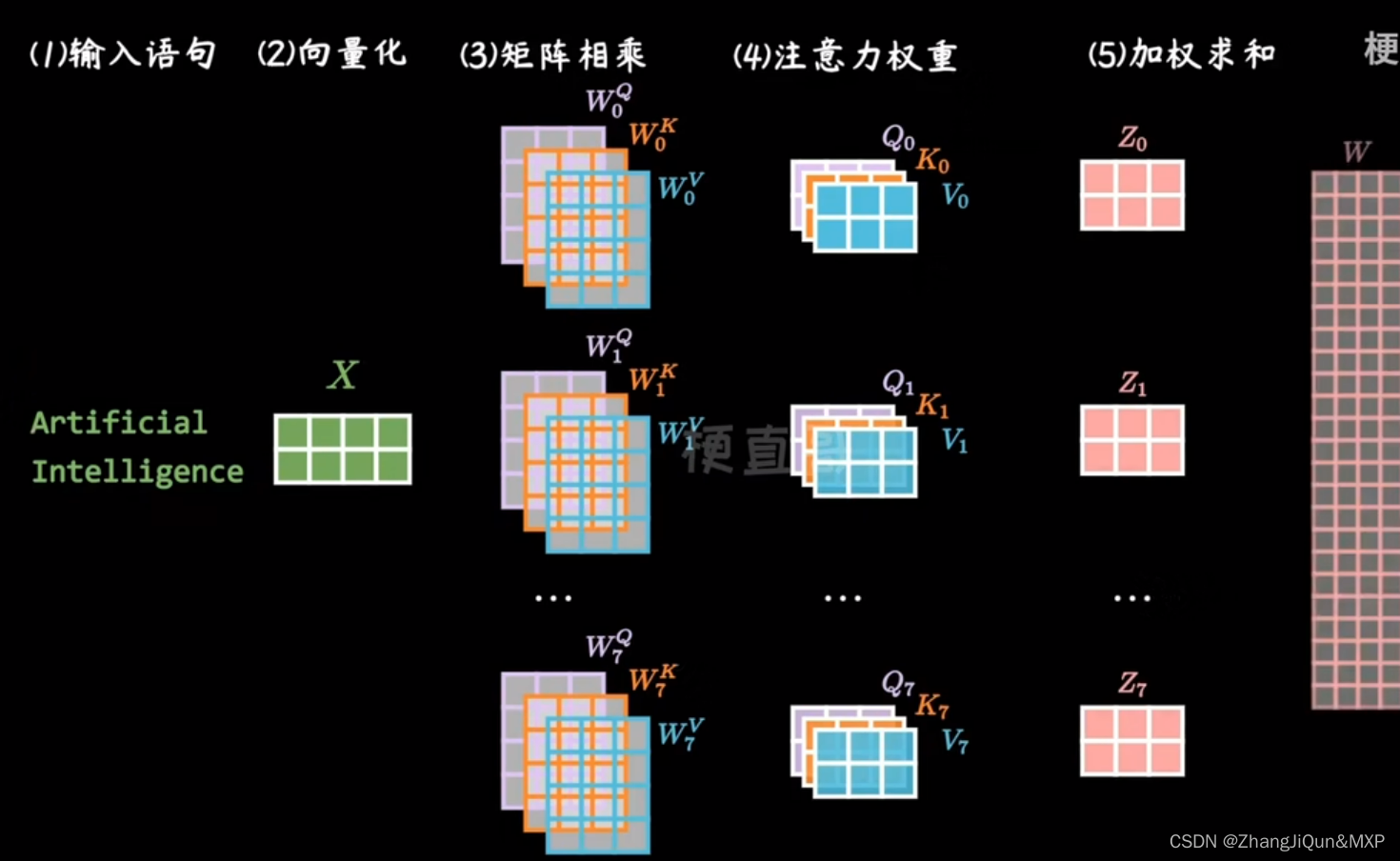

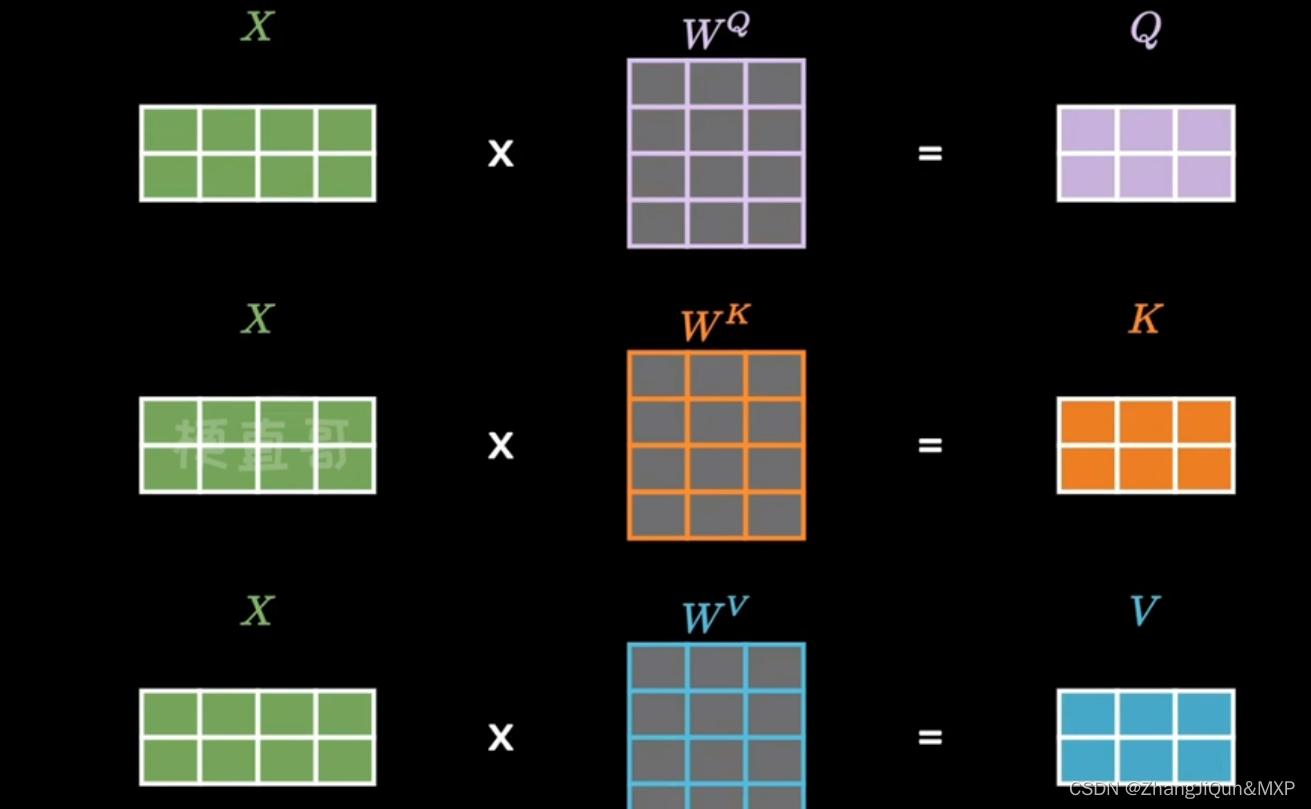

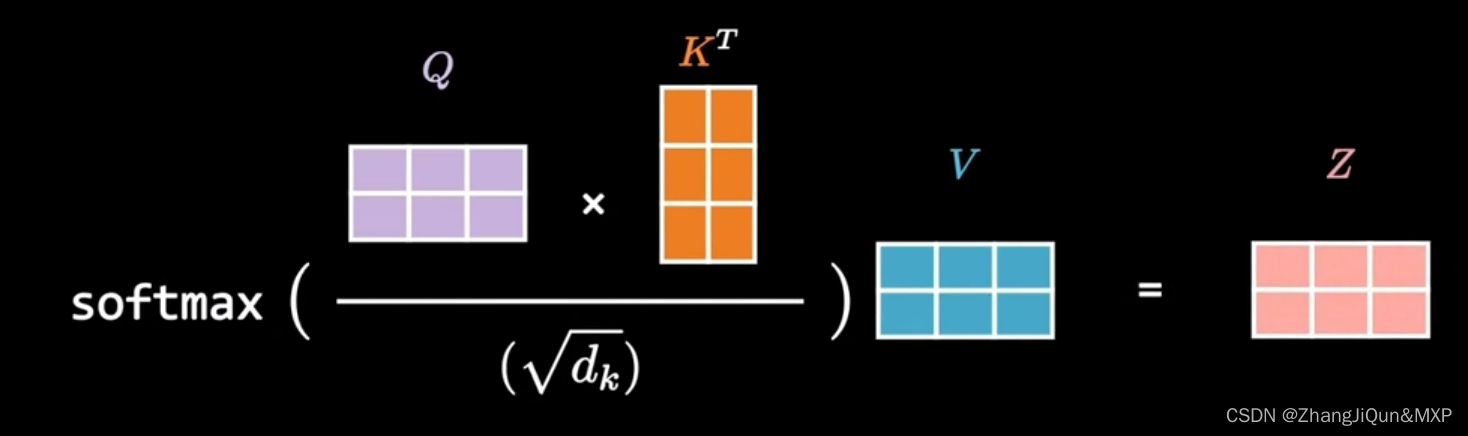

单词向量化,矩阵相乘生成关系说明,注意力权重,最后加权求和编辑

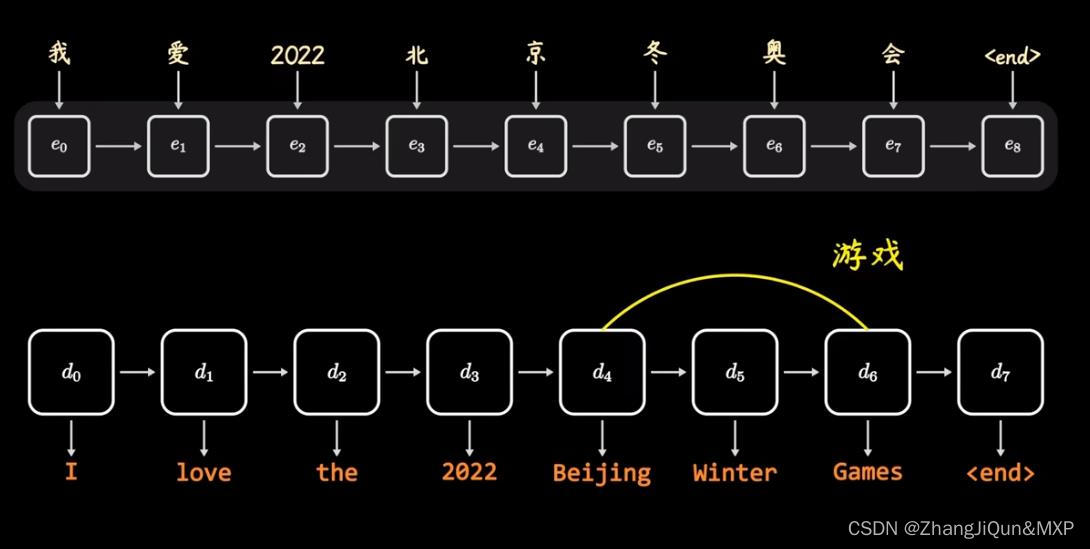

game是游戏

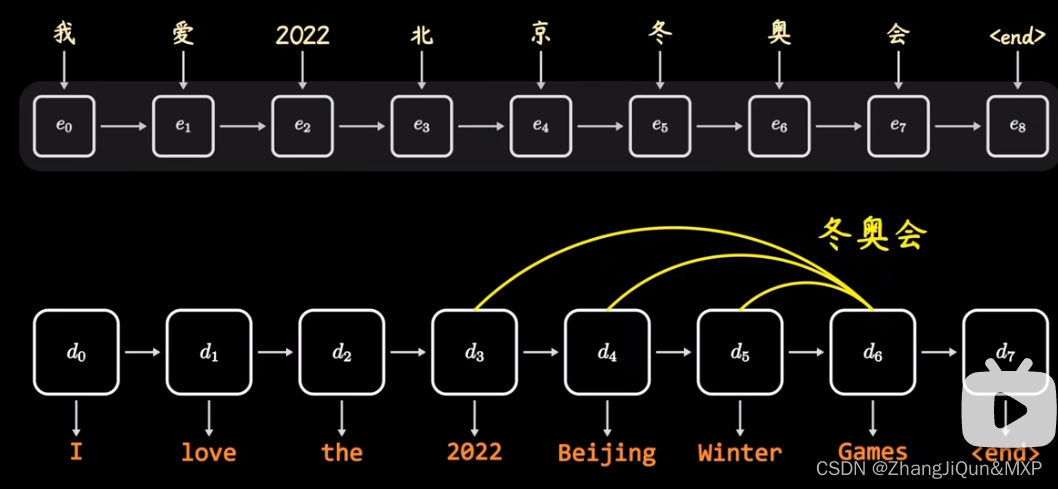

与北京在一起:冬奥会

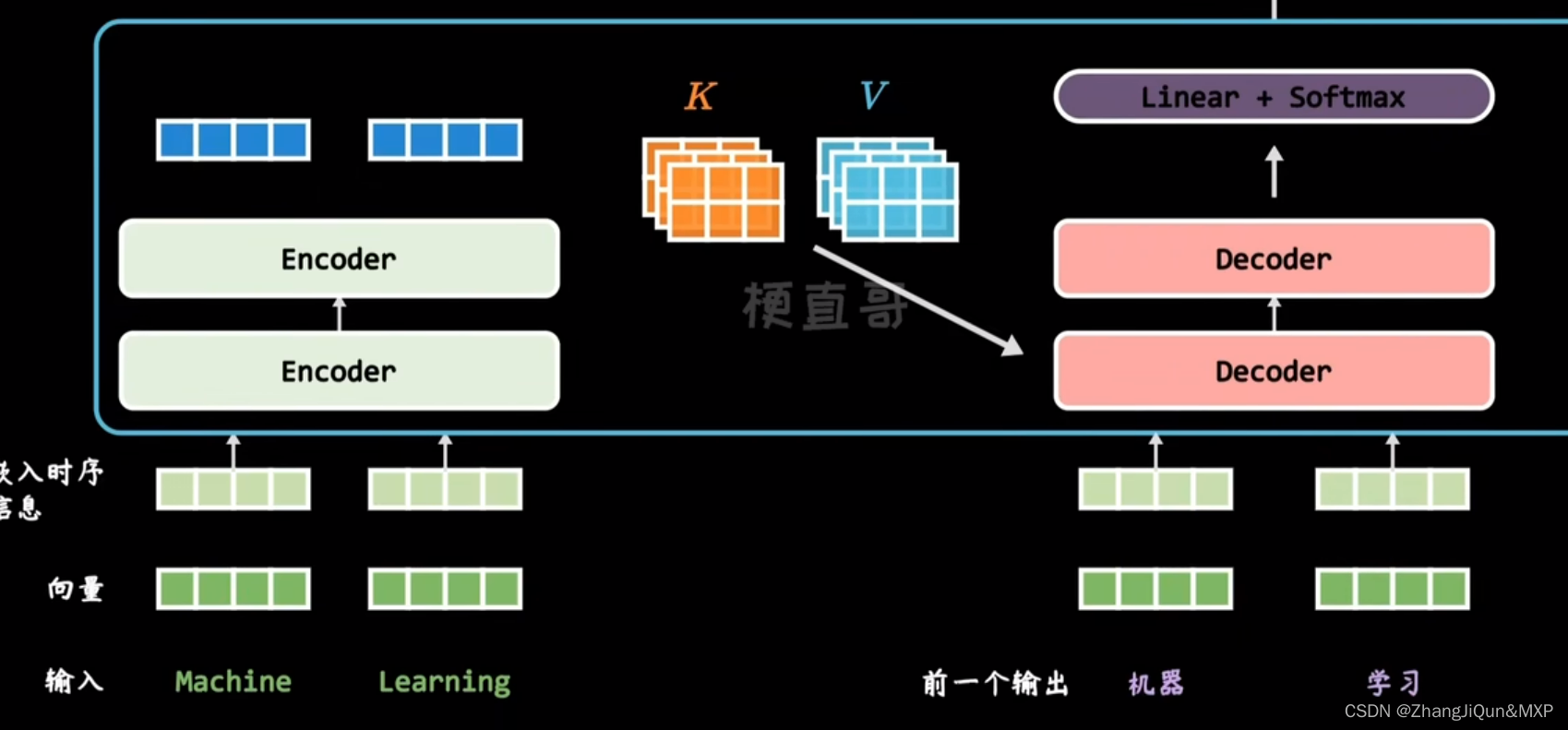

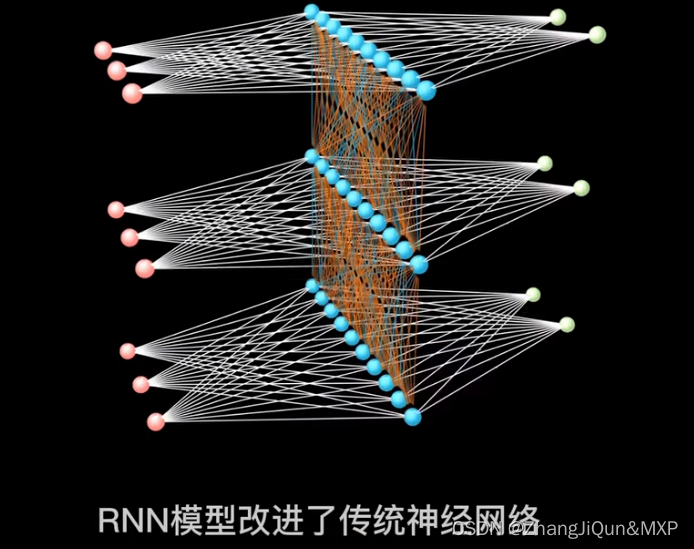

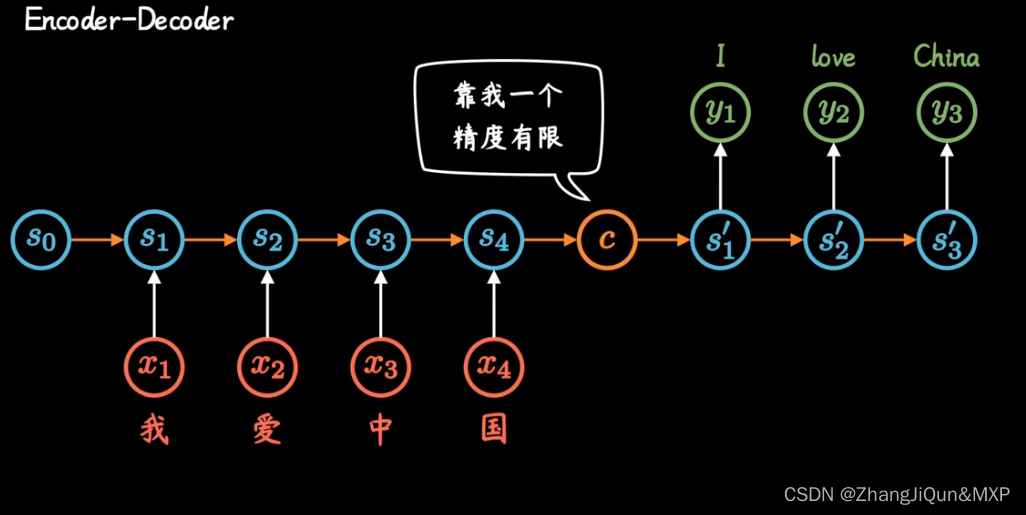

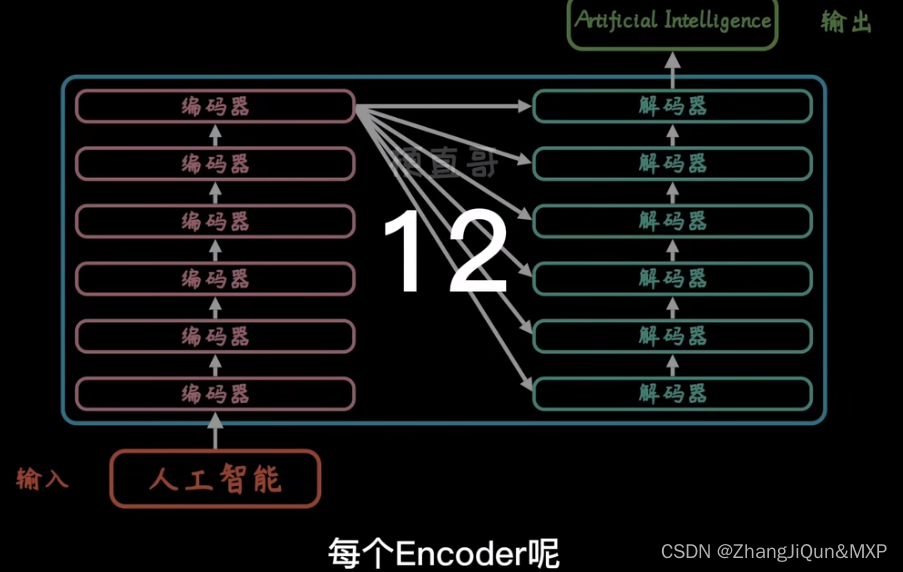

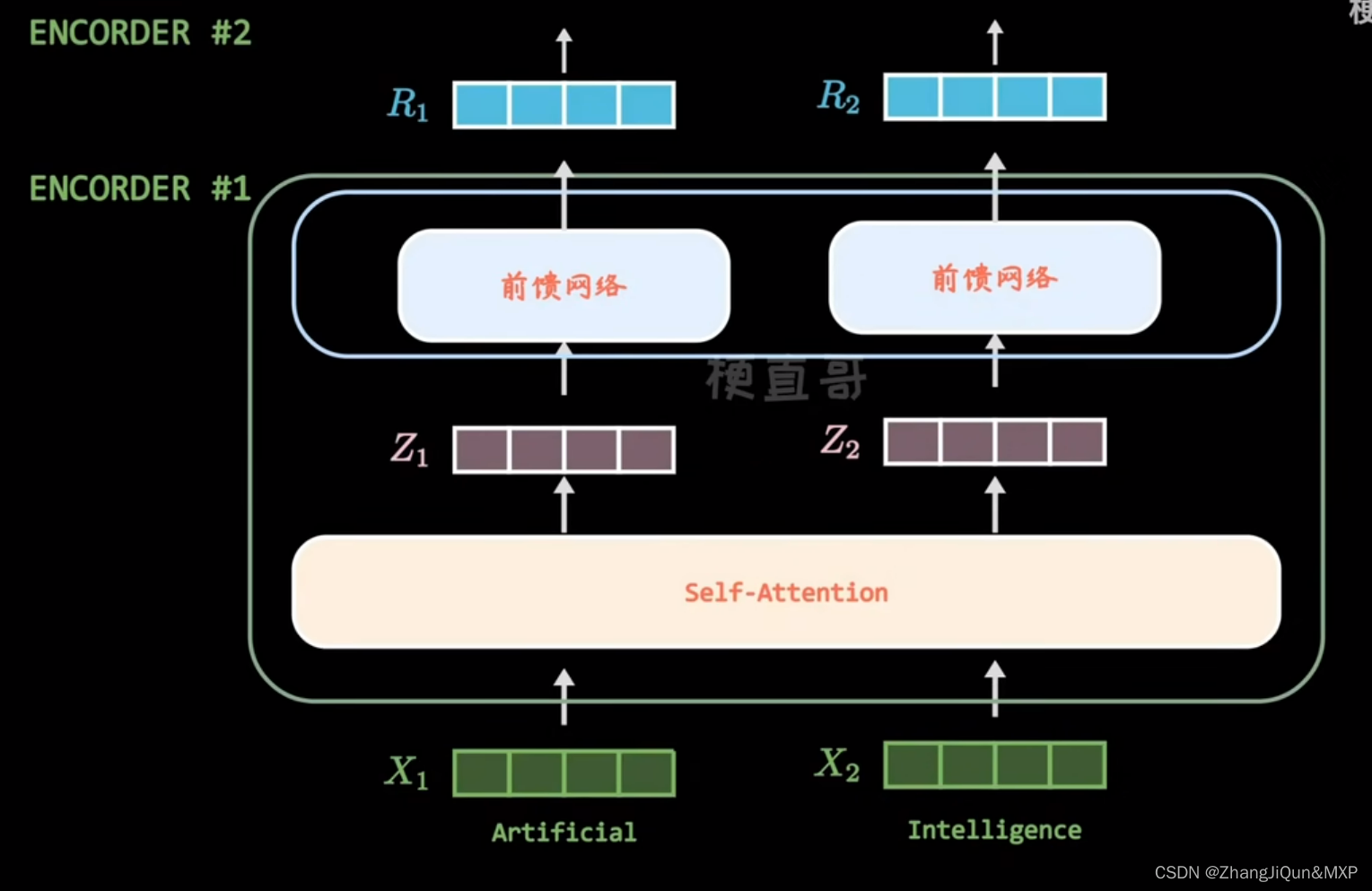

transform :encode,decode 12步骤

自注意力机制就是变形金刚的拆解对照:生成零部件V和权重K,前馈神经网络进行权重调节:初步变形

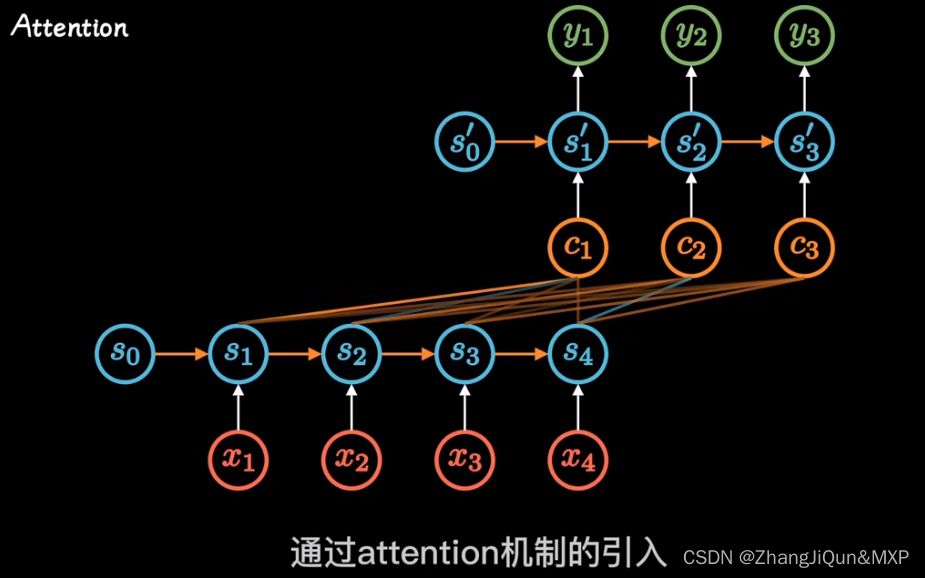

编码器Attention就是考虑上下文信息

【Transformer模型】曼妙动画轻松学,形象比喻贼好记_哔哩哔哩_bilibili

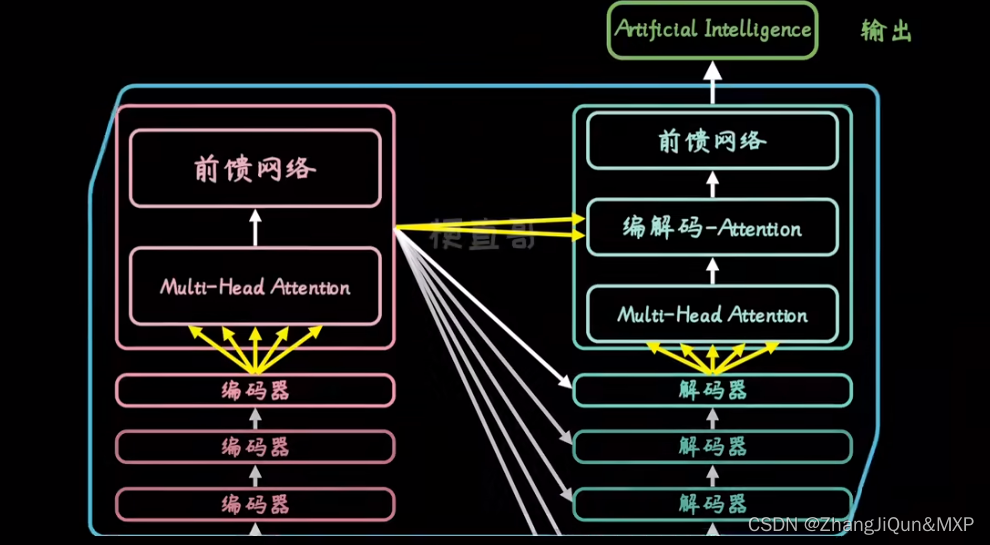

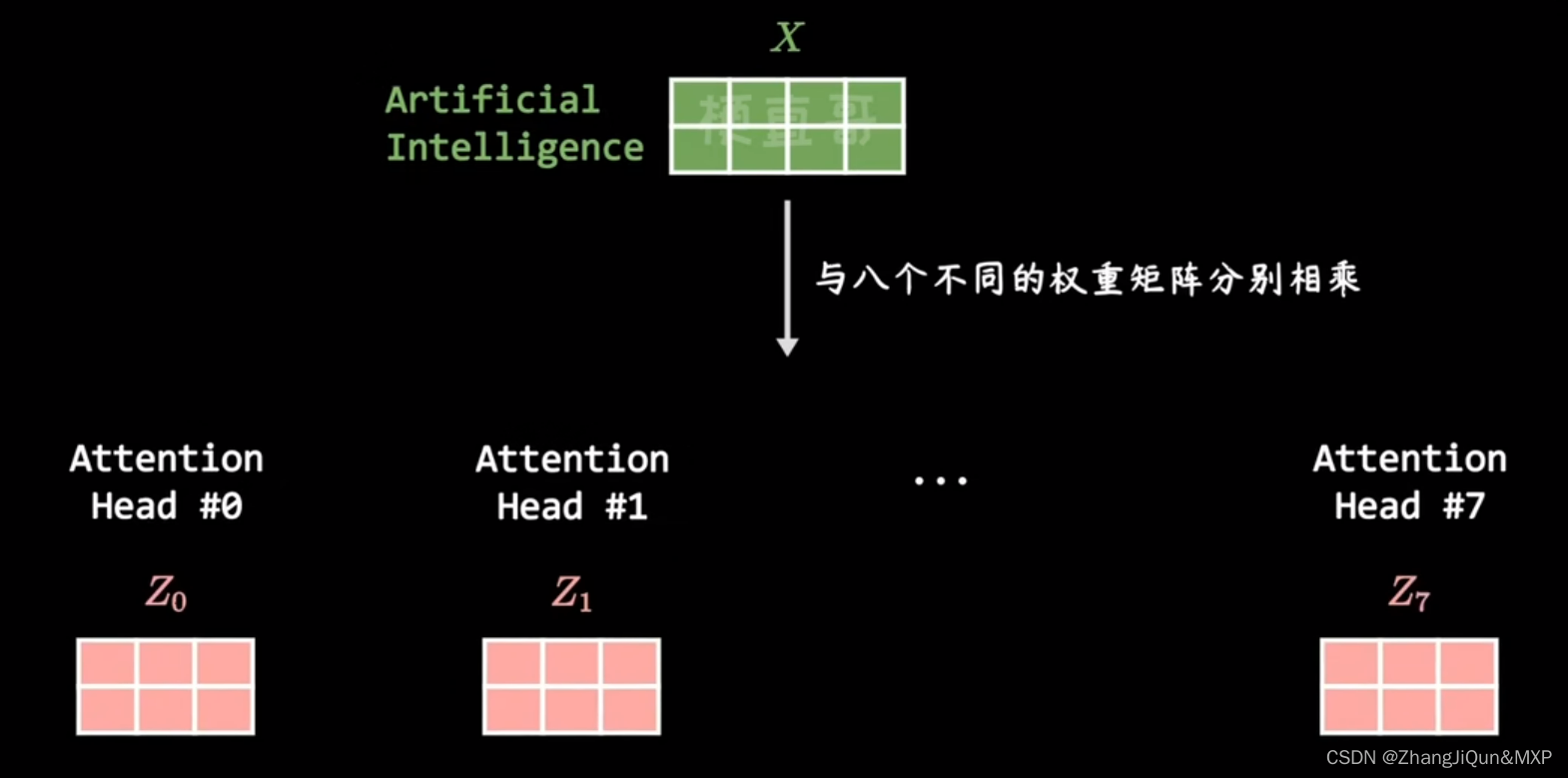

注意力机制:采用多注意机制:防止一人叛变导致模型失效

数据流动:用算法吧单词向量化,同一场赌。512位

通过权重:Q,K,V进行计算生成零部件说明和关系说明

8个权重矩阵,防止失效,消除初始权重影响

单词向量化,矩阵相乘生成关系说明,注意力权重,最后加权求和