1、前言

从ChatGPT正式推出之后,大模型开始逐渐火爆起来,基于大模型的潜力与广泛应用前景,多个厂商也开始在大模型领域进行深耕布局。越来越多的人也开始尝试使用大模型来解决日常工作或生活中的问题,有效地提高了处理问题的效率。

最开始大家都喜欢使用ChatGPT,但随着ChatGPT的升级,访问ChatGPT就变成了难题。值得庆幸的是,国内的一些大厂商也相继推出了一些大模型平台,比如百度的千帆大模型、阿里的通义千问大模型、华为的盘古大模型、科大讯飞的星火认知大模型等。这些平台提供的服务更到位,支持的功能更齐全,特别是在中文环境支持方面更有优势和竞争力。

作为国内人工智能领域的领导者,百度智能云推出的千帆大模型平台在最近进行了新一轮重量级的升级,千帆大模型平台已经全面接入Llama 2全系列、ChatGLM2-6B、RWKV-4-World、MPT-7B-Instruct、Falcon-7B等33个大模型,一举成为国内拥有大模型最多的平台。

最近,千帆大模型平台已面向企业和个人开放测试申请,有幸申请体验了一下,使用下来感觉效果非常好,下面给大家分享一下我的体验过程。

百度千帆大模型平台体验地址:百度千帆大模型体验链接

2、千帆大模型平台

千帆大模型平台是百度智能云推出的全球首个一站式的企业级大模型平台,它不但提供包括文心一言在内的大模型服务及第三方大模型服务,还提供了生成式AI生产及应用全流程开发工具链,是大模型生产和分发的集散地,能够帮助企业解决大模型开发和应用过程中的所有问题。

据了解,目前千帆大模型平台已经全面接入Llama 2全系列、ChatGLM2-6B、RWKV-4-World、MPT-7B-Instruct、Falcon-7B等33个大模型,成为国内拥有大模型最多的平台。接入的模型经过千帆平台二次性能增强,模型推理成本最高可降低50%。同时,千帆平台上线了国内最全的预置Prompt模板,模板数量多达103个,覆盖对话、游戏、编程、写作十余个场景。

千帆大模型平台可以为企业、开发者提供更加灵活、多样化、高效的大模型服务,客户可选择最适合自身业务的大模型,再利用千帆平台全套工具链进行模型再训练、指令微调等,高效率、低成本地打造企业专属大模型。此外,海量Prompt模板库可提高大模型内容准确性和满意度。

企业用户和开发者可将不同大模型搭配使用,以满足不同细分场景的业务需求,可以直接登陆千帆大模型平台操作台,在“模型仓库”中直接按需求进行调用、部署。

千帆大模型平台的鲜明特点有:

- 技术领先

知识增强大模型,统一范式支持多类下游任务。先进并行策略支撑大模型训练、压缩与部署。可控可信的语言理解和生成能力。- 全场景覆盖支持

对话互动,自由问答,文案创作等能力,覆盖能源、金融、航天、工业、媒体等领域。- 低门槛使用便捷

一行代码调用服务,一键自动模型微调,少量数据完成多场景AI应用落地。- 真实可落地

提供企业级一站式客户服务,打通芯片+平台+模型+应用的四层架构,联合多家合作伙伴实现端到端应用落地。

3、申请千帆大模型体验

点击千帆大模型的官网(https://cloud.baidu.com/product/wenxinworkshop),在打开的页面中,点击申请体验:

填写完信息后提交申请,若干小时就会审核通过。

审核通过后,进入千帆大模型首页(https://cloud.baidu.com/product/wenxinworkshop),点击右上角的控制台:

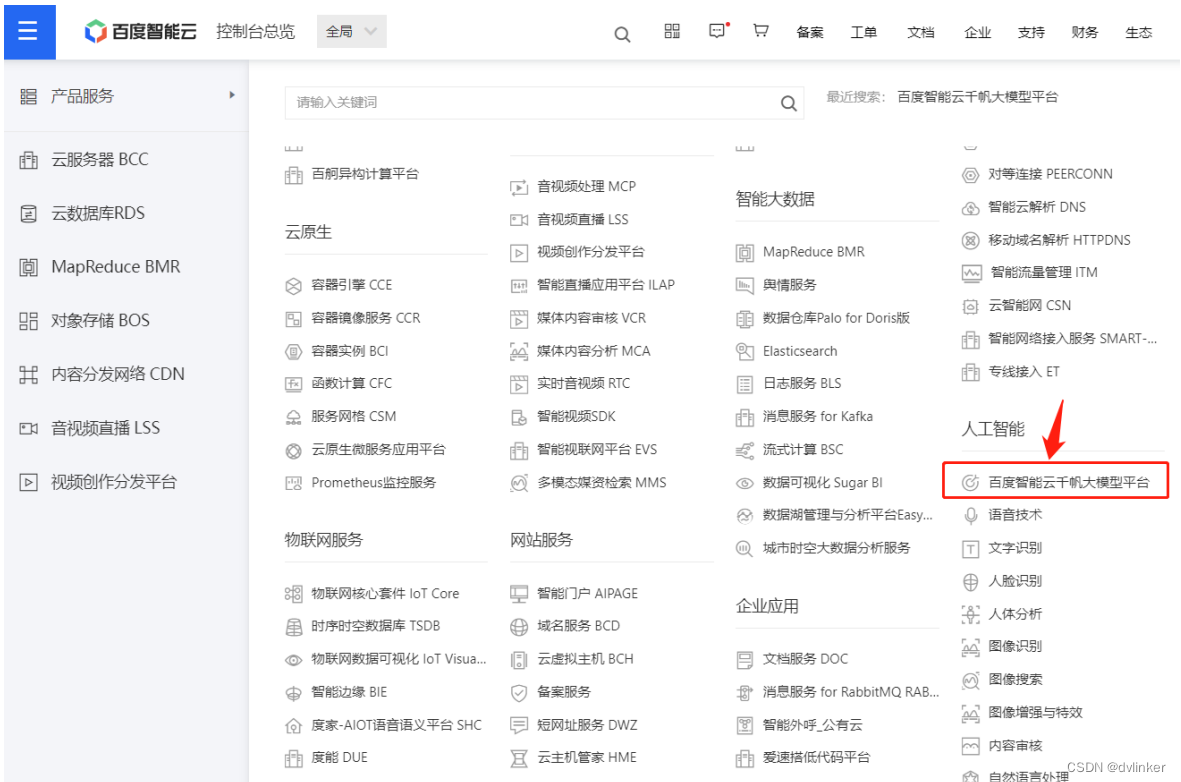

在打开的控制台页面中,点击左上角的三道杠按钮,在展开的页面中点击产品服务,然后找到“百度智能云千帆大模型平台”,如下所示:

点击进入大模型页面,这样就可以按照概览页的操作指引,正式开始使用千帆大模型平台。

4、Prompt模板体验

Prompt含义是提示词,用户通过自然语言向大模型提出问题或搜索关键字(提出命令或指令),指示大模型生成对应的内容。而在实际应用时,大模型往往因为Prompt缺乏针对性、描述不清晰等原因影响到大模型提供内容的准确性。

为帮助客户提高Prompt提问质量、提升模型输出满意度,本轮升级后,百度智能云千帆大模型平台上线了海量预置Prompt模板库,模板数量多达103个,包含对话、编程、电商、医疗、游戏、翻译、演讲等十余个常见场景。用户可以根据需求选择合适的模板,直接输出给大模型, 即可提高模型内容的针对性和准确度。Prompt对于大模型的使用效果非常重要,优质的Prompt提问能得到更高质量的回答。通过优化和改进Prompt的提问方式,可以提高模型的针对性和准确度,从而生成更高质量的内容。

4.1、Prompt效果体验

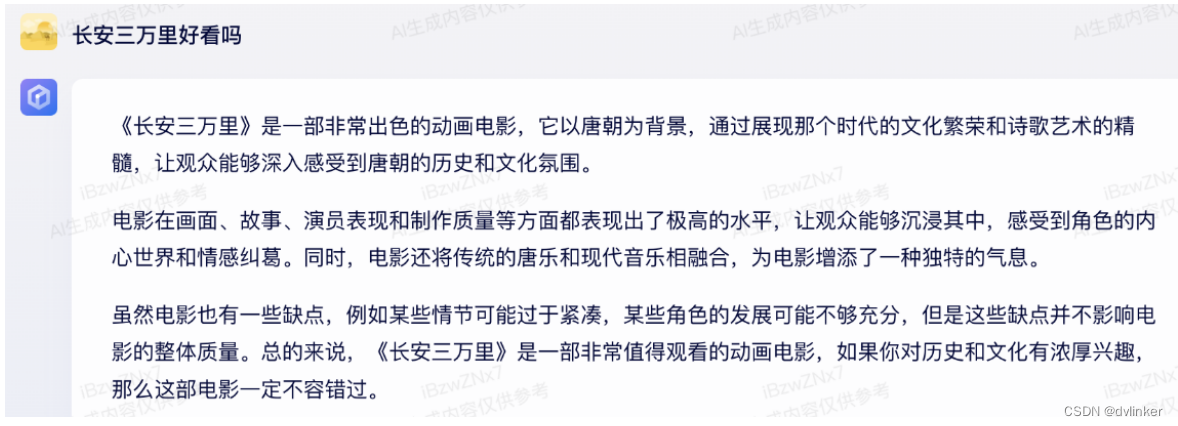

输入原始的Prompt:“长安三万里好看吗?”,文心一言会返回一个比较宽泛的结果:

但使用Prompt模板+原始Prompt,文心一言就会返回一个更符合预期的答案:

4.2、Prompt模板的使用介绍

大模型平台提供了100多款预置Prompt模板供大家使用:

大家可根据自己的需要,选择引用适合自己的Prompt模板。

如果预置模板无法满足大家的需求,还可以在自制模板模块中进行创建自定义的自制模板:

点击“创建Prompt模板”按钮,打开创建创建页面:

填写模板名称,选择模板标签,然后填写模板内容,可以直接填入引用的内容,也可以“{}”注入变量。

在Prompt模版列表中可以查看模板,点击模版名称即可查看Prompt模板详情:

可以在Prompt模板列表中可对指定模版进行编辑、删除和复制ID等操作:

4.3、如何调用API接口获取Prompt模版?

4.3.1、创建应用

先创建一个应用:

应用创建完后,在应用列表里就会看到刚才创建的那个应用:

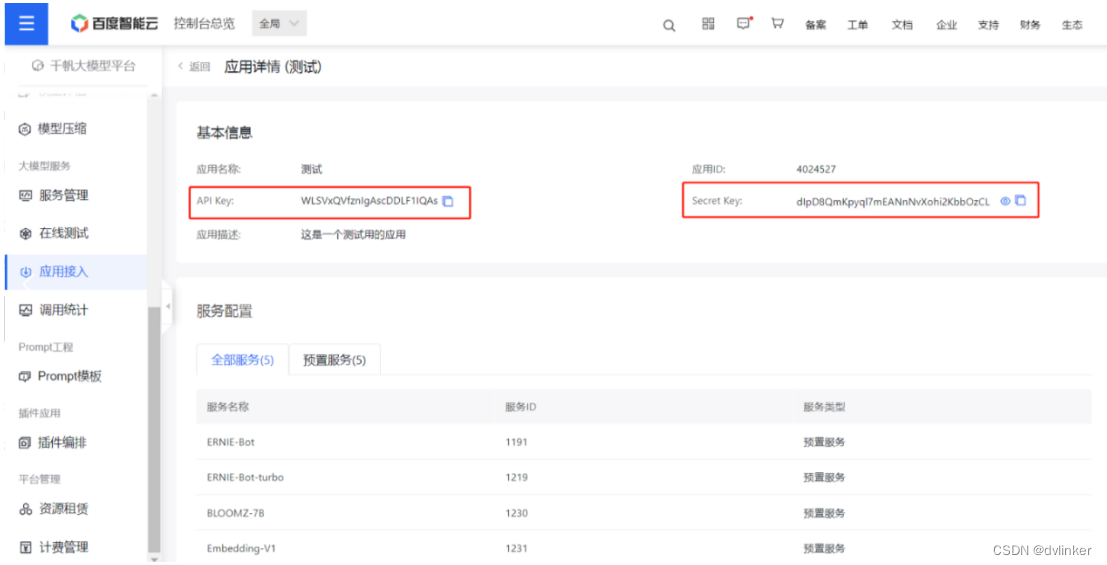

点击右侧的详情按钮,去查看该应用的API Key和Secret Key:

这两个Key后面要用到。

4.3.2、获取access_token

百度开放平台目前使用OAuth2.0授权调用开放API,调用API时必须在URL中带上Access_token参数。

先向授权服务地址https://aip.baidubce.com/oauth/2.0/token发送请求(推荐使用POST),并在URL中带上以下参数:

- grant_type: 必须参数,固定为client_credentials;

- client_id: 必须参数,应用的API Key;

- client_secret: 必须参数,应用的Secret Key;

相关演示代码如下:

def get_access_token():

"""

使用 API Key,Secret Key 获取access_token,替换下列示例中的应用API Key、应用Secret Key

"""

url = "https://aip.baidubce.com/oauth/2.0/token?"

headers = {

'Content-Type': 'application/json',

'Accept': 'application/json'

}

params = {

'grant_type':'client_credentials',

'client_id':'应用API Key',

'client_secret':'应用Secret Key'

}

response = requests.request("POST", url, headers=headers,params=params)

return response.json().get("access_token")

if __name__ == '__main__':

print(get_access_token())4.3.3、模板api调用

使用URL:https://aip.baidubce.com/rest/2.0/wenxinworkshop/api/v1/template/info,请求方式用GET,相关携带参数说明:

模板api接口调用演示代码如下:

import requests

def main():

url = "https://aip.baidubce.com/rest/2.0/wenxinworkshop/api/v1/template/info?"

access_token = get_access_token()

params = {

'access_token':access_token,

'id':1968, # 模板的id

'content':'测试' # 变量

}

headers = {

'Content-Type': 'application/json'

}

response = requests.get(url,params=params,headers=headers)

print(response.text)

def get_access_token():

"""

使用 API Key,Secret Key 获取access_token,替换下列示例中的应用API Key、应用Secret Key

"""

url = "https://aip.baidubce.com/oauth/2.0/token?"

headers = {

'Content-Type': 'application/json',

'Accept': 'application/json'

}

params = {

'grant_type':'client_credentials',

'client_id':'WLSVxQVfznIgAscDDLF1IQAs',

'client_secret':'dIpD8QmKpyql7mEANnNvXohi2KbbOzCL'

}

response = requests.request("POST", url, headers=headers,params=params)

return response.json().get("access_token")

if __name__ == '__main__':

main()至此,Prompt模版的体验及相关使用说明就介绍完了,也希望能给大家提供一个借鉴和参考。

5、最后

经过上述的探索与体验,让我充分了解到了千帆大模型平台提供的丰富功能,操作简单易用,操作界面友好,平台还提供内容安全的机制,使大模型内容更加安全可控。

千帆大模型平台提供全面领先的平台功能:

- 覆盖大模型全生命周期,更全面

提供数据标注,模型训练与评估,推理服务与应用集成的全面功能服务- 训练与推理性能大幅提升,更高效

MLPerf榜单训练性能世界领先,千亿模型分布式并行训练加速能力和算力利用率大幅提升- 快速应用编排与插件集成,更开放更开放

预置百度文心大模型与第三方大模型,支持插件与应用灵活编排,助力大模型多场景落地应用- 自带敏感词过滤

完善的鉴权与流控安全机制,自带问答内容审核与敏感词过滤,多重安全机制护航企业应用

如果你是使用或打算尝试大模型的用户,无论是个人还是企业用户,百度智能云的千帆大模型都是你最佳的选择!千帆大模型已全面开启体验试用,感兴趣的朋友快来点击链接:百度千帆大模型体验链接,申请体验试用吧!