ALPAGASUS : TRAINING A BETTER ALPACA WITH FEWER DATA♢

Introduction

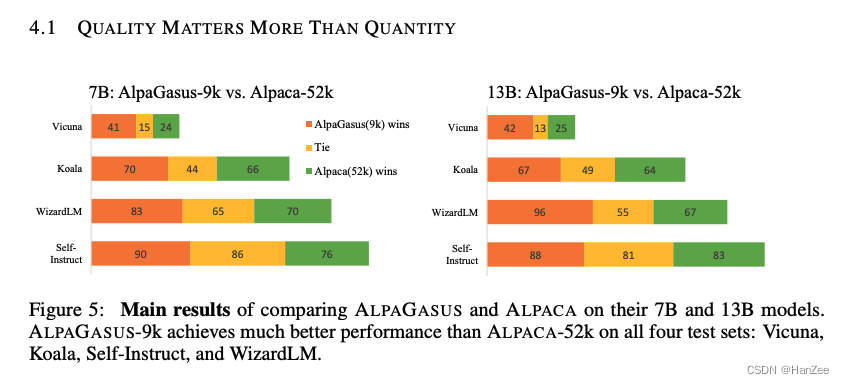

本文证明了数据的质量的重要性要大于数量。作者通过与GPT交互的方法过滤了Alpaca52k的数据,剩下9k,对二者分别微调,通过实验对比,发现9k的性能远大于52k。

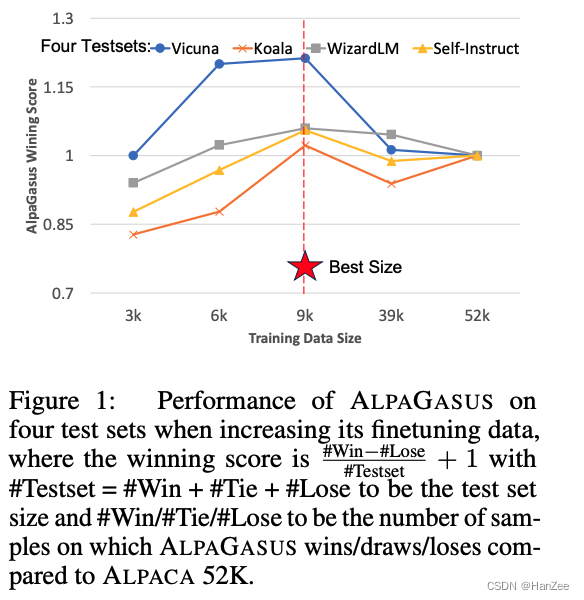

第二点贡献是:作者通过混合其他开源指令数据集(Vicuna),证明了在数据集数量为9k是性能最佳。

Method

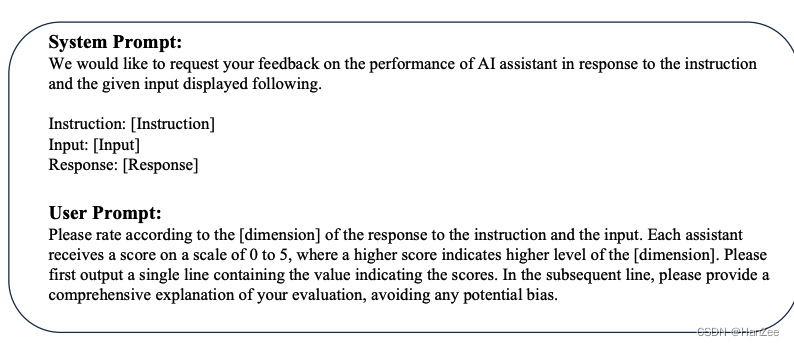

过滤方式就是通过In Context Learning 的方式与ChatGPT交互,为alpaca52k数据打分,分值为0-5.

prompt 如下:

之后选取4.5分以上的数据组成alpagasus 9k数据。

然后通过llama7b、llama13b分别对这两种数据集微调,性能对比如下:

同时作者也验证了 3k 6k的情况,发现9k的性能最好。

参考

https://arxiv.org/pdf/2307.08701.pdf