图像检索在搜索引擎中起着至关重要的作用。通常,他们的用户依靠图像或文本作为查询来检索所需的目标图像。然而,基于文本的检索有其局限性,因为使用单词准确描述目标图像可能具有挑战性。例如,在搜索时尚商品时,用户可能想要其特定属性(例如徽标的颜色或徽标本身)与他们在网站中找到的物品不同的商品。然而,在现有搜索引擎中搜索该商品并非易事,因为通过文本精确描述时尚商品可能具有挑战性。为了解决这一事实,组合图像检索 (CIR) 基于一个查询来检索图像,该查询结合了图像和文本示例,该示例提供了有关如何修改图像以适应预期检索目标的说明。因此,CIR允许通过组合图像和文本来精确检索目标图像。

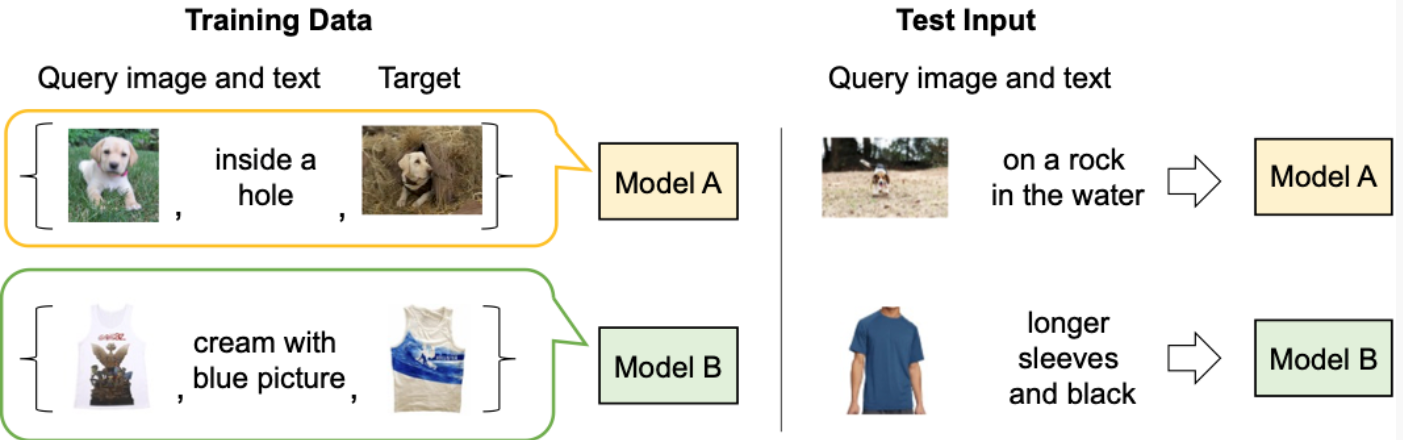

然而,CIR 方法需要大量的标记数据,即 1) 查询图像、2) 描述和 3) 目标图像的三元组。收集此类标记数据的成本很高,并且根据这些数据训练的模型通常是针对特定用例量身定制的,这限制了它们推广到不同数据集的能力。

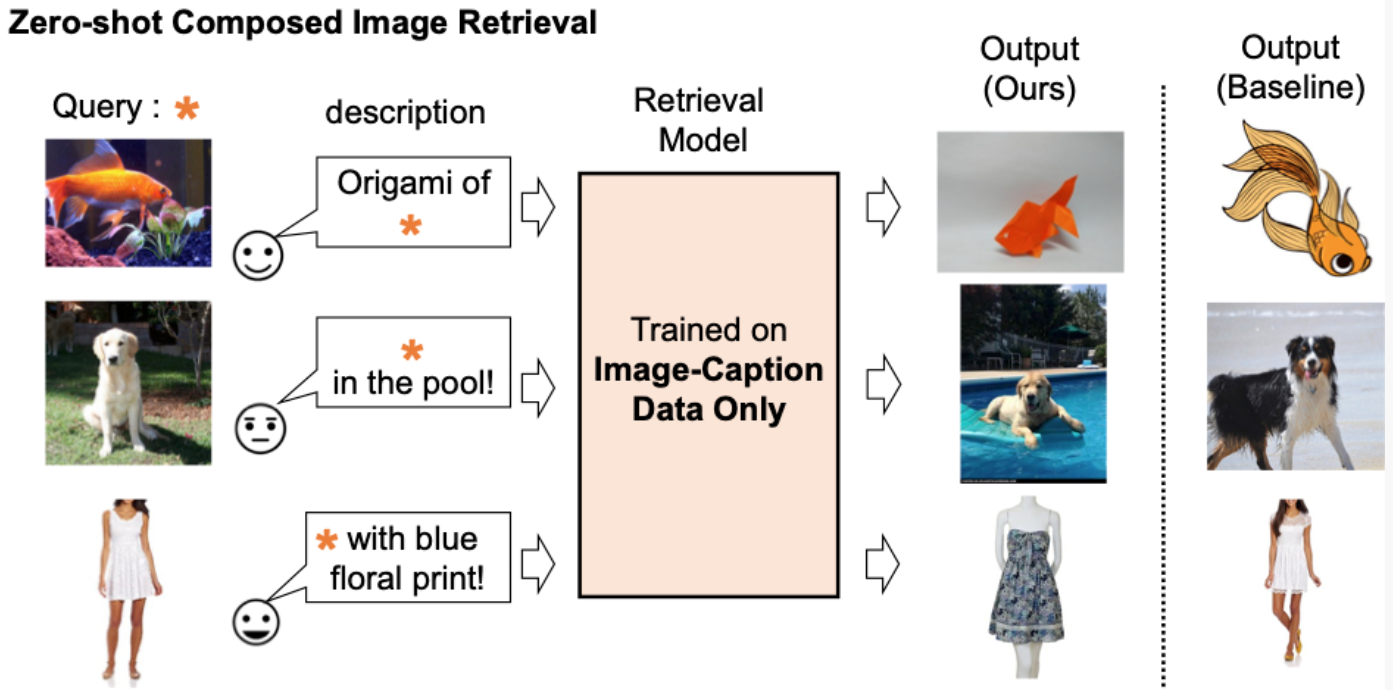

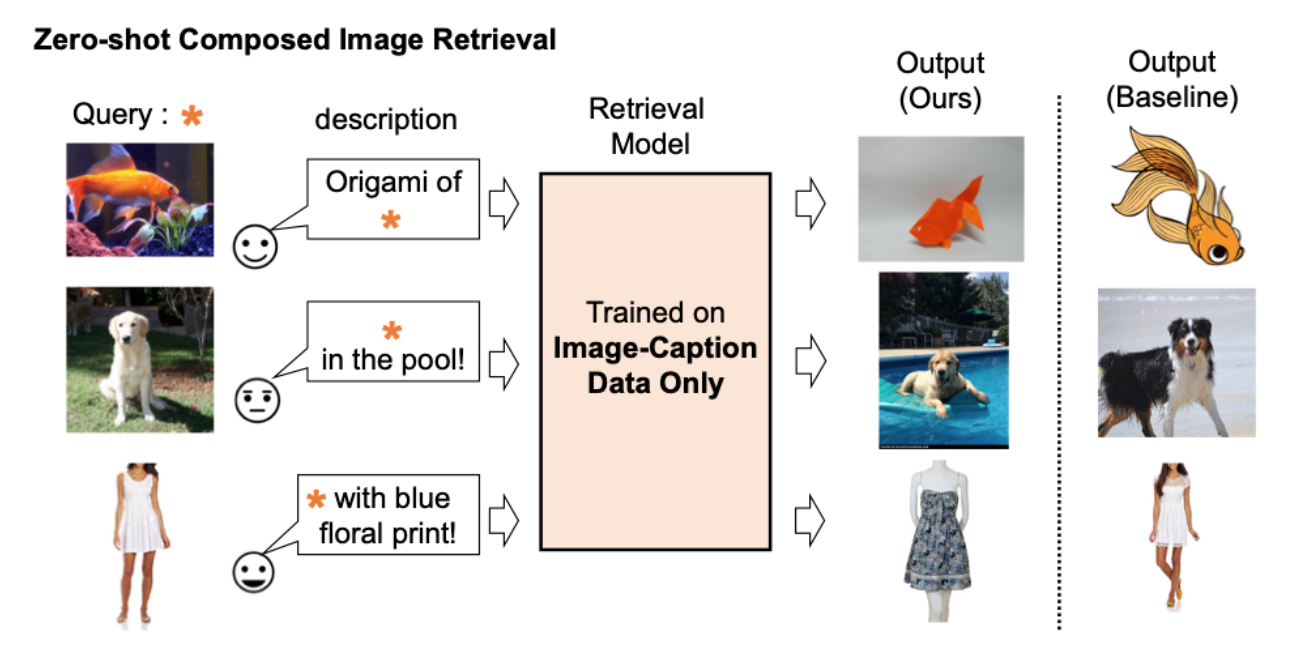

为了应对这些挑战,在“ Pic2Word:将图片映射到单词以进行零镜头合成图像检索 ”中,我们提出了一项称为零镜头CIR(ZS-CIR)的任务。在ZS-CIR中,我们的目标是构建一个执行各种CIR任务的CIR模型,例如对象组合,属性编辑或域转换,而无需标记三元组数据。相反,我们建议使用大规模图像标题对和未标记图像来训练检索模型,这比大规模监督CIR数据集更容易收集。为了鼓励可重复性并进一步推进这一领域,我们还发布了代码。

|

|

|---|

| 现有组合图像检索模型的描述。 |

|

|

|---|

| 我们仅使用图像标题数据训练组合图像检索模型。我们的模型检索与查询图像和文本的组成对齐的图像。 |

方法概述

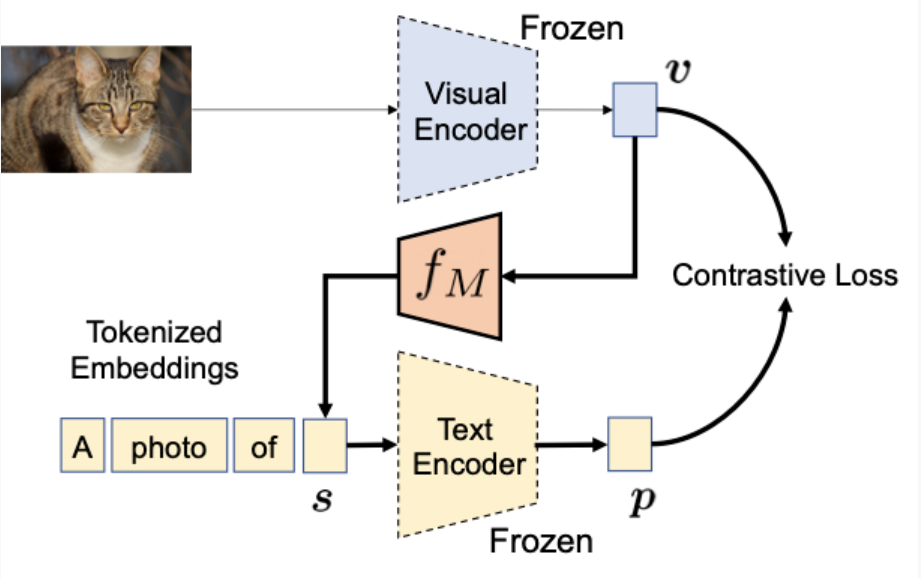

我们建议在对比语言图像预训练模型(CLIP)中利用语言编码器的语言功能,该模型擅长为广泛的文本概念和属性生成语义上有意义的语言嵌入。为此,我们在 CLIP 中使用了一个轻量级映射子模块,该子模块旨在将输入图片(例如,猫的照片)从图像嵌入空间映射到文本输入空间中的单词标记(例如,“猫”)。整个网络通过视觉语言对比损失进行了优化,以再次确保视觉和文本嵌入空间在给定一对图像及其文本描述的情况下尽可能接近。然后,可以将查询图像视为单词。这使得语言编码器能够灵活、无缝地组合查询图像特征和文本说明。我们将我们的方法称为 Pic2Word,并在下图中概述了其训练过程。我们希望映射的令牌以单词标记的形式表示输入图像。然后,我们训练映射网络以重建语言嵌入中的图像嵌入p。具体来说,我们优化了CLIP中提出的视觉嵌入v和文本嵌入p之间的对比损失。

|

|

|---|

| 仅使用未标记图像训练映射网络(f M)。我们仅使用冻结的可视和文本编码器优化映射网络。 |

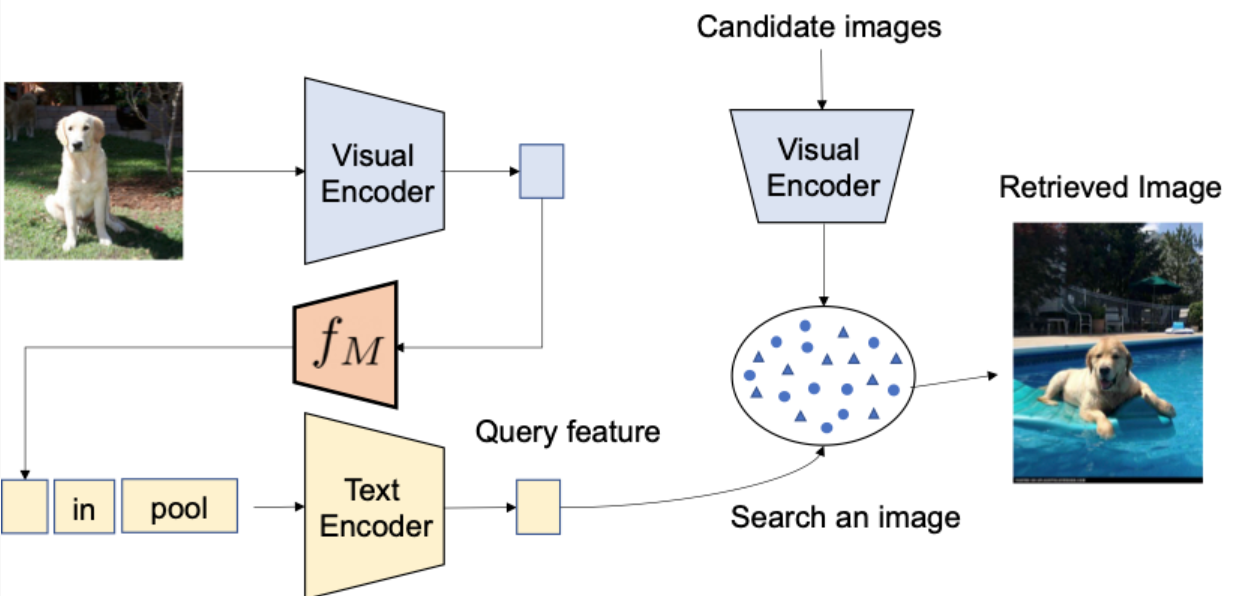

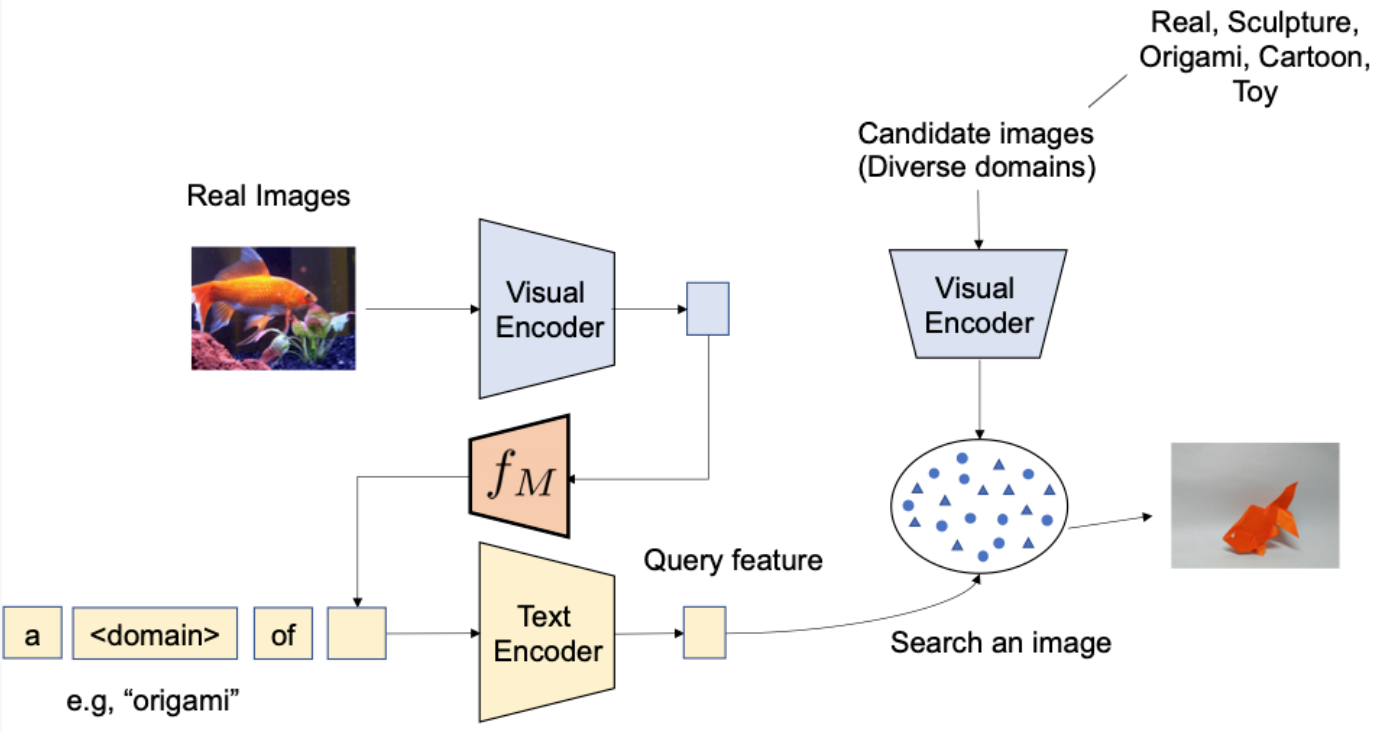

给定经过训练的映射网络,我们可以将图像视为单词标记,并将其与文本描述配对,以灵活地组成图-文本联合查询,如下图所示。

|

|

|---|

| 通过经过训练的映射网络,我们将图像视为单词标记,并将其与文本描述配对,以灵活地组成图像-文本联合查询。 |

评价

我们进行了各种实验来评估Pic2Word在各种CIR任务上的表现。

域名转换

我们首先评估所提出的方法在域转换方面的组合能力 - 给定图像和所需的新图像域(例如,雕塑,折纸,卡通,玩具),系统的输出应该是具有相同内容但具有新期望图像域或样式的图像。如下图所示,我们评估了分别以图像和文本形式组合类别信息和域描述的能力。我们使用ImageNet和ImageNet-R评估从真实图像到四个域的转换。

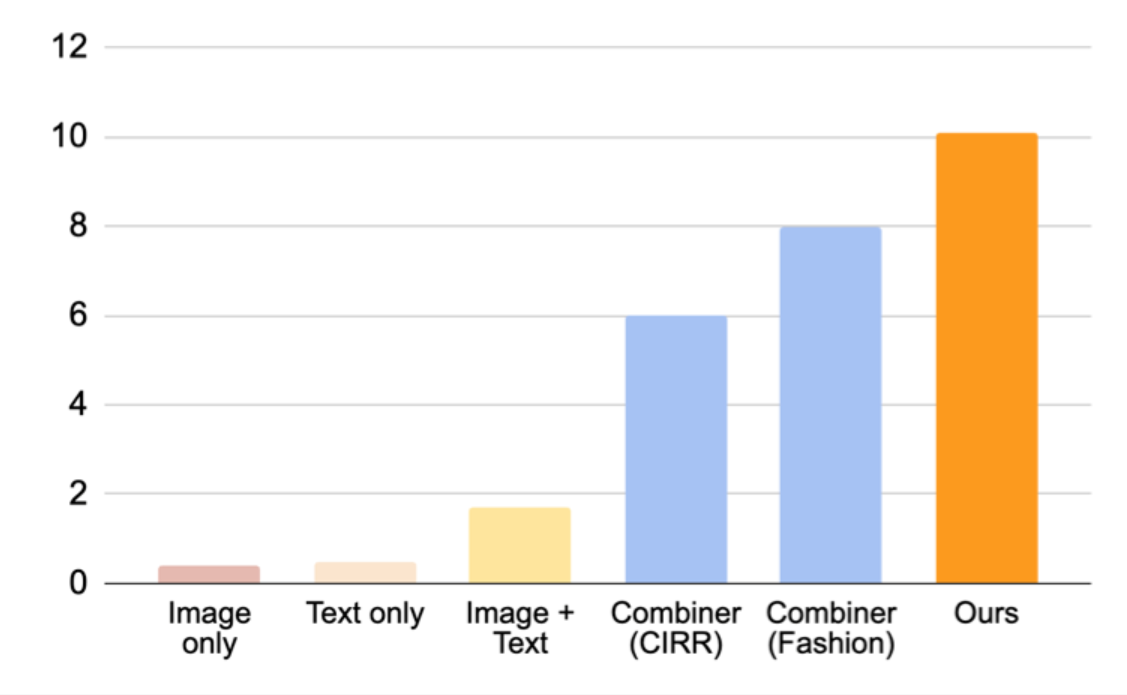

为了与不需要监督训练数据的方法进行比较,我们选择了三种方法:(i)图像仅使用视觉嵌入执行检索,(ii)文本仅使用文本嵌入,以及(iii)图像+文本平均视觉和文本嵌入以组成查询。与(iii)的比较显示了使用语言编码器撰写图像和文本的重要性。我们还与Combiner进行了比较,Combiner在Fashion-IQ或CIRR上训练CIR模型。

|

|

|---|

| 我们的目标是将输入查询图像的域转换为用文本描述的域,例如折纸。 |

如下图所示,我们提出的方法大大优于基线。

|

|

|---|

| 组合图像检索的结果(回想@10,即检索到的前10张图像中相关实例的百分比)以进行域转换。 |

时尚属性构成

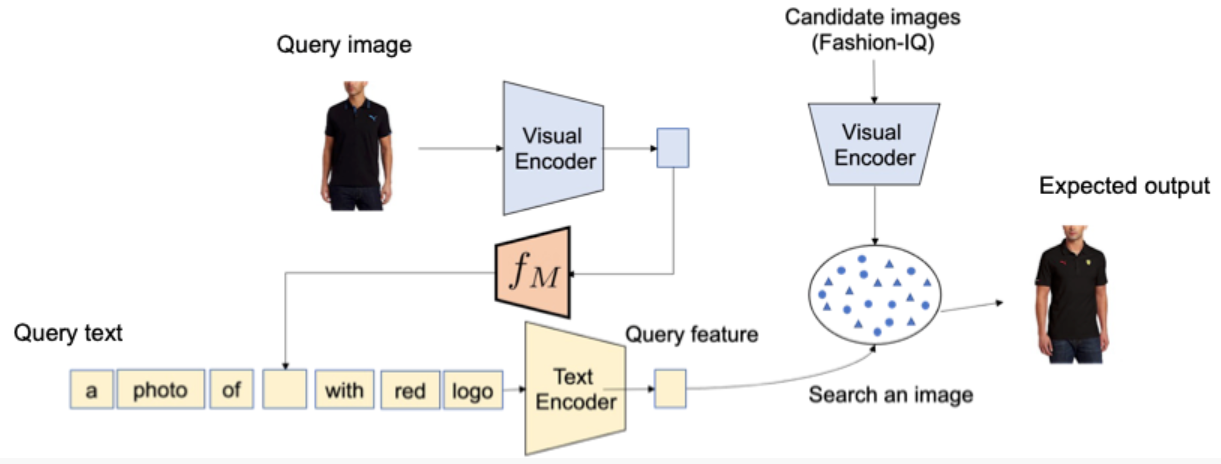

接下来,我们使用 Fashion-IQ 数据集评估时尚属性的组成,例如布料的颜色、徽标和袖子的长度。下图说明了给定查询的所需输出。

|

|

|---|

| 时尚属性的CIR概述。 |

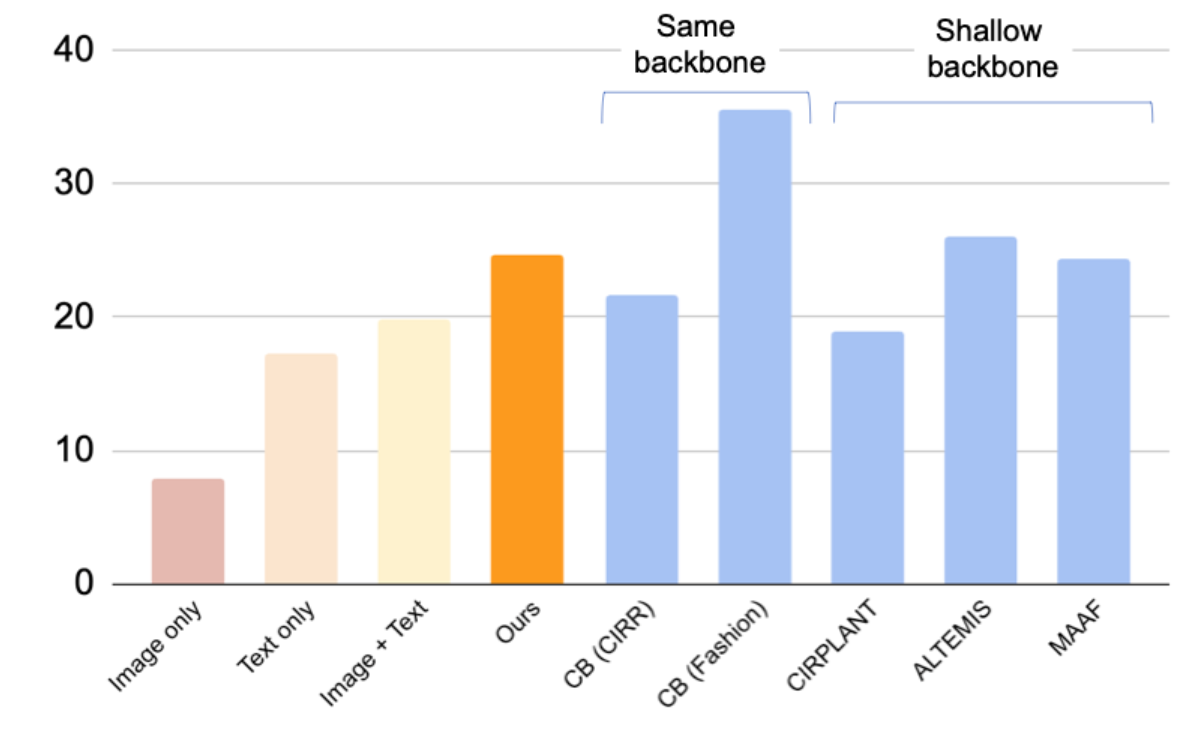

在下图中,我们提供了与基线的比较,包括使用三元组来训练CIR模型的监督基线:(i)CB使用与我们的方法相同的架构,(ii)CIRPLANT,ALTEMIS,MAAF使用较小的骨干,例如ResNet50。与这些方法进行比较将使我们能够了解我们的零镜头方法在这项任务上的表现如何。

虽然CB优于我们的方法,但我们的方法比具有较小骨干的监督基线表现更好。这一结果表明,通过利用鲁棒的CLIP模型,我们可以训练一个高效的CIR模型,而无需注释的三元组。

|

|

|---|

| Fashion-IQ 数据集组合图像检索的结果(回想一下@10,即检索到的前 10 张图像中相关实例的百分比)(越高越好)。浅蓝色条使用三元组训练模型。请注意,我们的方法与这些具有浅(较小)骨干的监督基线相当。 |

定性结果

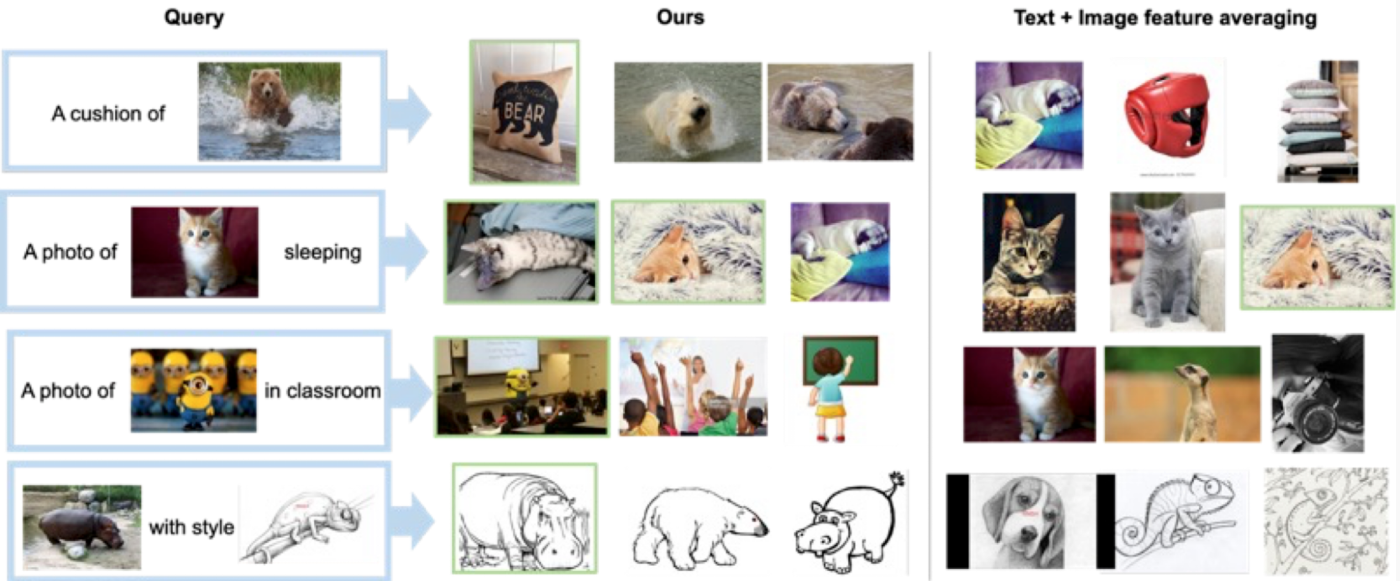

我们在下图中展示了几个示例。与不需要监督训练数据(文本+图像特征平均)的基线方法相比,我们的方法在正确检索目标图像方面做得更好。

|

|

|---|

| 各种查询图像和文本描述的定性结果。 |

结论和今后的工作

在本文中,我们介绍了Pic2Word,这是一种将图片映射到ZS-CIR单词的方法。我们建议将图像转换为单词标记,以仅使用图像标题数据集来实现CIR模型。通过各种实验,我们验证了训练模型在不同CIR任务上的有效性,表明在图像标题数据集上进行训练可以构建强大的CIR模型。一个潜在的未来研究方向是利用标题数据来训练映射网络,尽管我们在目前的工作中只使用图像数据。