Bernstein–von Mises类型的定理指出,可用于采样的数据越多,先验概率对预测模型的影响就越小,至少对于具有特定约束集的常见贝叶斯推理模型是这样。随着数据池的扩大,后验分布变得更加独立于先验概率假设,后验曲线看起来就像(渐近于)从最大似然估计器绘制的抽样分布。

所以在实际推断中,选择非信息性(或信息性较弱)的先验通常是出于 Bernstein-von-Mises 定理的渐近一致性保证。

符号

I θ I_{\theta} Iθ : Fisher information (Fisher 信息),

ℓ θ ( x ) = log p θ ( x ) , \ell_{\theta}(x)=\log p_{\theta}(x) , ℓθ(x)=logpθ(x),

ℓ ˙ θ ( x ) = d d θ ℓ θ ( x ) , \dot{\ell}_{\theta}(x)=\frac{d}{d \theta} \ell_{\theta}(x), ℓ˙θ(x)=dθdℓθ(x),

ℓ ¨ θ ( x ) = d 2 d θ 2 ℓ θ ( x ) , \ddot{\ell}_{\theta}(x)=\frac{d^{2}}{d \theta^{2}} \ell_{\theta}(x), ℓ¨θ(x)=dθ2d2ℓθ(x),

Δ n , θ = 1 / n ∑ i = 1 n \Delta_{n, \theta}=1 / \sqrt{n} \sum_{i=1}^{n} Δn,θ=1/n∑i=1n ℓ ˙ θ ( x i ) \dot{\ell}_{\theta}\left(x_{i}\right) ℓ˙θ(xi)

I n , θ = − 1 / n ∑ i = 1 n ℓ ¨ θ ( x i ) , I_{n, \theta}=-1 / n \sum_{i=1}^{n} \ddot{\ell}_{\theta}\left(x_{i}\right) \text {, } In,θ=−1/n∑i=1nℓ¨θ(xi),

∥ ⋅ ∥ T V \|\cdot\|_{T V} ∥⋅∥TV : total variation(总变化量),

前言

在模型中 ( P θ : θ ∈ Θ ) \left(P_{\theta}: \theta \in \Theta\right) (Pθ:θ∈Θ) ,在某些规律性条件下 (有限维度,光滑,测度的存在),如果先验分布上 θ \theta θ 相对于 Lebesgue测度的密度足够光滑(接近 θ 0 \theta_{0} θ0 远离零),后验分布之间的总变化距离 (通过居中和重新缩放到 n ( θ − θ 0 ) \sqrt{n}\left(\theta-\theta_{0}\right) n(θ−θ0) ) 和高斯分布以任何为中心有效的估计器随着逆Fisher信息,作为方差的趋势将趋于0。

贝叶斯公式

根据贝叶斯公式, θ \theta θ的后验密度由下式给出

π ( θ ∣ X 1 , … , X n ) = ∏ i = 1 n p θ ( X i ) π ( θ ) ∫ ∏ i = 1 n p θ ( X i ) π ( θ ) d θ . \pi\left(\theta \mid X_{1}, \ldots, X_{n}\right)=\frac{\prod_{i=1}^{n} p_{\theta}\left(X_{i}\right) \pi(\theta)}{\int \prod_{i=1}^{n} p_{\theta}\left(X_{i}\right) \pi(\theta) d \theta} . π(θ∣X1,…,Xn)=∫∏i=1npθ(Xi)π(θ)dθ∏i=1npθ(Xi)π(θ).

贝叶斯公式的另一个有趣的性质是源自当我们观察无穷次观察之后会发生什么,通常被称为Bernstein-von Mises定理。

泰勒展开

log p θ + h p θ ( x ) = h T ℓ ˙ θ ( x ) + 1 2 h T ℓ ¨ θ ( x ) h + o p ( ∥ h ∥ 2 ) \log \frac{p_{\theta+h}}{p_{\theta}}(x)=h^{T} \dot{\ell}_{\theta}(x)+\frac{1}{2} h^{T} \ddot{\ell}_{\theta}(x) h+o_{p}\left(\|h\|^{2}\right) logpθpθ+h(x)=hTℓ˙θ(x)+21hTℓ¨θ(x)h+op(∥h∥2)

在非贝叶斯视角下,当我们要对某参数模型的参数进行估计时,我们常常会运用 中心极限定理(CLT),并得到一个类似这样的结果,

n ( θ ^ n − θ 0 ) → N ( 0 , Σ ) \sqrt{n}\left(\hat{\theta}_{n}-\theta_{0}\right) \rightarrow N(0, \Sigma) n(θ^n−θ0)→N(0,Σ)

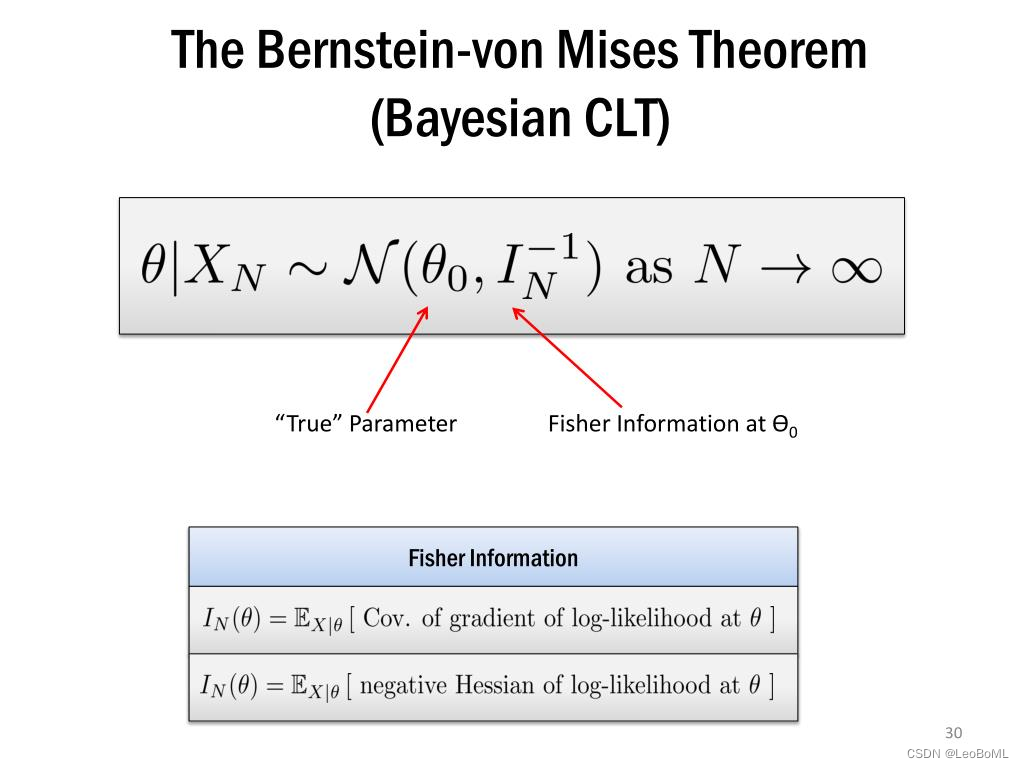

在贝叶斯视角下我们类似的结论,堪称是贝叶斯 CLT,这就是我们要介绍的 Bernstein–von Mises类型的定理

Bernstein–von Mises类型的定理

Bernstein-von Mises定理告诉我们,当我们获得更多的数据时,我们的后验估计将渐进地独立于我们最初(先前)的信念。这在某种程度上类似于频率统计中的律数定律,它告诉我们,当我们获得越来越多的数据时,样本的均值最终将等于总体的均值。

在某些条件下:

∥ Π ( n ( ϑ − θ 0 ) ∈ ⋅ ∣ X 1 , … , X n ) − N d ( I θ 0 − 1 Δ n , θ 0 , I θ 0 − 1 ) ∥ T V → 0 in P θ 0 n \left\|\Pi\left(\sqrt{n}\left(\vartheta-\theta_{0}\right) \in \cdot \mid X_{1}, \ldots, X_{n}\right)-N_{d}\left(I_{\theta_{0}}^{-1} \Delta_{n, \theta_{0}}, I_{\theta_{0}}^{-1}\right)\right\|_{T V} \rightarrow 0 \text { in } P_{\theta_{0}}^{n}

Π(n(ϑ−θ0)∈⋅∣X1,…,Xn)−Nd(Iθ0−1Δn,θ0,Iθ0−1)

TV→0 in Pθ0n

这里,变量 Δ n , θ 0 \Delta_{n,\theta_0} Δn,θ0的序列在 θ 0 \theta_0 θ0下收敛到 N d ( 0 , I { θ 0 } ) N_d(0,I_{\{\theta_0\}}) Nd(0,I{

θ0})。

证明草图:

step 1:应用CLT的泰勒展开

假设数据是来自密度 p θ p_{\theta} pθ的随机样本 X 1 , … , X n X_{1}, \ldots, X_{n} X1,…,Xn,该密度 p θ p_{\theta} pθ平滑地依赖于 θ ∈ Θ \theta \in \Theta θ∈Θ 参数,并允许形式的泰勒展开,

log p θ + h p θ ( x ) = h T ℓ ˙ θ ( x ) + 1 2 h T ℓ ¨ θ ( x ) h + … \log \frac{p_{\theta+h}}{p_{\theta}}(x)=h^{T} \dot{\ell}_{\theta}(x)+\frac{1}{2} h^{T} \ddot{\ell}_{\theta}(x) h+\ldots logpθpθ+h(x)=hTℓ˙θ(x)+21hTℓ¨θ(x)h+…

现在我们将 h 替换为 h n 并对观察结果求和,我们发现 \text{现在我们将}h \text{替换为}\frac{h}{\sqrt{n}} \text{并对观察结果求和,我们发现} 现在我们将h替换为nh并对观察结果求和,我们发现

log ∏ i = 1 n p θ + h / n p θ ( X i ) = h T Δ n , θ + 1 2 h T I n , θ h + … \log \prod_{i=1}^{n} \frac{p_{\theta+h / \sqrt{n}}}{p_{\theta}}\left(X_{i}\right)=h^{T} \Delta_{n, \theta}+\frac{1}{2} h^{T} I_{n, \theta} h+\ldots \\ logi=1∏npθpθ+h/n(Xi)=hTΔn,θ+21hTIn,θh+…

其中,

Δ n , θ = 1 n ∑ i = 1 n ℓ ˙ θ ( X i ) , I n , θ = − 1 n ∑ i = 1 n ℓ ¨ θ ( X i ) . \Delta_{n, \theta}=\frac{1}{n} \sum_{i=1}^{n} \dot{\ell}_{\theta}\left(X_{i}\right), \quad I_{n, \theta}=-\frac{1}{n} \sum_{i=1}^{n} \ddot{\ell}_{\theta}\left(X_{i}\right) .\\ Δn,θ=n1i=1∑nℓ˙θ(Xi),In,θ=−n1i=1∑nℓ¨θ(Xi).

注意在分布中 Δ n , θ → Δ θ : = N ( 0 , I θ ) 并且通过中心极限定理在概率中 I n , θ → I θ 。 \text { 注意在分布中} \Delta_{n, \theta} \rightarrow \Delta_{\theta}:=N\left(0, I_{\theta}\right) \text { 并且通过中心极限定理在概率中 } I_{n, \theta} \rightarrow I_{\theta} 。 注意在分布中Δn,θ→Δθ:=N(0,Iθ) 并且通过中心极限定理在概率中 In,θ→Iθ。

step 2:重写后验。

在第一步中我们看到,对log-likelihood进行泰勒展开,我们就可以运用CLT, 因此我们想对posterior进行泰勒展开

我们重新缩放参数以获得CLT形式的结果。因此,我们研究了 n ( ϑ − θ 0 ) \sqrt{n}\left(\vartheta-\theta_{0}\right) n(ϑ−θ0)的后验,其密度为

π n ( n ( ϑ − θ 0 ) = h ∣ X 1 , … , X n ) = ∏ i = 1 n p θ n + h / n ( X i ) π ( θ n + h / n ) ∫ ∏ i = 1 n p θ n + h / n ( X i ) π ( θ n + h / n ) d h \pi_{n}\left(\sqrt{n}\left(\vartheta-\theta_{0}\right)=h \mid X_{1}, \ldots, X_{n}\right)=\frac{\prod_{i=1}^{n} p_{\theta_{n}+h / \sqrt{n}}\left(X_{i}\right) \pi\left(\theta_{n}+h / \sqrt{n}\right)}{\int \prod_{i=1}^{n} p_{\theta_{n}+h / \sqrt{n}}\left(X_{i}\right) \pi\left(\theta_{n}+h / \sqrt{n}\right) d h} πn(n(ϑ−θ0)=h∣X1,…,Xn)=∫∏i=1npθn+h/n(Xi)π(θn+h/n)dh∏i=1npθn+h/n(Xi)π(θn+h/n)

如果先验是连续的,那么对于大 n n n,我们可以使用 π ( θ 0 ) \pi\left(\theta_{0}\right) π(θ0)来近似 π ( θ 0 + h / n ) \pi\left(\theta_{0}+h / \sqrt{n}\right) π(θ0+h/n)。它导致了前面的公式

π n ( n ( ϑ − θ 0 ) = h ∣ X 1 , … , X n ) = ∏ i = 1 n p θ n + h / n ( X i ) ∫ ∏ i = 1 n p θ n + h / n ( X i ) d h = ∏ i = 1 n p θ n + h / n / p θ 0 ( X i ) ∫ ∏ i = 1 n p θ n + h / n / p θ 0 ( X i ) d h \pi_{n}\left(\sqrt{n}\left(\vartheta-\theta_{0}\right)=h \mid X_{1}, \ldots, X_{n}\right)=\frac{\prod_{i=1}^{n} p_{\theta_{n}+h / \sqrt{n}}\left(X_{i}\right)}{\int \prod_{i=1}^{n} p_{\theta_{n}+h / \sqrt{n}}\left(X_{i}\right) d h}=\frac{\prod_{i=1}^{n} p_{\theta_{n}+h / \sqrt{n}} / p_{\theta_{0}}\left(X_{i}\right)}{\int \prod_{i=1}^{n} p_{\theta_{n}+h / \sqrt{n}} / p_{\theta_{0}}\left(X_{i}\right) d h} πn(n(ϑ−θ0)=h∣X1,…,Xn)=∫∏i=1npθn+h/n(Xi)dh∏i=1npθn+h/n(Xi)=∫∏i=1npθn+h/n/pθ0(Xi)dh∏i=1npθn+h/n/pθ0(Xi)

现在,我们已经将后验改写成了step 1中的形式,因此我们对其泰勒展开,其分子约等于 h T Δ n , θ + 1 2 h T I θ , n h h^{T} \Delta_{n, \theta}+\frac{1}{2} h^{T} I_{\theta, n}h hTΔn,θ+21hTIθ,nh。

step 3:高斯后验逼近

另外,对于高斯分布, 通过计算可以得到

log d N ( h , I θ − 1 ) d N ( 0 , I θ − 1 ) ( X ) = h T I θ X − 1 2 h T I θ h \log \frac{d N\left(h, I_{\theta}^{-1}\right)}{d N\left(0, I_{\theta}^{-1}\right)}(X)=h^{T} I_{\theta} X-\frac{1}{2} h^{T} I_{\theta} h logdN(0,Iθ−1)dN(h,Iθ−1)(X)=hTIθX−21hTIθh

将 Δ θ = I θ X \Delta_{\theta}=I_{\theta} X Δθ=IθX ,我们可以看到, ( P θ + h / n ) → N ( h , I θ − 1 ) \left(P_{\theta+h / \sqrt{n}}\right) \rightarrow N\left(h, I_{\theta}^{-1}\right) (Pθ+h/n)→N(h,Iθ−1) ,所以后验的渐近行为可以用 N ( h , I θ − 1 ) N\left(h, I_{\theta}^{-1}\right) N(h,Iθ−1)表示为

d N ( h , I θ 0 − 1 ) / d N ( 0 , I θ 0 − 1 ) ( X ) ∫ d N ( h , I θ 0 − 1 ) / d N ( 0 , I θ 0 − 1 ) ( X ) d h = d N ( h , I θ 0 − 1 ) ( X ) ∫ d N ( h , I θ 0 − 1 ) ( X ) d h = d N ( X , I θ 0 − 1 ) ( h ) 其中 X ∼ I θ 0 − 1 N ( 0 , I θ 0 ) \frac{d N\left(h, I_{\theta_{0}}^{-1}\right) / d N\left(0, I_{\theta_{0}}^{-1}\right)(X)}{\int d N\left(h, I_{\theta_{0}}^{-1}\right) / d N\left(0, I_{\theta_{0}}^{-1}\right)(X) d h}=\frac{d N\left(h, I_{\theta_{0}}^{-1}\right)(X)}{\int d N\left(h, I_{\theta_{0}}^{-1}\right)(X) d h} =d N\left(X, I_{\theta_{0}}^{-1}\right)(h)\\ \text {其中} X \sim I_{\theta_{0}}^{-1} N\left(0, I_{\theta_{0}}\right) ∫dN(h,Iθ0−1)/dN(0,Iθ0−1)(X)dhdN(h,Iθ0−1)/dN(0,Iθ0−1)(X)=∫dN(h,Iθ0−1)(X)dhdN(h,Iθ0−1)(X)=dN(X,Iθ0−1)(h)其中X∼Iθ0−1N(0,Iθ0)

渐进理论

在贝叶斯推断, 这Bernstein-Von Mises定理提供了使用贝叶斯可信集以置信陈述的基础参数模型。它指出,在某些条件下,后验分布以无限数据的极限收敛到以最大似然估计量为中心的多变量正态分布,其协方差矩阵给出 : n − 1 I ( θ 0 ) − 1 n^{-1} I\left(\theta_{0}\right)^{-1} n−1I(θ0)−1 , 在这里 θ 0 \theta_{0} θ0 是真实的人口参数 I ( θ 0 ) I\left(\theta_{0}\right) I(θ0) 是个Fisher信息矩阵在真实的总体参数值。

Bernstein-Von Mises定理链接贝叶斯推断和经常推断。它假设存在一些真正的概率过程,可以在频繁主义中产生观察结果,然后研究贝叶斯恢复该过程的方法的质量,并就该过程做出不确定性陈述。特别是,它指出贝叶斯可信的一定信誉级别 α \alpha α将渐近地成为信心水平的信心集 α \alpha α,这允许解释贝叶斯可信集。

设 { X j : j ≥ 1 } \left\{X_{j}: j \geq 1\right\} { Xj:j≥1}是独立的同分布随机变量,其概率密度取决于某个参数 θ \theta θ 。假设选择了 θ \theta θ的先验分布。贝叶斯推理的渐近理论中的一个基本定理是关于给定 X 1 … X n X_{1} \ldots X_{n} X1…Xn的 θ \theta θ的后验密度收敛于正态密度。

换句话说,后验分布趋向于渐近正态分布。这种现象最早是由拉普拉斯在独立和同分布观测的情况下注意到的。S.N. Bernstein [2]证明了一个相关但不同的结果,他考虑了 θ \theta θ的后验分布,给定平均 n − 1 ( X 1 + ⋯ + X n ) n^{-1}\left(X_{1}+\cdots+X_{n}\right) n−1(X1+⋯+Xn)。

R. von Mises [12]将结果扩展到经验分布函数的有限个可微泛函条件下的后验分布。L. Le Cam [5]在他关于最大似然的渐近性质和相关贝叶斯估计的工作中研究了这个问题。对于独立和同分布随机变量的情况,关于 L 1 − L_{1} - L1−均值收敛的 B e r n s t e i n − v o n M i s e s Bernstein-von\quad Mises Bernstein−vonMises定理如下,见[3]。

设 X i , 1 ≤ i ≤ n X_{i}, 1 \leq i \leq n Xi,1≤i≤n,是具有概率密度 f ( x , θ ) , θ ∈ Θ ⊂ R f(x, \theta), \theta \in \Theta \subset \mathbf{R} f(x,θ),θ∈Θ⊂R的独立同分布随机变量 。

假设 Θ \Theta Θ 是 开的 并且 λ \lambda λ 是 Θ \Theta Θ上的先验概率密度,在真参数 θ 0 \theta_{0} θ0的开放邻域内连续且为正。

设 h ( x , θ ) = log f ( x , θ ) h(x, \theta)=\log f(x, \theta) h(x,θ)=logf(x,θ) 。 假设 ∂ h / ∂ θ \partial h / \partial \theta ∂h/∂θ 和 ∂ 2 h / ∂ θ 2 \partial^{2} h / \partial \theta^{2} ∂2h/∂θ2 在 θ \theta θ 上存在并连续 。

进一步,假设 i ( θ ) = − E θ [ ∂ 2 h / ∂ θ 2 ] i(\theta)=-\mathrm{E}_{\theta}\left[\partial^{2} h / \partial \theta^{2}\right] i(θ)=−Eθ[∂2h/∂θ2] 是连续的, 其中 0 < i ( θ ) < ∞ 0<i(\theta)<\infty 0<i(θ)<∞ 。设 K ( ⋅ ) K(\cdot) K(⋅) 是一个满足的非负函数

∫ − ∞ ∞ K ( t ) exp [ − ( i ( θ 0 ) − ϵ ) t 2 2 ] d t < ∞ \int_{-\infty}^{\infty} K(t) \exp \left[-\frac{\left(i\left(\theta_{0}\right)-\epsilon\right) t^{2}}{2}\right] d t<\infty ∫−∞∞K(t)exp[−2(i(θ0)−ϵ)t2]dt<∞

对一些 0 < ϵ < i ( θ 0 ) 0<\epsilon<i\left(\theta_{0}\right) 0<ϵ<i(θ0) 。设 θ ^ n \hat{\theta}_{n} θ^n 是基于 X 1 … X n X_{1} \ldots X_{n} X1…Xn在 θ \theta θ 上的最大似然估计。设 L n ( θ ) L_{n}(\theta) Ln(θ) 为对应的似然函数。

已知在一定规律条件下在 θ 0 \theta_{0} θ0上 存在紧邻域 U θ 0 U_{\theta_{0}} Uθ0, 因此: θ ^ n → θ 0 \hat{\theta}_{n} \rightarrow \theta_{0} θ^n→θ0 几乎肯定;

( ∂ log L n ( θ ) / ∂ θ ) ∣ θ = θ ^ n = 0 \left.\left(\partial \log L_{n}(\theta) / \partial \theta\right)\right|_{\theta=\hat{\theta} n}=0 \quad (∂logLn(θ)/∂θ)∣θ=θ^n=0对于大 n n n ;

当 n → ∞ , n 1 / 2 ( θ ^ n − θ 0 ) n \rightarrow \infty ,n^{1 / 2}\left(\hat{\theta}_{n}-\theta_{0}\right) n→∞,n1/2(θ^n−θ0) 在分布上收敛到正态分布,均值为0,方差为 1 / i ( θ 0 ) 1 / i\left(\theta_{0}\right) 1/i(θ0)。

设 f n ( θ ∣ x 1 … x n ) f_{n}\left(\theta \mid x_{1} \ldots x_{n}\right) fn(θ∣x1…xn)为给定观测值 ( x 1 … x n ) \left(x_{1} \ldots x_{n}\right) (x1…xn)和先验概率密度 λ ( θ ) 的 θ \lambda(\theta)的\theta λ(θ)的θ的后验密度,即:

f n ( θ ∣ x 1 … x n ) = ∏ i = 1 n f ( x i , θ ) λ ( θ ) ∫ ∏ i = 1 n f ( x i , ϕ ) λ ( ϕ ) d ϕ f_{n}\left(\theta \mid x_{1} \ldots x_{n}\right)=\frac{\prod_{i=1}^{n} f\left(x_{i}, \theta\right) \lambda(\theta)}{\int \prod_{i=1}^{n} f\left(x_{i}, \phi\right) \lambda(\phi) d \phi} fn(θ∣x1…xn)=∫∏i=1nf(xi,ϕ)λ(ϕ)dϕ∏i=1nf(xi,θ)λ(θ)。

设 f n ∗ ( t ∣ x 1 … x n ) = n − 1 / 2 f n ( θ ^ n + t n − 1 / 2 ) 。然后 f n ∗ ( t ∣ x 1 … x n ) f_{n}^{*}\left(t \mid x_{1} \ldots x_{n}\right)=n^{-1 / 2} f_{n}\left(\hat{\theta}_{n}+t n^{-1 / 2}\right) 。 然后 f_{n}^{*}\left(t \mid x_{1} \ldots x_{n}\right) fn∗(t∣x1…xn)=n−1/2fn(θ^n+tn−1/2)。然后fn∗(t∣x1…xn) 是关于 t = n 1 / 2 ( θ − θ ^ n ) t=n^{1 / 2}\left(\theta-\hat{\theta}_{n}\right) t=n1/2(θ−θ^n)的后验密度。

在上述假设和一些附加的技术条件下,一个广义的Bernstein-von Mises theorem如下。

假如,对每个 h > 0 h>0 h>0 和 δ > 0 \delta>0 δ>0 ,

e − n δ ∫ ∣ t ∣ > h K ( n 1 / 2 t ) λ ( θ ^ n + t ) d t → 0 a.s. [ P θ 0 ] e^{-n \delta} \int_{|t|>h} K\left(n^{1 / 2} t\right) \lambda\left(\hat{\theta}_{n}+t\right) d t \rightarrow 0 \text { a.s. }\left[\mathrm{P}_{\theta_{0}}\right] e−nδ∫∣t∣>hK(n1/2t)λ(θ^n+t)dt→0 a.s. [Pθ0]

有

lim n → ∞ ∫ − ∞ ∞ K ( t ) . ⋅ ∣ f n ∗ ( t ∣ X 1 … X n ) − ( i ( θ 0 ) 2 π ) 1 / 2 e − 1 2 i ( θ 0 ) t 2 ∣ d t = = 0 a.s. [ P θ 0 ] . \begin{array}{c} \lim _{n \rightarrow \infty} \int_{-\infty}^{\infty} K(t) . \cdot\left|f_{n}^{*}\left(t \mid X_{1} \ldots X_{n}\right)-\left(\frac{i\left(\theta_{0}\right)}{2 \pi}\right)^{1 / 2} e^{-\frac{1}{2} i\left(\theta_{0}\right) t^{2}}\right| d t= =0 \text { a.s. }\left[\mathrm{P}_{\theta_{0}}\right] . \end{array} limn→∞∫−∞∞K(t).⋅

fn∗(t∣X1…Xn)−(2πi(θ0))1/2e−21i(θ0)t2

dt==0 a.s. [Pθ0].

对于 K ( t ) ≡ 1 K(t) \equiv 1 K(t)≡1 ,我们发现后验密度在 L 1 − L_{1} - L1−均值收敛时收敛到正态密度。结果可以扩展为多维参数。作为上述定理的应用,可以证明贝叶斯估计量对于合适的损失函数类是强一致和渐近有效的(参见[11])。关于收敛速率见[4], [7], [8]。

B.L.S. Prakasa Rao [6]将结果推广到任意离散时间随机过程(参见[1]);关于扩散过程和扩散场的扩展,请参见[9],[10]。

总结

虽然这是一个简单的理论,似乎消除了创建先验概率的需要,但应用该规则所需的特定条件列表并不总是容易满足,比如:最大似然估计量必须在整个模型中保持一致。该模型需要有限且固定数量的参数。无限维(非参数)参数,如未知函数,将不起作用。

先验密度也必须非零。数据库中的所有样本必须是唯一的和独立的,没有任何选择偏差,每个样本都由相同的实验设计收集。一般来说,数据库越大,这就越难实现,因为大多数“大数据”库都是在不同时间以不同的选择标准收集的较小数据库的集合。

Bernstein–von Mises定理的最重要含义是,从常见的角度来看,贝叶斯推论在渐近上是正确的。这意味着,对于大量数据,可以从经常观察的角度使用后验分布来制作有关估计和不确定性的有效陈述。

参考文献

-

[1] I.V. Basawa, B.L.S. Prakasa Rao, “Statistical inference for stochastic processes” , Acad. Press (1980)

-

[2] S.N. Bernstein, “Theory of probability” (1917) (In Russian)

-

[3] J.D. Borwanker, G. Kallianpur, B.L.S. Prakasa Rao, “The Bernstein-von Mises theorem for Markov processes” Ann. Math. Stat. , 43 (1971) pp. 1241-1253

-

[4] C. Hipp, R. Michael, “On the Bernstein-von Mises approximation of posterior distribution” Ann. Stat. , 4 (1976) pp. 972-980

-

[5] L. Le Cam, “On some asymptotic properties of maximum likelihood estimates and related Bayes estimates” Univ. California Publ. Stat. , 1(1953) pp. 277-330

-

[6] B.L.S. Prakasa Rao, “Statistical inference for stochastic processes” G. Sankaranarayanan (ed.), Proc. Advanced Symp. on Probability and its Applications, Annamalai Univ. (1976) pp. 43-150

-

[7] B.L.S. Prakasa Rao, “Rate of convergence of Bernstein-von Mises approximation for Markov processes” Serdica , 4 (1978) pp. 36-42

-

[8] B.L.S. Prakasa Rao, “The equivalence between (modified) Bayes estimator and maximum likelihood estimator for Markov processes” Ann. Inst. Statist. Math. , 31 (1979) pp. 499-513

-

[9] B.L.S. Prakasa Rao, “The Bernstein-von Mises theorem for a class of diffusion processes” Teor. Sluch. Prots. , 9 (1981) pp. 95104 (In Russian)

-

[10] B.L.S. Prakasa Rao, “On Bayes estimation for diffusion fields” J.K. Ghosh (ed.) J. Roy (ed.), Statistics: Applications and New Directions, Statistical Publishing Soc. (1984) pp. 504-511

-

[11] B.L.S. Prakasa Rao, “Asymptotic theory of statistical inference”, Wiley (1987)

-

[12] R. von Mises, “Wahrscheinlichkeitsrechnung” , Springer (1931)

-

[13] Van der Vaart, A. W. (2000). Asymptotic statistics.

-

[14] Ghosal, S., & Van der Vaart, A. (2017). Fundamentals of nonparametric Bayesian inference

-

https://zhuanlan.zhihu.com/p/367832769

-

https://developer.aliyun.com/article/715524

-

https://new.qq.com/rain/a/20210904A0421Y00