1. H.264/AVC框架流程图

1.1 H.264/AVC框架图

H.264的功能分两层

VCL (VideoCoding Layer,视频编码层):负责高效的视频内容表示,其中包括了:

帧间和帧内预测(Estimation)、

变换(Transform)和反变换、

量化(Quantization)和反量化、

环路滤波(Loop Filter)、

熵编码(Entropy Coding)。

NAL(NetworkAbstraction Layer,网络提取层):负责以网络所要求的恰当的方式对数据进行打包和传送。

网络封装格式

RTP: RTP 12字节头 + NALU,一般UDP传输

RTMP: RTMP头 + NALU,一般TCP传输 。RTMP客户端向服务器传输,RTMP就是直播形式。

RTSP:RTSP头 + NALU, 一般UDP传输 。RTSP同时走控制指令和视频图像。

1.2 H.264/AVC流程图

上述为H.264AVC的编码流程图,H264 编码器采用的是变换和预测的混合编码法。由上图所示,输入的帧或场 Fn 以宏块为单位被编码器处理。

首先,按帧内或帧间预测编码的方法进行处理。如果采用帧间预测编码,其预测值 PRED(图中用 P 表示)是由当前片中前面已编码的参考图像经运动补偿( MC)后得出,其中参考图像用 F’n-1 表示。为了提高预测精度,从而提高压缩比,实际的参考图像可在过去或未来(指显示次序上)已编码解码重建和滤波的帧中进行选择。而帧内预测的过程与JPEG很相似。一幅图像被划分好宏块后,对每个宏块可以进行 9 种模式的预测。找出与原图最接近的一种预测模式。

然后,将原始图像与帧内预测后的图像相减得残差值。预测值 PRED 和当前块相减后,产生一个残差块 Dn,经块变换、量化后产生一组量化后的变换系数 X,再经熵编码,与解码所需的一些边信息(如预测模式量化参数、运动矢量等)一起组成一个压缩后的码流,经 NAL(网络自适应层)供传输和存储用。

这便是H264的编码器,接下来了解一下解码器

由上图可知,由编码器的NAL输出一个压缩后的H.264压缩比特流。经熵解码得到量化后的一组变换系数X,再经反量化、反变换,得到残差Dn’。利用从该比特流中解码出的头信息,解码器就产生一个预测值PRED,它和编码器中的原始PRED是相同的。当该解码器产生的PRED与残差Dn‘相加后,就产生uFu’,再经滤波后,最后就得到滤波后的Fn‘,这个Fn’就是最好的解码输出图像。

由上图可知,由编码器的NAL输出一个压缩后的H.264压缩比特流。经熵解码得到量化后的一组变换系数X,再经反量化、反变换,得到残差Dn’。利用从该比特流中解码出的头信息,解码器就产生一个预测值PRED,它和编码器中的原始PRED是相同的。当该解码器产生的PRED与残差Dn‘相加后,就产生uFu’,再经滤波后,最后就得到滤波后的Fn‘,这个Fn’就是最好的解码输出图像。

2. H264编码原理

下面我们就简单的描述一下 H264 压缩编码数据的过程。通过摄像头采集到的视频帧(按每秒 30 帧算),被送到 H264 编码器的缓冲区中。编码器先要为每一幅图片划分宏块。

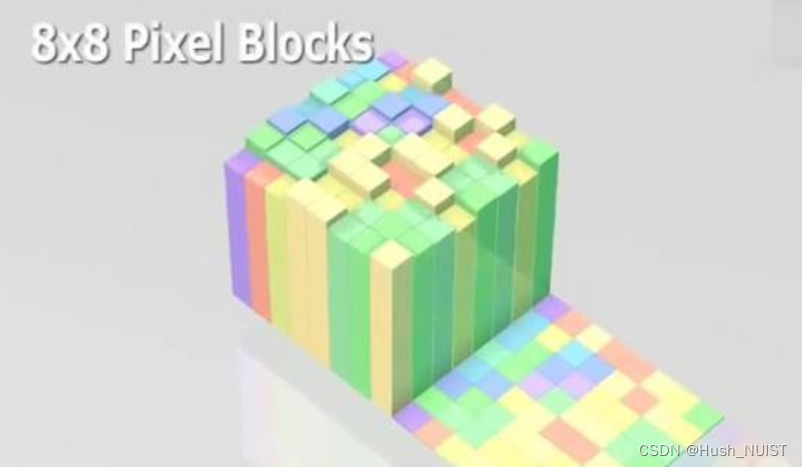

2.1 划分宏块

宏块是编码标准的基本处理单元,通常它的大小也为 16x16 像素。16X16 的宏块上可以划分出更小的子块。子块的大小可以是 8X16、 16X8、 8X8、 4X8、 8X4、 4X4

H264 默认是使用 16X16 大小的区域作为一个宏块,也可以划分成 8X8 大小的宏块。

划分好宏块后,计算宏块的象素值。

以此类推,计算一幅图像中每个宏块的像素值,所有宏块都处理完后如下面的样子。

2.2 划分子块

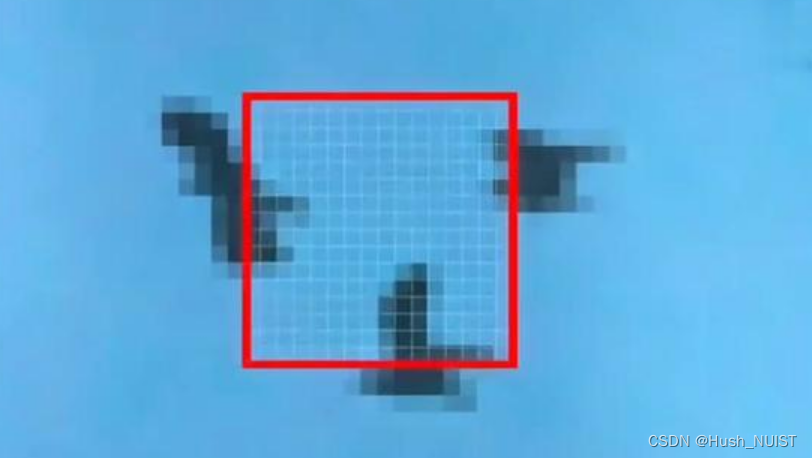

H264 对比较平坦的图像使用 16X16 大小的宏块。但为了更高的压缩率,还可以在 16X16 的宏块上更划分出更小的子块。

子块的大小可以是 8X16、 16X8、 8X8、 4X8、 8X4、 4X4,非常的灵活。

上幅图中,红框内的 16X16 宏块中大部分是蓝色背景,而三只鹰的部分图像被划在了该宏块内。为了更好的处理三只鹰的部分图像,H264就在 16X16 的宏块内又划分出了多个子块。

这样再经过帧内压缩,可以得到更高效的数据。

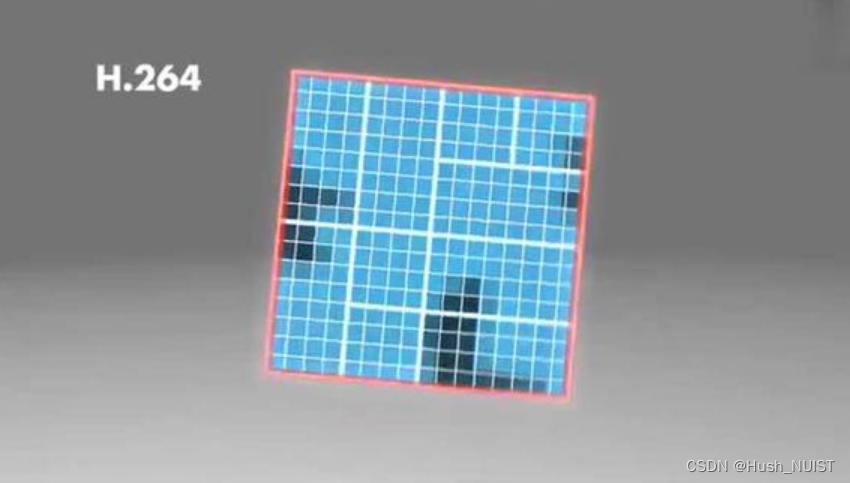

下图是分别使用 MPEG-2 和 H264 对上面宏块进行压缩后的结果。其中左半部分为 MPEG-2 子块划分后压缩的结果,右半部分为 H264 的子块划压缩后的结果,可以看出 H264 的划分方法更具优势:

每张图片的宏块划分好后,就可以对 H264 编码器缓存中的所有图片进行分组了。

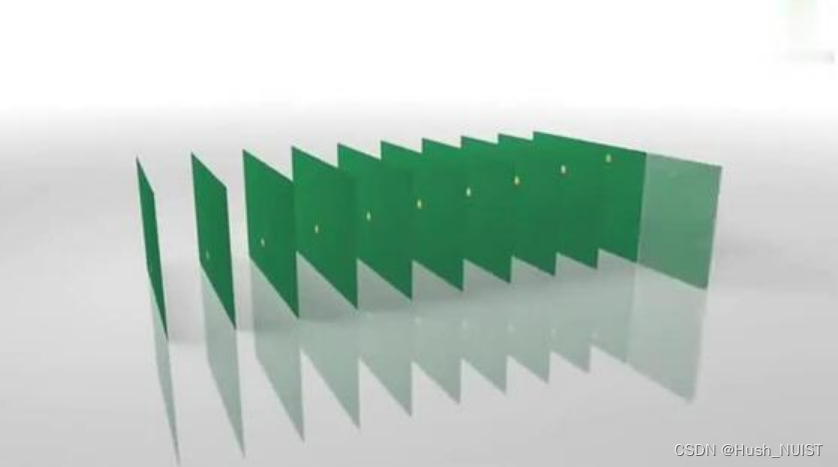

2.3 帧分组

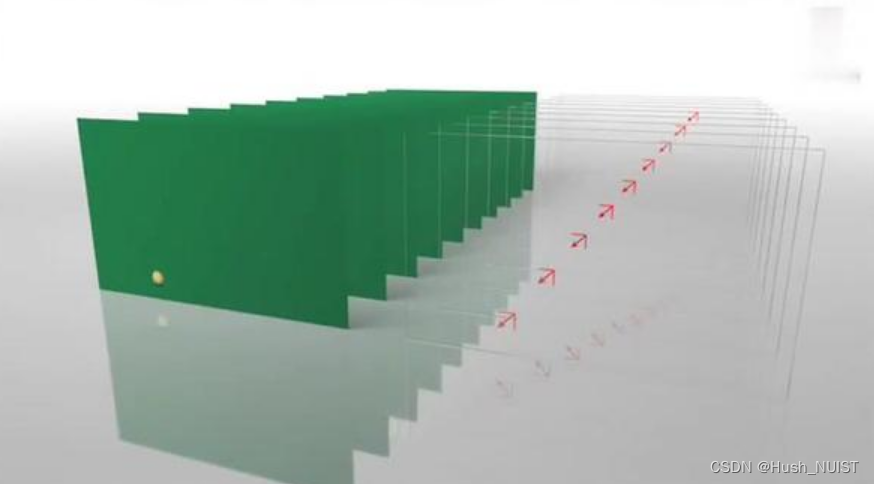

对于视频数据主要有两类数据冗余,一类是时间上的数据冗余,另一类是空间上的数据冗余。.其中时间上的数据冗余是最大的。下面我们就先来说说视频数据时间上的冗余问题。

为什么说时间上的冗余是最大的呢?假设摄像头每秒抓取30帧,这30帧的数据大部分情况下都是相关联的。也有可能不止30帧的的数据,可能几十帧,上百帧的数据都是关联特别密切的。

对于这些关联特别密切的帧,其实我们只需要保存一帧的数据,其它帧都可以通过这一帧再按某种规则预测出来,所以说视频数据在时间上的冗余是最多的。

为了达到相关帧通过预测的方法来压缩数据,就需要将视频帧进行分组。那么如何判定某些帧关系密切,可以划为一组呢?

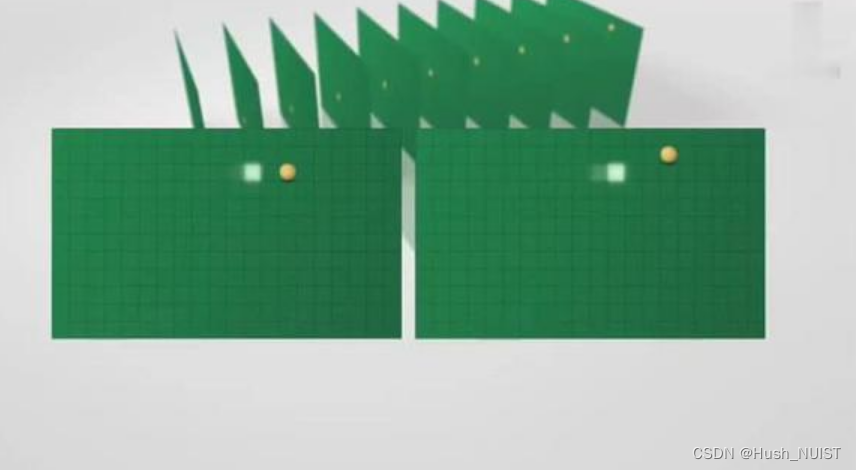

我们来看一下例子,下面是捕获的一组运动的台球的视频帧,台球从右上角滚到了左下角。

通过宏块扫描与宏块搜索可以发现这两个帧的关联度是非常高的。进而发现这一组帧的关联度都是非常高的。因此,上面这几帧就可以划分为一组,即 H264 中的 序列(GOP)。其算法是:在相邻几幅图像画面中,一般有差别的像素只有 10% 以内的点,亮度差值变化不超过 2%,而色度差值的变化只有 1% 以内,我们认为这样的图可以分到一组。

在这样一组帧中,经过编码后,我们只保留第一帖的完整数据,其它帧都通过参考上一帧计算出来。我们称第一帧为 IDR/I帧,其它帧我们称为 P/B帧,这样编码后的数据帧组我们称为 GOP。

所以如果场景一直没什么变化,则一系列视频帧中 I 帧的数量会很少。如果场景变换很复杂,一直在场景变换大的场景切换时就会有 I 帧出现。

2.4 帧间预测与运动补偿

在 H264 编码器中将帧分组后,就要计算帧组内物体的运动矢量了。还以上面运动的台球视频帧为例,我们来看一下它是如何计算运动矢量的。

H264 编码器首先按顺序从缓冲区头部取出两帧视频数据,然后进行宏块扫描。当发现其中一幅图片中有物体时,就在另一幅图的邻近位置(搜索窗口中)进行搜索。如果此时在另一幅图中找到该物体,那么就可以计算出物体的运动矢量了。

通过上图中台球位置相差,就可以计算出台图运行的方向和距离。H264 依次把每一帧中球移动的距离和方向都记录下来就成了下面的样子:

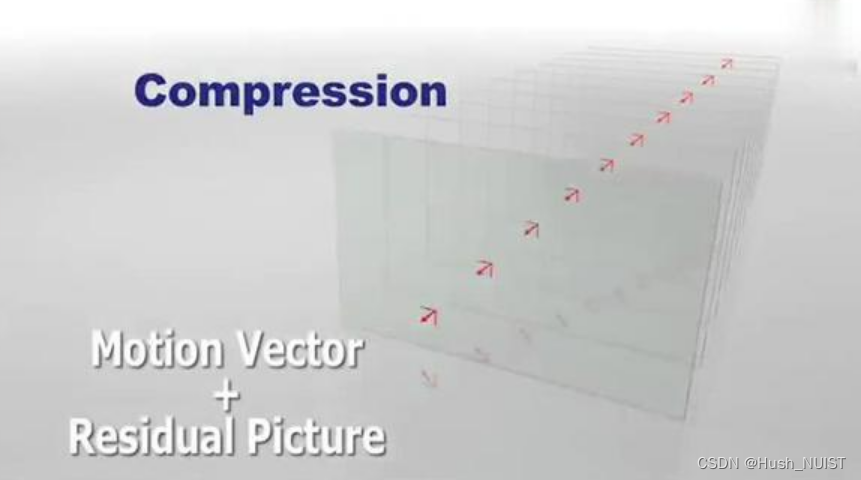

运动矢量计算出来后,将相同部分(也就是绿色部分)减去,就得到了补偿数据。我们最终只需要将补偿数据进行压缩保存,以后在解码时就可以恢复原图了。压缩补偿后的数据只需要记录很少的一点数据。如下所示:

我们把运动矢量与补偿称为帧间压缩技术,它解决的是视频帧在时间上的数据冗余。在这一步我们获取了 P/B 帧。

除了帧间压缩,帧内也要进行数据压缩,帧内数据压缩解决的是空间上的数据冗余。下面我们就来介绍一下帧内压缩技术。

2.5 帧内预测

人眼对图象都有一个识别度,对低频的亮度很敏感,对高频的亮度不太敏感。所以基于一些研究,可以将一幅图像中人眼不敏感的数据去除掉。这样就提出了帧内预测技术。

H264 的帧内压缩与 JPEG 很相似。一幅图像被划分好宏块后,对每个宏块可以进行 9 种模式的预测。找出与原图最接近的一种预测模式。

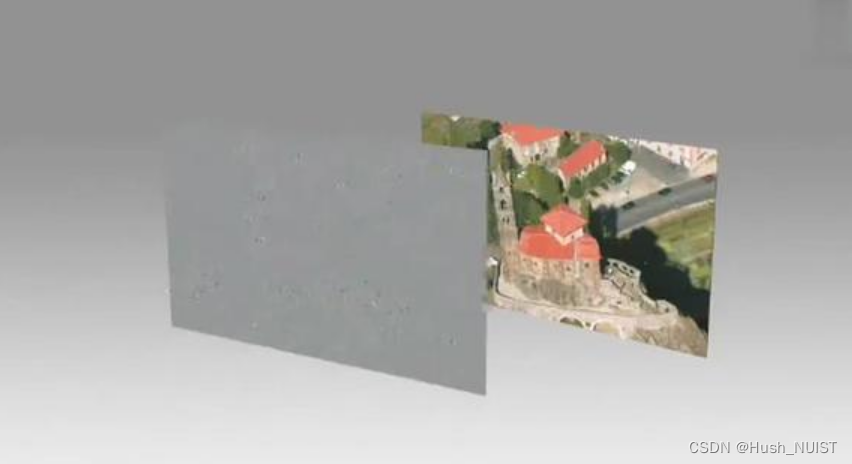

帧内预测后的图像与原始图像的对比如下:

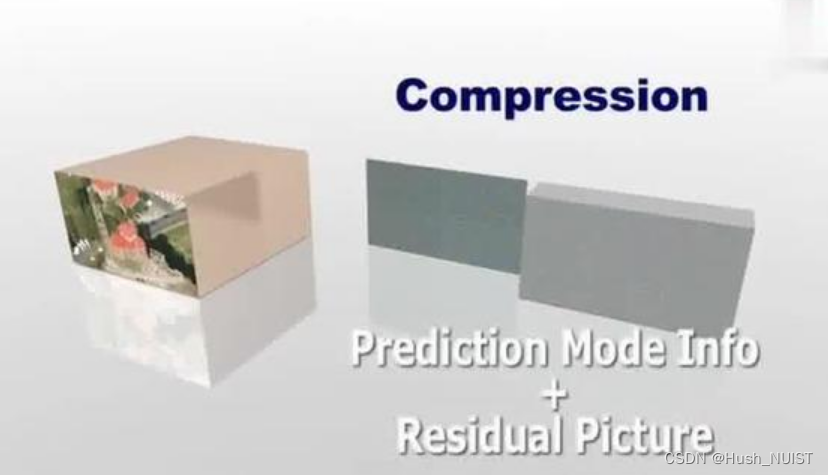

然后,将原始图像与帧内预测后的图像相减得残差值

再将我们之前得到的预测模式信息一起保存起来,这样我们就可以在解码时恢复原图了。效果如下:

经过帧内与帧间的压缩后,虽然数据有大幅减少,但还有优化的空间。这一步主要是压缩出 I 帧。

2.6 对残差数据做DCT转换

可以将残差数据做整数离散余弦变换,去掉数据的相关性,进一步压缩数据。

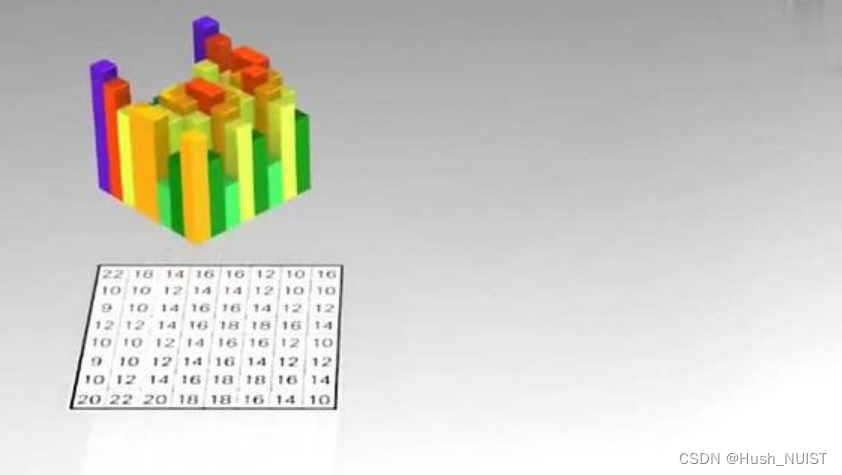

如下图所示,左侧为原数据的宏块,右侧为计算出的残差数据的宏块。

将残差数据宏块数字化后如下图所示:

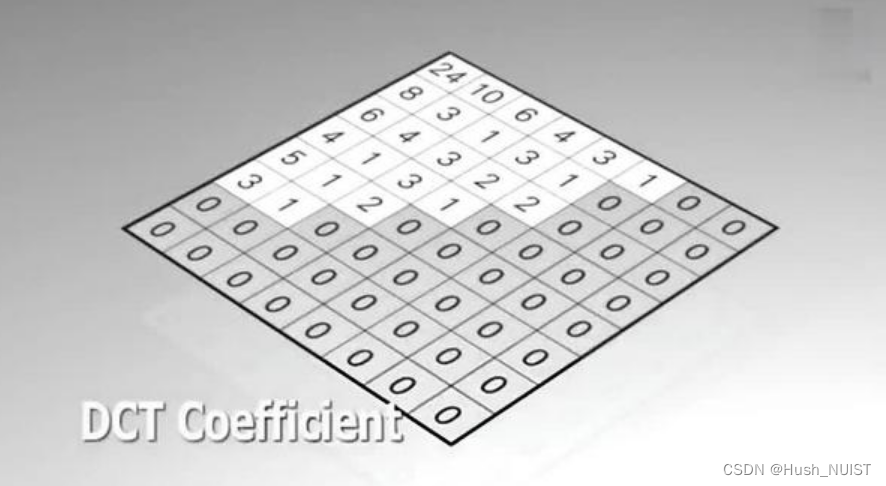

将残差数据宏块进行 DCT 转换。

去掉相关联的数据后,我们可以看出数据被进一步压缩了。做完 DCT 后,还不够,还要进行 CABAC 进行无损压缩。

2.7 CABAC 压缩

上面的帧内压缩是属于有损压缩技术。也就是说图像被压缩后,无法完全复原。而 CABAC 属于无损压缩技术。

无损压缩技术大家最熟悉的可能就是哈夫曼编码了,给高频的词一个短码,给低频词一个长码从而达到数据压缩的目的。

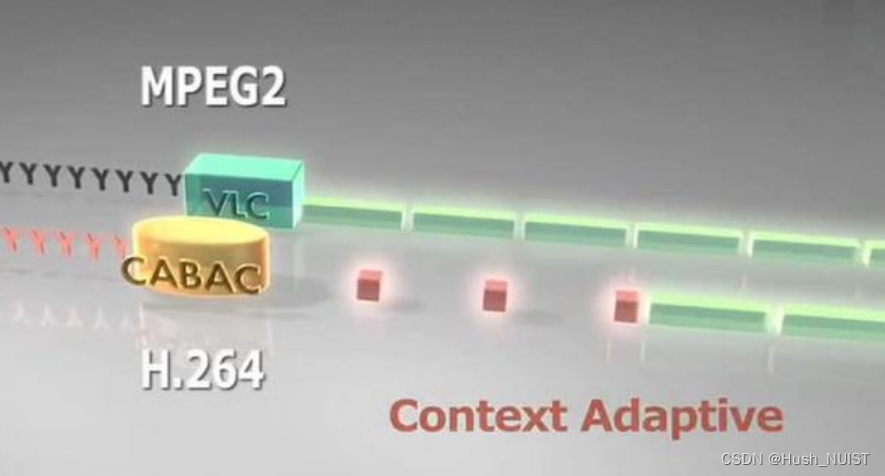

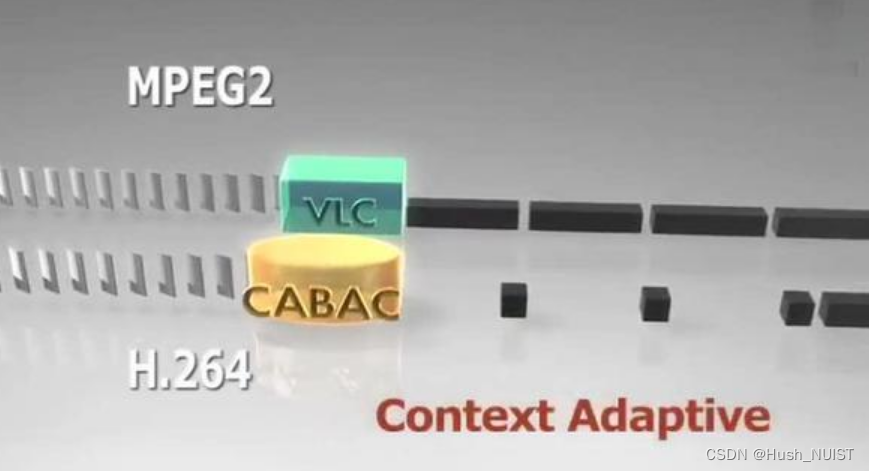

MPEG-2 中使用的 VLC 就是这种算法,我们以 A-Z 作为例子,A 属于高频数据,Z 属于低频数据。看看它是如何做的:

CABAC 也是给高频数据短码,给低频数据长码。同时还会根据上下文相关性进行压缩,这种方式又比 VLC 高效很多。其效果如下:

现在将 A-Z 换成视频帧,它就成了下面的样子:

从上面这张图中明显可以看出采用 CACBA 的无损压缩方案要比 VLC 高效的多。

AVC/H264的编码原理结束,接下来继续完善HEVC和VVC的编码过程原理。