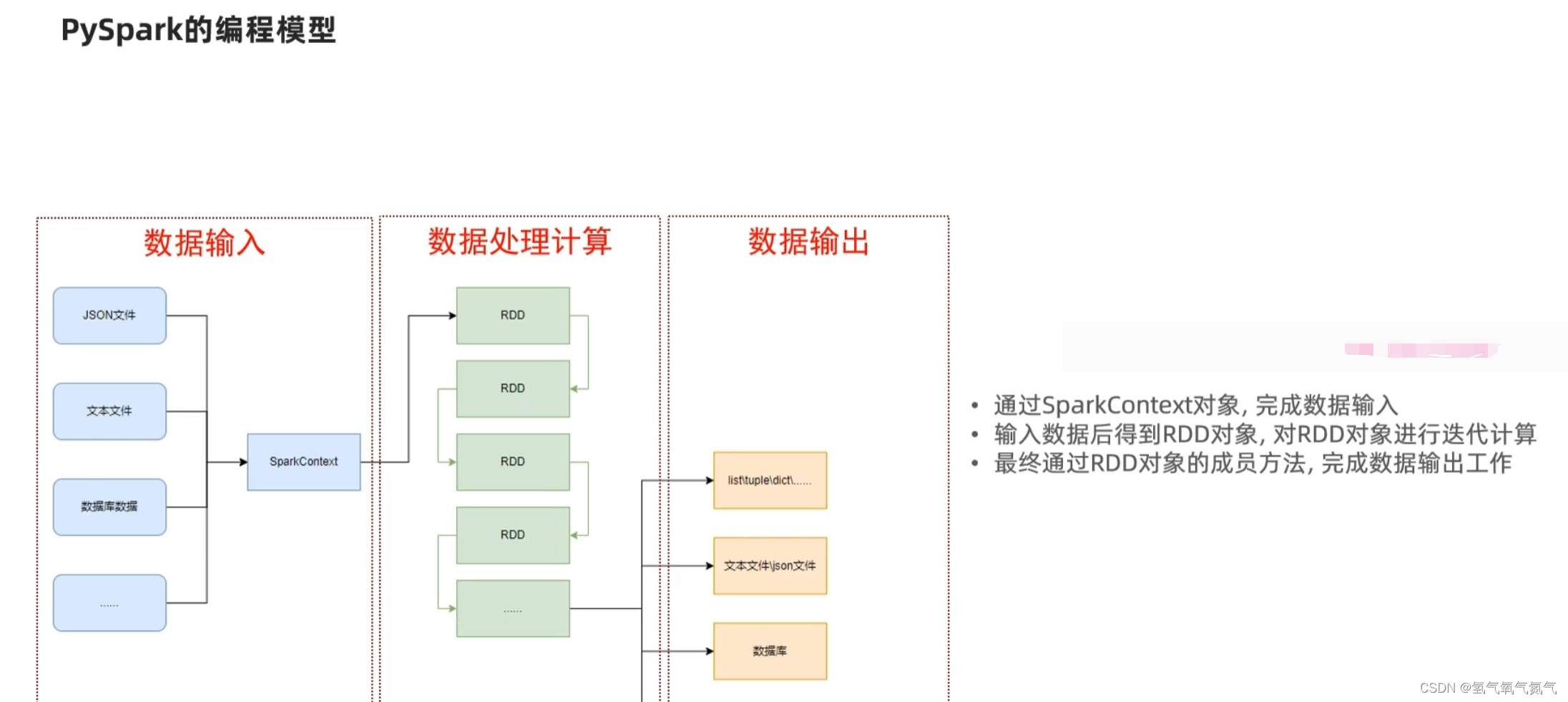

python语法-pyspark实战(基础知识)

演示获取pyspark的执行环境入库对象:SparkContext

"""

演示获取pyspark的执行环境入库对象:SparkContext

并通过SparkContext对象获取当前的pyspark的版本

"""

# 导包

from pyspark import SparkConf, SparkContext

# 创建sparkconf类对象

# conf = SparkConf()

# conf.setMaster("local[*]")

# conf.setAppName("test_name")

conf = SparkConf().setMaster("local[*]").setAppName("test_spark_app")

# 基于sparkconf类对象创建sparkcontext对象

sc = SparkContext(conf=conf)

# 打印pyspark版本

print(sc.version)

# 停止sparkcontext对象的运行(停止pyspark程序)

sc.stop()

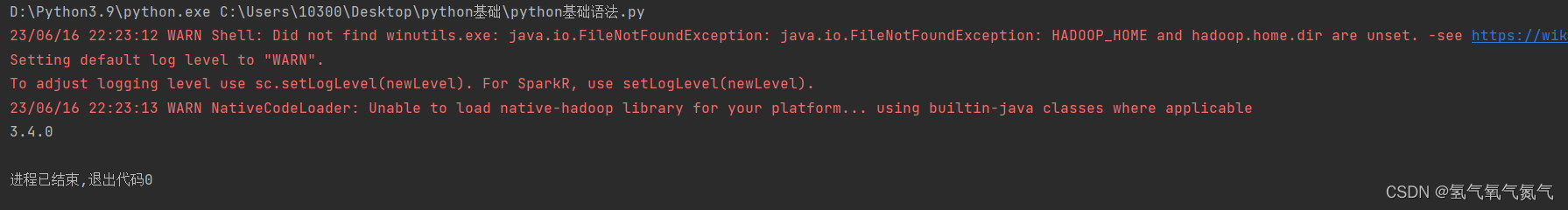

第一次执行遇到的问题:搭建PySpark执行环境入口时出现RuntimeError: Java gateway process exited before sending its port number

原因:未安装java的jdk程序

解决方法:去官网下载jdk,安装配置好重启pycharm,解决后程序结果如下

参考内容:

Python搭建PySpark执行环境入口时出现RuntimeError: Java gateway process exited before sending its port number解决办法

黑马程序员-python基础