数据计算-Map方法

"""

演示RDD的map成员方法的使用

"""

from pyspark import SparkConf, SparkContext

import os

os.environ['PYSPARK_PYTHON'] = 'D:\Python3.9\python.exe' # 通过os设置环境变量

conf = SparkConf().setMaster("local[*]").setAppName("test_spark")

sc = SparkContext(conf=conf)

# 准备一个RDD

rdd = sc.parallelize([1, 2, 3, 4, 5])

# 通过map方法将全部数据都乘以10

def func(data):

return data * 10

rdd2 = rdd.map(func) # 将rdd内每个数据都进行func函数的处理

print(rdd2.collect())

# 链式调用

rdd3 = rdd2.map(func)

print(rdd3.collect())

sc.stop()

数据计算-flatMap方法(对rdd执行map操作,然后进行解除嵌套操作)

"""

演示RDD的flatMap成员方法的使用

"""

from pyspark import SparkConf, SparkContext

import os

os.environ['PYSPARK_PYTHON'] = 'D:\Python3.9\python.exe' # 通过os设置环境变量

conf = SparkConf().setMaster("local[*]").setAppName("test_spark")

sc = SparkContext(conf=conf)

# 准备一个RDD

rdd = sc.parallelize(["itheima itcast 666", "itheima itheima itcast", "python itheima"])

# 需求,将RDD数据里面的一个个单词提取出来

rdd2 = rdd.flatMap(lambda x: x.split(" "))

print(rdd2.collect())

"""

演示reduceByKey算子的使用

功能:针对KV型RDD,自动按照key分组,然后根据你提供的聚合逻辑,完成组内数据(value)的聚合操作

方法内的func接收2个传入参数(类型一致),返回一个返回值,和传入类型一致

"""

from pyspark import SparkConf, SparkContext

import os

os.environ['PYSPARK_PYTHON'] = 'D:\Python3.9\python.exe' # 通过os设置环境变量

conf = SparkConf().setMaster("local[*]").setAppName("test_spark")

sc = SparkContext(conf=conf)

rdd = sc.parallelize([('a', 1), ('a', 1), ('b', 1), ('b', 1)])

result = rdd.reduceByKey(lambda a, b: a + b)

print(result.collect())

# 结果:[('a', 2), ('b', 2)]

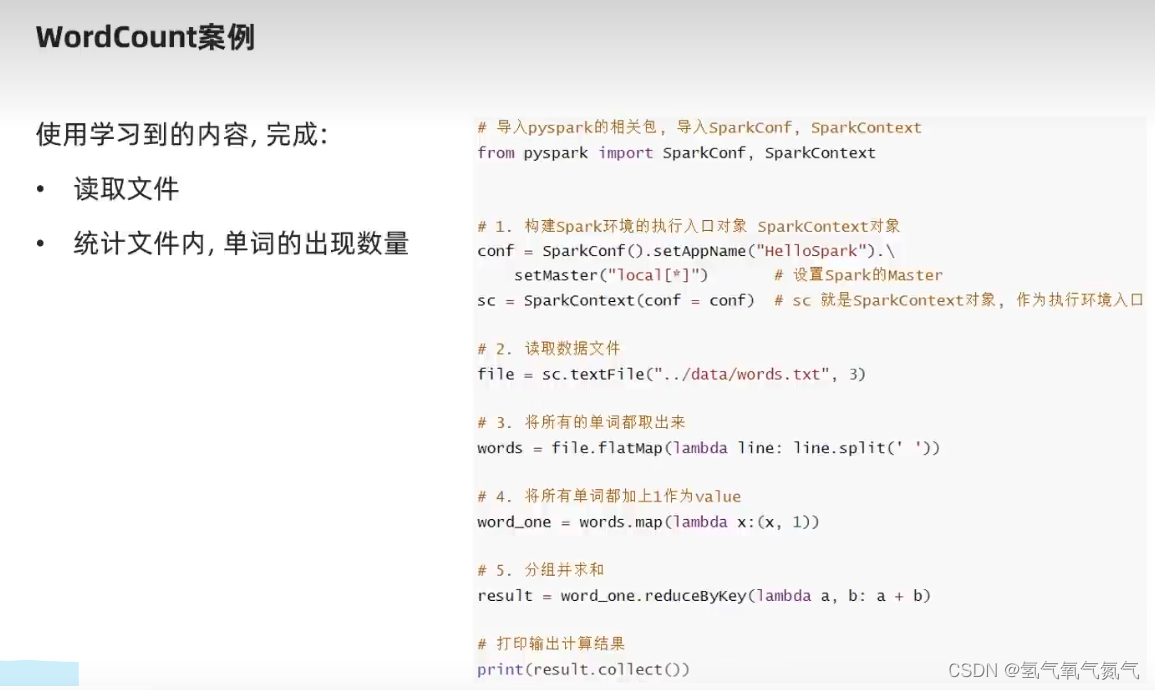

word_count案例