【通览一百个大模型】LaMDA(Google)

作者:王嘉宁,本文章内容为原创,仓库链接:https://github.com/wjn1996/LLMs-NLP-Algo

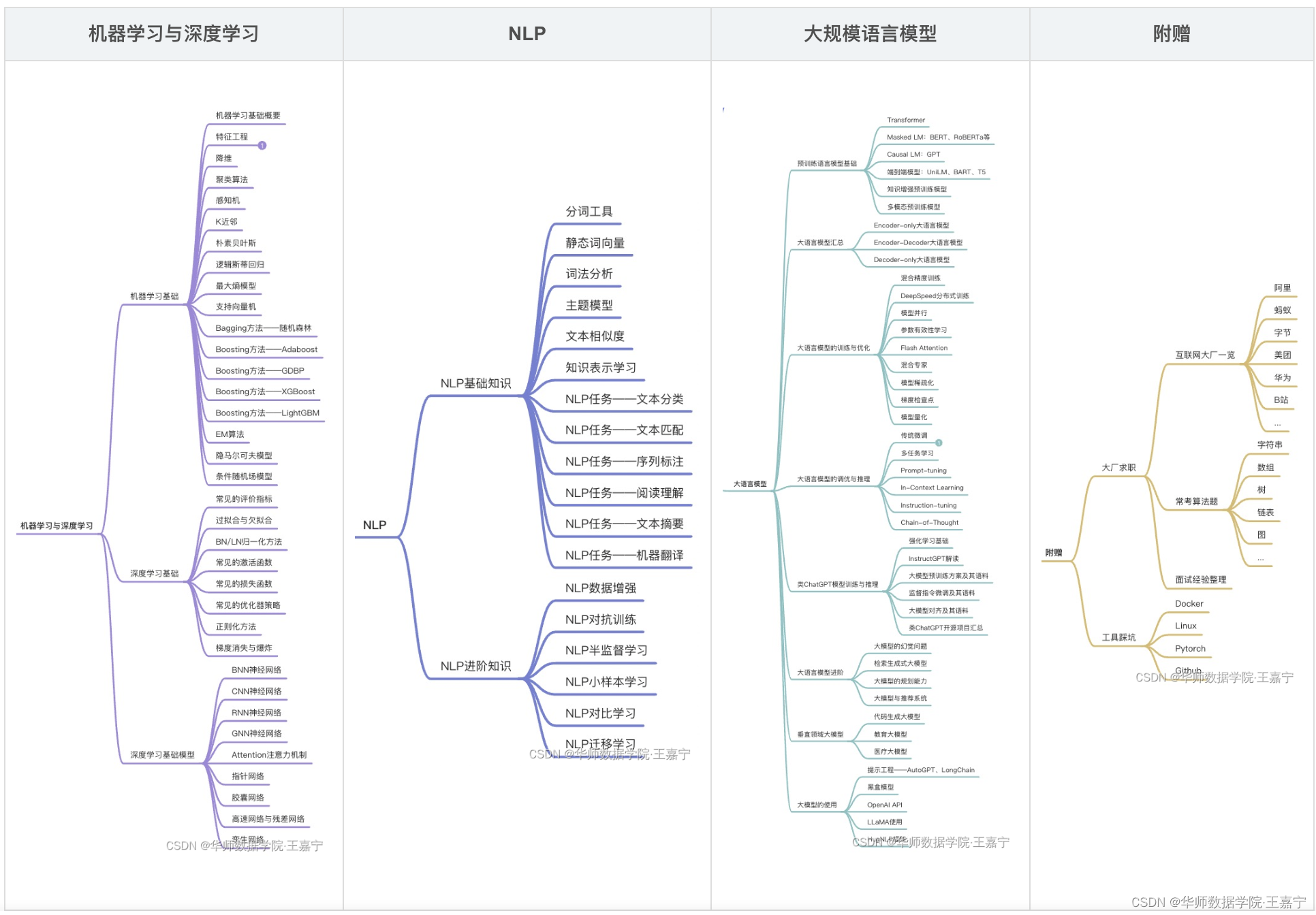

订阅专栏【大模型&NLP&算法】可获得博主多年积累的全部NLP、大模型和算法干货资料大礼包,近200篇论文,300份博主亲自撰写的markdown笔记,近100个大模型资料卡,助力NLP科研、学习和求职。

LaMDA大模型基本信息资料卡

| 序号 | 大模型名称 | 归属 | 推出时间 | 规模 | 预训练语料 | 评测基准 | 模型与训练方法 | 开源 | 论文 | 模型地址 | 相关资料 |

|---|---|---|---|---|---|---|---|---|---|---|---|

| 20 | LaMDA | 2022-02 | 137B | 预训练的数据包含2.97B documents,1.12B dialogs以及13.39B dialog utterances。 | 从三个方面进行评测: (1)Quality(Sensibleness, Specificity, Interestingness,SSI):Mini-Turing Benchmark (MTB) 数据集; (2)Safety:自己构建了8k对话数据; (3)Groundedness:自己构建了4k对话数据 |

选择Decoder-only Transformer,训练过程包括两个环节: (1)Pre-training,在2.97B文本上进行Causal LM预训练,多轮对话场景; (2)Fine-tuning,在Quality、Safety和Groundedness三个数据集/场景上训练,旨在提高模型在对话过程中的Sensibleness, Specificity, Interestingness、Safety和Groundedness性能。 (3)针对语言模型的可能生成看起来可信,但是违背事实的幻觉问题,LaMDA通过学习使用利用外部知识源去缓解这个问题。LaMDA构建一个包含信息检索系统,计算模块,翻译模块的工具(简称TS),这部分的finetune也包括两个子任务,第一个是将历史上文跟模型回复一起输入到模型中,生成对应的检索query。第二个子任务是将历史上文+模型回复+检索结果一同输入到模型中,让模型决定是生成新的检索query或者生成最终回复(根据生成的第一个字符串决定,如果是TS,则继续检索,如果是User则返回对应结果) |

未开源 | 论文 | 未开源 | LAMDA介绍,LAMDA论文阅读,LAMDA解读 |

订阅专栏【大模型&NLP&算法】可获得近100个大模型的资料卡~

LaMDA介绍

LaMDA是在DeepMind的Sparrow跟openai的instructGPT之前由谷歌提出的对话机器人,全称Language Models for Dialog Applications,是一个在海量对话跟web数据上进行预训练再在人工标注数据上做进一步微调后得到的参数量高达137B的大模型。LaMDA除了在生成文本质量有所提升外,通过在人工标注数据上做进一步finetune以及让模型学会检索利用外部知识源的能力,使得模型在安全性以及事实性这两个关键问题上获得明显提升。

- 安全性指的是模型的回复应该满足一系列人为价值观,例如没有歧视跟偏见,不会生成伤害性建议。

- 事实性指的模型的回复应该符合事实,跟外部知识源保持一致,而不是一本正经的胡说八道。

LaMDA模型Pre-training

we pre-trained LaMDA on a dataset created from public dialog data and other public web documents.

预训练的数据包含2.97B documents,1.12B dialogs以及13.39B dialog utterances。

模型:Decoder-only Transformer。共有64层Transformers,隐状态向量维度为8192,head数为128.

预测生成时,选择top-40结果采样得到16个候选回复,再基于候选回复的对数似然得分跟长度选择最优的回复

模型大小:

- 137B

- 8B

- 2B

LaMDA Fine-tuning

**LaMDA的finetune包括两部分,一部分是针对生成文本质量跟安全性,另一部分则是学习如何利用外部的信息检索系统。**其中质量(SS I)可以从三方面评估,分别是:

- sensibleness(文本是否合理,跟历史对话是否有冲突);

- Specificity(对于前文是否有针对性,避免笼统回复,例如用户提问“I love Eurovision”,模型生成一个笼统回复“Me too”就不符合预期);

- Interestingness(文本是否能引起某人注意或者好奇,是否是超出期待的巧妙回复)。而安全性(Safety)的目标则是要符合谷歌AI的基本原则,避免生成会造成伤害的不符合预期的结果,或者带有偏见跟歧视。

Finetuning to learn to call an external information retrieval system

这部分也称为Groundedness,针对语言模型的可能生成看起来可信,但是违背事实的幻觉问题,**LaMDA通过学习使用利用外部知识源去缓解这个问题。**LaMDA构建一个包含信息检索系统,计算模块,翻译模块的工具(简称TS),这部分的finetune也包括两个子任务,第一个是将历史上文跟模型回复一起输入到模型中,生成对应的检索query。第二个子任务是将历史上文+模型回复+检索结果一同输入到模型中,让模型决定是生成新的检索query或者生成最终回复(根据生成的第一个字符串决定,如果是TS,则继续检索,如果是User则返回对应结果)

博客记录着学习的脚步,分享着最新的技术,非常感谢您的阅读,本博客将不断进行更新,希望能够给您在技术上带来帮助。

【大模型&NLP&算法】专栏

近200篇论文,300份博主亲自撰写的markdown笔记。订阅本专栏【大模型&NLP&算法】专栏,或前往https://github.com/wjn1996/LLMs-NLP-Algo即可获得全部如下资料:

- 机器学习&深度学习基础与进阶干货(笔记、PPT、代码)

- NLP基础与进阶干货(笔记、PPT、代码)

- 大模型全套体系——预训练语言模型基础、知识预训练、大模型一览、大模型训练与优化、大模型调优、类ChatGPT的复现与应用等;

- 大厂算法刷题;