单纯地使用GPU是否会使得计算机的性能更好?看看Jack Dongarra先生是怎么说的吧

在计算机科学领域,GPU(图形处理器)的应用已经成为加速各种计算任务的重要工具。尤其是在深度学习和大规模数据处理方面,GPU的强大并行计算能力使其成为机器学习和人工智能的关键驱动力。然而,单纯地依赖GPU计算机性能是否可以获得更好结果?我们一起来看看Jack Dongarra先生是怎么说的吧。

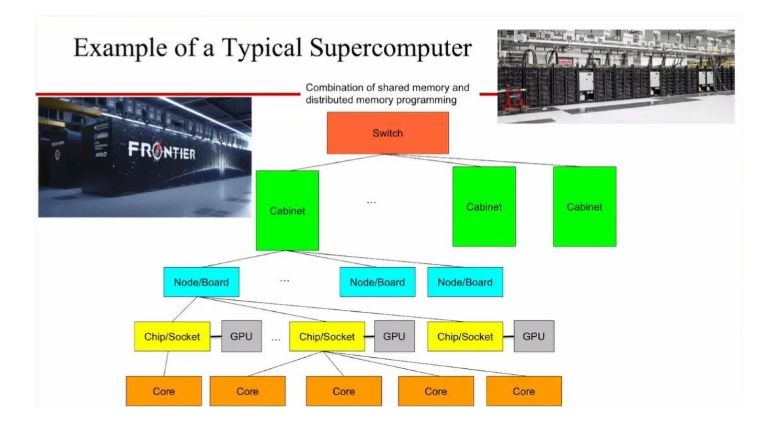

当前,高性能计算机中的CPU(中央处理器)和GPU(图形处理器)通常以松散耦合的方式一起工作,其中数据需要从CPU传输到GPU进行计算。然而,随着技术的不断发展,未来将继续出现将不同类型的硬件紧密耦合在一起的趋势。这种变化包括使用专门的硬件来进行机器学习(ML)计算,可以视为对GPU功能的进一步增强。通过将与ML相关的算法加载到相应的加速器上,在加速器上执行算法的详细计算,并将计算结果传输给对应的处理器。

这种硬件之间更紧密耦合的趋势是针对特定任务或领域的需求而出现的。例如,针对机器学习任务,我们可以引入专门的加速器,如Tensor Processing Unit(TPU),它具有高度优化的硬件设计,可显著提升机器学习工作负载的执行效率。TPU的设计重点放在了深度神经网络的计算需求上,它能够高效地执行矩阵计算和张量操作,为机器学习任务提供了出色的性能。

除了机器学习加速器外,未来还可以实现可插拔的量子加速器,以执行对应的量子算法。如今,量子计算是一个快速发展的领域,其独特的计算原理和潜在的巨大计算能力使得量子加速器成为可能。通过将专门设计的量子加速器与传统计算机系统相结合,可以实现更高效、更强大的量子计算能力,推动解决复杂问题的进展。

这种硬件耦合的发展趋势为不同类型的计算任务提供了更多的选择和优化机会。通过针对特定任务或领域的需求设计专用硬件,我们可以提高计算效率、加速任务执行,并开辟新的计算能力领域。此外,通过将不同类型的硬件紧密耦合,还可以实现更高级别的协同工作和数据流动,促进跨硬件平台的互操作性和优化。

然而,随着硬件耦合变得更加紧密,也面临一些挑战。其中之一是如何有效地管理和调度不同类型硬件间的数据传输和计算任务分配,以最大程度地利用各种硬件资源。此外,为了实现硬件之间的紧密耦合,需要进行深入的软硬件协同设计,以确保硬件之间的相互兼容性和有效的通信。

总结而言,未来将继续看到不同类型硬件之间更紧密耦合的趋势。这种发展将包括专用的机器学习加速器、可插拔的量子加速器等。通过将特定任务的计算需求与相应的硬件优化相结合,可以提供更高效、更强大的计算能力,推动科学研究、工程设计和创新领域的进一步发展。然而,实现这种硬件耦合也需要解决管理、调度和软硬件协同设计等挑战。随着技术的进步和创新的推动,我们可以期待在多样化的硬件环境中获得更多的计算优势。