0 引言

略。

1 基于 DCNN 的视觉目标检测

略。

2 基于 DCNN 的小型无人机视觉检测研究

2.1 无人机目标检测数据集

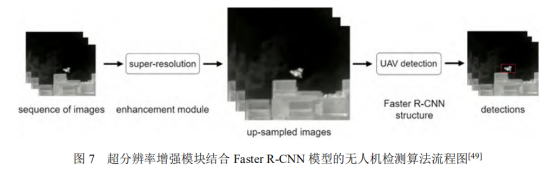

基于 DCNN 的目标检测算法通常需要依靠较大规模的数据集进行模型训练和性能评估。然而,当前业内仍然缺乏公开的大型无人机检测数据集。现有的无人机检测国际挑战赛数据集和公开发表文献中的自建数据集介绍如下。

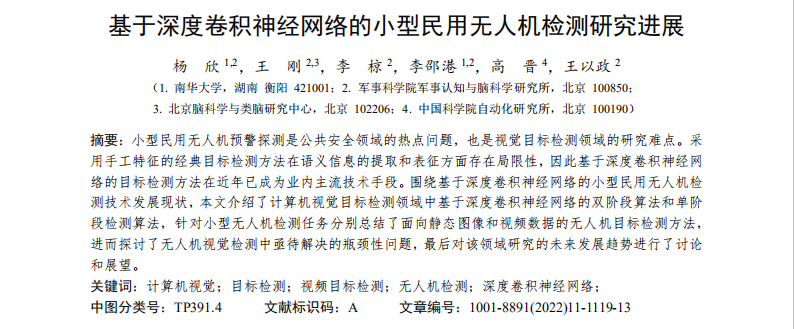

2.1.1 Anti-UAV2020 数据集

Anti-UAV2020[44]数据集包含 160 段较高质量的双模态(可见光+近红外)视频序列,其中 100 段视频用于训练和验证,60 段视频用于测试。该数据集涵盖了多种场景、多种尺度和多种机型(包括 DJIInspire、DJI-Phantom 4、DJI-Mavic Air、DJI-Mavic PRO)的商用无人机。该数据集中的示例图片如图 3所示。可见光与近红外视频数据分别由固定于地面的可见光和红外光电传感器采集获得。已公开的标注数据真值由专业数据标注员给出,其中标注信息包括:检测框位置和大小、目标属性(大、中、小型目标,白天、夜晚、云雾、楼宇、虚假目标、速度骤变、悬停、遮挡、尺度变化)以及表示当前帧是否存在目标的标志位。在第二届 Anti-UAV2021[45]反无人机挑战大赛中,数据集已扩展到 280 段高清红外视频数据,涵盖多种复杂场景下无人机目标的快速运动,使无人机探测任务更具挑战性。

2.1.2 Drone-vs-Bird Detection Challenge 数据集

Drone-vs-Bird Detection Challenge[46]数据集包含11 个在不同时间拍摄的 MPEG4 格式视频,每个视频文件对应有 XML 格式的标注文件。如图 4 所示,场景中的无人机呈现出多尺度、多视角和亮度异质性。特别地,数据集中包含大量远距离的小尺寸无人机和飞鸟,很多无人机的面积小于 20 像素,有 300 多个无人机的目标标注检测框边长甚至低至 3~4 个像素,对这些微小目标的检测非常具有挑战性。

2.1.3 未开源自建数据集

除了上述公开数据集外,许多研究人员通过自建数据集来训练网络,并在其公开发表的论文中进行了相应的介绍。

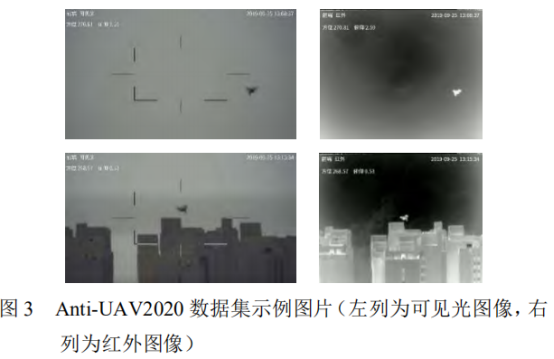

文献[47]建立的 Anti-Drone Dataset 包含 449 个视频,所拍摄的无人机机型包括 Mavic pro,Phantom 2和 Phantom 等,视频帧分辨率为 2048×1536 和1024×768,帧速率为 24 FPS。如图 5 所示,该数据集中的视频画面涵盖了不同的相机角度、放大倍率、天气、白天或黑夜等情况,反映出无人机目标检测任务的复杂性。

UAV data[48]采集了 20 款无人机的图像,其中包括 15 种旋翼无人机、3 种固定翼无人机和 2 种无人直升机。该数据集还特别突出了背景的复杂性和多样性,如图 6 所示,画面中的无人机背景包括居民建筑、商业中心、山地、林木、河流、工厂、海岸等 30 个不同的地点,较好地反映了无人机探测系统在实际部署时可能会遇到的多种场景。该数据集包含 200000 张图像,其中包括 140000 张训练集图像和 60000 张测试集图像以及每张图像对应的标注真值,图像分辨率为 1920×1080。

2.2 面向静态图像的无人机检测

围绕无人机探测预警任务,业内学者基于主流目标检测的算法开发了相当数量的无人机目标检测算法。这些算法主要解决的问题包括:基于通用目标检测算法的多尺度无人机目标检测、少样本无人机目标检测和红外图像无人机目标检测等。

2.2.1 基于通用目标检测算法的无人机目标检测

无人机目标检测算法按照是否显式生成候选区域,同样可大致分为双阶段和单阶段算法,两种类型的算法各具优势。在相同的数据集中,不采用任何优化法的情况下,双阶段的 Faster R-CNN 算法有较高的检测准确率,单阶段的 YOLO 系列算法处理速度较快。当前计算机视觉领域提出的面向静态图像的无人机目标检测算法介绍如下。

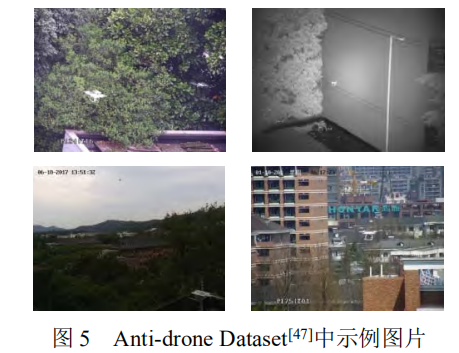

针对远距离无人机在成像视野中尺寸小的问题,Vasileios[49]通过在Faster R-CNN训练中加入深度超分辨率模型提出了新型无人机目标检测算法。如图 7 所示,该算法中的超分辨率模型[50]采用深度残差网络来提取特征并重构图像,提升输入图像中无人机小目标的分辨率,进而提升基于 Faster R-CNN 目标检测模型的召回率。Celine Craye[51]等人将无人机的检测分为两个步骤,首先将视频图像的时空序列输入 U-Net[52]模型中来获取无人机候选区域,再使用 ResNet101 模型对其进行分类,该算法与双阶段算法 R-CNN 相似,能够提升对小目标无人机的检测效果。然而,采用基于 Faster R-CNN 等双阶段的检测方法在计算实时性方面存在一定局限性。

鉴于 YOLO 系列算法计算效率方面存在优势,文 献[53]开发了基于 YOLOv2 的无人机目标检测算法。然而,由于 YOLOv2 算法在工作时需要在图像上划分网格,而且每个网格最多只能预测单个目标,因此多个目标落入同一个网格时就会出现漏检。此外,传统深度卷积网络在所学特征对方向和尺度变化鲁棒性差,因此对于小物体和重叠物体检测效果不佳。

文献[54]基于 YOLOv3 的 Darknet53 骨干网络采用 Gabor 滤波器调制 DCNN 中的卷积核,借以增强特征对方向和尺度变化的鲁棒性,并在数据集上进行了验证,性能超过了基于尺度不变特征变换(Scaleinvariant feature transform, SIFT)特征和局部特征聚合描述符、词袋和费舍尔向量等分类模型相结合的方法。但是该算法尚未与 YOLOv3 等基于 DCNN 的目标检测方法进行对比,Gabor 滤波器调制 DCNN 算法的优势没有得到验证。

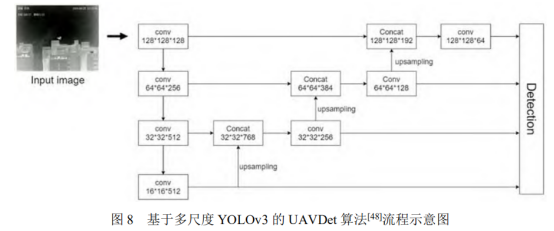

由于无人机目标在成像视场中的尺度变化较大,YOLOv3 中在 3 个尺度层面的检测难以有效覆盖无人机尺度变化范围。针对该问题,文献[55]在 YOLOv3模型中加入多尺度的特征融合,来检测尺度变化显著的无人机。文献[48]同样基于 YOLOv3 模型提出了针对无人机目标检测的 UAVDet 模型(如图 8 所示),将 YOLOv3 扩展为 4 个尺度进行预测,而且在第二个下采样后增加两个残差模块来获得更多定位信息。需要指出的是,由于单阶段算法没有显式生成候选框的过程,YOLO 系列算法需要事先使用 k-means[56]聚类算法根据数据集生成先验框,因此在使用 YOLO 系列算法进行目标检测时,同样需要使用 k-means 对特定

的无人机数据集聚类生成更适合无人机的先验框。同时,为了解决图像中存在的运动模糊问题,对数据集用高斯模糊和运动模糊的方法进行数据增强,有效提升检测准确度和召回率。

2.2.2 迁移学习和数据增广在无人机检测中的应用

如前文所述,基于 DCNN 目标检测算法通常是数据驱动的监督学习算法,需要依靠较大规模的数据集进行模型训练和性能评估,但是目前业内缺乏公开的大型无人机检测数据集,基于少样本数据集训练DCNN 模型容易造成过拟合问题,因此研究人员通过迁移学习和数据增广来缓解这个矛盾。

迁移学习是一种机器学习领域常用的技术,通常指将一个预训练的模型被重新用在另一个任务中的过程,能够将模型在一种数据集中学到的知识迁移应用在另一个数据集中,进而提高模型的泛化性能。具体在无人机检测任务上,可以首先在其他类型(如通用目标检测)的大规模数据集中对模型进行比较充分的训练,然后将预训练的网络在特定的相对较小规模

无人机检测数据集上进行微调。Muhamma 等人[57]将经过 ImageNet 数据集预训练过的模型在 Drone-vsBird Detection Challenge 数据集上进行微调,进而使模型能够更好地检测无人机。作者采用 Faster R-CNN算法,对比了 ZFNet,VGG16 和 VGG_CNN_1024 三种特征提取网络的检测性能,结果显示 VGG16 模型在该数据集取得相对更好的性能。在 2019 年的Dronevs-Bird Detection Challenge 挑战赛中,竞赛数据引入了更复杂的目标背景、更丰富的光照条件以及更多变的画面缩放,甚至还有很多低对比度画面和多种鸟类存在的场景。Nalamati 等人[58]采用了类似的迁移学习技术路线,并且对比了 Faster R-CNN 和 SSD 算法,其实验结果表明基于 ResNet101 网络的 Faster R-CNN 算法检测准确度较好,但是在实时性方面存在局限性。

数据增广是另外一种缓解模型训练过拟合问题的常用手段,通过变换现有数据或根据现有数据创建新的合成数据来增加样本数量。常用的数据增广方法有图像几何变换、翻转、颜色修改、裁剪、旋转、加噪声、随机遮挡、透明度混叠、裁剪混叠等。这些方法都可以引入到无人机目标检测中来缓解少样本的问题。例如,针对大规模无人机目标检测数据获取困难的问题,文献[59]将鸟和无人机的图像块拼接到不同的背景图片中,最终得到了 676534 张图片,进而可以更好地训练无人机目标检测模型。

2.2.3 红外图像无人机检测

可见光图像分辨率高,通常具有较好的纹理和形状信息,非常利于 DCNN 模型进行特征学习和表征,进而实现无人机检测。但是,在雾天或夜间等光照条件差的情况下,可见光传感器获得的图像数据能见度差,难以捕获无人机目标。相比之下,红外成像传感器具有探测距离远、全天候工作、光照条件适应性强等优势,但同时也存在分辨率小、对比度差、信噪比低、纹理形状信息缺乏等缺点,因此面向红外图像的无人机目标检测更具挑战性。文献[60]对红外图像进行倒置,直方图均衡,去噪和锐化预处理后,在YOLOv3 模型的基础上引入 SPP 模块和 GIOU(Generalized Intersection over Union)损失函数,改善了模型对近距离大目标和边缘目标的检测能力。文献[61]使用全卷积神经网络对红外图像进行分割,利用视觉显著性机制对小目标进行增强,抑制背景和虚警,检测结果优于典型的红外目标检测算法。文献[62]利用红外图像与可见光图像的互补特性进行多尺度显著特征融合,使用改进的 YOLOv3 模型进行检测,采用注意机制对辅助网络和骨干网络的特征信息融合,增强有效信息通道,抑制无效信息通道,提升小目标检测效果。

当红外图像中的无人机目标尺寸非常小时(例如小于 9×9 像素),需要将无人机目标看作红外小目标进行检测。基于手工特征的红外小目标检测典型方 法包括高斯差分滤波器、局部对比度算法[63]、二维最小均方滤波器[64]、形态学 Top-hat 变换[65-66]算法、非线性图像块处理[67]模型等。针对基于手工特征的方法 自适应能力有限的问题,近来有学者将 DCNN 引入红 外小目标检测领域。文献[68]将小目标检测问题转化 为小目标位置分布分类问题,利用全卷积网络对红外 小目标进行背景抑制和目标增强,同时获得目标潜在区域;然后将原始图像和目标潜在区域同时输入分类网络,进而输出目标检测结果。在50000张图片上的 训练和测试结果表明,该方法能够有效检测复杂背景 和低信噪比甚至存在运动模糊的小目标。但是,该方 法仍然存在虚警率较高的问题,这是因为在很多情况下,仅仅依赖静态外观特征难以区分真实小目标和背景中的非目标点状物体。因此,在复杂背景和低信噪

比情况下有效利用时空上下文信息进行红外小目标检测仍然是一项具有挑战性的任务[69]。

2.3面向视频数据的无人机检测

面向视频数据的无人机检测是无人机检测的核 心任务,一方面是因为基于光电传感器的无人机探测数据通常为视频数据(即图像序列),另一方面在单帧静态图像上无法辨识目标时需要借助视频数据中的上下文时空信息进行目标增强和检测识别。然而,基于视频数据实现无人机检测也存在若干难点。一是视频序列中的连续帧之间存在大量冗余信息;二是复 杂运动模态的背景会对目标检测造成极大干扰;三是无人机剧烈运动或者传感器镜头失焦会造成目标外观模糊。因此,面向视频数据的无人机检测需要联合静态外观信息和目标特异性运动信息(即空域和时域的上下文信息)进行判别。如前文所述,计算机视觉领域已经提出了相当数量的面向静态图像的目标检测方法,但是面向视频数据的目标检测特别是无人机 检测的研究还相对较少,已有的工作主要借助光流和时序特征来表征运动信息,进而更好地实现视频数据中的目标检测任务。

2.3.1 基于光流场的视频目标检测

视频运动目标检测是在视频的连续图像序列中将运动物体检测出来的过程,运动目标检测方法包括两帧/多帧差分法、背景抑制法和光流法等,其中光流 法对运动信息的表征最为有效。光流的概念通常是指空间中的运动物体在成像平台上像素运动的瞬时速度(包含速率和方向)。如果图像中没有运动目标时,整幅图像中的光流是连续变化的;如果存在运动目 标,那么运动目标形成的光流场与背景的光流场就会存在差异,进而可以将运动目标与背景进行区分。光流场的有效计算方法最初是由 Horn 和 Schunck[70]于1981 年提出,该方法假设物体的瞬时灰度值不变且在整个图像上平滑变化来求解光流。Lueas 和 Kanade[71]提出了改进光流算法,假设在一个小空间领域上运动矢量保持恒定,然后使用加权最小二乘法估计光流。

但是以上方法需要通过迭代的方式计算光流,通常计算量比较大。更重要的是,该类方法对图像连续帧亮度恒定的假设过于严格,因而在复杂光照条件下的光流计算准确度有限。2015 年 Fischer 将光流计算转化为监督学习问题,提出了基于深度学习的 FlowNet[72]方法。如图 9 所示,FlowNet 模型的输入为连续的两帧图像(支持 RGB 图像),网络分为卷积下采样和反卷积上采样两部分,其中下采样网络负责分层提取特征和编码高级语义信息,反卷积网络利用高级语义信息解码和分层提取的特征进行光流预测,借助大量数据的训练,显著提升了光流计算性能。后续的FlowNet2.0[73]模型和 RAFT[74]模型进一步提高了基于DCNN 的光流计算能力。

鉴于光流场在目标运动信息表征方面存在许多优良特性,可以预期将光流信息引入视频运动目标检测将显著提升视频目标检测的性能。一种思路是利用光流信息消除图像连续帧之间的冗余信息。例如,文献[75]发现 DCNN 模型提取的相邻帧图像的特征图通常非常相似,因此利用 DCNN 模型逐帧处理视频将消耗大量的非必要计算资源,因此可以在处理视频时按固定时间间隔仅选取和处理关键帧,而非关键帧的特征可以由关键帧的特征借助光流信息迁移获得。由于光流计算速度远高于 DCNN 特征提取速度,因此该方法大幅减少了视频处理的计算量,从而提升了视频目标检测速度。然而,该方法主要适用于运动物体和背景在相邻帧之间连续变化的情况。另一种利用光流信息进行视频运动目标检测的思路是将光流信息与静态外观信息进行叠加,从而进一步增加目标与背景之间的差异性。文献[76]采用 DCNN 模型获得当前帧和参考帧的外观特征图,同时采用 FlowNet 模型预测当前帧和参考帧的光流场,然后将对应帧的外观特征图与光流信息叠加为时空混合特征图,进而根据当前帧和参考帧的时空混合特征图获得目标检测结果。这种方法有效地利用了视频数据的时空信息,而且有助于解决运动目标模糊的问题,因此显著提升了目标检测性能。但是该方法对目标强度和局部信噪比有一定的要求,而且主要适用于离线视频目标检测,在实时在线目标检测方面还需要改进。借助无人机视频及其标注数据,这些基于光流场的目标检测模型可以有效迁移到无人机检测任务中。

2.3.2 基于多帧相关特征的无人机检测

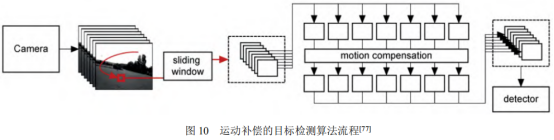

光流法通常在视频图像质量较高时能够有效表征目标运动信息,但在目标模糊或者极端弱隐的情况下容易失效。针对该问题,Rozantsev 等人[77]利用时序维度上的多个连续帧对目标能量进行累积进而达到目标增强的目的。如图 10 所示,首先用不同尺度的滑动窗口在图像序列中获取时空图像立方体(SpatioTemporal Image Cube);然后对每个 cube 进行运动补偿得到时空稳像立方体,这个操作能够极大地增强候选目标的能量,增强潜在目标的局部信噪比;最后再采用分类器判断该时空稳像立方体是否包含目标,并通过非极大值抑制技术优化目标检测结果。该方法与基于光流的方法相比,抗复杂背景干扰和抗目标运动模糊的能力显著提高。

由于卷积神经网络训练过程丢失时间维度信息,无法保证特征的时空一致性的问题,除了上述用运动补偿来获得时空稳定特征的方法外,有研究者提出输入图像序列到神经网络中来提取隐含的运动信息,主要包括 Siamese[78]和循环神经网络(Recurrent Neural Network, RNN)[79]网络。文献[80]提出了基于全卷积神经网络的目标检测框架,该框架通过使用 Siamese网络来提取时序信息,同时,RNN 作为一种时间序列模型也能够提供时序信息,在循环神经网络中,当前层的输出不仅与输入有关,还取决于前一时刻的输入,使得神经网络具有“记忆”功能,RNN 主要应用于自然语言处理领域。

面向视频数据的无人机检测在实际应用中通常会遇到树枝、飞鸟等动态的非目标干扰物,单纯利用帧间光流信息难以将其与真实目标区分开来。针对该问题,文献[81]发现无人机作为一种人工设计的飞行器,其飞行动力学具有一定的特异性规律,因此提出一种基于多帧目标形态变化特性和航迹规律的无人机目标检测方法,能够一定程度上降低目标检测虚警率。但是该方法的目标分割过程建立在背景差分法之上,因此对背景运动复杂度以及传感器运动(包括移动、转动和扰动)幅度具有较高的要求。

以下

略。

感兴趣的同学可以去知网上下载此论文。

文章来源:杨 欣 1,2,王 刚 2,3,李 椋 2,李邵港 1,2,高 晋 4,王以政 2. 基于深度卷积神经网络的小型民用无人机检测研究进展 [J]. 红河技术, 2022,44(11)

目前机器视觉结合无人机应用的方案国内许多AI公司都在做,也是一个很热门的版块,但是还是存在一个费用高、准确率不理想的结果。这里想推荐一个国内的机器视觉平台—Coovally,它是一个包含完整AI建模流程、AI项目管理及AI系统部署管理的机器视觉平台。可以把开发周期从月缩短到天,加快AI视觉解决方案的开发、集成、测试和验证。帮助提升企业的AI栈软件开发能力,使先进的AI系统能够以更低成本、更快地普及。“打包自身的AI能力”给业务人员使用,从而实现“授人以渔”。目前跑码地Coovally已覆盖多个应用领域,包含制造业质检、地质灾害监测、电力行业设备监控、医学专病诊断、智慧交通、智慧园区等。