初始化

深度学习模型训练的过程本质是对参数w进行更新,这需要每个参数有相应的初始值。

为什么要初始化?

神经网络要优化一个非常复杂的非线性模型,而且基本没有全局最优解,初始化在其中扮演着非常重要的作用。

□ 初始点的选取,有时能够决定算法是否收敛;

□ 当收敛时,初始点可以决定学习收敛的多快,是否收敛到一个代价高或低的点;

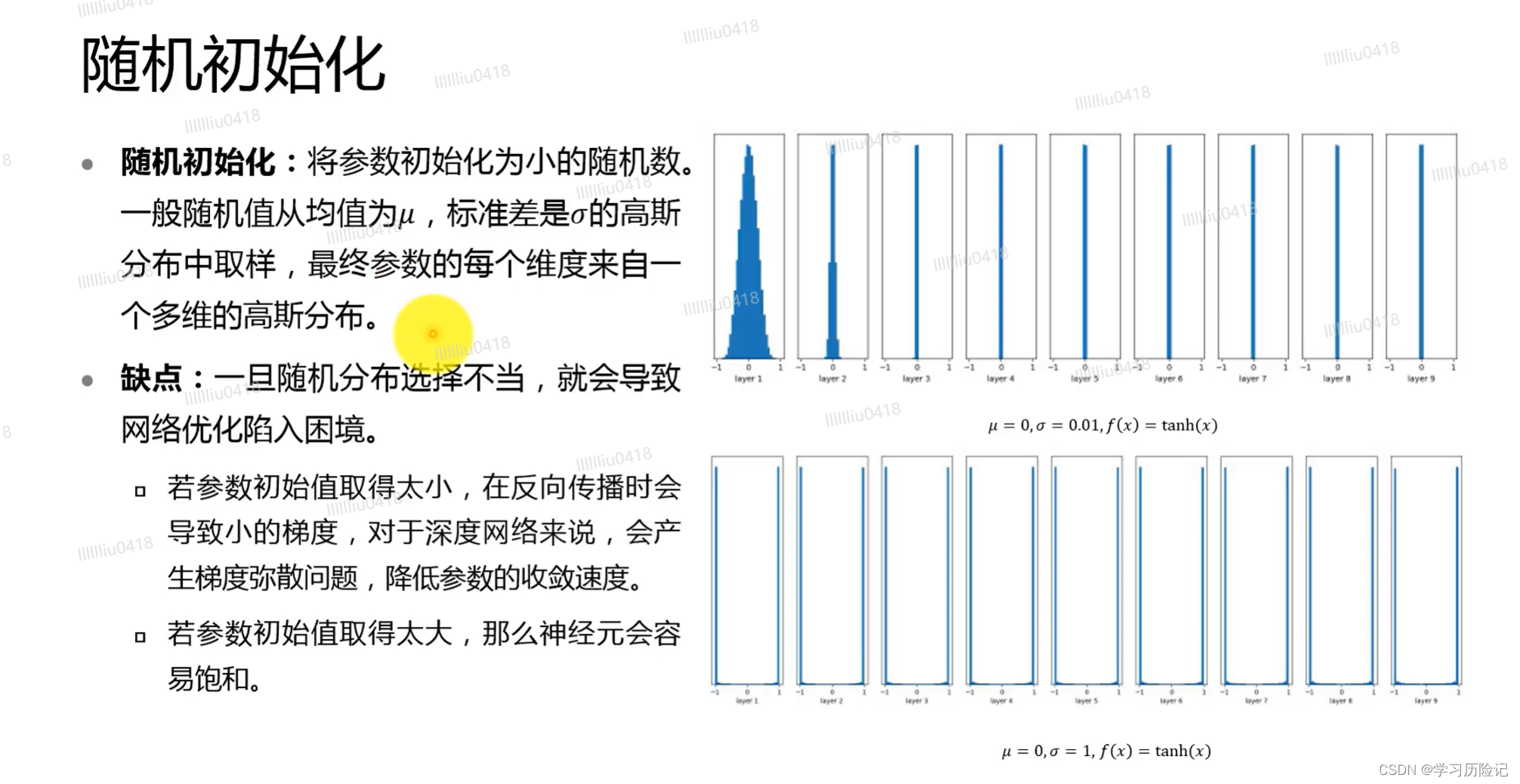

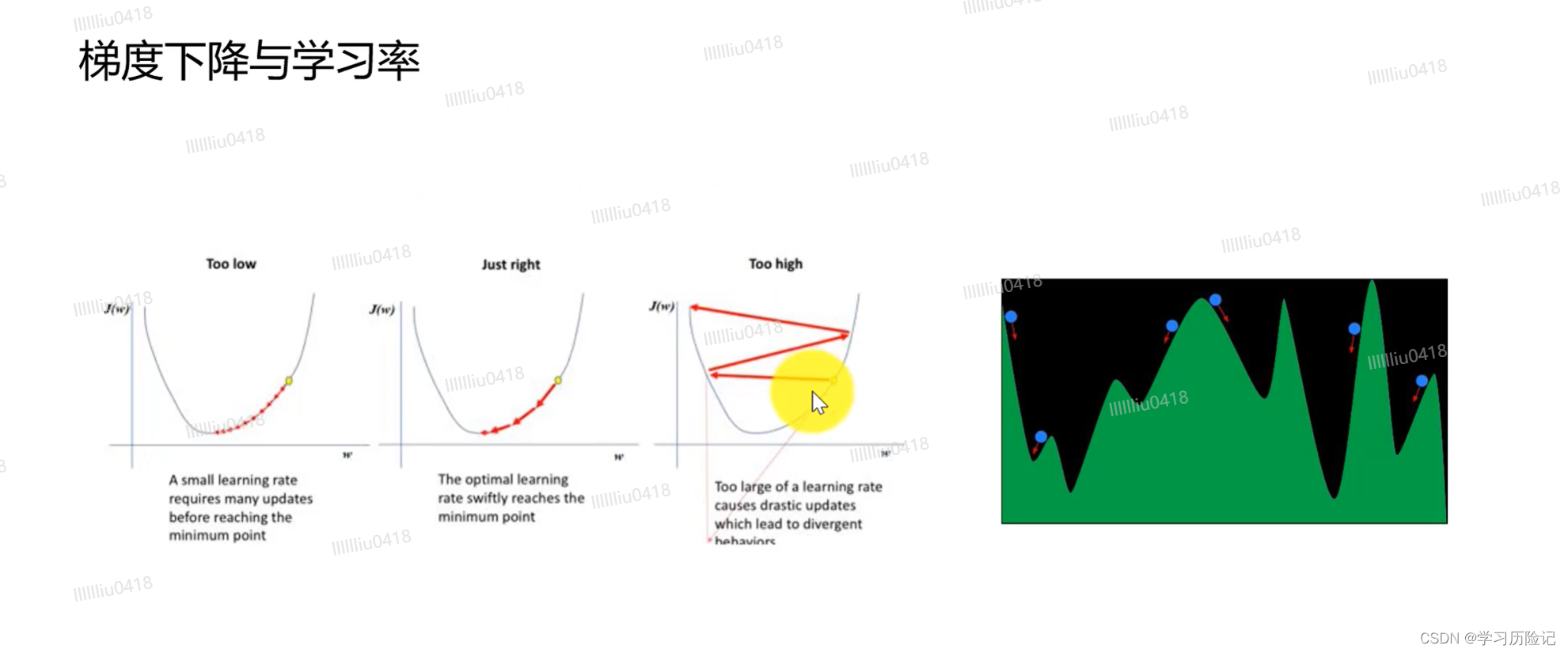

□ 过大的初始化导致梯度爆炸,过小的初始化导致梯度消失。

什么是好的初始化?

好的初始化应该满足以下两个条件:

□ 让神经元各层激活值不会出现饱和现象;

□ 各层激活值也不能为0。

全零初始化:参数初始化为0。

缺点:同一层的神经元会学习到相同的特征,不能破坏不同神经元的对称性质。

如果神经元的权重被初始化为0,所有神经元的输出都将是相同的,除了输出之外,所有的中间层的节点的值都为零。一般神经网络拥有对称的结构,那么在进行第一次误差反向传播时,更新后的网络参数将会相同,在下一次更新时,相同的网络参数学习提取不到有用的特征,因此深度学习模型都不会使用0初始化所有参数。

参数调节

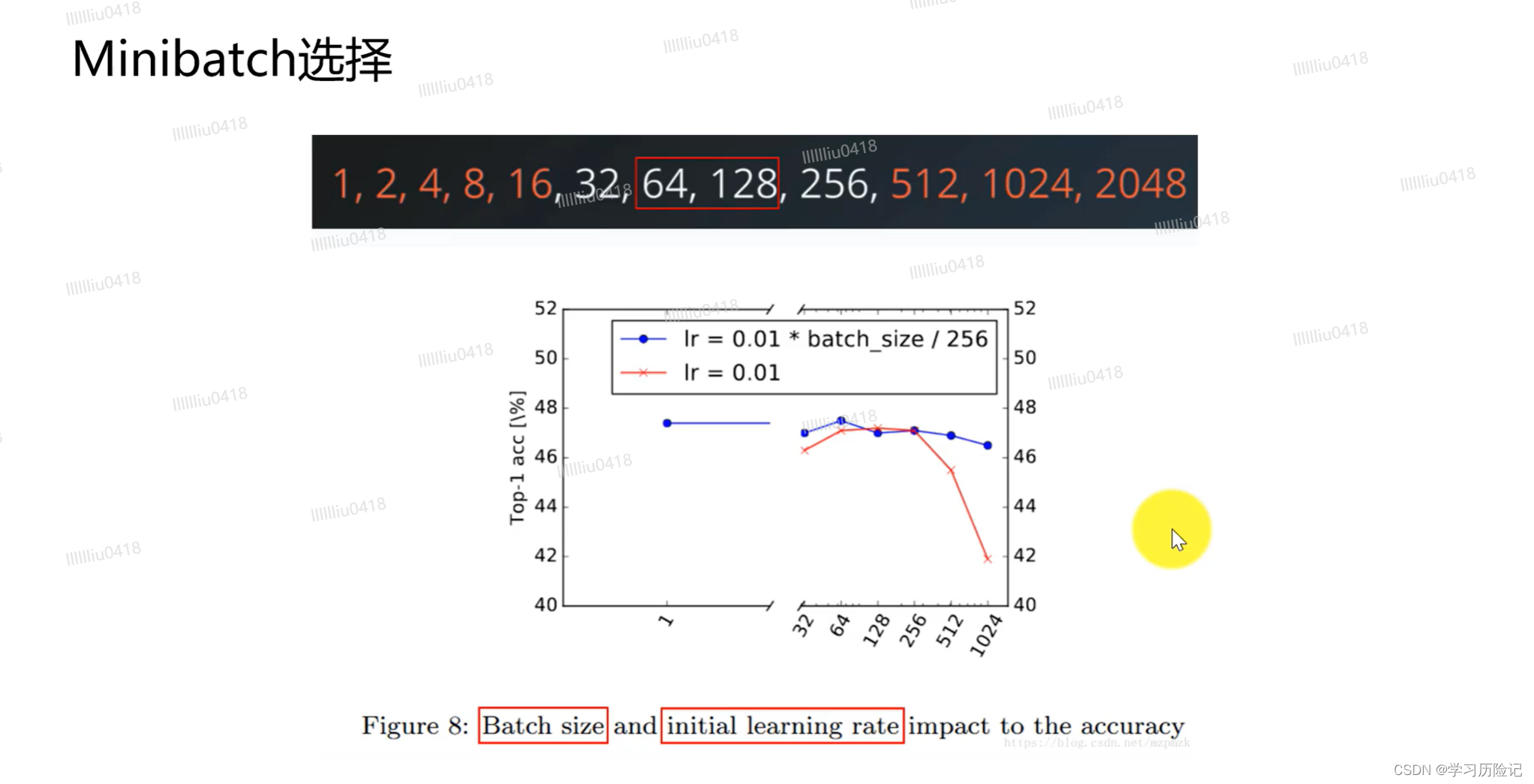

批量 batchsize 选择2的指数倍 与计算机内存相符

超参数调节方法

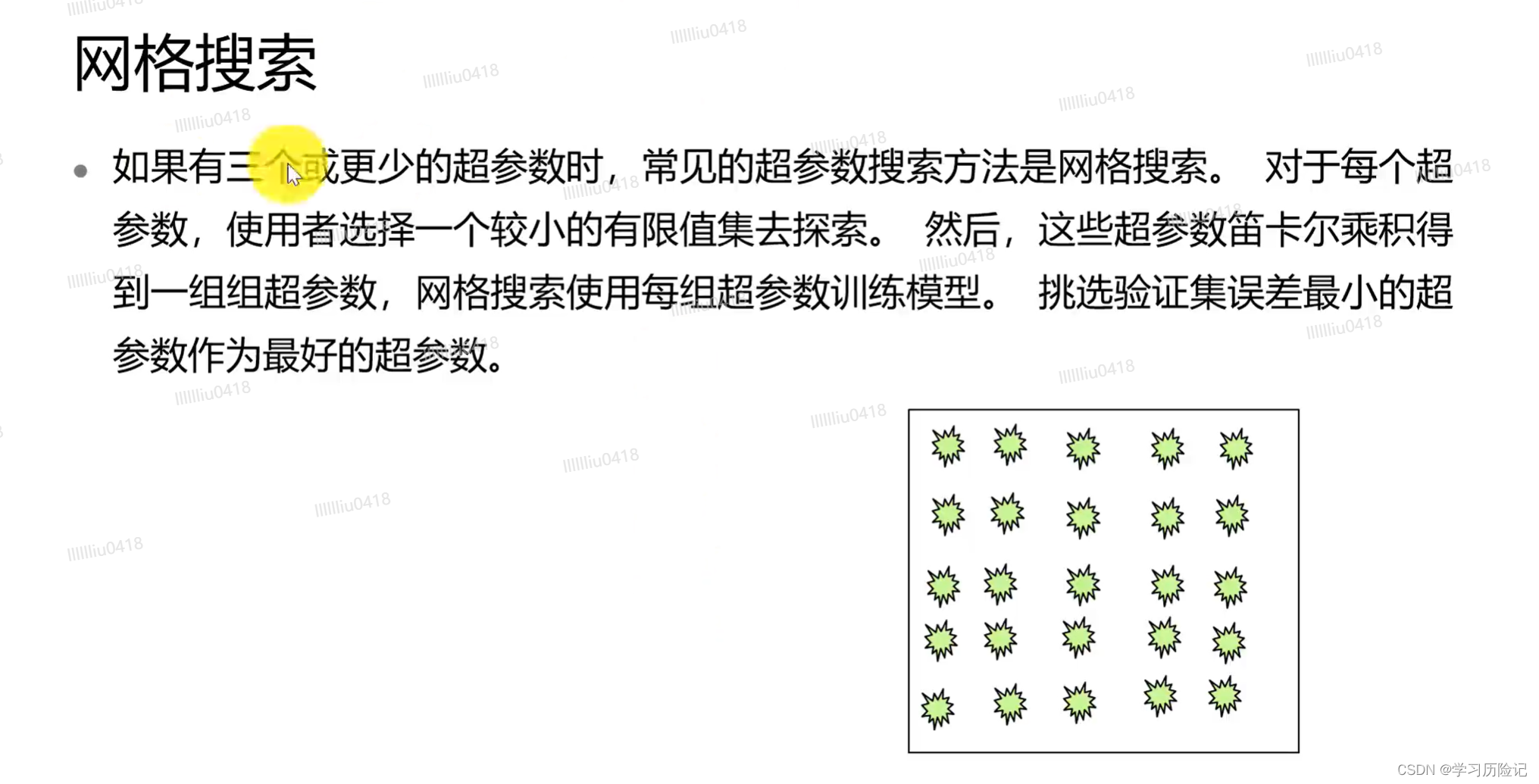

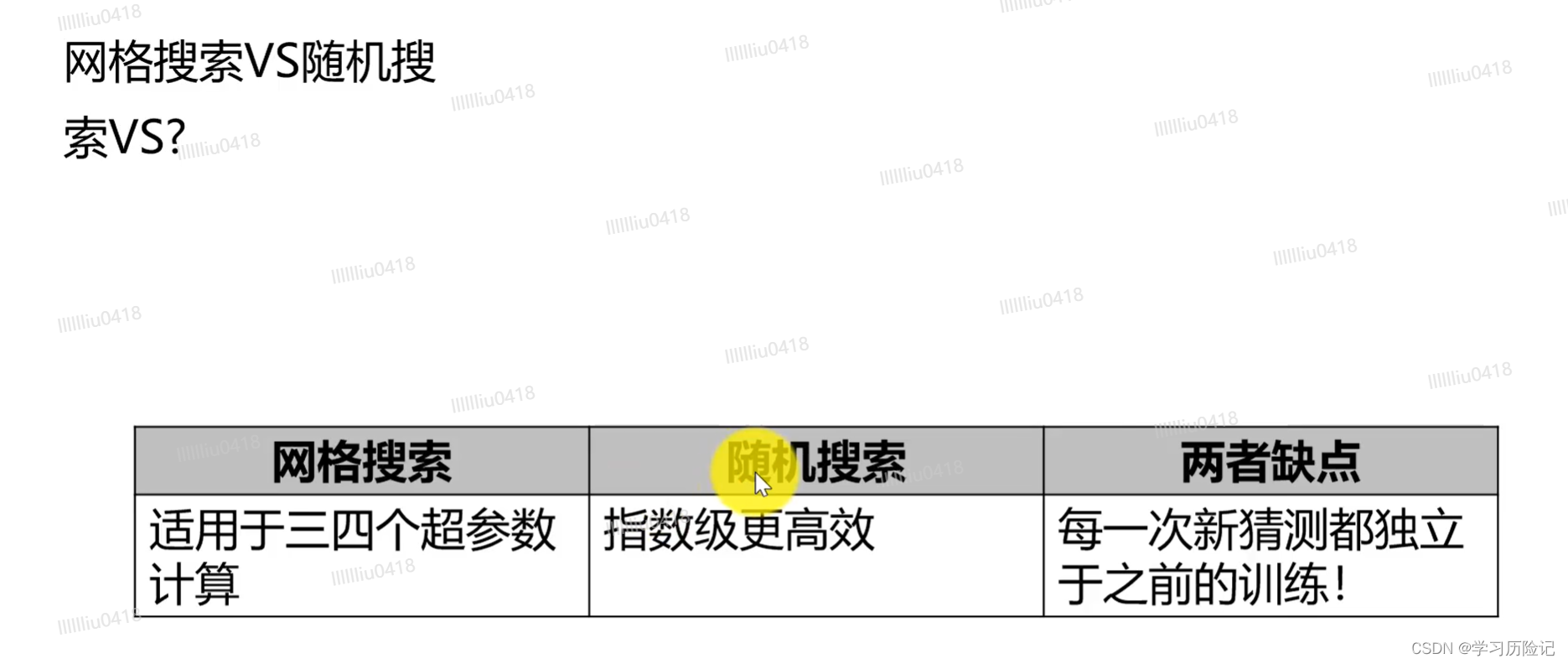

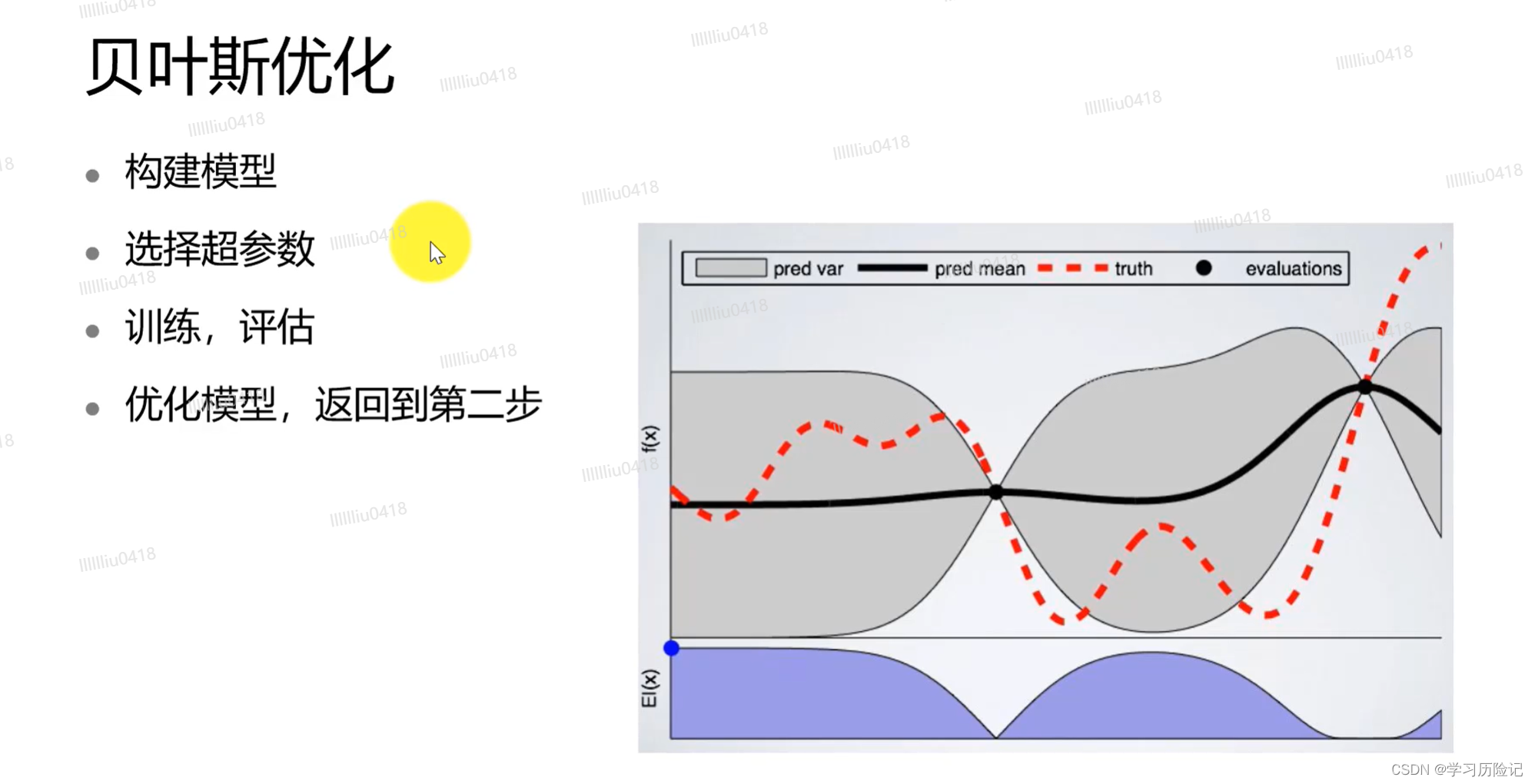

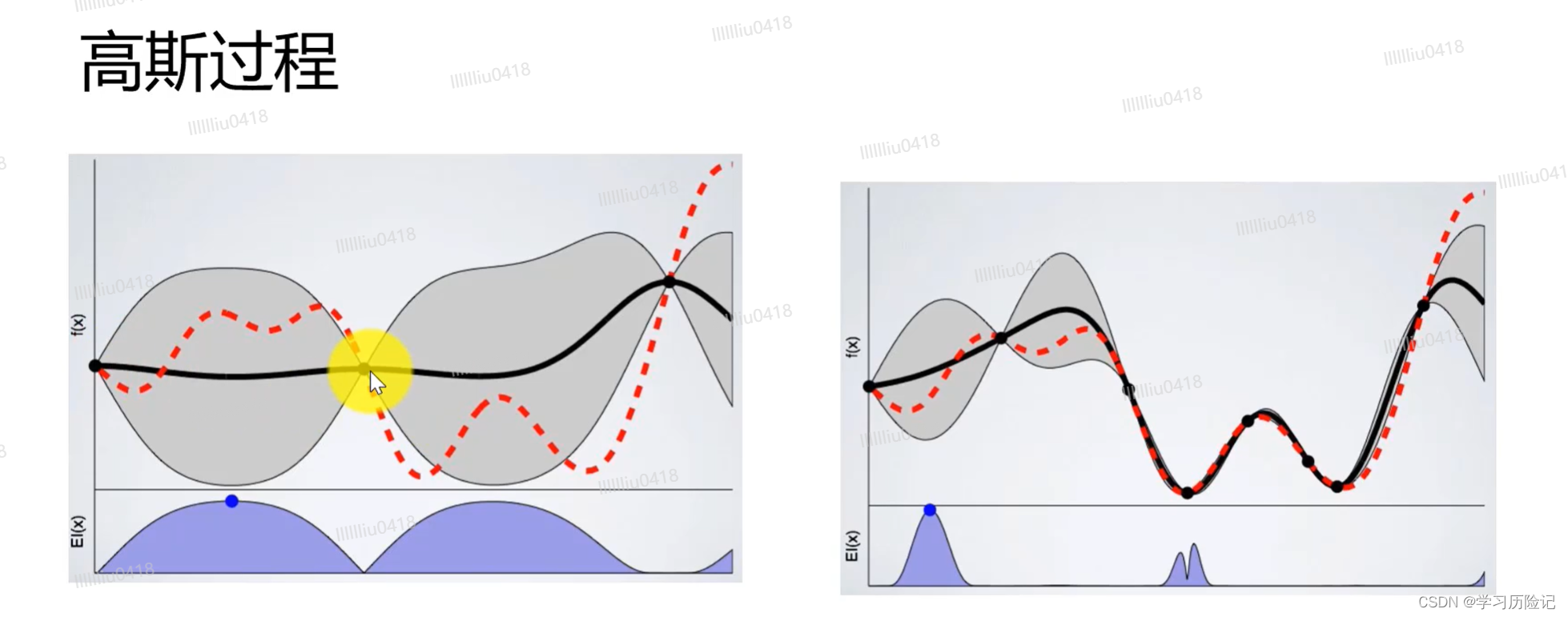

试错法、网络搜索、随机搜索、贝叶斯优化、高斯过程