近日,在北京举行的2023开放原子全球开源峰会开源大模型分论坛上,笔者作为开放原子基金会TOC大模型SIG(即Special Interest Group,类似工作组)的发起人,发表了名为《开源协作下一代数字经济核心基础设施》的主题演讲,分论坛的官方媒体回顾链接在此https://mp.weixin.qq.com/s/6eXK-6ztLUBpw2qK61ZsTg。

在这里,我想把在我在当日论坛上分享的内容用博客文章更详细的写下来,并呼吁更多的参与。

首先大语言模型为什么重要?

ChatGPT火了,而且高温不退。2022年11月30日,OpenAI对外推出基于GPT3.5的ChatGPT服务,给全球互联网和科技带来前所未有的震撼。人类世界从未有这样的产品,短短两个月达到一亿的活跃用户,而且很多用户愿意付费,愿意每天使用,并且不断有新的用法出来。为什么?简单分析来说,我认为是以下两个原因造成它的大流行。

- 第一个原因是ChatGPT第一次以toC的应用向普罗大众揭示了AI的能力。 2017年以来,著名AI科学家并曾任谷歌和百度AI大脑负责人的吴恩达教授一直都说“AI is the New Electricity“, 即AI是新的电力,将彻底改变人类的工作和生活,但是长期以来,普通人很难感受到AI的魅力,他们也许在手机上体验过支付宝的人脸支付,体验过抖音上的小视频推荐,体验过京东上的购物推荐,这些场景后面其实都是大量人工智能的技术在支撑,但是相对没有那么直接能感受到。而ChatGPT提供了一个人人能用的对话框,只需要输入对话内容,他就像一个无所不知的天才,能够给出各种比较合理或者看似合理的答复,而且在中英翻译、文章摘要、寻求建议等方面表现的非常专业。普通人第一次能以如此方便的形式感受到AI的能力,就像电灯把电力带到了千家万户,“Chat GPT”把人工智能的能力展示给了所有普通人。

- 第二个原因是它以自然语言交互的方式大大降低了体验的门槛。 交互的进步是可以极大的促进技术、产品和产业的进步的。我们回想一下相关的历史,2007年苹果乔布斯先生发布初代iPhone的时候,它带来革命的交互方式的改变,人们可以用手指来代替键盘或者手写笔来完成手机上跟各个手机应用之间的交互,他们通过点击、拖放、多点触摸等交互方式轻松使用手机上的各种应用,彻底改变了手机产业,并带来移动互联网的高速发展;但是对于人来说,相对手指,对话是更自然的交互方式。只要跟计算机系统进行对话,就可以完成大部分的工作,这是很多人的梦想。但是之前的各种对话工具,例如苹果的Siri和Baidu的小度,虽然已经发布不短时间了,但是对于人的自然语言的理解和交互的逻辑,距离人的期望还是差的很远。但是这一次,ChatGPT的发布,让大家发现,原来和它对话,并不是那么痛苦的事情,它能很好的理解问题,而且还能很有逻辑的回答问题(虽然有些问题回答是一本正经的胡说八道)。从此,以自然语言交互的方式,将成为之后人机交互的默认界面,因为它的交互体验更自然。

这一切才刚刚开始,ChatGPT只是大模型应用的一种产品,此外还有更多大模型应用的产品相继出现,比如Midjourney的AI图片生成,Runway的AI视频生成,以及Adobe、微软等把AIGC工具集成到它们的生产力工具等等。随着大模型技术的进步以及人类想象力的进步,会有更多相关的AI工具出现,极大的提升我们日常工作和生活的效率。

但是,大模型不仅仅只是生产力工具,它可能比想象中还要重要。它浓缩了全世界的知识,将彻底改变“知识的创造、继承和应用”,对知识的影响堪比四大发明的“造纸术和印刷术“。而知识是第一生产力,知识的创造、继承和应用方式的彻底改变,将对整个社会的工业、农业、教育、军事等发生重大影响。所以我认为大模型是下一代数字经济核心的基础设施。

所以,中国的大模型建设不能落后,但是这一仗怎么打?

我们先看看现状,现状是大模型全世界只有中美能做,但是对比OpenAI,我们的差距是非常明显的。

- 我们的模型距离GPT3.5还有几个月的差距,但是GPT 4出来又几个月了。

- 我们的中文数据集在数量上和质量上还跟英文数据集有很大差距。

- 我们的算力还受到很大的限制。

- 我们架构在大模型上的开发生态才刚刚开始。

所以,只能发挥中国“集中力量办大事”的传统,汇聚国内广大相关企业、高校、研究单位的人力和资源,来共同把大模型做好。但是选择什么样的战略呢?

看看国内已经参与大模型的各个企业,最近呈现出百模大战的局面,包括百度、阿里、华为、360、网易、商汤、清华智谱、北京智源等都纷纷推出自己的大模型产品。他们之中其实是有大量的重复工作的,包括并不限于如下这些:

- 中文语料的收录和清洗。

- 中文对齐指令训练集的标注和整理。

- 跟国家相关合规规定的对齐。

- 对国产算力的适配和调优,包括训练和推理的调度和优化。

- 相关训练程序的优化,尤其是RLHF部分。

如果我们能够采用开源的方式,把这些重复的工作都采用更高效的方式协作起来,是可以减少重复造轮子,并为创新生态提供更好的基础的。

当然,我们需要的大模型是一个能够持续进化的大模型,是一个能在此基础上产生健康生态(开发活跃、良性竞争、技术和商业都兼顾)的大模型,再结合开放原子基金会的使命和价值观,我们只能采用开源协作的方式来推动。

可能有的同学有疑问,能否集中各种资源(包括数据、人力、算力等资源)支持一两家公司或者机构来快速发展大模型?我认为首先这不符合开放原子基金会的定位;其次我不认为这种类似“天选”或者“钦定”的方式能在如今的形式下Work。用“天选”的方式进行运作,风险太高了,包括技术风险,团队风险和道德风险。大模型的技术迭代是非常快的,虽然目前的主流都是基于Transformer的Decoder Only模式,但是过几年呢?多模态的要求尤其是多模态对齐的要求下,Transformer的Decoder Only是否还是最优的方式,不好说。不能只赌一种技术路线,赌一种技术路线的技术风险实在太高了,因为这一仗我们不能输;另外选定一到几家企业或者机构,这些组织的团队是否给力,是否能长期良性运作都是一个问题,他们能否承担起这样的责任并一步步实现?;最后选择集中算力资源来支持一到几家组织也是道德风险巨高的事情,算力后面是海量的机器,后面是天价的财政投入,数据集后面也是巨大的资源投入。垄断状态下有可能会滋生严重的腐败问题。基于以上这些原因,开放原子基金会来推动建设大模型,只能采用开源协作,并长期努力的方式来进行。(当然不排除某些机构采用集中力量支持一两家机构的可能性,他们在处理好以上这些风险后有可能行动速度更快,更容易看到效果。)

开源协作的路线定下来之后,我们来看看具体怎么操作?

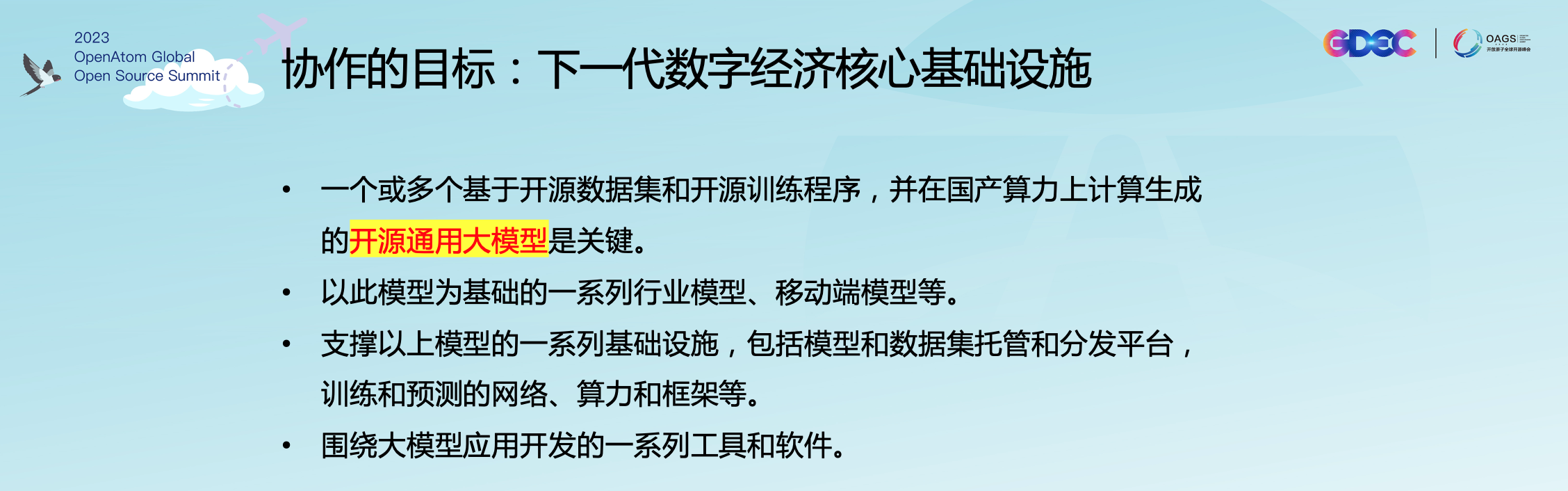

先看看协作的目标是什么?见下图。

其中一个或多个基于开源数据集(符合国内相关合规规定)和开源训练程序,并在国产算力上训练生成的开源通用大模型是关键。

我来简单拆解一下,从结果的角度来倒推为什么。

未来几十年的大模型相关的产业形态,我预测如下:1. 首先是有几家提供通用大模型服务的企业,候选包括百度、阿里等; 2.其次是多家企业提供行业大模型的服务,包括金融、能源、制造等行业;3.最后是数百家甚至上千家技术企业提供企业内部的私有化大模型服务,用于知识管理、软件开发、供应链等具体场景。每家企业内都会有很多大模型的服务,其中大部分是部署在企业内部的私有化大模型服务,也有少部分是访问公网大模型API服务。

那么开源通用大模型将如何支撑这些产业形态?1. 提供通用大模型服务的企业,可以是在开源通用大模型加上他们各自有独特竞争力的特性,或者是部分私有数据提供更好的能力,或者是在底层调度和优化上提供更低价格的服务;2.提供行业大模型服务的企业,可以是在开源通用大模型加上各个行业特有的数据。3. 企业内部的私有大模型,可以是在开源通用大模型上加上企业内部的私有数据。以上种种形态的分析都表明,开源通用大模型是关键的技术底座。

架构在开源通用大模型之上还有各种各样的技术栈,包括开发框架、向量数据库等都可以通过开源的方式来共建。用来支持的底层算力调度和优化的开发库或者平台,也都可以用开源的方式共建。

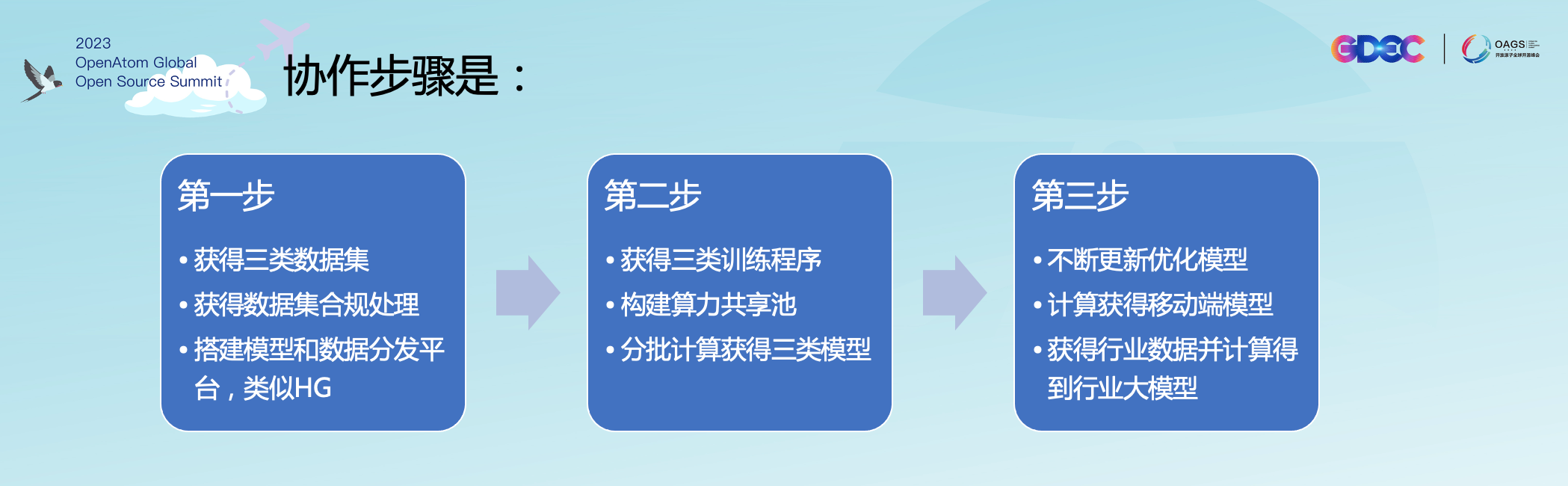

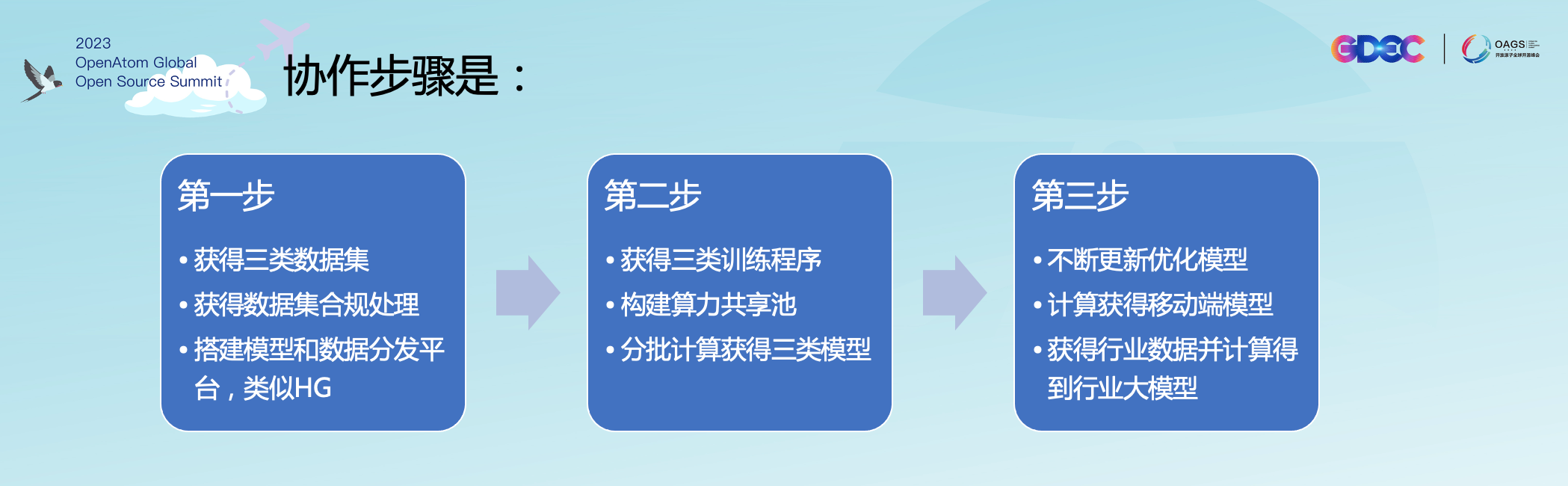

那么共建大模型(包括算力、数据集、算法)以及之上的开发技术栈,以及之下的国产算力调度和优化,实施步骤可以按照如下的计划进行三步走。

这上面所列举的三类数据集和三类模型,是我把ChatGPT的训练过程简化为三个步骤,见下图,分别是:

1. 拿数十TB来自互联网的语料,进行非监督学习,得到预训练模型,也称为Base model;

2. 拿数万人工标注的指令训练集,进行监督学习,得到指令优化模型,也称为SFT Model;

3. 拿数万人工标注的强化训练集,进行强化学习,得到最后的对话模型,称为Assit Model,也称为Chat Model。

具体这三步走的步骤如下:

- 第一步:获得各种开源数据集(以中文为特色),加上数据合规清洗程序(依据中国的各种法律法规对原始数据集进行合规处理和清洗);并存放在国内的模型和数据托管服务上,类似Hugging face。

- 第二步:获得各种开源训练程序,并组织算力共享池,在此算力上训练得到各种通用的开源大模型;

- 第三步:不断优化和更新通用大模型,训练得到移动端模型,结合行业数据得到开源行业大模型等;

路线和步骤都如上所述,但是纸上谈兵好说,难的是一步步的落到实处。不过好在基金会TOC的价值观就是开放、透明、务实。我相信一步步来,每一步都走的很坚实,那么一定会得到很好的长期效果,为中国的开源大模型技术生态和商业生态,提供最基础的数据、算法和模型。 希望能做到全程透明可追述,任何一家有一定财力的公司或者组织,都可以根据基金会文档组建好算力集群后,下载各种数据集和程序,从头训练出三类大模型(基础模型、监督模型和对话模型)出来,然后再进行各种fine tune来适配各自的场景,或者作为行业大模型服务提供,或者作为企业内部大模型服务提供。

开放原子基金会在TOC的大模型SIG之上,组建了开源大模型工作委员会,从数据共享,算法开源、算力公用基础设施共建三个方面来进行协作。

欢迎社会各界人士加入该工委会,请联系开放原子基金会(官网地址在https://www.openatom.org/)