作者:英特尔物联网行业创新大使 杨雪锋

目录

1.2 导出YOLOv8-Pose姿态估计OpenVINO IR模型

1.3 用benchmark_app测试yolov8姿态估计模型的推理计算性能

1.4 使用OpenVINO Python API编写YOLOv8-Pose姿态估计模型推理程序

1.1 简介

《在英特尔开发套件上用OpenVINO加速YOLOv8-Seg实例分割模型》介绍了在英特尔者开发套件上使用OpenVINO™ 开发套件部署并测评YOLOv8-Seg的实例分割模型,本文将介绍在英特尔开发者套件上使用OpenVINO™ 2023.0加速YOLOv8-Pose姿态估计(Pose Estimation)模型。

请先下载本文的范例代码仓,并搭建好YOLOv8的OpenVINO推理程序开发环境。

git clone https://gitee.com/ppov-nuc/yolov8_openvino.git

1.2 导出YOLOv8-Pose姿态估计OpenVINO IR模型

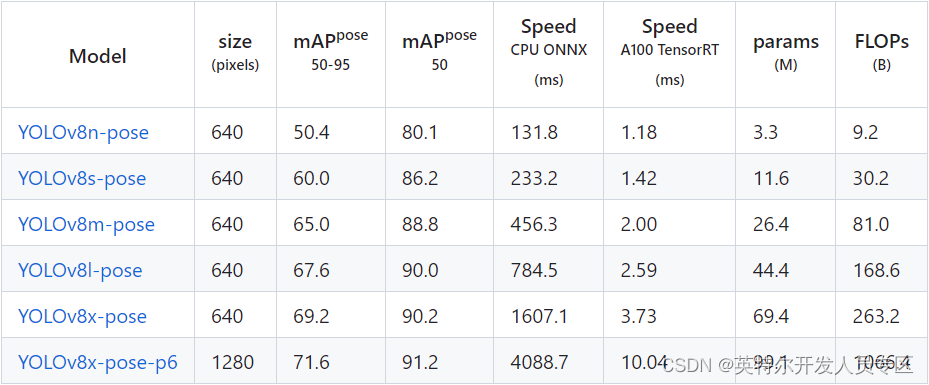

YOLOv8-Pose的姿态估计模型有5种,在COCO Keypoints数据集完成训练,如下表所示。

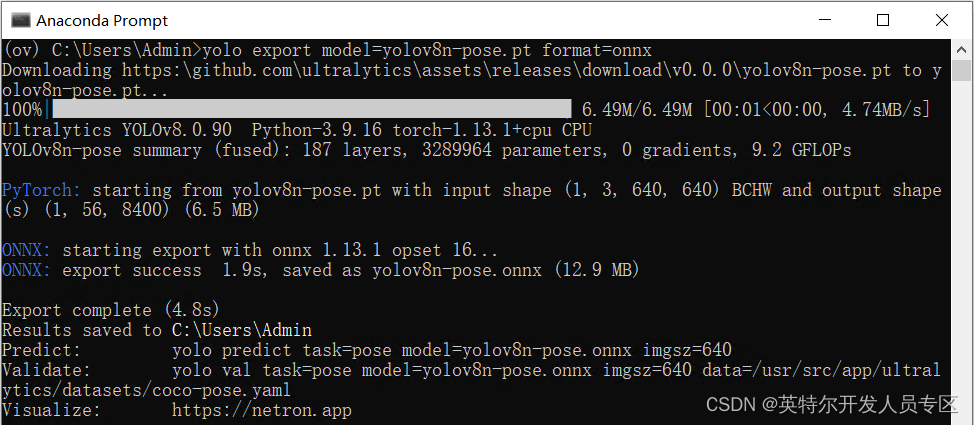

首先使用命令:yolo export model=yolov8n-pose.pt format=onnx,完成yolov8n-pose.onnx模型导出,如下图所示。

然后使用命令:mo -m yolov8n-pose.onnx --compress_to_fp16,优化并导出FP16精度的OpenVINO IR格式模型,如下图所示。

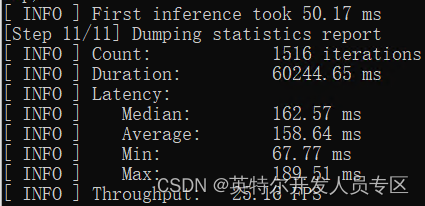

1.3 用benchmark_app测试yolov8姿态估计模型的推理计算性能

benchmark_app是OpenVINOTM工具套件自带的AI模型推理计算性能测试工具,可以指定在不同的计算设备上,在同步或异步模式下,测试出不带前后处理的纯AI模型推理计算性能。

使用命令:benchmark_app -m yolov8n-pose.xml -d GPU,获得yolov8n-pose.xml模型在英特尔开发者套件的集成显卡上的异步推理计算性能,如下图所示。

1.4 使用OpenVINO Python API编写YOLOv8-Pose姿态估计模型推理程序

用Netron打开yolov8n-seg.onnx可以看到模型的输入和输出:

- 输入节点名字:“images”;数据: float32[1,3,640,640]

- 输出节点1的名字:“output0”;数据:float32[1,56,8400],其中“8400”是指YOLOv8的3个检测头在imgsz=640时,有640/8=80, 640/16=40, 640/32=20, 80x80+40x40+20x20=8400个输出单元格; “56”指“Person”类的中心坐标cx,cy,w,h+“Person”类的置信分数+“Person”类的17个关键点([17,3]) = 56。

基于OpenVINO Python API的YOLOv8实例分割模型范例程序yolov8_pose_ov_sync_infer_demo.py的核心源代码,如下所示:

# 实例化Core对象

core = Core()

# 载入并编译模型

net = core.compile_model(f'{MODEL_NAME}.xml', device_name="GPU")

# 获得模型输出节点

output_node = net.outputs[0]

ir = net.create_infer_request()

cap = cv2.VideoCapture("store-aisle-detection.mp4")

while True:

start = time.time()

ret, frame = cap.read()

if not ret:

break

[height, width, _] = frame.shape

length = max((height, width))

image = np.zeros((length, length, 3), np.uint8)

image[0:height, 0:width] = frame

scale = length / 640

blob = cv2.dnn.blobFromImage(image, scalefactor=1 / 255, size=(640, 640), swapRB=True)

# 基于OpenVINO实现推理计算

outputs = ir.infer(blob)[output_node]

outputs = np.array([cv2.transpose(outputs[0])])

rows = outputs.shape[1]

# Postprocess

boxes = []

scores = []

preds_kpts = []

for i in range(rows):

classes_scores = outputs[0][i][4]

key_points = outputs[0][i][5:]

if classes_scores >= 0.5:

box = [

outputs[0][i][0] - (0.5 * outputs[0][i][2]), outputs[0][i][1] - (0.5 * outputs[0][i][3]),

outputs[0][i][2], outputs[0][i][3]]

boxes.append(box)

scores.append(classes_scores)

preds_kpts.append(key_points)

result_boxes = cv2.dnn.NMSBoxes(boxes, scores, 0.25, 0.45, 0.5)

detections = []

for i in range(len(result_boxes)):

index = result_boxes[i]

box = boxes[index]

pred_kpts = preds_kpts[index]

detection = {

'class_id': 0,

'class_name': 'person',

'confidence': scores[index],

'box': box,

'scale': scale}

detections.append(detection)

print(box[0] * scale, box[1] * scale, scale)

draw_bounding_box(frame, 0, scores[index], round(box[0] * scale), round(box[1] * scale),

round((box[0] + box[2]) * scale), round((box[1] + box[3]) * scale))

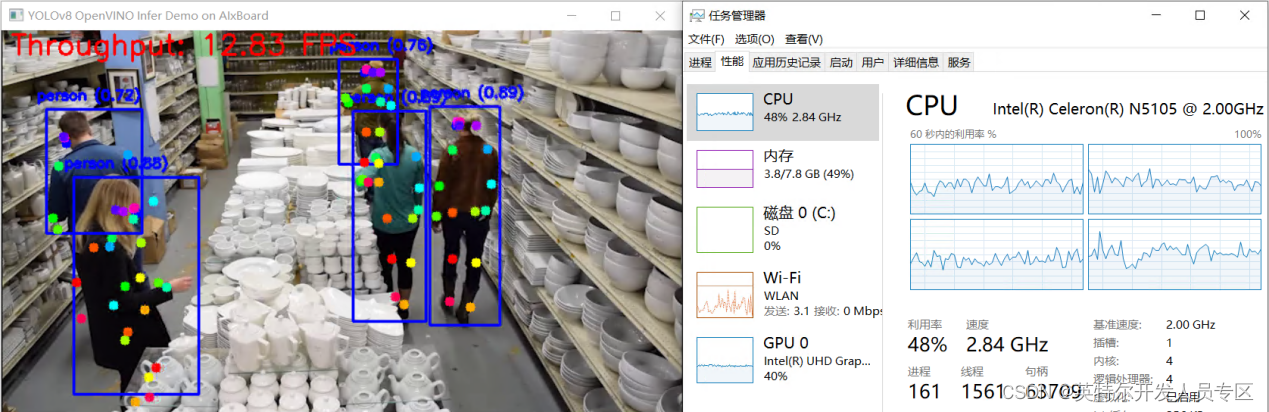

draw_key_points(frame, pred_kpts, 0.2, scale)运行结果,如下图所示:

1.5 结论:

英特尔开发者套件借助N5105处理器的集成显卡(24个执行单元)和OpenVINO 2023.0,可以在YOLOv8-Pose的姿态估计模型上获得相当不错的性能。通过异步处理和AsyncInferQueue,还能进一步提升计算设备的利用率,提高AI推理程序的吞吐量。