Centralized Feature Pyramid for Object Detection

摘要

视觉特征金字塔在广泛的应用中显示出其有效性和效率的优越性。

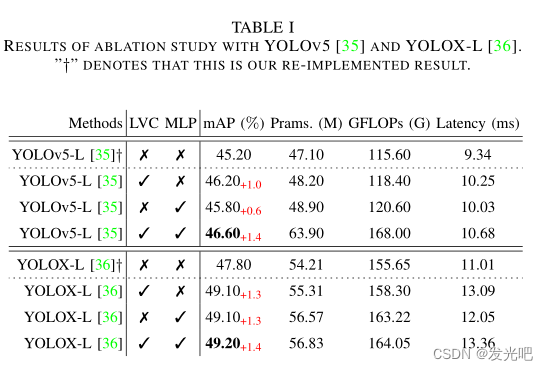

然而,现有的方法过分地集中于层间特征交互,而忽略了层内特征规则,这是经验证明是有益的。尽管一些方法试图在注意力机制或视觉变换器的帮助下学习紧凑的层内特征表示,但它们忽略了对密集预测任务非常重要的被忽略的角点区域。为了解决这一问题,本文提出了一种基于全局显式集中式特征规则的集中式特征金字塔(CFP)对象检测方法。具体而言,我们首先提出了一种空间显式视觉中心方案,其中使用轻量级MLP来捕捉全局长距离依赖关系,并使用并行可学习视觉中心机制来捕捉输入图像的局部角区域。在此基础上,我们以自上而下的方式对常用特征金字塔提出了一种全局集中的规则,其中使用从最深层内特征获得的显式视觉中心信息来调整正面浅层特征。与现有的特征金字塔相比,CFP不仅能够捕获全局长距离依赖关系,而且能够有效地获得全面但有区别的特征表示。在具有挑战性的MS-COCO上的实验结果验证了我们提出的CFP能够在最先进的YOLOv5和YOLOX目标检测基线上实现一致的性能增益。该代码发布于:CFPNet。

I. INTRODUCTION

对象检测是计算机视觉领域中最基本但最具挑战性的研究任务之一,其目的是为输入图像中的每个对象预测一个唯一的边界框,该边界框不仅包含位置,还包含类别信息。在过去几年中,这项任务已被广泛开发并应用于广泛的潜在应用,例如,自动驾驶[2]和计算机辅助诊断。

成功的目标检测方法主要基于卷积神经网络(CNN)作为主干,然后是两阶段(例如,快速/快速R-CNN)或单阶段(例如SSD和YOLO)框架。

然而,由于目标尺寸的不确定性,单个特征尺度不能满足高精度识别性能的要求。为此,提出了基于网络内特征金字塔的方法(例如SSD和FPN)这些方法背后的统一原则是为每个不同大小的对象分配感兴趣区域,并提供适当的上下文信息,使这些对象能够在不同的特征层中识别。

…

尽管这些方法可以解决CNN中有限的接受域和局部上下文信息,但一个明显的缺点是它们的计算复杂性很大。例如,与输入大小为224×224的性能相当的CNN模型RegNetY相比,Swin-B几乎有3倍模型FLOP(即47.0 G vs 16.0 G),这很容易忽略对于密集预测任务很重要的一些角区域(例如,“飞机引擎”、“摩托车车轮”和“蝙蝠”)。这些缺点在大规模输入图像上更为明显。为此,我们提出了一个问题:是否有必要在所有层上使用变压器编码?为了回答这个问题,我们从分析浅层特征开始。浅层特征主要包含一些一般的对象特征模式,例如纹理、颜色和方向,这些通常不是全局的。相比之下,深度特征反映了对象特定信息,通常需要全局信息。因此,我们认为transformer在所有层中都是不必要的。

在这项工作中,我们提出了一种用于对象检测的集中式特征金字塔(CFP)网络,该网络基于全局显式集中式规则方案。具体而言,基于从CNN主干提取的视觉特征金字塔,我们首先提出了一种显式视觉中心方案,其中使用轻量级MLP架构来捕获长距离依赖关系,并使用并行可学习视觉中心机制来聚集输入图像的局部关键区域。考虑到最深的特征通常包含浅层特征中稀缺的最抽象的特征表示[33]这一事实,基于所提出的调节方案,我们随后以自上而下的方式对提取的特征金字塔提出了一种全局集中调节,其中从最深特征获得的空间显式视觉中心用于同时调节所有的额叶浅特征。与现有的特征金字塔相比,如图1(c)所示,CFP不仅具有捕获全局长距离依赖关系的能力,而且能够有效地获得全面但有区别的特征表示。

为了证明其优越性,在具有挑战性的MS-COCO数据集上进行了大量实验。结果验证了我们提出的CFP能够在最先进的YOLOv5和YOLOX目标检测基线上实现一致的性能增益。

我们的贡献总结如下:

- 我们提出了一种空间显式视觉中心方案,该方案包括一个用于捕获全局长距离依赖的轻量级MLP和一个用于聚集局部关键区域的可学习视觉中心。

- 我们以自上而下的方式为常用特征金字塔提出了一个全球集中的规则。

- CFP在强目标检测基线上实现了一致的性能增益。

II RELATED WORK

第二点就不说了,感兴趣可以看一下原文,主要介绍第三点。

III. OUR APPROACH

在本节中,我们将介绍所提出的集中式特征金字塔(CFP)的实现细节。我们首先在第III-A节中概述了CFP的架构描述。

然后,我们在第III-B节中展示了显式可视化提交4中心的实现细节。最后,我们展示了如何在图像特征金字塔上实现显式视觉中心,并在第III-C节中提出了我们的全局集中规则。

A、 集中式特征金字塔(CFP)

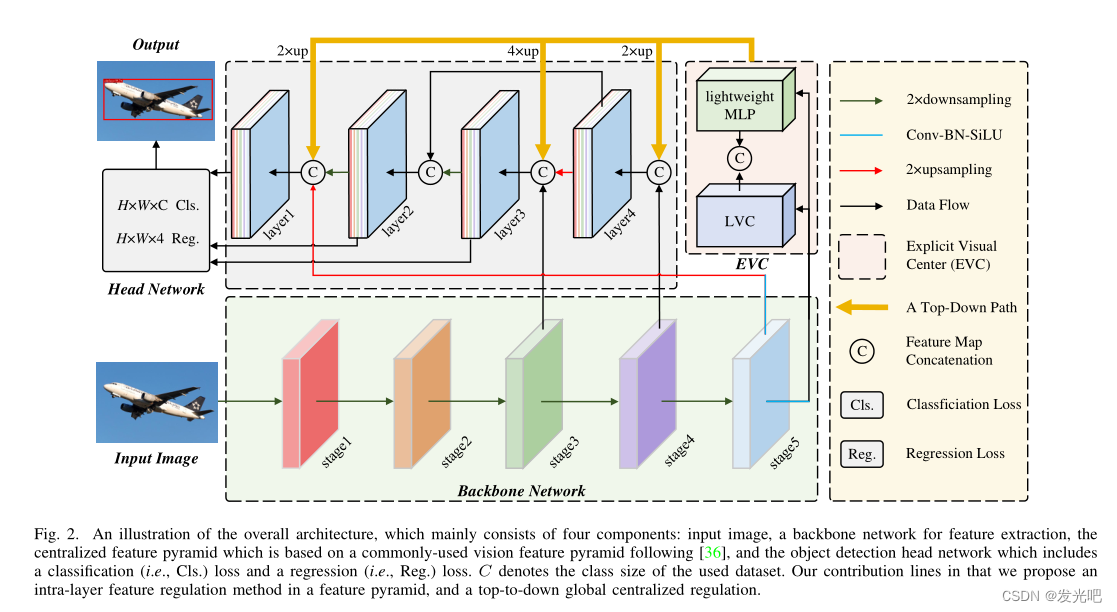

尽管现有的方法主要集中在层间特征交互上,但它们忽略了层内特征规则,这已被经验证明有利于视觉识别任务。在我们的工作中,受先前关于密集预测任务的工作[的启发,我们提出了一种基于全局显式集中层内特征规则的CFP对象检测方法。与现有的特征金字塔相比,我们提出的CFP不仅能够捕获全局长距离依赖关系,而且能够实现全面和差异化的特征表示。如图2所示,CFP主要由以下部分组成:输入图像、CNN主干用于提取视觉特征金字塔、提议的显式视觉中心(EVC)、提议的全球集中调节(GCR)以及用于对象检测的解耦头部网络(包括分类损失、回归损失和分割损失)。在图2中,EVC和GCR在提取的特征金字塔上实现。

具体来说,我们首先将输入图像馈送到骨干网络(即,改进的CSP v5]),以提取五层的特征金字塔X,其中特征Xi(i=0,1,2,3,4)的每一层的空间大小分别为输入图像的1/2,1/4,1/8,1/16,1/32。基于此特征金字塔,我们的CFP得以实现。提出了一种轻量级MLP架构来捕获X4的全局长距离依赖关系,其中标准变压器编码器的多头自关注模块被MLP层所取代。与基于多头注意机制的变压器编码器相比,我们的轻量级MLP架构不仅结构简单,而且体积更轻,计算效率更高(参见第III-B节)。此外,一个可学习的视觉中心机制与轻量级MLP一起用于聚集输入图像的局部角区域。

我们将上述并行结构网络命名为空间EVC,它在特征金字塔的顶层(即X4)上实现。基于所提出的ECV,为了使特征金字塔的浅层特征能够同时以高效模式从最深特征的视觉集中信息中受益,其中从最深的层内特征获得的显式视觉中心信息用于同时调节所有的前浅特征(即X3至X2)。最后,我们将这些特征聚合到一个解耦的头部网络中进行分类和回归。

B. Explicit Visual Center (EVC)

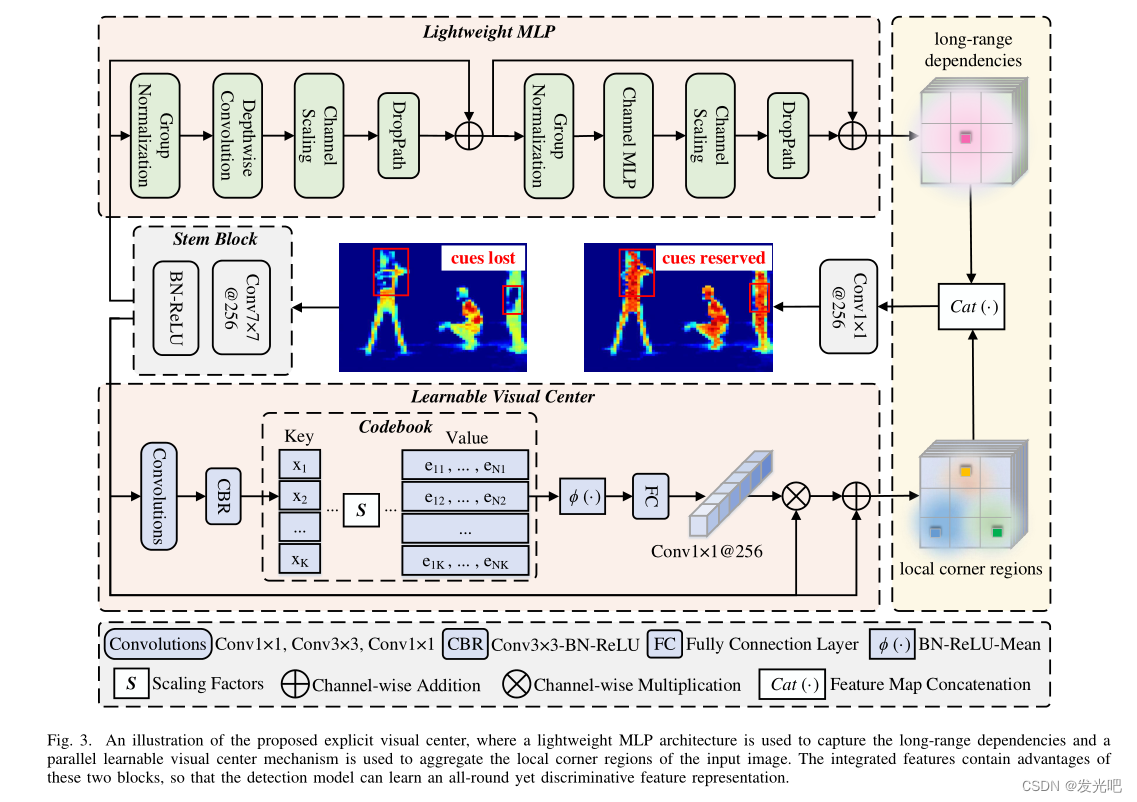

如图3所示,我们提出的EVC主要由两个并行连接的块组成,其中轻量级MLP用于捕获顶层特征X4的全局长程依赖关系(即全局信息)。

同时,为了保留局部角点区域(即局部信息),我们在X4上实现了一种可学习的视觉中心机制,以聚集层内局部区域特征。这两个块的结果特征图沿着信道维度连接在一起,作为用于下游识别的EVC的输出。在我们的实现中,在X4和EVC之间,Stem块用于特征平滑,而不是直接在原始特征图上实现。Stem块由输出通道大小为256的7×7卷积组成,随后是批量标准化层和激活功能层。

MLP:使用的轻量级MLP主要由两个剩余模块组成:基于深度卷积的模块和基于通道MLP的块,其中基于MLP的模块的输入是基于深度卷曲的模块的输出。这两个块之后都是信道缩放操作和DropPath操作,以提高特征泛化和鲁棒性能力。

具体而言,对于基于深度卷积的模块,从Stem模块Xin输出的特征首先被馈送到深度卷积层中,该层已通过组归一化处理(即,特征图沿信道维度分组)。与传统的空间卷积相比,深度卷积可以提高特征表示能力,同时降低计算成本。

然后,实现信道缩放和丢弃路径。之后,Xin的剩余连接被实现。Xin输出的特征首先被馈送到a组归一化,然后基于这些特征实现信道MLP。与空间MLP相比,通道MLP不仅可以有效降低计算复杂度,而且可以满足一般视觉任务的要求。之后,通道缩放,丢弃路径,

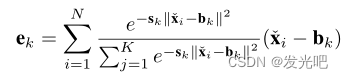

LVC:LVC是一个具有固有字典的编码器,具有两个组件:1)固有码本:B={b1,b2,…,bK},其中N=H×W是输入特征的总空间数,其中H和W分别表示特征图的高度和宽度的空间大小;2) 可学习视觉中心的一组缩放因子S={s1,s2,…,sK}。具体而言,来自stem的Xin的特征首先通过一组卷积层(由1×1卷积、3×3卷积和1×1褶积组成)的组合进行编码。然后,编码特征由CBR块进行处理,该块由3×3卷积与BN层和ReLU激活函数组成。通过上述步骤,编码特征“Xin”被输入到码本中。为此,我们使用一组比例因子s按照顺序地使xi和bk映射相应的位置信息。整个图像的信息关于第k个码字可以通过以下方式计算:

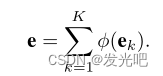

中,xi是第i个像素点,bk是第k个可学习的视觉码字,sk是第k种比例因子。 xi− bk是关于相对于码字的每个像素位置的信息。K是视觉中心的总数。之后,我们使用φ融合所有ek,其中φ包含BN层和ReLU层以及平均池化层。基于此,整个图像相对于K个码字的完整信息计算如下。

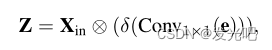

在获得码本的输出后,我们进一步将e送到全连接层和1×1卷积层,以预测突出关键类的特征。之后,我们使用Stem块Xin的输入特征与缩放因子系数δ之间的逐通道乘法。

上述过程表示为

δ(·) 是sigmoid函数

在从Stem块输出的特征Xin和局部角区域特征Z之间执行信道相加,其公式为:

⊕ 是通道加法

⊕ 是通道加法

C. Global Centralized Regulation (GCR)

EVC是一种广义的层内特征调节方法,它不仅可以提取全局长距离相关性,而且可以尽可能地保留输入图像的局部角点区域信息,这对于密集预测任务非常重要。然而,在特征金字塔的每一级使用EVC将导致大量的计算开销。

为了提高层内特征调整的计算效率,我们进一步以自顶向下的方式提出了一种特征金字塔的GCR。具体而言,如图2所示,考虑到最深的特征通常包含最抽象的特征表示,这在浅层特征中是罕见的,我们的空间EVC首先在特征金字塔的顶层(即X4)上实现。然后,使用所获得的包括空间显式视觉中心的特征X来同时调节所有额叶浅特征(即X3至X2)。在我们的实现中,在每个对应的低层特征上,将在深层中获得的特征上采样到与低层特征相同的空间尺度,然后沿信道维度进行连接。在此基础上,通过1×1卷积将级联特征下采样为256的信道大小。通过这种方式,我们能够显式地增加自顶向下路径中特征金字塔每一层的全局表示的空间权重,从而我们的CFP可以有效地实现全面但有区别的特征表示。

IV. EXPERIMENTS

在这项工作中,使用MS-COCO来验证我们提出的CFP的优越性。在我们的实验中,为了公平比较,所有的训练图像都被调整为640×640的固定大小。为了增强数据,我们在实验中采用了常用的Mosaic和MixUp。

评估指标。我们主要遵循实验中常用的目标检测评估指标——平均精度(AP),包括AP50、AP75、APS、APM和APL。此外,为了量化模型效率,还使用了GFLOP、每秒帧数(FPS)、延迟和参数(参数)。特别是,延迟和FPS在没有进行后处理的情况下进行测量,以便进行公平比较。

为了公平比较,我们选择YOLOv5(即修改的CSPNet v5)作为骨干网络。输出的特征图是第5阶段的特征图,它包括三个卷积(Conv、BN和SiLU[61])操作和一个空间金字塔池[62]层(5×5、9×9和13×13)。