《BLOOM: A 176B-Parameter Open-Access Multilingual Language Model》

论文地址: https://arxiv.org/pdf/2211.05100.pdf

代码地址: transformers库-modeling_bloom.py

BigScience 官方提供的代码链接并没有找到完整的模型实现代码,只有提示说模型结构代码是在 Megatron 的 GPT-2 代码基础上修改的。

BLOOM模型结构

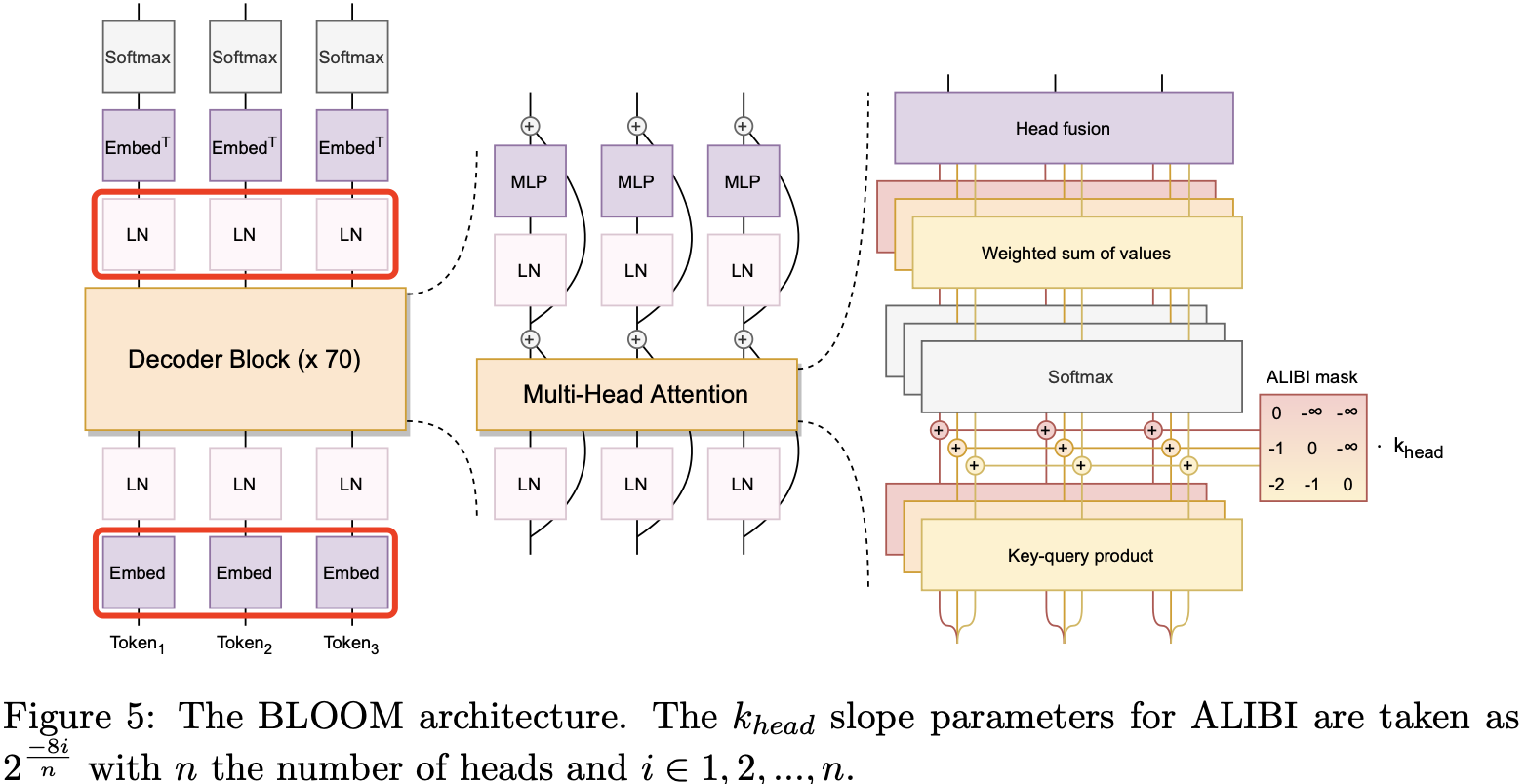

BLOOM 的完整架构图

BLOOM 模型也是 Decoder-only 架构,但和原始 transformer-decoder 结构有所区别,上图红色框框出来的是 两个优化地方,具体来说:

- ALiBi Positional Embeddings。ALiBi 位置嵌入不是向嵌入层添加位置信息,而是根据键和查询的距离直接衰减注意力分数。尽管作者最初的动机是其推断更长序列的能力,但后来发现即使在原始序列长度下,它也能带来更平滑的训练和更好的下