点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

Tracking Everything Everywhere All at Once.

前段时间,Meta 发布「分割一切(SAM)」AI 模型,可以为任何图像或视频中的任何物体生成 mask,让计算机视觉(CV)领域研究者惊呼:「CV 不存在了」。之后,CV 领域掀起了一阵「二创」狂潮,一些工作陆续在分割的基础上结合目标检测、图像生成等功能,但大部分研究是基于静态图像的。

现在,一项称为「追踪一切」的新研究为动态视频中的运动估计提出了新方法,能够准确、完整地追踪物体的运动轨迹。

该研究由来自康奈尔大学、谷歌研究院和 UC 伯克利的研究者共同完成。他们联合提出了一种完整且全局一致的运动表征 OmniMotion,并提出一种新的测试时(test-time)优化方法,对视频中每个像素进行准确、完整的运动估计。

欢迎加入CVer计算机视觉知识星球!每天更新最新最前沿的AI论文、项目,扫描下方二维码,即可加入学习!

论文地址:https://arxiv.org/abs/2306.05422

项目主页:https://omnimotion.github.io/

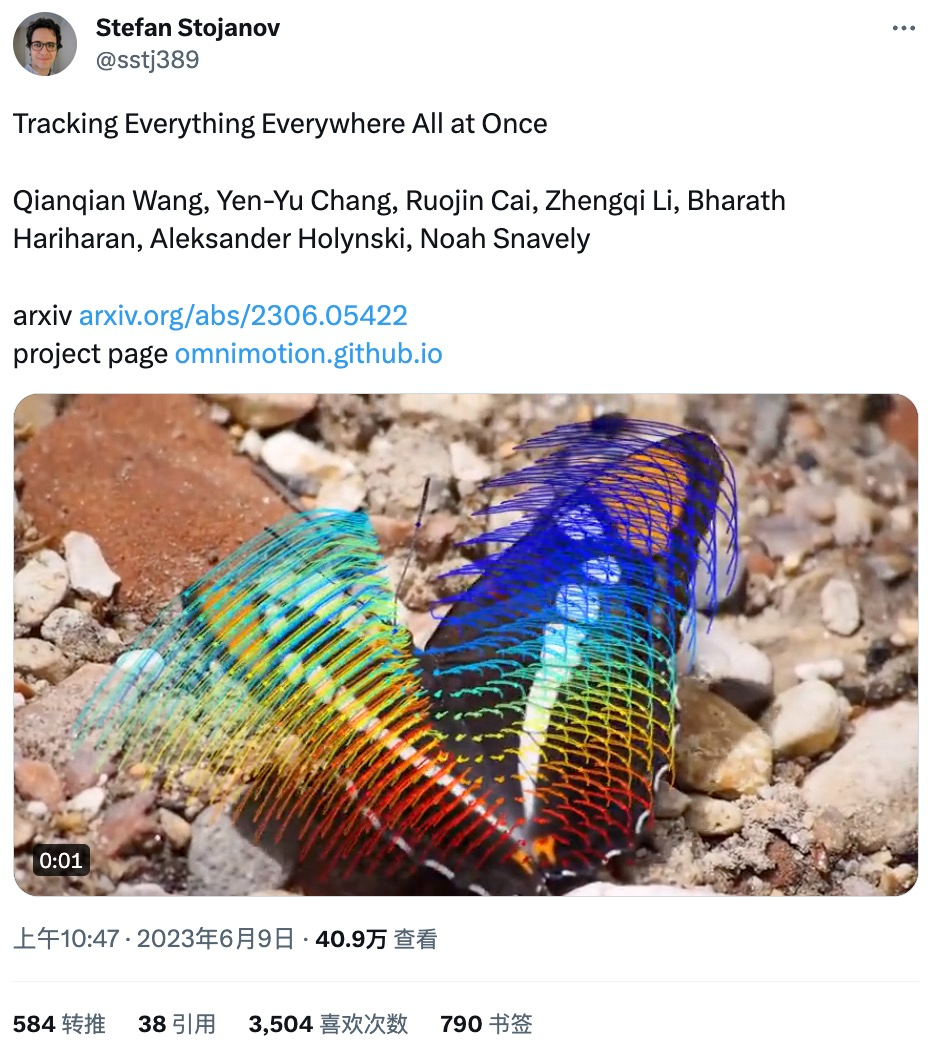

有网友在推特上转发了这项研究,仅一天时间就收获了 3500 + 的点赞量,研究内容大受好评。

从该研究发布的 demo 看,运动追踪的效果非常好,例如追踪跳跃袋鼠的运动轨迹:

荡秋千的运动曲线:

还能交互式查看运动追踪情况:

即使物体被遮挡也能追踪运动轨迹,如狗在跑动的过程中被树遮挡:

在计算机视觉领域,常用的运动估计方法有两种:稀疏特征追踪和密集光流。但这两种方法各有缺点,稀疏特征追踪不能建模所有像素的运动;密集光流无法长时间捕获运动轨迹。

该研究提出的 OmniMotion 使用 quasi-3D 规范体积来表征视频,并通过局部空间和规范空间之间的双射(bijection)对每个像素进行追踪。这种表征能够保证全局一致性,即使在物体被遮挡的情况下也能进行运动追踪,并对相机和物体运动的任何组合进行建模。该研究通过实验表明所提方法大大优于现有 SOTA 方法。

方法概述

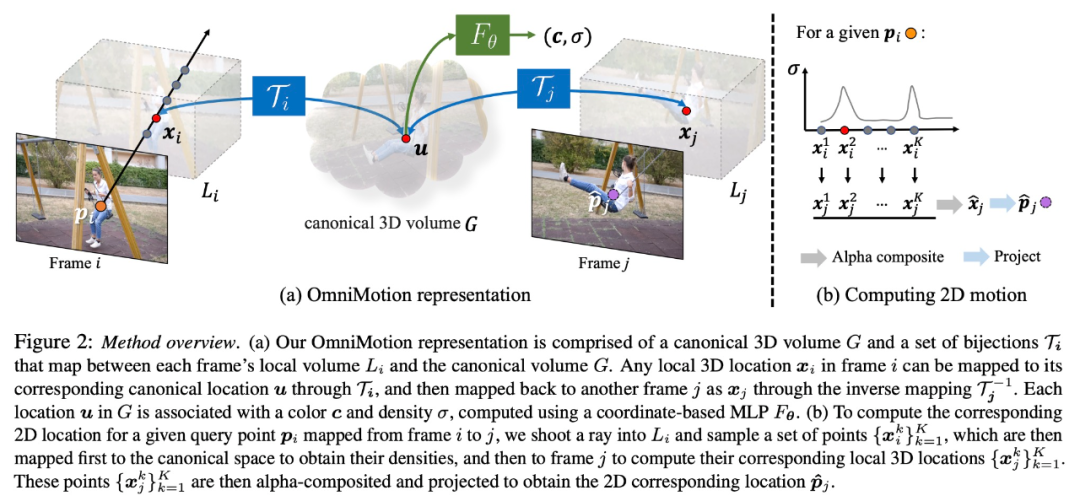

该研究将帧的集合与成对的噪声运动估计(例如光流场)作为输入,以形成整个视频的完整、全局一致的运动表征。然后,该研究添加了一个优化过程,使其可以用任何帧中的任何像素查询表征,以在整个视频中产生平滑、准确的运动轨迹。值得注意的是,该方法可以识别画面中的点何时被遮挡,甚至可以穿过遮挡追踪点。

OmniMotion 表征

传统的运动估计方法(例如成对光流),当物体被遮挡时会失去对物体的追踪。为了在遮挡的情况下也能提供准确、一致的运动轨迹,该研究提出全局运动表征 OmniMotion。

该研究试图在没有显式动态 3D 重建的情况下准确追踪真实世界的运动。OmniMotion 表征将视频中的场景表示为规范的 3D 体积,通过局部规范双射(local-canonical bijection)映射成每个帧中的局部体积。局部规范双射被参数化为神经网络,并在不分离两者的情况下捕获相机和场景运动。基于此种方法,视频可以被视为来自固定静态相机局部体积的渲染结果。

由于 OmniMotion 没有明确区分相机和场景运动,所以形成的表征不是物理上准确的 3D 场景重建。因此,该研究称其为 quasi-3D 表征。

OmniMotion 保留了投影到每个像素的所有场景点的信息,以及它们的相对深度顺序,这让画面中的点即使暂时被遮挡,也能对其进行追踪。

实验及结果

定量比较

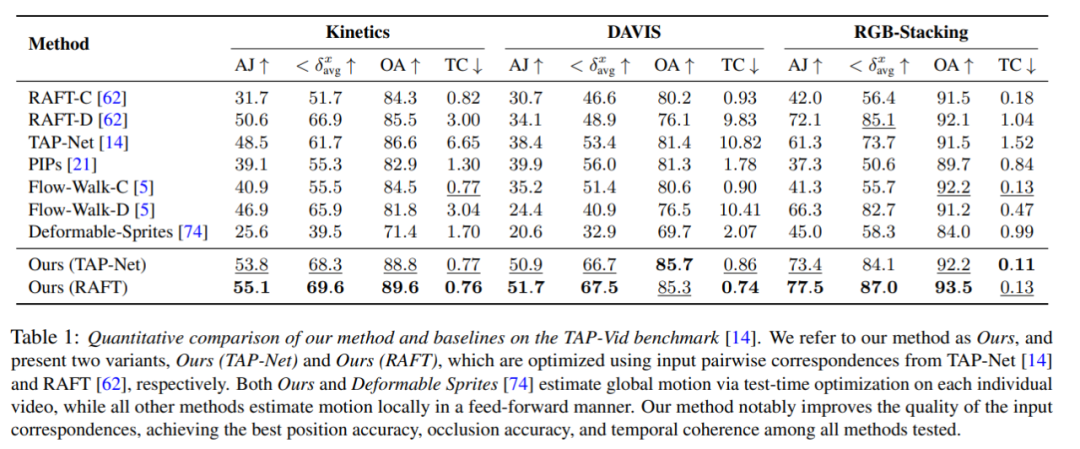

研究者将提出的方法与 TAP-Vid 基准进行比较,结果如表 1 所示。可以看出,在不同的数据集上,他们的方法始终能实现最佳的位置准确性、遮挡准确性和时序一致性。他们的方法可以很好地处理来自 RAFT 和 TAP-Net 的不同的成对对应输入,并且在这两种基准方法上提供了一致的改进。

定性比较

如图 3 所示,研究者对他们的方法和基线方法进行了定性比较。新方法在(长时间)遮挡事件中显示出了出色的识别和追踪的能力,同时在遮挡期间为点提供合理的位置,并处理很大的摄像机运动视差。

消融实验与分析

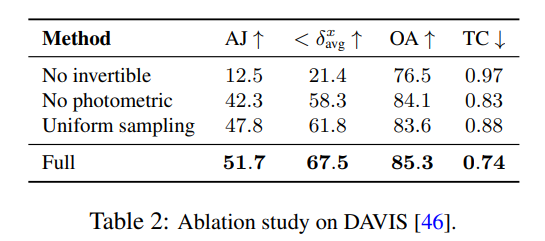

研究者利用消融实验来验证他们设计决策的有效性,结果如表 2 所示。

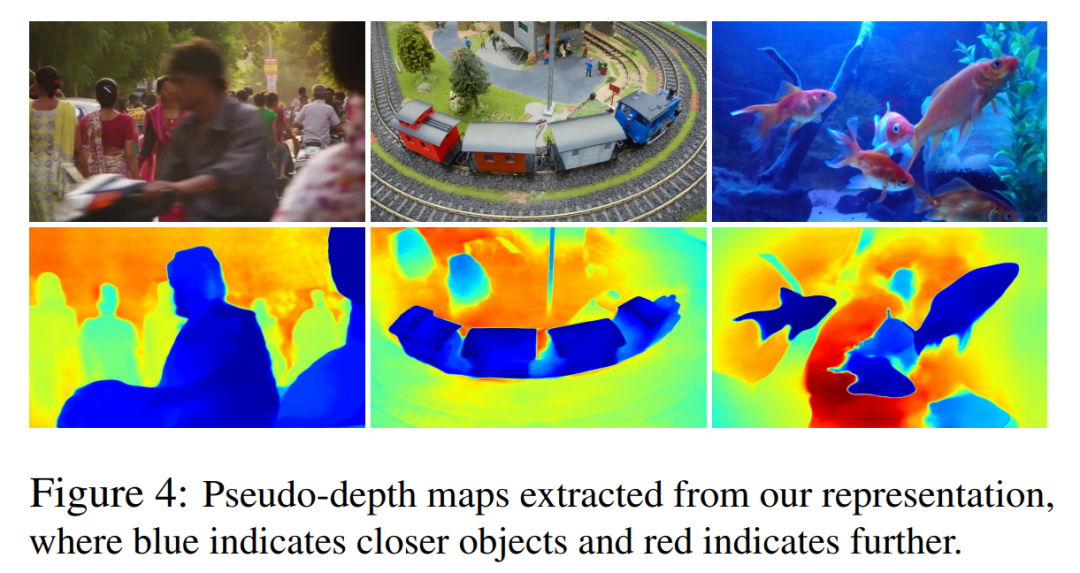

在图 4 中,他们展示了由他们的模型生成的伪深度图,以展示学习到的深度排序。

需要注意的是,这些图并不对应于物理深度,然而,它们展示了仅使用光度和光流信号时,新方法能够有效地确定不同表面之间的相对顺序,这对于在遮挡中进行追踪至关重要。更多的消融实验和分析结果可以在补充材料中找到。

最新CVPR 2023论文和代码下载

后台回复:CVPR2023,即可下载CVPR 2023论文和代码开源的论文合集

后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

目标跟踪和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer333,即可添加CVer小助手微信,便可申请加入CVer-目标跟踪或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

一定要备注:研究方向+地点+学校/公司+昵称(如目标跟踪或者ransformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信号: CVer333,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉,已汇集数千人!

▲扫码进星球

▲点击上方卡片,关注CVer公众号整理不易,请点赞和在看![]()