一、Docker 网络实现原理

- Docker使用Linux桥接,在宿主机虚拟一个Docker容器网桥(docker0),Docker启动一个容器时会根据Docker网桥的网段分配给容器一个IP地址,称为Container-IP,同时Docker网桥是每个容器的默认网关。因为在同一宿主机内的容器都接入同一个网桥,这样容器之间就能够通过容器的 Container-IP 直接通信

简单来说:

- docker0是安装docker就自动有的一个容器的虚拟网关

- docker0是容器的网关,绑定物理网卡,负责做NAT地址转换、端口映射

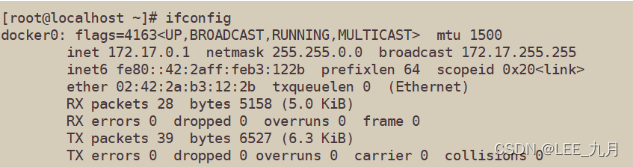

- 使用ifconfig可以查看

[root@localhost ~]# ifconfig

docker0: flags=4099<UP,BROADCAST,MULTICAST> mtu 1500

inet 172.17.0.1 netmask 255.255.0.0 broadcast 172.17.255.255

inet6 fe80::42:2aff:feb3:122b prefixlen 64 scopeid 0x20<link>

ether 02:42:2a:b3:12:2b txqueuelen 0 (Ethernet)

RX packets 0 bytes 0 (0.0 B)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 2 bytes 180 (180.0 B)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

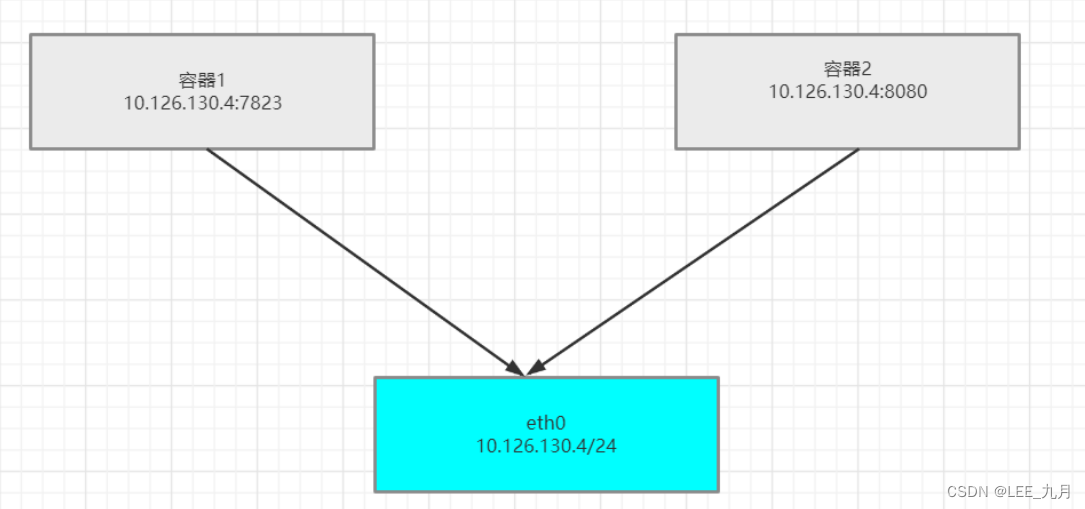

- Docker网桥是宿主机虚拟出来的,并不是真实存在的网络设备,外部网络是无法寻址到的,这也意味着外部网络无法直接通过 Container-IP 访问到容器。如果容器希望外部访问能够访问到,可以通过映射容器端口到宿主主机(端口映射),即 docker run 创建容器时候通过 -p 或 -P 参数来启用,访问容器的时候就通过[宿主机IP]:[容器端口]访问容器

#例:

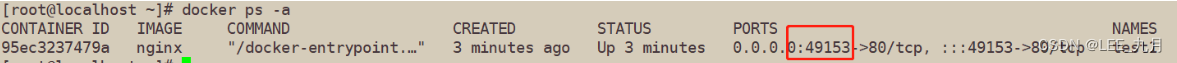

[root@localhost ~]# docker run -d --name test1 -P nginx #大写p随机映射端口(从32768开始)

[root@localhost ~]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

95ec3237479a nginx "/docker-entrypoint.…" 6 seconds ago Up 6 seconds 0.0.0.0:49153->80/tcp, :::49153->80/tcp test1

浏览器访问测试 192.168.113.127:49153

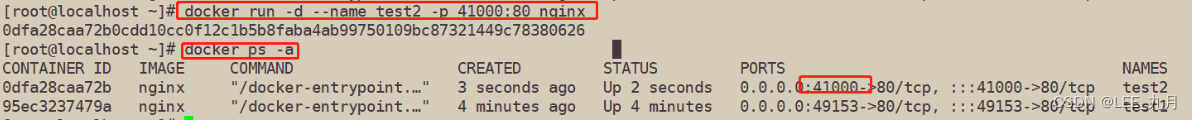

[root@localhost ~]# docker run -d --name test2 -p 41000:80 nginx #小写p指定映射端口

[root@localhost ~]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

0dfa28caa72b nginx "/docker-entrypoint.…" 3 seconds ago Up 2 seconds 0.0.0.0:41000->80/tcp, :::41000->80/tcp test2

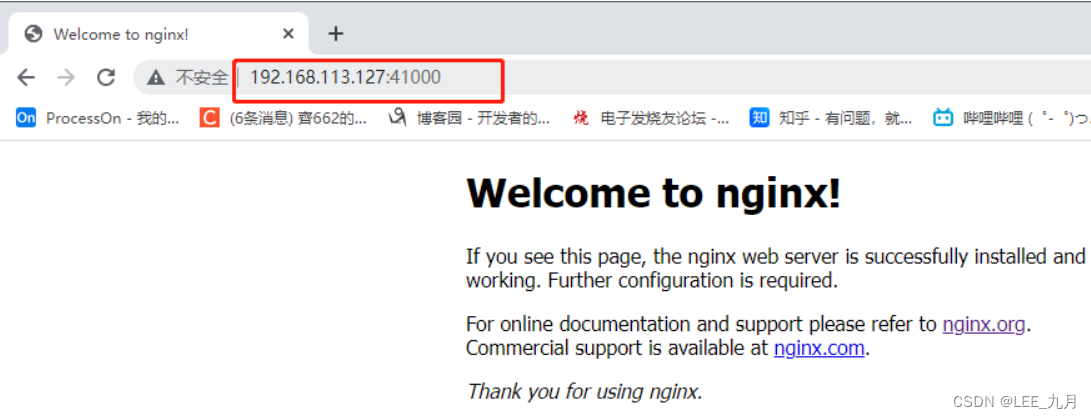

浏览器访问测试 192.168.113.127:41000

二、Docker 的网络模式

| 网络模式 | 说明 |

|---|---|

| Host | 容器将不会虚拟出自己的网卡,配置自己的IP等,而是使用宿主机的IP和端口 |

| Container | 创建的容器不会创建自己的网卡,配置自己的IP,而是和一个指定的容器共享IP、端口范围 |

| None | 该模式关闭了容器的网络功能 |

| Bridge | 默认为该模式,此模式会为每一个容器分配、设置IP等,并将容器连接到一个docker0虚拟网桥,通过docker0网桥以及iptables nat 表配置与宿主机通信 |

| 自定义网络 | 都是自己定 |

1.安装Docker时,它会自动创建三个网络,bridge(创建容器默认连接到此网络)、 none 、host

#查看docker网络列表

[root@localhost ~]# docker network ls #方法一

NETWORK ID NAME DRIVER SCOPE

8634fd81aada bridge bridge local

686fa85148f5 host host local

6b205bc8ef67 none null local

[root@localhost ~]# docker network list #方法二

NETWORK ID NAME DRIVER SCOPE

8634fd81aada bridge bridge local

686fa85148f5 host host local

6b205bc8ef67 none null local

2.使用docker run创建Docker容器时,可以用 --net 或 --network 选项指定容器的网络模式

| 网络模式 | 指定网络模式命令 |

|---|---|

| host模式 | 使用 --net=host 指定 |

| none模式 | 使用 --net=none 指定 |

| container模式 | 使用 --net=container:NAME_or_ID 指定 |

| bridge模式 | 使用 --net=bridge 指定,默认设置,可省略 |

3.网络模式详细解释

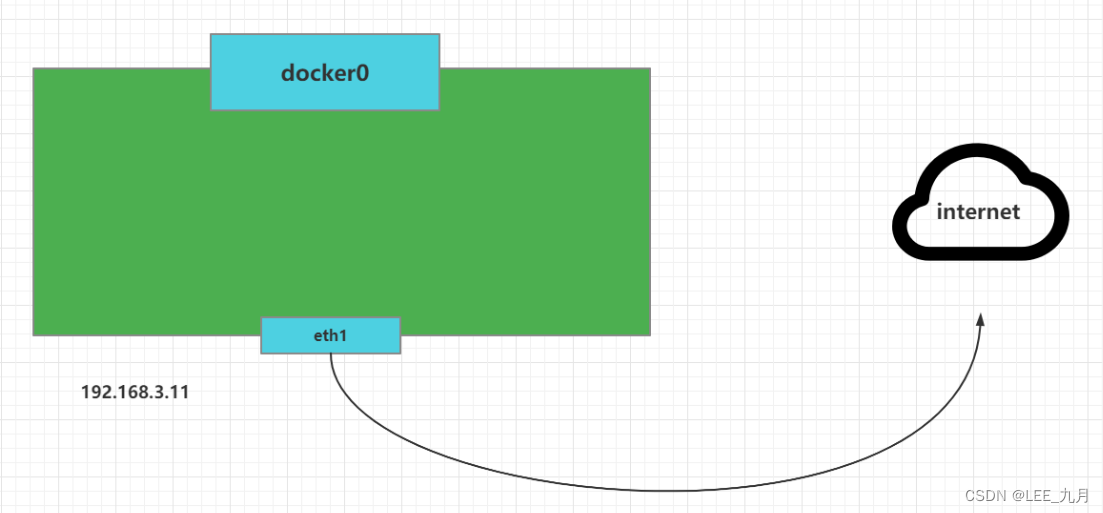

3.1 host 模式

-

host 容器将不会虚拟出自己的网卡,配置自己的IP等,而是使用宿主机的IP和端口

-

如果启动容器的时候使用host 模式,那么这个容器将不会获得一个独立的 Network Namespace,而是和宿主机共用一个 Network Namespace,容器将不会虚拟出自己的网卡,配置自己的IP等而是使用宿主机的IP和端口,但是容器的其他方面,如文件系统,进程列表还是和宿主机隔离的

-

使用host模式的容器可以直接使用宿主机的IP地址与外界通信,容器内部的服务器端口也可以使用宿主机的端口,不需要进行 NAT,host最大的优势就是网络性能比较好,但是docker host上已经使用的端口就不能再用了,网络的隔离性不好

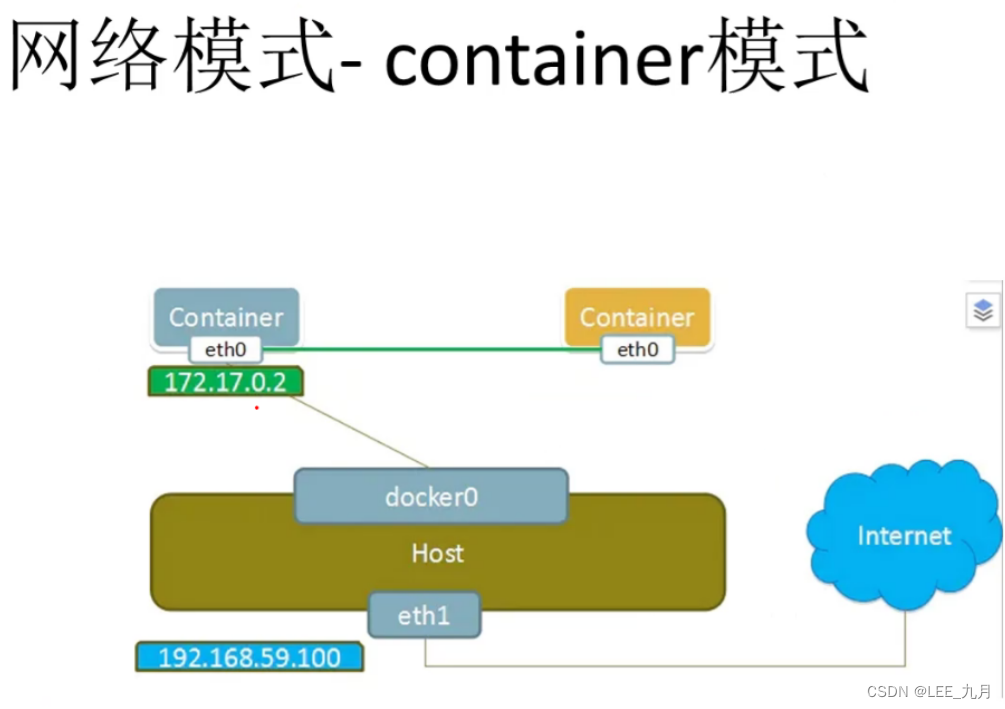

3.2 container 模式

- 创建的容器不会创建自己的网卡,设置IP 等,而是和一个指定的容器共享 IP,端口范围

- 这个模式指定新建的容器和已经存在的一个容器共享一个 network namespace,而不是和宿主机共享,新创建的容器不会创建自己的网卡,配置自己的 IP,而是和一个指定的容器共享IP,端口范围等,同样,两个容器除了网络方面,其他的如文件系统,进程列表还是隔离的

- 两个容器的进程可以通过lo网卡设备通讯信

#实例操作实验:

[root@nginx1 opt]# docker run -itd --name test1 centos:7 /bin/bash #--name选项可以给容器创建一个自定义名称

[root@nginx1 opt]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

35950288a708 centos:7 "/bin/bash" 22 seconds ago Up 21 seconds test1

[root@nginx1 opt]# docker inspect -f '{

{.State.Pid}}' 35950288a708 #查看容器进程号

[root@nginx1 opt]# ls -l /proc/28643/ns #查看容器的进程,网络,文件系统等命名空间编号

总用量 0

lrwxrwxrwx 1 root root 0 9月 6 19:23 ipc -> ipc:[4026532527]

lrwxrwxrwx 1 root root 0 9月 6 19:23 mnt -> mnt:[4026532525]

lrwxrwxrwx 1 root root 0 9月 6 19:21 net -> net:[4026532530]

lrwxrwxrwx 1 root root 0 9月 6 19:23 pid -> pid:[4026532528]

lrwxrwxrwx 1 root root 0 9月 6 19:23 user -> user:[4026531837]

lrwxrwxrwx 1 root root 0 9月 6 19:23 uts -> uts:[4026532526]

[root@nginx1 opt]# docker run -itd --name test2 --net=container:35950288a708 centos:7 /bin/bash

[root@nginx1 opt]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

29a672517519 centos:7 "/bin/bash" About a minute ago Up About a minute test2

[root@nginx1 opt]# docker inspect -f '{

{.State.Pid}}' 29a672517519

[root@nginx1 opt]# ls -l /proc/28960/ns #查看可以发现两个容器的 net namespace 编号相同

总用量 0

lrwxrwxrwx 1 root root 0 9月 6 19:30 ipc -> ipc:[4026532622]

lrwxrwxrwx 1 root root 0 9月 6 19:30 mnt -> mnt:[4026532620]

lrwxrwxrwx 1 root root 0 9月 6 19:30 net -> net:[4026532530]

lrwxrwxrwx 1 root root 0 9月 6 19:30 pid -> pid:[4026532623]

lrwxrwxrwx 1 root root 0 9月 6 19:30 user -> user:[4026531837]

lrwxrwxrwx 1 root root 0 9月 6 19:30 uts -> uts:[4026532621]

3.3 none模式

- 使用none模式,Docker容器拥有自己的Network Namespace,但是,并不为Docker容器进行任何网络配置。 也就是说,这个Docker容器没有网卡、IP、路由等信息。这种网络模式下容器只有lo回环网络,没有其他网卡。这种类型的网络没有办法联网,封闭的网络能很好的保证容器的安全性

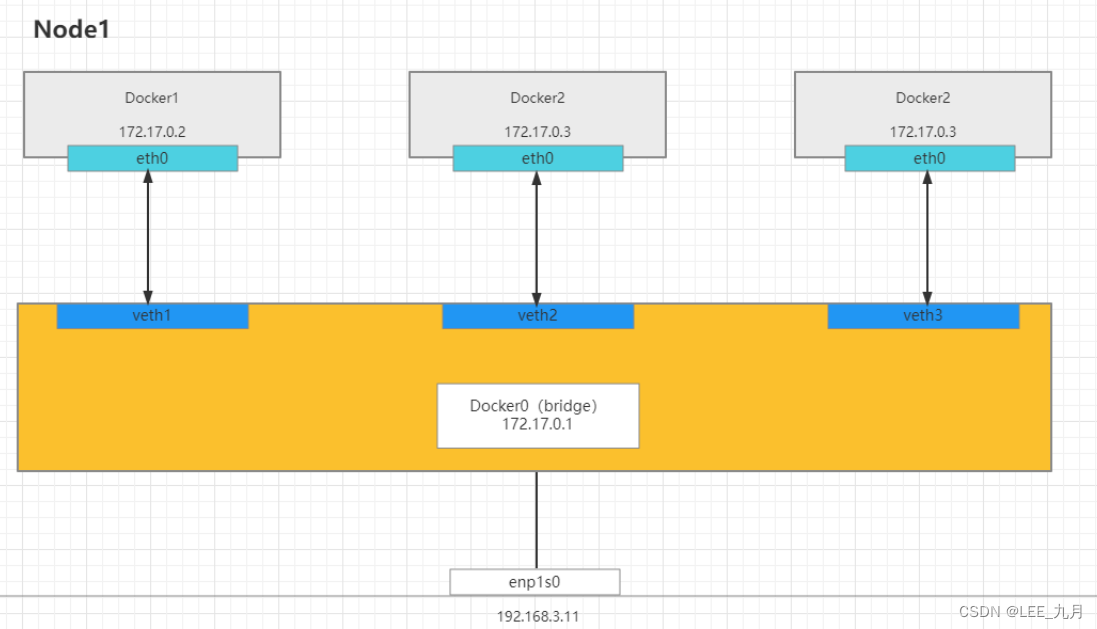

3.4 Bridge模式

- bridge模式是docker的默认网络模式,不写–net参数,就是bridge模式

相当于Vmware中的 nat 模式,容器使用独立network Namespace,并连接到docker0虚拟网卡。通过docker0网桥以及iptables nat表配置与宿主机通信,此模式会为每一个容器分配Network Namespace、设置IP等,并将一个主机上的 Docker 容器连接到一个虚拟网桥上

(1)当Docker进程启动时,会在主机上创建一个名为docker0的虚拟网桥,此主机上启动的Docker容器会连接到这个虚拟网桥上。虚拟网桥的工作方式和物理交换机类似,这样主机上的所有容器就通过交换机连在了一个二层网络中

(2)从docker0子网中分配一个IP给容器使用,并设置docker0的IP地址为容器的默认网关。在主机上创建一对虚拟网卡veth pair设备。veth设备总是成对出现的,它们组成了一个数据的通道,数据从一个设备进入,就会从另一个设备出来。因此,veth设备常用来连接两个网络设备

(3)Docker将veth pair 设备的一端放在新创建的容器中,并命名为eth0(容器的网卡),另一端放在主机中, 以veth*这样类似的名字命名,并将这个网络设备加入到docker0网桥中。可以通过 brctl show 命令查看

(4)使用 docker run -p 时,docker实际是在iptables做了DNAT规则,实现端口转发功能。可以使用iptables -t nat -vnL 查看

3.5自定义网络

#直接使用bridge,无法支持指定IP运行docker

docker run -itd --name test1 --network bridge --ip 172.17.0.10 centos:7 /bin/bash

#1.创建自定义网络

#可以先自定义网络,再使用指定IP运行docker

[root@nginx1 opt]# docker network create --subnet=172.18.0.0/16 --opt "com.docker.network.bridge.name"="docker1" mynetwork

#docker1为执行ifconfig -a命令时,显示的网卡名,如果不使用--opt参数指定此名称,那你在使用ifconfig-a命令查看网络信总时,看到的是类似br-110eb56a0b22这样的名字,这显然不怎么好记

#mynetwork为执行docker network list命令时,显示的oridgek网络模式名称

#查看是否创建成功

[root@nginx1 opt]# ifconfig

docker1: flags=4099<UP,BROADCAST,MULTICAST> mtu 1500

inet 172.18.0.1 netmask 255.255.0.0 broadcast 172.18.255.255

ether 02:42:52:ab:85:af txqueuelen 0 (Ethernet)

RX packets 0 bytes 0 (0.0 B)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 0 bytes 0 (0.0 B)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

#再次创建就不会出错了

[root@nginx1 opt]# docker run -itd --name test5 --net mynetwork --ip 172.18.0.10 centos:7 /bin/bash

ps:overlay 叠加网络

ip/mac vlan 虚拟MAC地址

三、资源控制

1.CPU 资源控制

-

cgroups,是一个非常强大的linux内核工具,他不仅可以限制被 namespace 隔离起来的资源, 还可以为资源设置权重、计算使用量、操控进程启停等等。 所以 cgroups( Control groups) 实现了对资源的配额和度量

-

cgroups有四大功能:

| 功能 | 说明 |

|---|---|

| 资源限制 | 可以对任务使用的资源总额进行限制 |

| 优先级分配 | 通过分配的cpu时间片数量以及磁盘IO带宽大小,实际上相当于控制了任务运行优先级 |

| 资源统计 | 可以统计系统的资源使用量,如cpu时长,内存用量等 |

| 任务控制 | cgroup可以对任务执行挂起、恢复等操作 |

1.1设置CPU使用率上限

-

Linux 通过 CFS(Completely Fair Scheduler,完全公平调度器)来调度各个进程对 CPU 的使用。CFS 默认的调度周期是 100ms

-

我们可以设置每个容器进程的调度周期,以及在这个周期内各个容器最多能使用多少 CPU 时间

-

使用 --cpu-period 即可设置调度周期,使用 --cpu-quota 即可设置在每个周期内容器能使用的 CPU 时间。两者可以配合使用

CFS 周期的有效范围是 1ms~1s,对应的 --cpu-period 的数值范围是 1000~100000

而容器的 CPU配额必须不小于 1ms,即 --cpu-quota 的值必须 >= 1000

#1.查看CPU使用率

[root@nginx1 opt]# docker run -itd --name test3 centos:7 /bin/bash

[root@nginx1 opt]# docker ps -a

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

7211583c640c centos:7 "/bin/bash" 45 seconds ago Up 44 seconds test3

[root@nginx1 opt]# cd/sys/fs/cgroup/cpu/docker/7211583c640c37beb5079f67f6e3657e3628ba8b8dde388ea69697532b155fe4/

[root@nginx1 7211583c640c37beb5079f67f6e3657e3628ba8b8dde388ea69697532b155fe4]# cat cpu.cfs_quota_us

-1

[root@nginx1 7211583c640c37beb5079f67f6e3657e3628ba8b8dde388ea69697532b155fe4]# cat cpu.cfs_period_us

100000

------------------------------------------------------------------------------------------------------------

#cpu.cfs_period_us:cpu分配的周期(微秒,所以文件名中用 us 表示),默认为100000

#cpu.cfs_quota_us:表示该control group限制占用的时间(微秒),默认为-1,表示不限制。 如果设为50000,表示占用50000/100000=50%的CPU

-----------------------------------------------------------------------------————————————————---------------

#2.进行CPU压力测试

[root@nginx1 docker]# docker exec -it 7211583c640c /bin/bash

[root@7211583c640c opt]# vim cpu.sh

#!/bin/bash

i=0

while true

do

let i++

done

[root@7211583c640c opt]# sh cpu.sh

#可再开启个终端查看

[root@nginx1 opt]# top #可以看到这个脚本占了很多的cpu资源

#3.设置CPU使用率

#设置50%的比例分配CPU使用时间上限

#可以重新创建一个容器并设置限额

docker run -itd --name test2 --cpu-quota 50000 centos:7 /bin/bash

或

[root@nginx1 ~]# echo 50000 > /sys/fs/cgroup/cpu/docker/7211583c640c37beb5079f67f6e3657e3628ba8b8dde388ea69697532b155fe4/cpu.cfs_quota_us

#进入容器在执行下脚本

[root@nginx1 docker]# docker exec -it 7211583c640c /bin/bash

[root@7211583c640c opt]# sh cpu.sh

#可再开启个终端查看

[root@nginx1 ~]# top #可以看到cpu占用率接近50%,cgroups对cpu的控制起了效果

1.2设置CPU资源占用比(设置多个容器时才有效)

Docker 通过–cpu-shares 指定 CPU 份额,默认值为1024,值为1024的倍数

#创建两个容器为 q1 和 q2,若只有这两个容器,设置容器的权重,使得q1和q2的CPU资源占比为1/3和2/3

[root@nginx1 ~]# docker run -itd --name q1 --cpu-shares 512 centos:7

[root@nginx1 ~]# docker run -itd --name q2 --cpu-shares 1024 centos:7

#分别进入容器,进行压力测试

[root@nginx1 ~]# docker exec -it q2 /bin/bash

[root@nginx1 ~]# docker exec -it q1 /bin/bash

#进入容器分别安装

[root@e631251e8a35 /]# yum install -y epel-release

[root@e631251e8a35 /]# yum install stress -y

[root@e631251e8a35 /]# stress -c 4

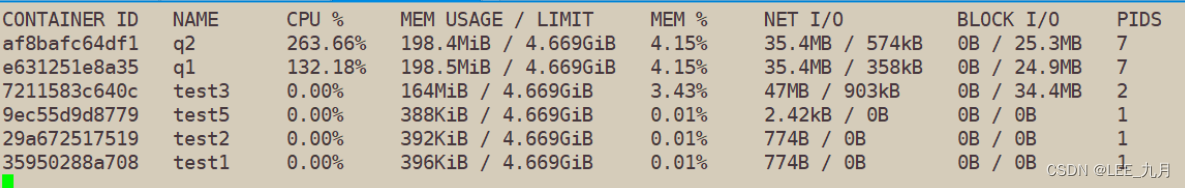

#查看容器运行状态(动态更新),因为我是4个CPU所以cpu值会这么大,正常的就是去掉前面百位数

[root@nginx1 /]# docker stats

CONTAINER ID NAME CPU % MEM USAGE / LIMIT MEM % NET I/O BLOCK I/O PIDS

af8bafc64df1 q2 242.36% 198.4MiB / 4.669GiB 4.15% 35.4MB / 574kB 0B / 25.3MB 7

e631251e8a35 q1 156.18% 198.5MiB / 4.669GiB 4.15% 35.4MB / 358kB 0B / 24.9MB 7

1.3设置容器绑定指定的CPU

#先分配虚拟机4个CPU核数

[root@nginx1 /]# docker run -itd --name q3 --cpuset-cpus 1,3 centos:7 /bin/bash

#进入容器,进行压力测试

[root@nginx1 /]# docker exec -it q3 bash

[root@53a585a0396c /]# yum install -y epel-release

[root@53a585a0396c /]# yum install -y stress

[root@53a585a0396c /]# stress -c 4

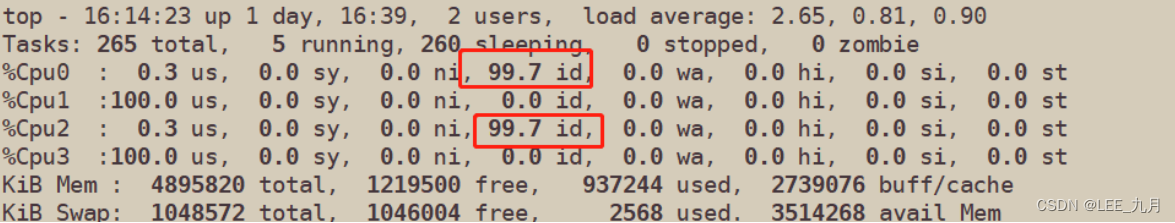

#退出容器,执行 top 命令再按 1 查看CPU使用情况

[root@nginx1 /]# top

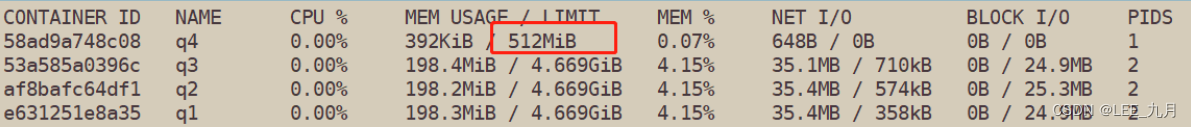

2.对内存使用的限制

[root@nginx1 /]# docker run -itd --name q4 -m 512m centos:7 /bin/bash

[root@nginx1 /]# docker stats

3.限制可用的 swap大小

强调一下 --memory-swap 是必须要与 --memory一起使用的

正常情况下 --memory-swap的值包含容器可用内存和可用swap

所以 -m 300m --memory-swap=1g 的含义为:容器可以使用 300M 的物理内存,并且可以使用700M(1G - 300)的 swap

如果 --memory-swap设置为 0 或者不设置,则容器可以使用的 swap 大小为 -m 值的两倍

如果 --memory-swap 的值和 -m 值相同,则容器不能使用 swap

如果 --memory-swap值为 -1,它表示容器程序使用的内存受限,而可以使用的 swap 空间使用不受限制(宿主机有多少 swap 容器就可以使用多少)

#例:首先你的宿主机要有swap

#--vm 1:启动1个内存工作线程

#--vm-bytes 200M:每个线程分配200M内存

#如果让工作线程分配的内存超过 1g,分配的内存超过了限额,stress线程会报错,容器退出

docker run -itd -m 300m --memory-swap=1g centos:7 --vm 1 --vm-byres 200

'注意!一旦容器Cgroup使用的内存超过了限制的容量,Linux内核就会尝试收回这些内存'

'如果仍旧无法控制内存使用在这个设置的范围之内,就会杀死该进程!

4.对磁盘IO配额控制(blkio)的限制

--device-read-bps:限制某个设备上的读速度bps(数据量),单位可以是kb、mb(M)或者gb。

例:docker run -itd --name test4 --device-read-bps /dev/sda:1M centos:7 /bin/bash

--device-write-bps : 限制某个设备上的写速度bps(数据量),单位可以是kb、mb(M)或者gb

例:docker run -itd --name test5 --device-write-bps /dev/sda:1mb centos:7 /bin/bash

-----------------------------------------------------------------------

bps 是byte per second,每秒读写的数据量

iops是io per second,每秒IO的次数

可通过以下参数控制容器的bps 和iops:

-–device-read-bps ,限制读菜个设备的bps

-–device-write-bps,限制写某个设备的bps

-–device-read-iops,限制读某个设备的iops(次数)

-–device-write-iops,限制写入某个设备的iops(次数)

------------------------------------------------------------------------

#创建容器,并限制写速度

docker run -it --name test5 --device-write-bps /dev/sda:1mb centos:7 /bin/bash

#通过dd来验证写速度

dd if=/dev/zero of=test.out bs=1M count=10 oflag=direct #添加oflag参数以规避掉文件系统cache

10+0 records in

10+0 records out

10485760 bytes (10 MB) copied, 10.0025 s, 1.0 MB/s

#小知识:

#清理docker占用的磁盘空间

docker system prune -a

#可以用于清理磁盘,删除关闭的容器、无用的数据卷和网络