Docker-网络模式和资源控制

网络模式

原理

Docker使用Linux桥接,在宿主机虚拟一个Docker容器网桥(docker0),Docker启动一个容器时会根据Docker网桥的网段分配给容器一个IP地址,称为Container-IP,同时Docker网桥是每个容器的默认网关。因为在同一宿主机内的容器都接入同一个网桥,这样容器之间就能够通过容器的Container-IP直接通信。

Docker网桥是宿主机虚拟出来的,并不是真实存在的网络设备,外部网络是无法寻址到的,这也意味着外部网络无法通过直接Container-IP访问到容器。如果容器希望外部访问能够访问到,可以通过映射容器端口到宿主主机(端口映射),即docker run创建容器时候通过 -p 或 -P 参数来启用,访问容器的时候就通过[宿主机IP]:[容器端口]访问容器。

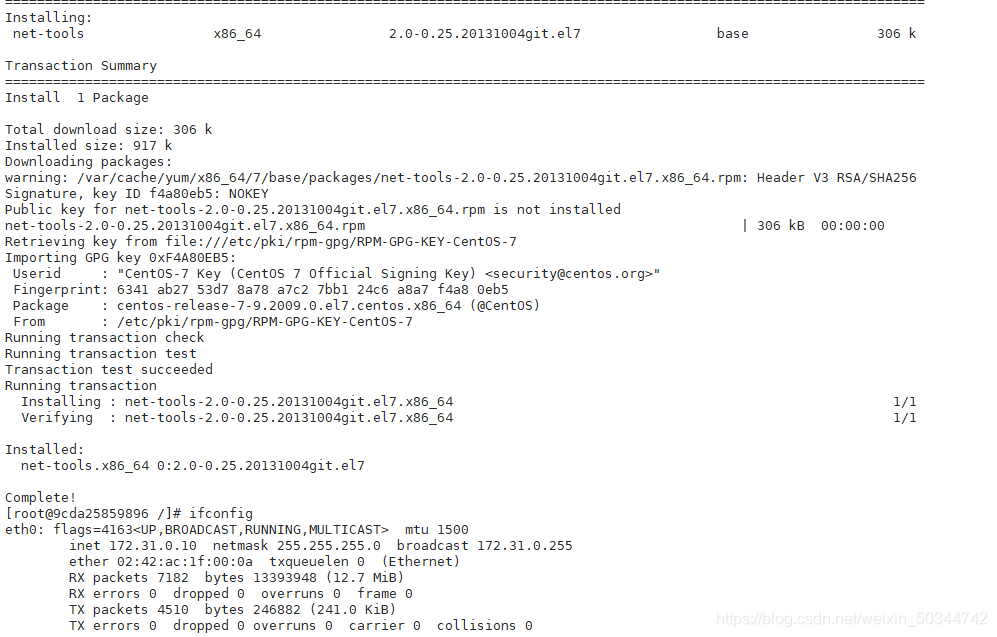

用ifconfig即可查询。

docker 0网络

docker 虚拟网关,在docker安装完成之后自动生成的虚拟网卡

loopback(lo):

回环网卡、TCP/IP主机连接性,网卡是否生效,检测本地是否可以通信,自我检测,虚拟化平台网卡

ens33:

虚拟机(宿主机)网络网卡

virtual bridge(virdr0):

linux自身继承了一个虚拟化功能(kvm架构) ,是原生架构的一个虚拟化平台,安装了一个虚拟化平台之后就会系统就会自动安装虚拟网卡

(示例:安装workstation (虚拟化平台) 之后,会在网络适配器中会多出VMnet1 VMnet8 VMnet0)

docker 0 :

容器的网关,绑定物理网卡,负责做NAT地址转换、端口映射

docker 0本身也是一种容器

四种网络模式

host

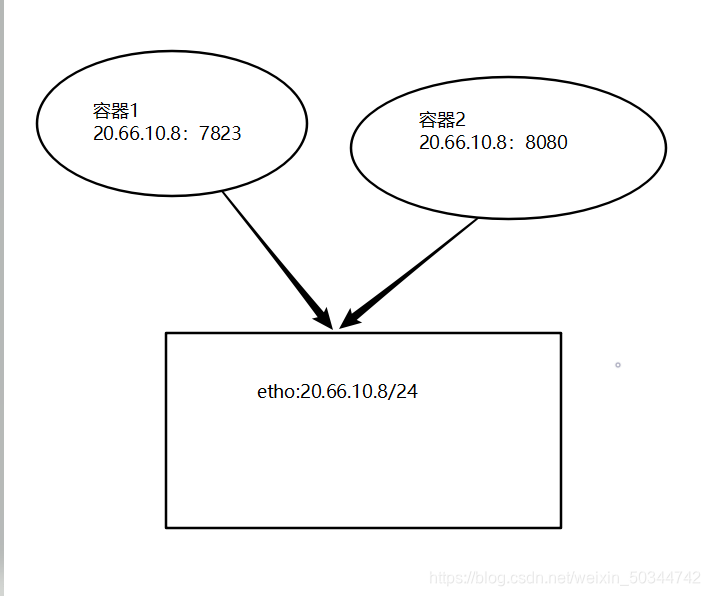

host容器将不会虚拟出自己的网卡,配置自己的IP等,而是使用宿主机的IP和端口。如果启动容器的时候使用host模式,那么这个容器将不会获得一个独立的Network Namespace(网络名称空间),而是和宿主机共用一个Network Namespace。容器将不会虚拟出自己的网卡,配置自己的IP等,而是使用宿主机的IP和端口。但是,容器的其他方面,如文件系统、进程列表等还是和宿主机隔离的。

使用host模式的容器可以直接使用宿主机的IP地址与外界通信,容器内部的服务端口也可以使用宿主机的端口,不需要进行NAT, host 最大的优势就是网络性能比较好,但是docker host上已经使用的端口就不能再用了,网络的隔离性不好。

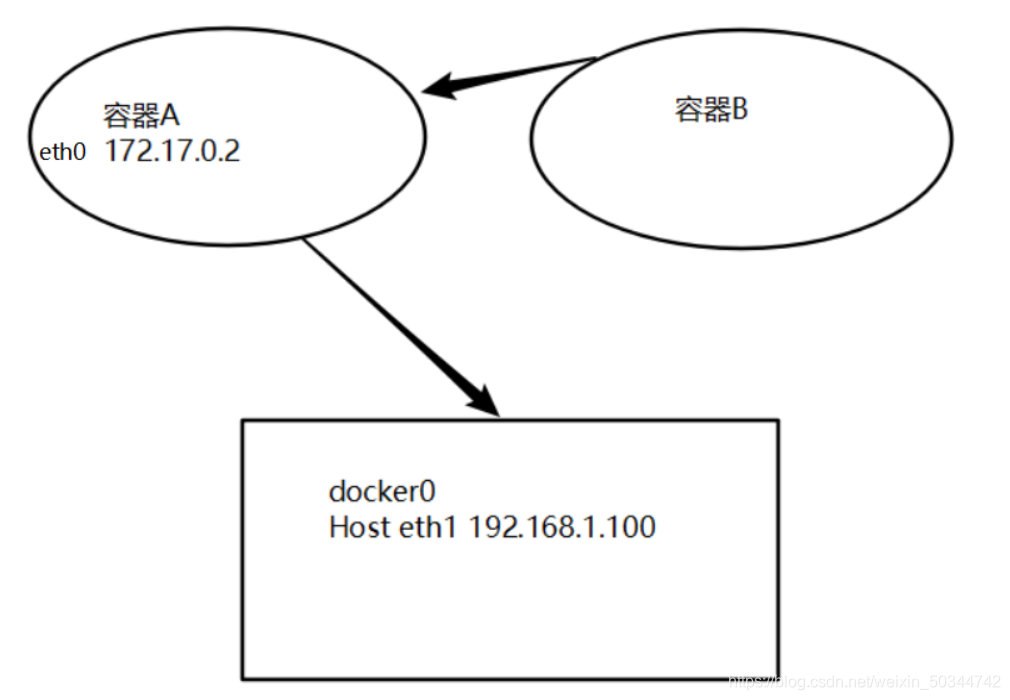

container

创建的容器不会创建自己的网卡、设置IP等,而是和一个指定地容器共享IP、端口范围。

这个模式指定新创建的容器和已经存在的一个容器共享一network namespace,而不是和宿主机共享,新创建的容器不会创建自己的网卡,配置自己的IP,而是和一个指定地容器共享IP、端口范围等。同样,两个容器除了网络方面,其他的如文件系统、进程列表还是隔离的。两个容器的进程可以通过loo网卡设备通信.

None

该模式关闭了容器的网络功能。这种网络模式下容器只有lo回环网口,没有其他的网卡。none 模式可以在容器创建时通过-network=none参数指定。这种类型的网络无法联网,但是封闭的网络能很好的保证容器的安全性,提高了安全性。

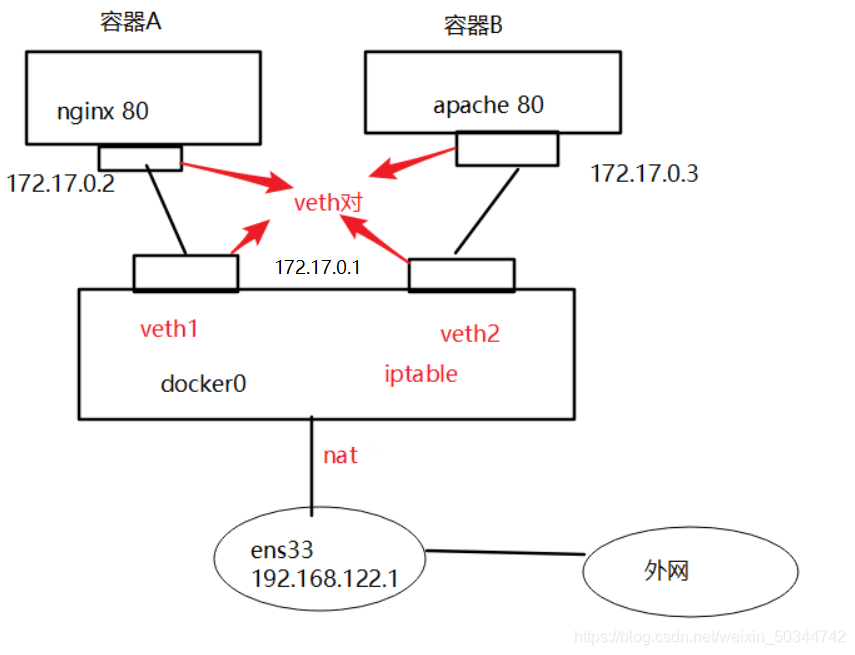

Bridge

此模式会为每一个容器分配、设置IP等,并将容器连接到一个docker虛拟网桥,通过docker0网桥及iptables的nat表配置与宿主机通信。

当Docker进程启动时,会在主机上创建一个名为docker0的虚拟网桥,此主机上启动的Docker容器会连接到这个虚拟网桥上。虚拟网桥的工作方式和物理交换机类似,这样主机上的所有容器就通过交换机连在了一个二层网络中。

从docker0子网中分配一个IP给容器使用,并设置docker0的IP地址为容器的默认网关。在主机上创建一对虚拟网卡veth pair设备,Docker将veth pair设备的一端挂载在新创建的容器中,并命名为ethO (容器的网卡),另一端放在主机中,以vethxxx这样类似的名字命名,并将这个网络设备加入到docker0网桥中。可以通过brctl show命令查看。

veth对:

成对出现的虚拟接口。用于连接两个虚拟网络环境或者用于连接两个不同的名称空间。veth对是以挂载的形式,挂载到两个名称空间的。

自定义网络

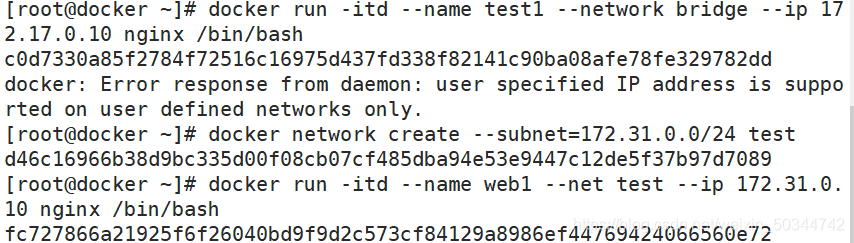

创建容器时默认使用的是桥接模式,但是使用bridge不支持为容器指定IP

docker run -itd --name test1 --network bridge --ip 172.17.0.10 nginx /bin/bash

docker network create --subnet=172.31.0.0/24 test #创建自定义网络test

docker run -itd --name web1 --net test --ip 172.31.0.10 nginx /bin/bash

查看

docker ps -a

docker exec -it 9cda25859896 /bin/bash #进入容器

yum -y install net-tools #安装软件以支持ifconfig

资源控制优化

CPU控制

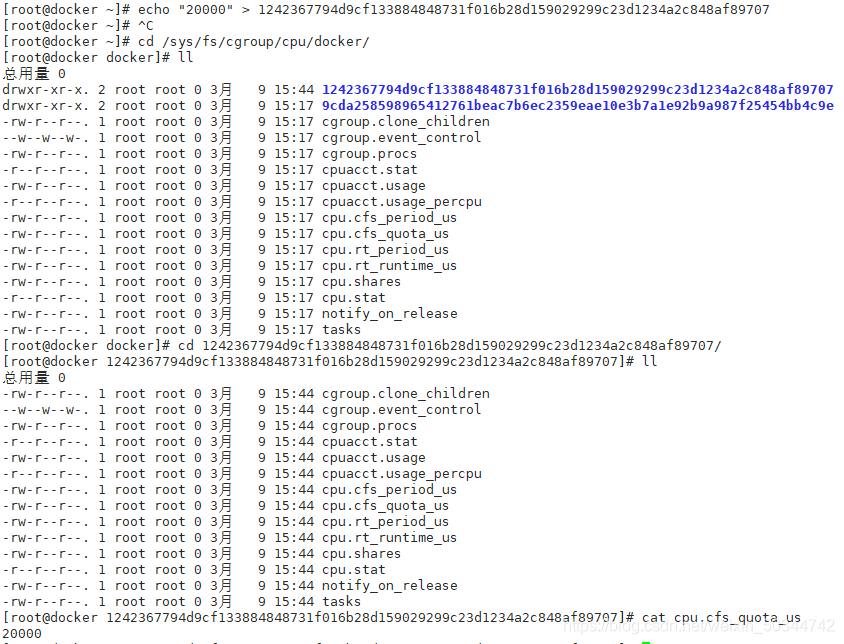

CPU的目录及使用率分配

cpu 周期:1s为一个周期的定律,参数值一般为100000(CPU衡量单位是秒)

假如需要给此容器分配cpu使用率的20%,则参数需要设置为20000,相当于每个周期分配给这个容器0.2s

cpu 在一个时刻,只能给一个进程占用

cat /sys/s/cgroup/cpu/docker/容器ID/cpu.cfs_quota_us

-1代表此容器可以使用得资源不受限制

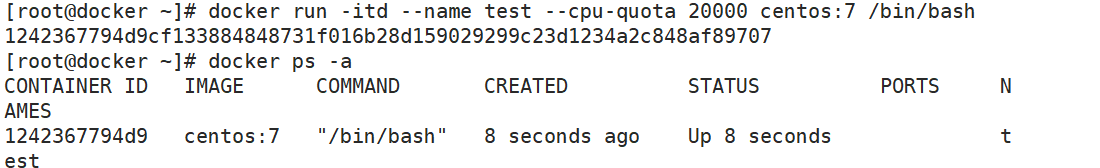

创建一个cpu使用率为20%的容器

方法一(未创建容器):

docker run -itd --name test --cpu-quota 20000 centos:7 /bin/bash

docker ps -a

方法二(已创建容器):

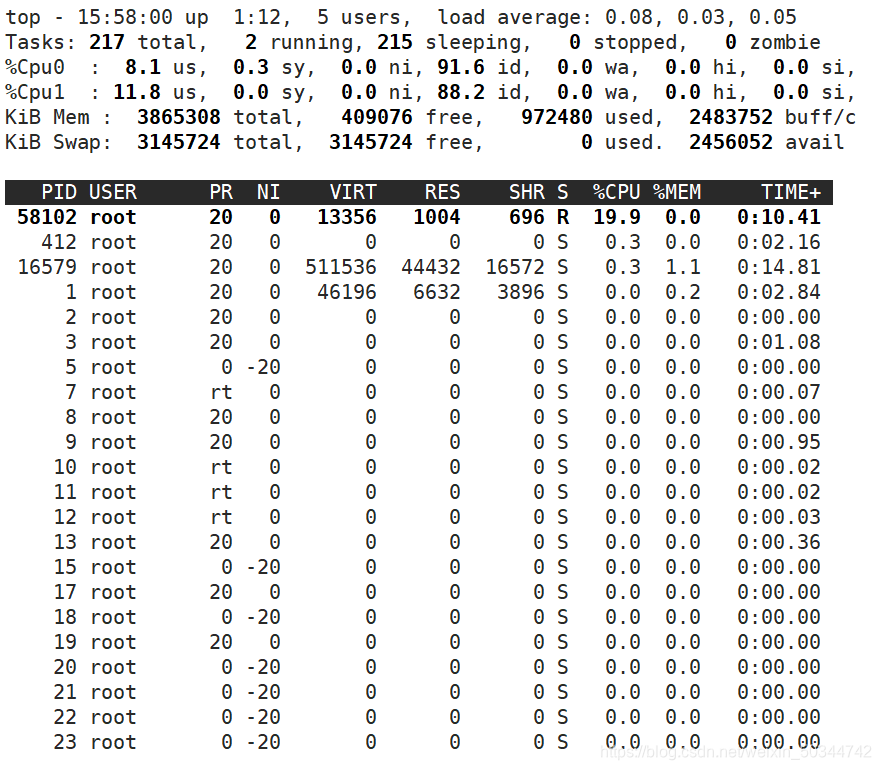

查看该容器的cpu占有率

echo "20000" > 1242367794d9cf133884848731f016b28d159029299c23d1234a2c848af89707

进入容器,运行一些操作

docker exec -it 1242367794d9 /bin/bash

yum -y install bc

echo "scale=5000;4*a(1)" | bc -l -q #运行计算圆周率

再开另开一个终端,运行top,(按“1”显示cpu详细信息)

CPU的权重设置

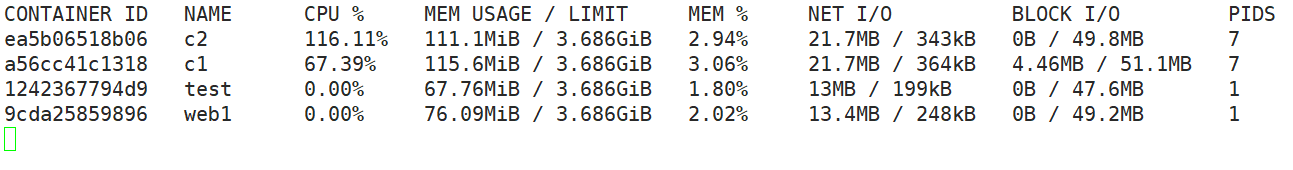

按比例分配 设置容器权重,此处权重是所有值相加然后看占用百分比

docker run -itd --name c1 --cpu-shares 512 centos:7 /bin/bash

docker run -itd --name c2 --cpu-shares 1024 centos:7 /bin/bash

docker ps -a

进入2个容器,测试

例:

docker exec -it ea5b06518b06 /bin/bash

yum install epel-release -y

yum install stress -y

stress -c 4 (CPU配置数量) #stress模拟满载线程

查看

docker stats

限制容器使用CPU

添加cpu核心,要有4个内核

先清空所有的容器,注意必须先停止状态

docker ps -a | awk '{print "docker rm "$1}' | bash

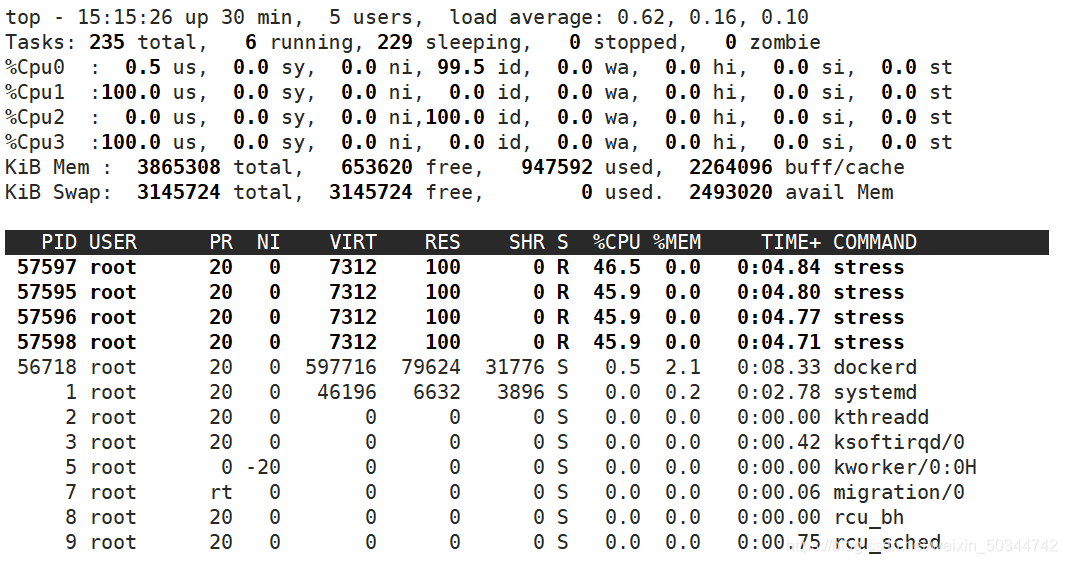

创建容器,并指定cpu1,3,使用第2和第4个cpu

docker run -itd --name test1 --cpuset-cpus 1,3 centos:7 /bin/bash

docker ps -a

docker exec -it 3ea411f1b6a4 /bin/bash

yum install epel-release -y

yum install stress -y

stress -c 4

查看

内存限制

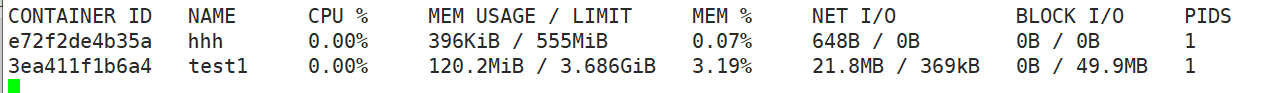

docker run -itd --name hhh -m 555m centos:7 /bin/bash #创建一个内存限制为555M的容器

docker stats

Io限制

docker的Io限制就是对block的Io进行约束,控制数据量用的较多,其中控制Io次数使用的较少。

docker run -itd --device-read-bps /dev/sda:30M centos:7 /bin/bash

--device-read-bps 限制读某个设备的bps (数据量,比特率,每秒数据传输速率)

--device-write-bps 限制写入某个设备的bps (数据量)

--device-read-iops 限制读某个设备的iops (次数)

--device-write-iops 限制写入某个设备的iops (次数)