集成学习

- Boosting

- Bagging

- Random Forest

集成学习:通过构建并结合多个学习器来完成学习任务。

要获得好的集成,个体学习器应“好而不同”,即个体学习器要有一定的“准确性”,即学习器不能太坏,还要有一定的“多样性”,即学习器间要有差异。

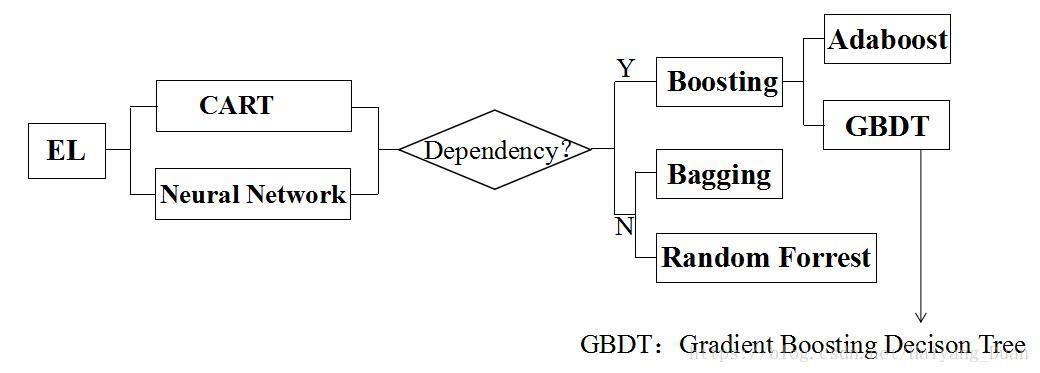

目前的集成学习方法分为两类:

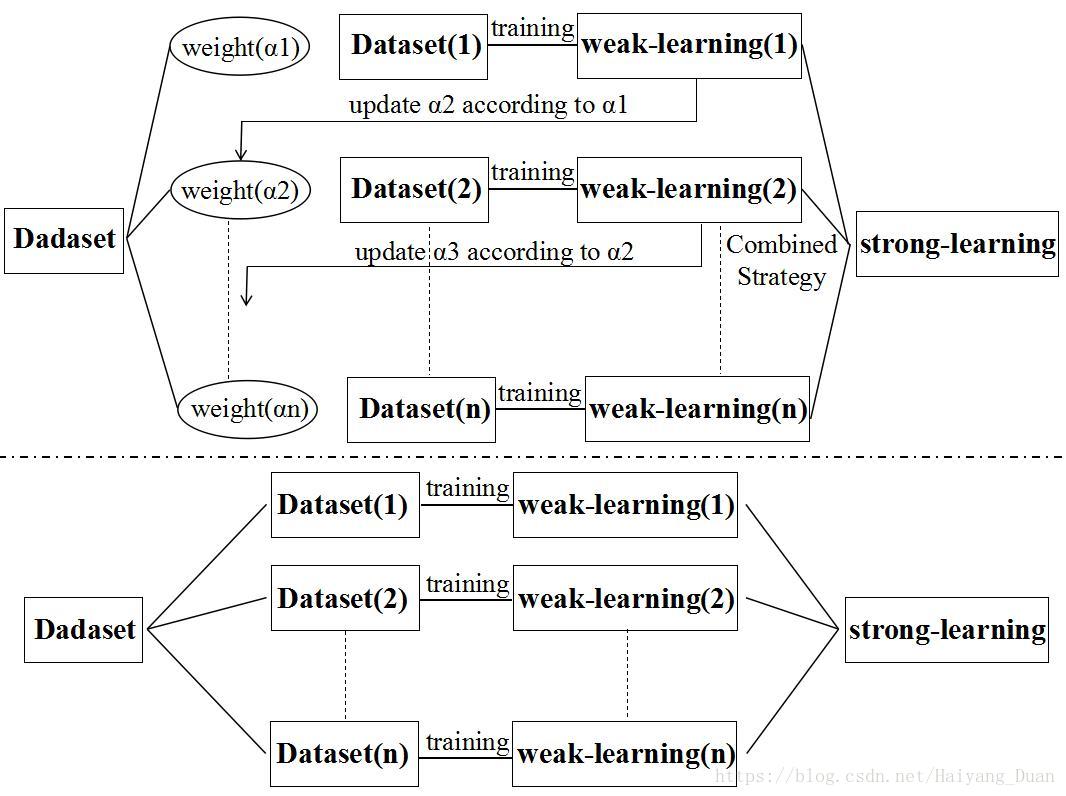

(1)个体学习器间存在强依赖关系、必须串行生成的序列化方法,代表算法Boosting;

(2)个体学习器间不存在强依赖关系、可同时生成的并行化方法代表算法Bagging和随机森林;

先从初始训练集训练出一个基学习器,再根据基学习器的表现对训练样本分布进行调整,使得先前基学习器做错的训练样本在后续受到更多关注,然后基于调整后的样本分布来训练下一个基学习器;如此重复进行,直至基学习器数目达到T,最终将这T个基学习器进行加权结合。

为得到泛化能力强的学习器,集成学习中的基学习器应尽可能独立,或者尽可能保持较大的差异。

给定一个训练数据集,一种可能的做法是对训练样本进行采样,产生若干个不同的子集,再从每个数据子集中训练出一个基学习器,这样,由于训练数据不同,获得的基学习器可望具有较大的差异。然而,还要保证基学习器的性能,每个训练数据子集必须具有交叠。

Bagging采用的是“自助采样法”,给定m个样本的数据集,先随机选出一个,再把该样本放回数据集,使得下次采样时仍有可能被选中,这样训练集中的样本在采样集里多次出现。基于每个采样集训练出一个基学习器,再将其进行结合,这就是Bagging的基本流程。

随机森林(Random Forest)在以决策树为基学习器构建Bagging集成的基础上,进一步在决策树的训练过程中引入可随机属性。即传统决策树在选择划分属性时是在当前结点的属性集合中选择一个最优属性;而在RF中,对基决策树的每个节点,先从该结点的属性集合中,随机选择一个包含k个属性的子集,再从这个子集中随机选择一个最有属性用于划分。推荐值 。

半监督学习

- 主动学习

- 纯半监督学习

- 直推学习

先使用有标记的数据集训练一个模型,利用该模型预测一个未标记的样本,然后把这个新获得的有标记样本加入数据集,重新训练一个模型,再去预测未标记的样本,…,这样的学习方法为“主动学习”。

让学习器不依赖于外界交互、自动地利用为标记的样本来提升学习性能,就是半监督学习。

要利用为标记样本,必然要做一些将未知样本所揭示的数据分布信息与类别标记联系起来的假设。

- 聚类假设

- 流形假设

假定训练数据中的未标记样本并非待预测的数据,其是基于“开放世界”的假设,希望学得模型能适用于训练过程中未观测到的数据。

假定学习过程中所考虑的为标记样本恰是待预测数据,其是基于“封闭世界”假设,仅试图对学习过程中观察到的为标记样本数据进行预测。