近年来,人工智能的热潮席卷而来,它正在各行各业影响着我们的生活。似乎只要套上AI,再困难的事情都能解决。那么究竟AI到底是什么?它是如何运作的?应该如何想像和应用它?

AI 即人工智能,是一种能够模拟人类智能的技术。它可以处理大量的数据,并能学习、思考、解决问题。AI可以被应用在各种领域,如自动驾驶汽车,语音识别,图像识别等。可以想象未来 AI 会在更多领域发挥重要作用,比如医疗诊断、金融风险评估、机器人技术等。

人工智能

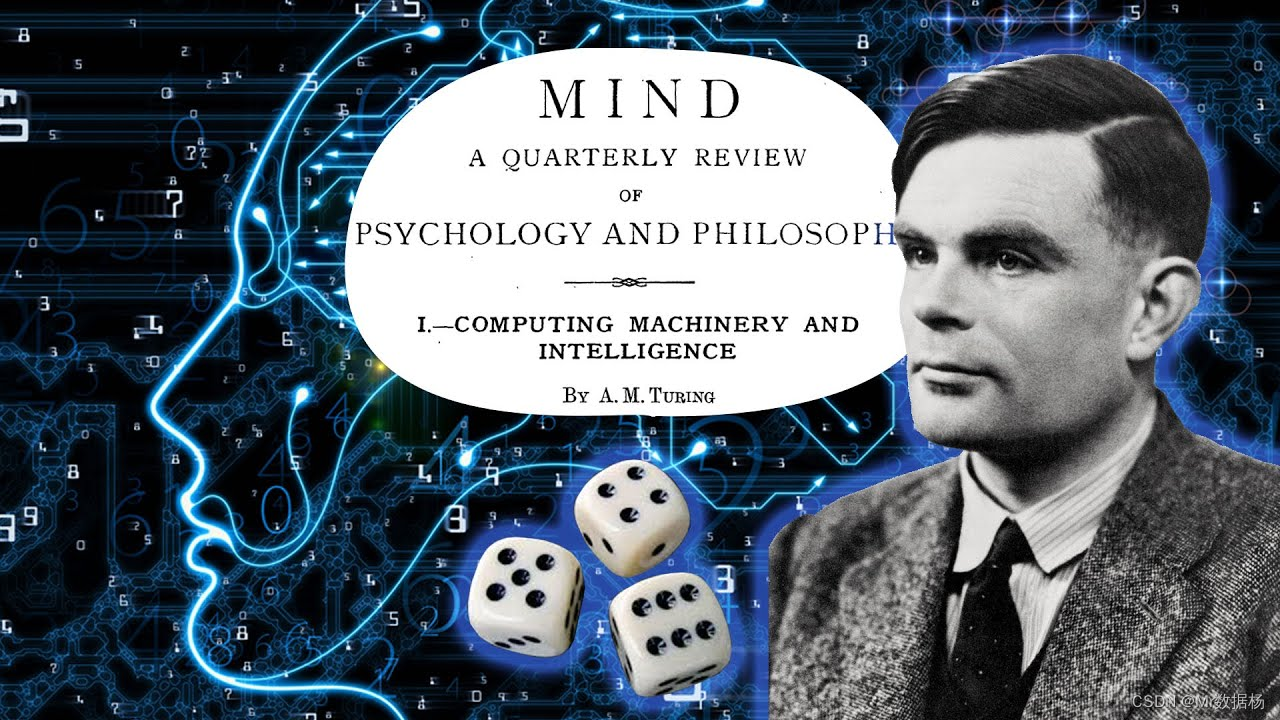

AI 全称 Artificial Intelligence,翻译为人工智能,是一项长期以来人类梦寐以求的技术。它的起源可以追溯到 1950 年,当时科学家艾伦·图灵在他的论文《计算机与智能》中首次提出了机器能否思考这一问题。这标志着人工智能这一新领域的诞生,并引发了人们对AI无限的想象。

如今 AI 已经影响到了各行各业,它能够处理大量的数据,并能学习、思考、解决问题。AI 在自动驾驶汽车、语音识别、图像识别等领域都有着广泛的应用。人工智能已经成为了人类生活中不可或缺的一部分,是推动人类进步的重要力量。

根据艾伦·图灵的理论,要判断一台机器是否能思考,必须通过一个经典的模拟游戏。这个游戏被后来称为图灵测试。在这个测试中,有一个问题者C,同时对不同房间内的机器A和人类B持续发问。只要C无法分辨出A和B谁是电脑谁是人类,我们就可以宣称这个房间内的机器是一台能思考的机器。图灵测试是一个经典的挑战,它帮助我们评估人工智能的进展和性能。

人类一直在努力研发能通过图灵测试的机器或算法。

1997年,最先进的IBM深蓝电脑击败了国际象棋冠军加里·卡斯帕罗夫,虽然看起来很厉害,但实际上只是通过穷举所有可能性,并从中选择最优步骤,就像GPS导航系统一样。

然而在复杂的现实世界中,这种暴力穷举方法显然不能应用到大多数情况。为了将 AI 应用于日常生活中,需要寻找更高效的方法。人类智慧的累积方式,就是一个很好的参考方向。在过去几十年中,已经看到了人工智能的快速发展,它已经成为许多领域的重要工具,从语音识别到图像识别,再到自然语言处理。AI 已经被广泛应用于我们的日常生活中,从智能手机到智能家居,它正在改变我们的生活方式。

机器学习

人类智能的核心是经验,通过不断学习和记录经验来调整对外界的认知。这样,在遇到类似情况时,我们就能轻易地利用过往经验来预测和应对未知的未来。

人类智慧的根基在于积累经验,通过不断学习和记录信息来调整对外界的理解。这样一来,当我们面对类似情况时,就能轻松利用过往经验来分析和应对未知未来。为了减少需要记忆和处理的信息量,人类善于将相似内容分类并标记。我们是否能将这些经验,即历史资料,用于机器学习,自动发现事件特征,并建立结果与事件之间的关联模型,从而预测未来数值或自动进行分类和决策呢?

预测数值是一个常见问题,可以通过找出事件特征和结果之间的数学线性关系来解决。举个例子假设在某个地段,有一间10平米的房子以100万成交,另一间20平米的房子以200万成交,我们就能根据这些信息推断出成交价与平数之间大约是每平10万的关系。

使用线性回归法可以利用这些信息来预测房价。而当成交资讯越来越多时,也能利用T度下降,Gradient Descent之类的技巧,找出一条符合所有资料的回归线,进而获得一个用平数来预测房价的模型,这就是所谓的线性回归法Linear Regression。

自动分类是一个广泛研究的问题,有许多不同的算法可供使用。其中之一就是逻辑回归法。在面对非明显的分类问题时,我们可以将特征与结果之间的关系投射到0和1之间的逻辑曲线上。使用这种方法,我们可以得到一个能将任意数值映射到适当分类的模型。这就是逻辑回归法 Logistic Regression。

决策树 Decision Tree 是一种机器学习算法,它利用特征与分类结果之间的关系,从历史数据中建立出一颗树状结构。这颗树状结构充满了"如果这样,就那样"的决策路径,它能将不同的特征映射到对应的适当分类。而随机森林算法是在决策树的基础上进行改进,它通过随机选择部分特征来建立多棵决策树,并使用投票的方式来得出最终结果。这样可以避免单一特征的重要性被过度放大而造成偏差。这就是随机森林算法 Random Forest。

类似的概念更进一步,提升树算法是在随机森林算法的基础上进一步改进。它通过策略性地建构多棵决策树模型,让重要的特征具有更高的权重,从而得到更高的准确度。这种算法也被称为GBDT(Gradient Boosting Decision Tree)。

最近邻居法 Knearest Neighbors,或简称KNN,它在现有历史数据的基础上,直接比较新数据与历史数据之间的特征相似度,并选择最接近的k个数据来决定新数据的分类。这种算法非常简单,而且容易理解,通常用于分类和回归问题。它的优点是不需要训练数据,只需要一些历史数据即可进行预测,并且在数据不平衡的情况下具有很高的精度。

贝叶斯分类 Naive Bayesian Classifier 是一种基于贝叶斯定理和特征条件独立性假设的分类算法。它通过计算每个特征条件下对应类别的概率来预测一个新数据的类别。这种算法简单易于实现,并且在处理大量文本数据时表现出色。然而,由于假设特征之间相互独立,它的精度可能不如其他算法。在解决数据稀疏问题时,可以使用拉普拉斯平滑来提高其精度。

支持相量机 Support Vector Machine 简称 SVM ,是一种用于分类和回归的统计学习方法。它的基本思想是在训练数据中找到一条最优的超平面,将数据划分到两个类别中。它通过寻找最大间隔来划分数据,从而使得分类效果更好。SVM在高维空间中表现良好,并且对线性不可分的数据也能很好地处理。

那么如果我们手头上的资料,从来没被分类过,还有办法自动将他们分群吗?

K-means 聚类是一种无监督学习算法,用来将无标签数据分组。它通过选择K个随机中心点来分组,然后通过迭代地调整中心点和每组数据点来使得每组数据点越来越相似。最终得到K个类别,每个类别都是相似的数据点。这种算法通常用于数据挖掘和数据分析中,帮助我们发现数据的潜在结构。

深度学习

以上都是在有历史资料的情形下,利用资料来建构模型的演算法,那么如果没有历史资料呢?

强化学习 Reinforcement Learning 简称RL,是一种机器学习的方法,它的目的是让代理人或智能体,通过不断地尝试,来学习如何在一个环境中获得最大的奖励。它的核心思想是通过不断的互动来学习最优的策略。通过不断的尝试和反馈来调整代理人的策略,使其能够在未来获得更高的奖励。在不同的应用场景中,强化学习都能取得非常好的效果,如机器人控制,游戏人工智能,金融交易等。

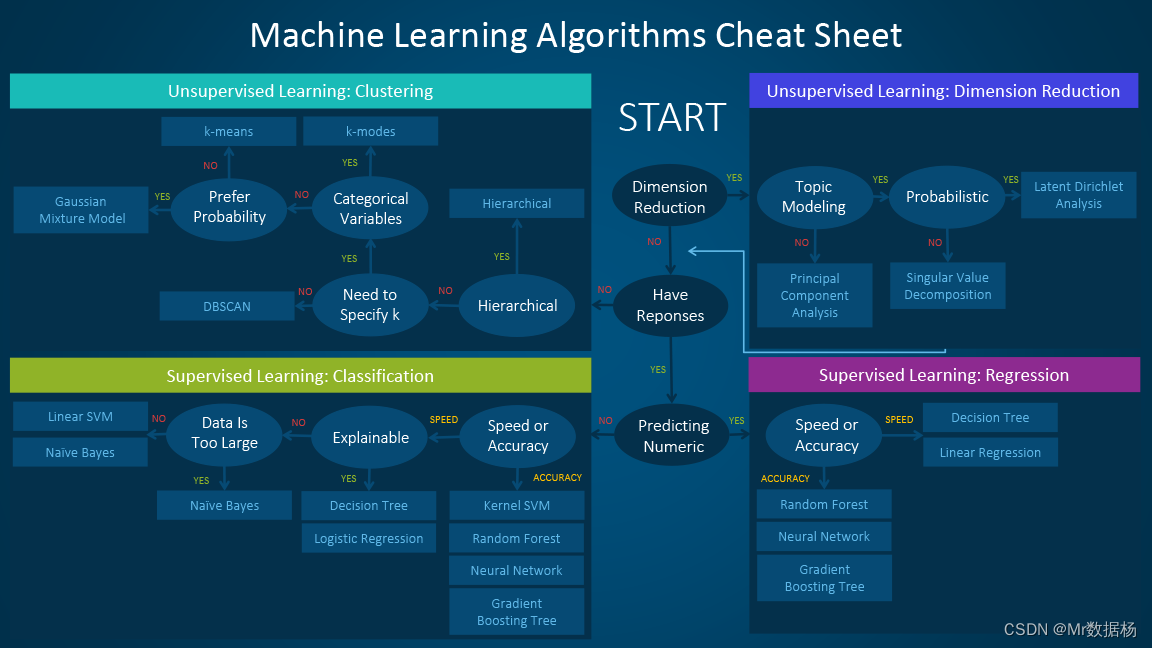

在选择演算法时,我们需要考虑历史资料是否有标准答案,以及每种演算法的特性与前提假设。在监督式学习中,我们可以使用线性回归法或逻辑回归法来分类,而在非监督式学习中,我们可以使用K平均算法来自动分群。对于没有历史资料的情况,我们可以使用强化学习来训练模型。最重要的是,我们需要根据具体情况来选择最适合的演算法。

机器学习并不局限于某些特定的类型问题或应用场景。在选择演算法时,需要考虑诸多因素,包括数据量、模型效能和准确度等。某些人甚至制定了标准程序作业 Standard Operating Procedures 简称 SOP 来简化演算法的选择过程。然而,在更高层次和更复杂的应用场景中,还需要更先进的方法来提升模型的效能。因此,机器学习的发展仍在不断探索和提升中。

人类一直在探索如何让机器模拟人脑的智能。随着机器学习的发展,我们发现人脑的智能主要来自于数百到数千个神经元之间的相互连结。我们是否能用类似的概念来让机器模拟人脑的智能呢?这就是我们当前的研究课题。

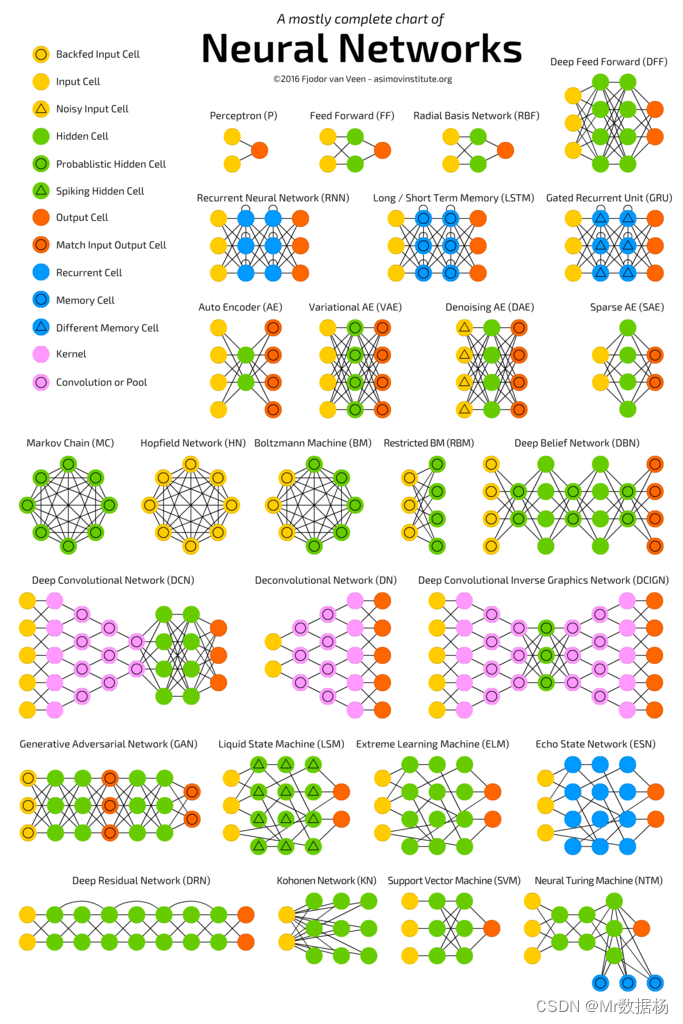

类神经网络理论的出现,导致了"New World Network"的诞生。这一理论进一步演变为后来的深度学习,Deep Learning。这种理论借鉴了人脑神经元的运作机制,以数字逻辑的方式来模拟。我们称之为"感知器",Perceptron。它包含了M个输入X,一个偏置Bias,经过权重W相乘并加和之后,再通过一个激活函数来模拟大脑神经元的电位发值机制。最终输出这个节点被激活的程度,并传递至下一层的Perceptron。由于现实中要解决的问题大多不会有简单的线性解,我们通常会选用非线性的激活函数,如Sigmoid, Tanh, Relu等。

通过连接多个Perceptron, 就可以形成一个Deep Learning的模型架构。为了训练这个模型,我们需要将数据一条一条地输入模型中,进行正向传播 Forward Propagation,计算出模型的输出结果,并与标准答案带入损失函数 Loss Function ,计算出两者之间的差异。然后使用最佳化函数(如Gradient Descent)进行反向传播 Backward Propagation ,以减小差异为目标,调整每一个Perceptron中的权重。当数据量足够大,且模型输出结果与标准答案之间的差异足够小时,就表明这个模型已经被训练成功并可以使用了。

Deep Learning的概念看上去简单,但是要实现这个概念需要大量的数据、大量的运算能力和简单易用的软件。

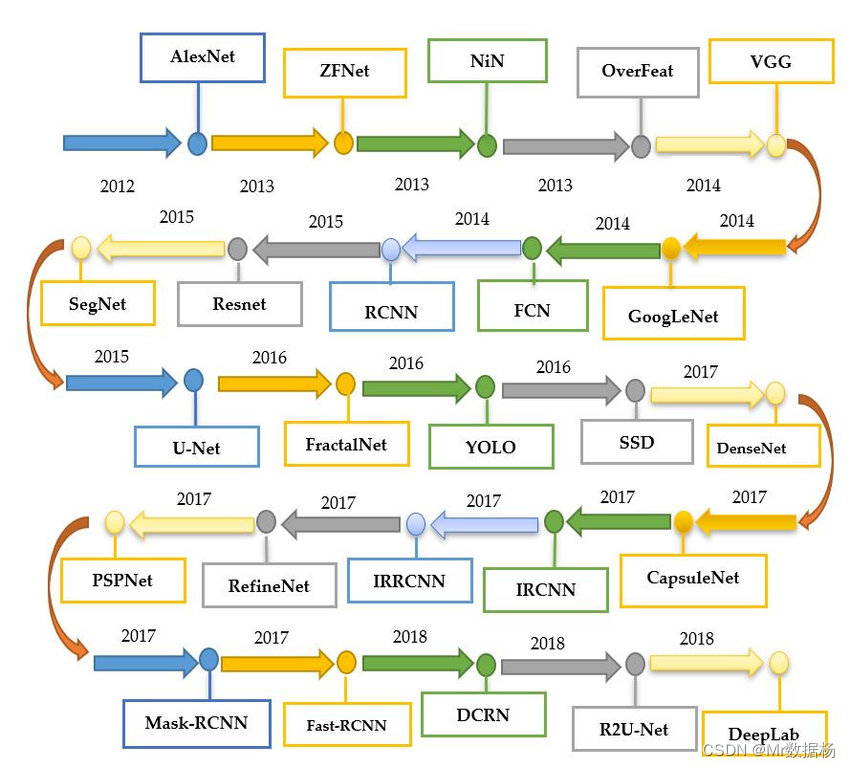

因此直到2012年之后,这三个条件都得到了满足,Deep Learning才开始有了爆炸性的增长。在计算机视觉领域,我们可以使用卷积神经网络 Convolutional Neural Network, CNN ,通过小范围的滤镜来提取图像的边缘形状等特征,再将这些具有意义的特征传递给Deep Learning模型,从而有效识别图像中的物体。在图像或艺术风格方面,我们可以使用生成对抗网络 Generative Adversarial Network 简称 GAN ,通过两个 Deep Learning 模型相互竞争来实现。生成模型 Generator 会产生假数据,而判别模型 Discriminator 则会判断这些数据是否真实。当生成模型产生出来的假数据能够被判别模型分辨出来时,就说明成功了。这样的方式可以在模仿图像或艺术风格方面取得很高的效果。

一些变脸应用的App,或AI生成的化作,都是使用了自然语言处理 Nature Language Processing 简称 NLP 技术。这些技术通常使用递归神经网络 Nature Language Processing 简称 RNN 来处理有顺序性资料,以达到有顺序性短期记忆的效果。更先进的长短期记忆神经网络 Long Short Term Memory 简称 LSTM 技术则用于改善RNN的长期记忆效果。Transformer 是一种新的有效率的解决方案,它使用注意力 Attention 机制,让模型直接针对重点部分进行处理。这种机制不仅用于自然语言处理,在电脑视觉领域也有不错的成绩。

2020年拥有 175B 连模型参数的 GPT-3 已经能够自动生成文章和程序代码,并回答问题,甚至质量不亚于人类。

未来,随著模型参数各数在持续指数型成长,这类模型的实际应用成效更是令人期待,而除了前面说的电脑视觉,与自然语言处理这两大领域之外,Deep Learning在各领域也都有很惊人的成果,

2017年,靠着深度学习和强化学习技术的Alphago战胜了世界棋王柯洁,这是人工智能在某些领域超越人类智慧的典型事例。

2020年,Alphago研发团队DeepMind解决了生物学领域长期困扰的蛋白质分子折叠问题,这将有助于更好地理解疾病机制、促进新药研发、帮助农业生产、改善地球生态环境。

自动驾驶汽车技术也在不断发展,事故率远低于人类驾驶。在医学领域,AI在某些诊断方面的准确率也已达到超过人类的水平。无人商店和“中国天网”等应用也已不再是新鲜话题。

总结

回顾1950年图灵问题,机器能思考吗?我们可能依然无法给出明确答案。然而,当下的人类已经拥有比当年更多的技术成果,更接近这个梦想。当前的人工智能技术就像一个不断学习成长的孩子,能看、能听、能说,能针对特定问题做出精准的判断,甚至超越人类过往认知能力。

然而在处理哲学、情感、伦理道德等问题时,它们仍远远跟不上。人和机器各有所长。人类擅长思考和创新,但体力有限,有时会犯错误。机器擅长记忆和运算,能稳定高效地回答特定问题,并且24小时不停歇。因此,在这个人工智能浪潮中,理想的策略是人和机器充分合作,发挥各自优势。人类可以将低阶、重复、琐碎的工作外包给机器,腾出时间和精力去实现梦想,思考人生意义,专注于解决重要问题,从而提升整体人类水平。