周志华《机器学习》(西瓜书)目录

https://editor.csdn.net/md?articleId=106864771

—————————————————————————————————

性能度量

对学习器的泛化性能进行评估,不仅需要有效可行的实验估计方法,还需 要有衡量模型泛化能力的评价标准,这就是性能度量(performance measure).

- 错误率与精度

- 查准率、查全率与F1

- ROC 与 AUC

- 代价敏感错误率与代价曲线

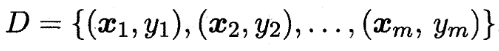

数据集:

学习器:f

回归任务最常用的性能度量是"均方误差" (mean squared error)。

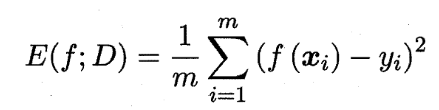

对于一般的数据分布D以及概率密度函数p(.),均方误差为:

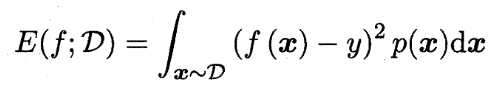

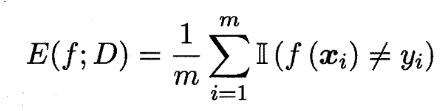

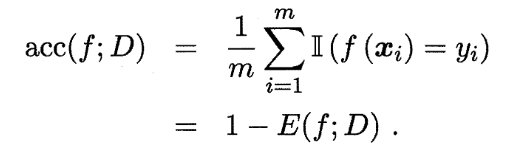

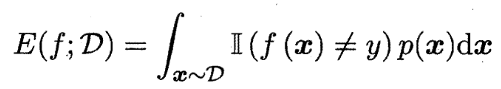

错误率与精度

错误率是分类错误的样本数占样本总数的比例。

精度则是分类正确的样本数占样本总数的比例。

对于一般的数据分布D以及概率密度函数p(.),其表示为:

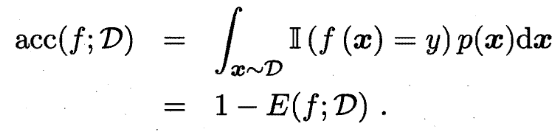

查准率、查全率与F1

对于二分类问题,真实类别和机器预测类别的组合如下:

其查准率和查全率为:

](https://img-blog.csdnimg.cn/2020062115571099.png)

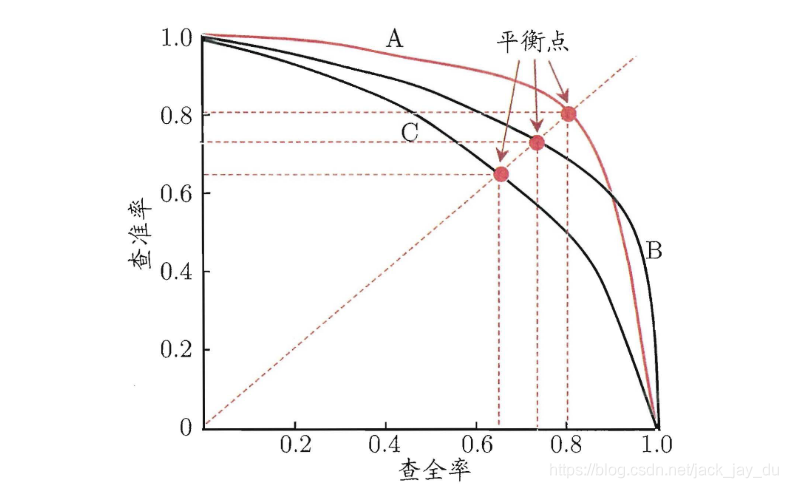

以查准率为纵轴、查全率为横轴作图,就得到 了查准率-查全率曲线,简称 " P-R曲线"显示该曲线的图称为 “P-R图”。如下图所示:

平衡点:查准率=查全率

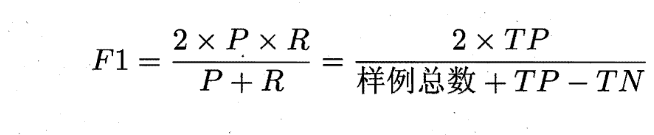

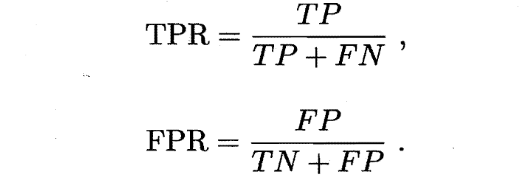

BEP 还是过于简化了些,更常用的是 F 1 F_1 F1 度量以及 F β F_\beta Fβ:

其中 β > 0 \beta>0 β>0度量了查全率对查准率的相对重要性。 β = 1 \beta=1 β=1时退化为标准的 F1; β > 1 \beta>1 β>1时查全率有更大影响; β < 1 \beta<1 β<1时查准率有更大影响.

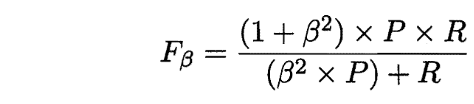

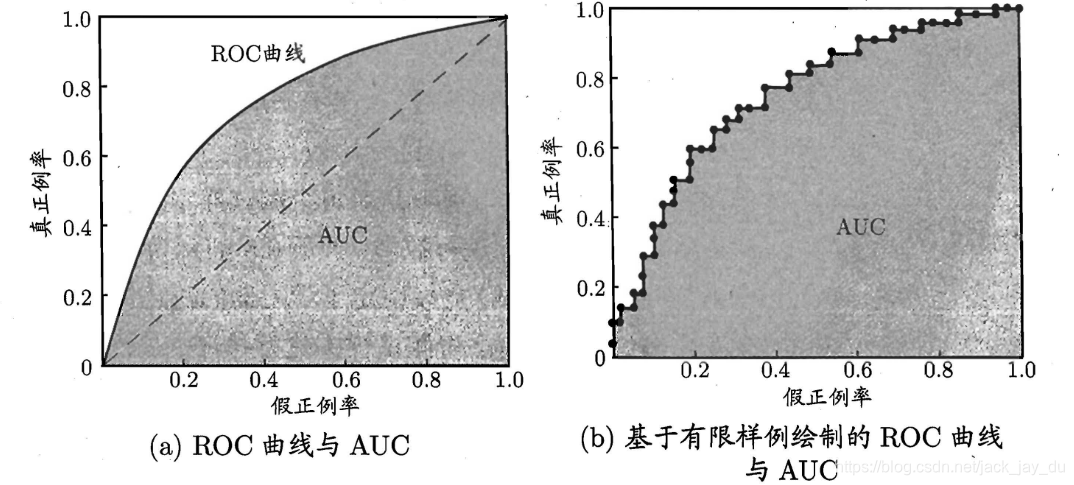

ROC 与 AUC

ROC 全称是"受试者工作特征" (Receiver Operating Characteristic) 曲

线,我们根据学习器的预 测结果对样例进行排序,按此顺序逐个把样本作为正例进行预测,每次计算 出两个重要量的值,分别以它们为横、纵坐标作图。ROC 曲线的纵轴是"真正 例率" (True Positive Rate,简称 TPR),横轴是"假正例率" (False Positive Rate,简称 FPR)。

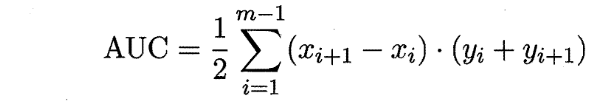

AUC (Area Under ROC Curve)是ROC 曲线下的面积,AUC 可通过对 ROC 曲线下各部分的面积求和而得。离散情况下,AUC 可估算为:

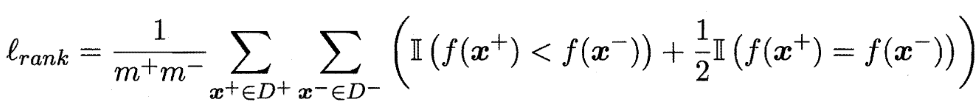

排序"损失" (loss)为:

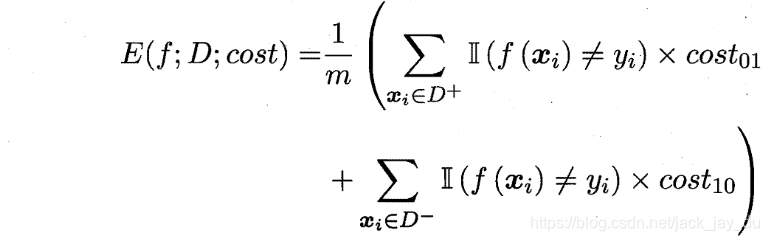

代价敏感错误率与代价曲线

“代价敏感” (cost-sensitive)错误率是指在非均等代价情况下,我们所希望的不再是简单地最小化错误次 数,而是希望最小化"总体代价" (total cost)。

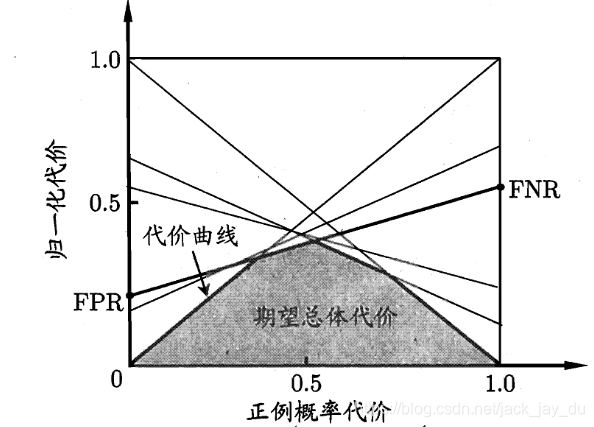

在非均等代价下,ROC 曲线不能直接反映出学习器的期望总体代价,而"代价曲线" (cost curve) 则可达到该目的。

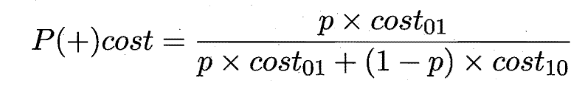

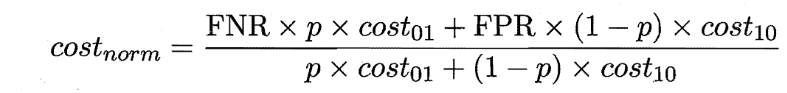

其中横轴是取值为 [0 ,1] 的正例概率代价,纵轴是取值为 [0 ,1] 的归一化代价,p 是样例为正例的概率。

参考文献

[1] 周志华. 机器学习 : = Machine learning[M]. 清华大学出版社, 2016.