目录

1. 深度前馈神经网络

深度前馈网络(deep feedfoward network)也称作前馈神经网络(feedforward neural network)或者多层感知机(multilayer perceptron:MLP),它是最典型的深度学习模型。

但多层感知器的叫法并不是十分合理,因为前馈神经网络其实是由多层 的 Logistic 回归模型(连续的非线性函数)组成,而不是由多层的感知器(不连 续的非线性函数)组成。

在前馈神经网络中,各神经元分别属于不同的层.每一层的神经元可以接收前一层神经元的信号,并产生信号输出到下一层,第0层称为输入层,最后一层称 为输出层,其他中间层称为隐藏层。整个网络中无反馈,信号从输入层向输出层 单向传播,可用一个有向无环图表示。

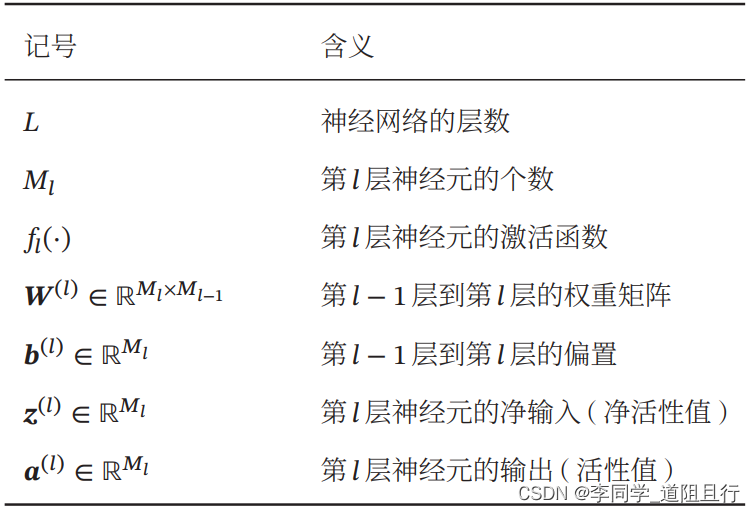

前馈神经网络的记号

2. 反向传播(BP)

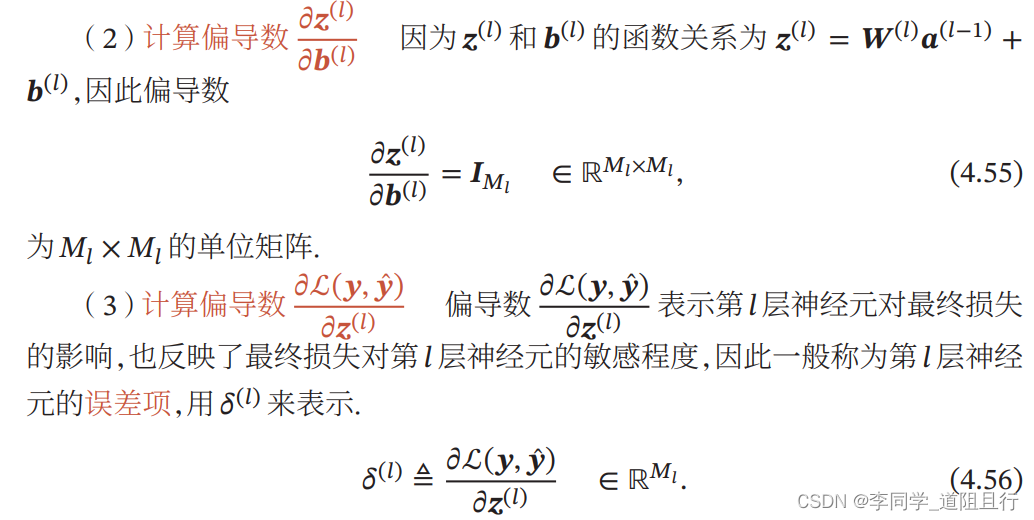

误差反向传播的简称,是一种与最优化方法(如梯度下降法)结合使用的,用来训练人工神经网络的常见方法。 该方法对网络中所有权重计算损失函数的梯度,反馈给最优化方法,用来更新权值以最小化损失函数。

BP算法是一个迭代算法,它的基本思想为:(1)先计算每一层的状态和激活值,直到最后一层(即信号是前向传播的);(2)计算每一层的误差,误差的计算过程是从最后一层向前推进的(这就是反向传播算法名字的由来);(3)更新参数(目标是误差变小)。迭代前面两个步骤,直到满足停止准则(比如相邻两次迭代的误差的差别很小)。

2.1 链式法则

“正向传播”求损失,“反向传播”回传误差。同时,神经网络每层的每个神经元都可以根据误差信号修正每层的权重。

2.2 链接: 使用反向传播法训练多层神经网络的原则

2.3 链接 :对上述原则解读,并举例计算反向传播

深度学习(六):前向传播算法和后向传播算法 - 简书 (jianshu.com)![]() https://www.jianshu.com/p/1765be3eda14

https://www.jianshu.com/p/1765be3eda14