示例代码

参考李沐老师的《动手学深度学习》第4节:多层感知机

batch_size = 256

train_iter,test_iter = d2ltorch.load_data_fashion_mnist(batch_size)

next(iter(train_iter))[0].shape # torch.Size([256, 1, 28, 28])

next(iter(train_iter))[1].shape # torch.Size([256])

# 2个Type都是tensor

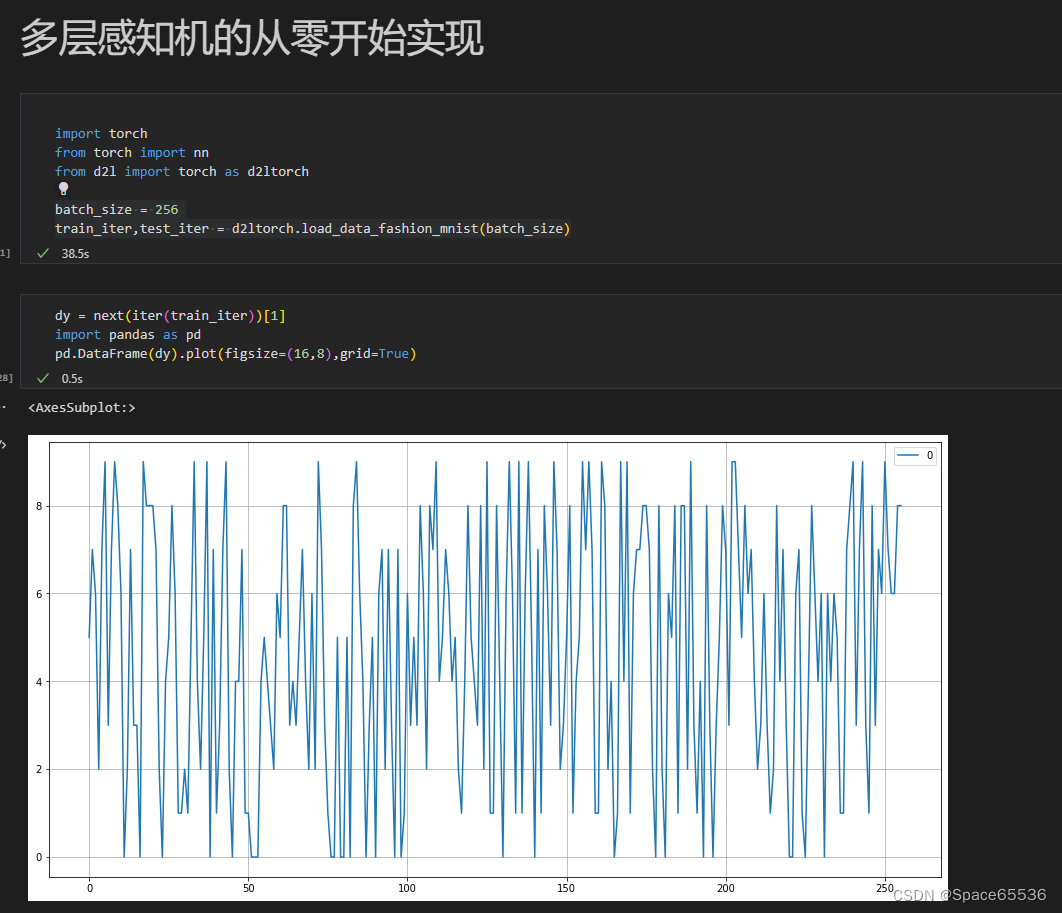

next(iter(train_iter))[1][0] # tensor(3) 图片种类,有256张图片,就有256个结果

分析

- 迭代器[0]:X

- 迭代器[1]:y

- 迭代器[0][0]:第一张图片

- 迭代器[0][1]:第一张图片

- 迭代器[0][N]:第N张图片

补充

batch_size

是我们每次抽取的数据样本的大小,通过指定batch_size大小指定data_iter这个iterator每次iter多少。

- 当batch_size = 数据集大小m时,整个过程的时间肯定会比较长

- 当batch_size 比较小的时候,也就是一次只学一点,大概率学不到什么东西,也可能导致训练loss比较大