前言

随着人工智能的不断发展,机器学习这门技术也越来越重要,很多人都开启了学习机器学习,本文就介绍了机器学习的基础内容。来源于哔哩哔哩博主“霹雳吧啦Wz”,博主学习作为笔记记录,欢迎大家一起讨论学习交流。

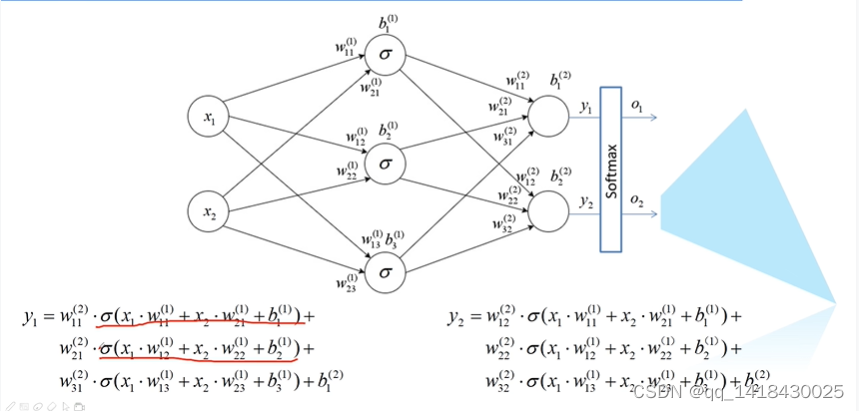

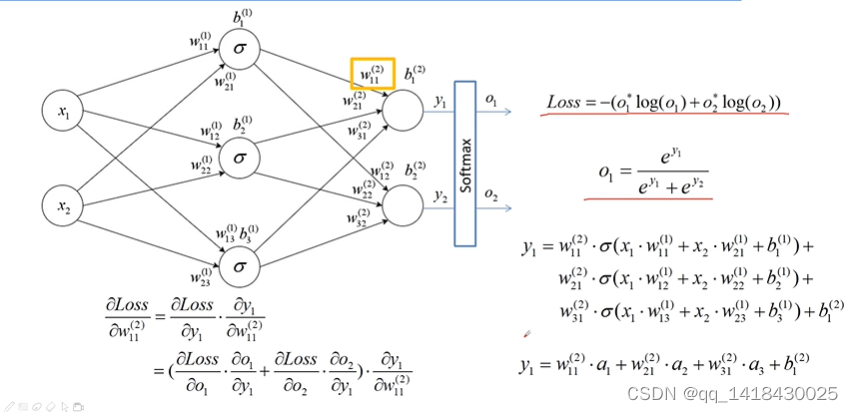

一、输出的计算

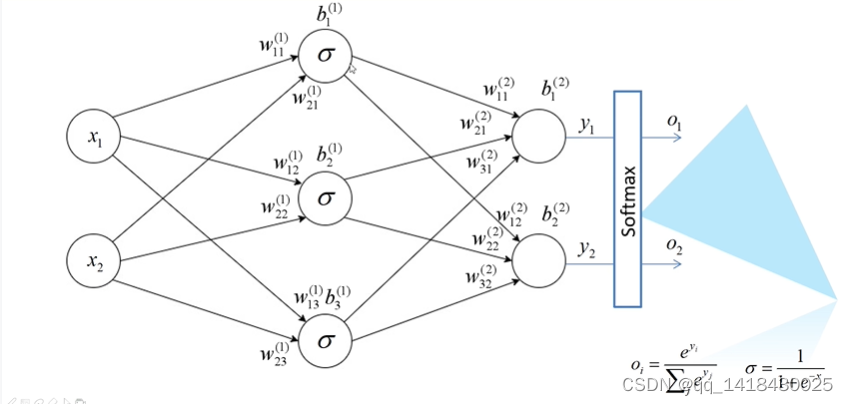

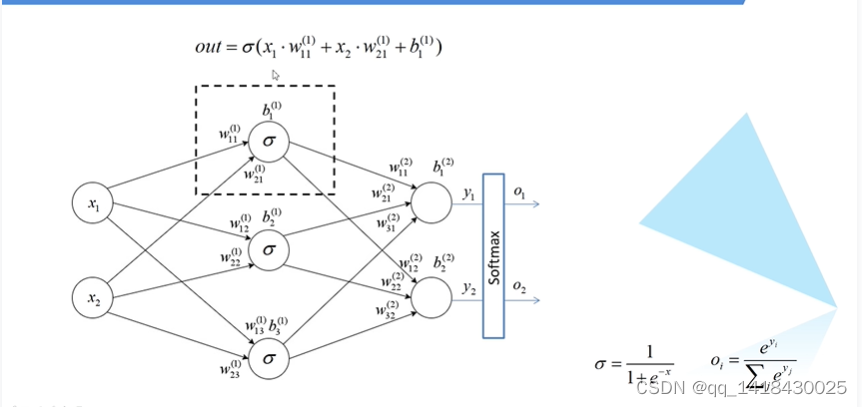

参数解释:

x1,x2表示第一层输入;中间代表隐层,隐层有三个节点;y1,y2为最后一层输出层。中间sigmoid表示激活函数。

w11(1):下标11当中的第一个1表示上一个输入层的第几个节点,w11(1)就表示上一个层的第一个的节点x1。

w11(1):下标11当中的第二个1表示本层当中的第几个节点,w11(1)就表示本层当中的第一个的节点1。

w11(1):上标1表示第一层,第二层…。w11(1)就表示本层(隐层),第一层(隐层)。

同理可以得出最后一层的输出,对应激励与权重相乘再相加,再加上相应的偏置。最后一层没有使用sigmoid激活函数,通常情况下,计算多维损失,最后一层统一使用softmax函数。

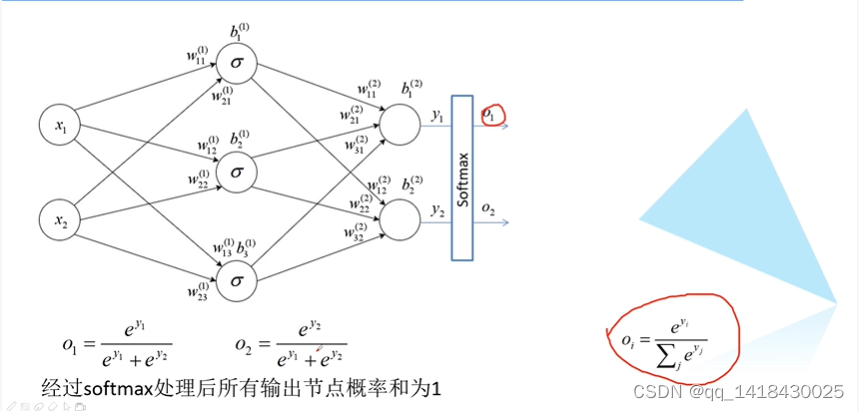

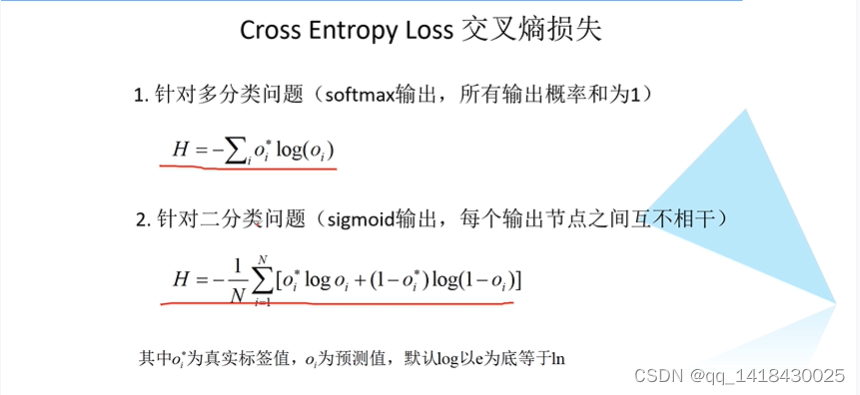

二、误差的计算

softmax满足分布和为1,但sigmoid函数并不满足此特性。大部分使用softmax函数,即输出指定是某一个确定的类别,而不是和其他类别的相似类别。即假设猫狗二分类问题,我们希望输出要么是猫,要么是狗,使用softmax函数;假设人和男人分类问题,可能一张图片可能是人,也可能是男人,二者有相似的东西。

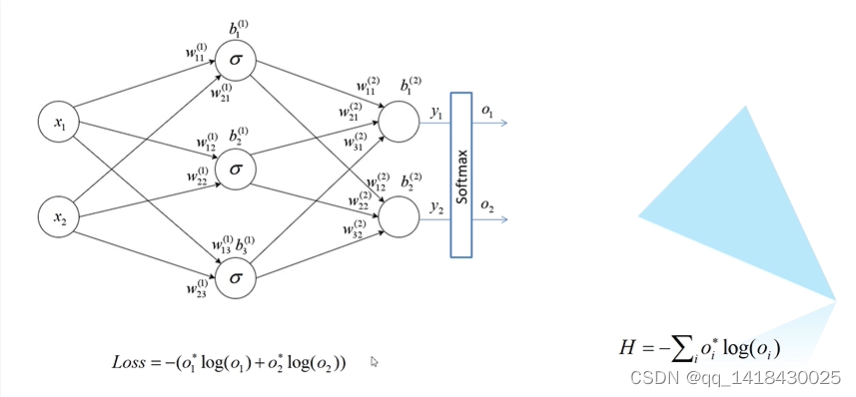

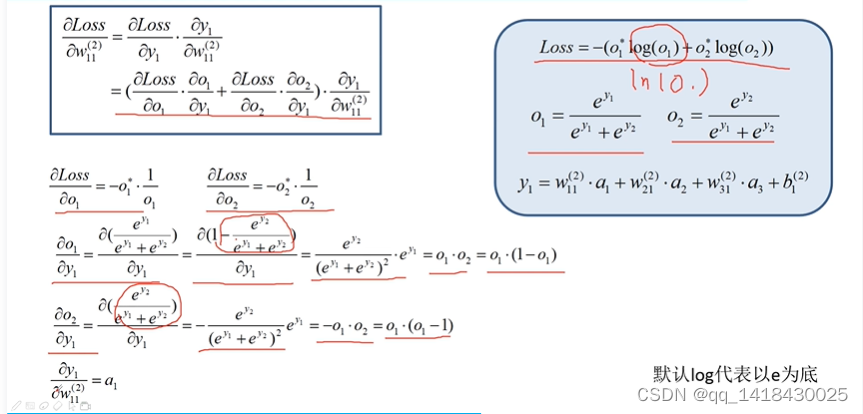

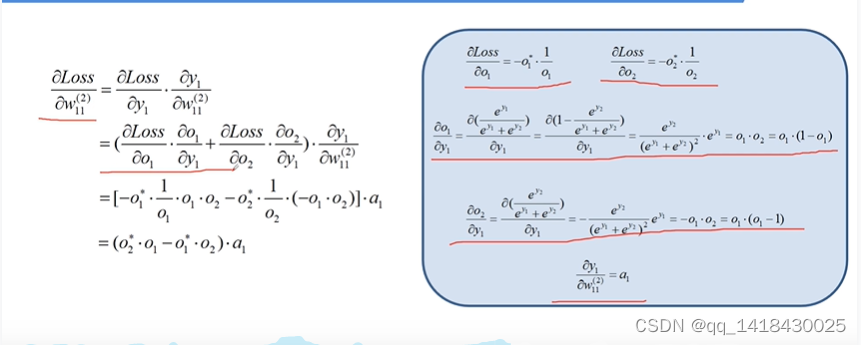

三、误差的反向传播

得到损失,接下来进行误差的方向传播。以w11(2)为例求解损失梯度。计算loss对其的偏导,根据链式法则,loss先对y1求导,然后y1再对w11(2)求导。loss又是包含o1和o2,所以loss对y1的求导可以转化为loss对o1,o1对y1;loss对o2,o2对y1。

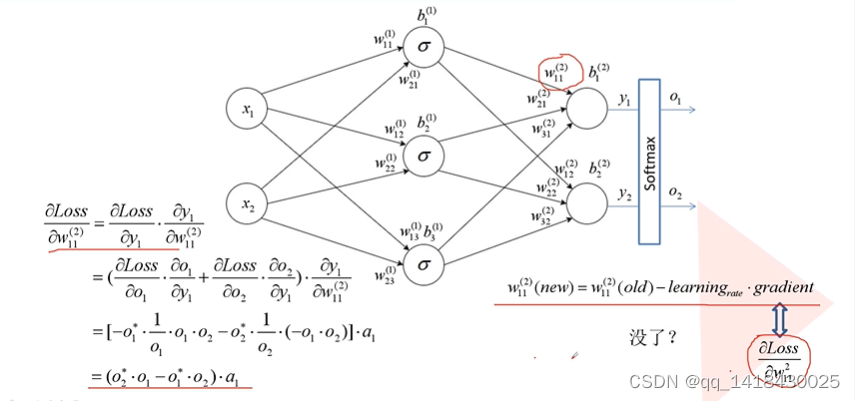

即把所求的误差反向传播到了每一个节点,得到每一个节点的损失梯度。

四、权重的更新

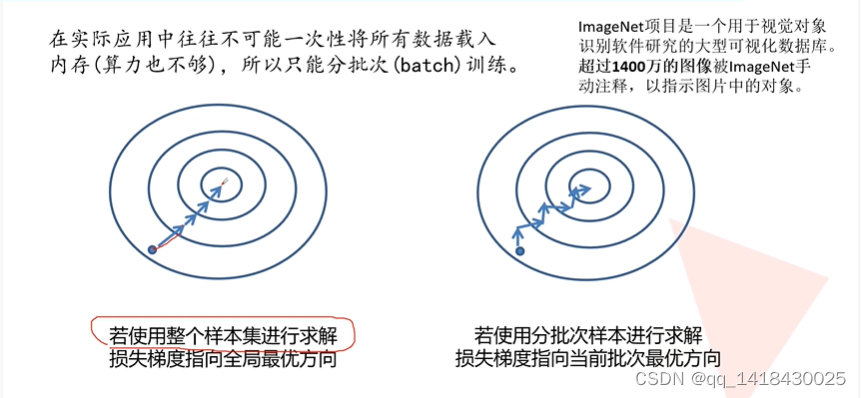

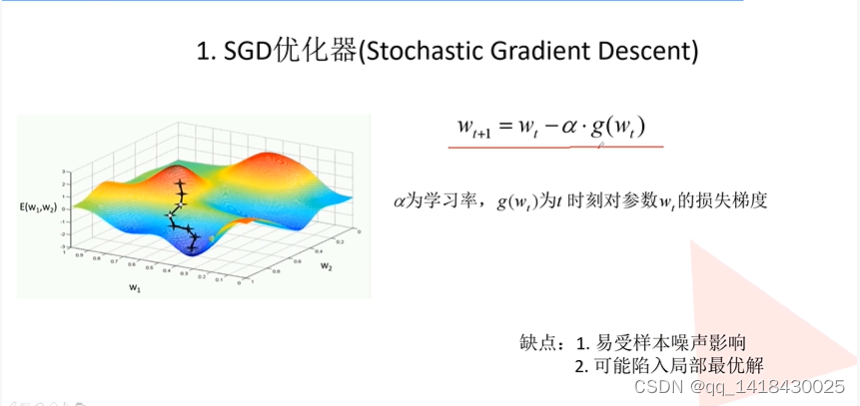

1.易受噪声影响比如训练集标记错误,训练出来的结果有问题。

2.局部最优解:每一批数据随机分批次进行。

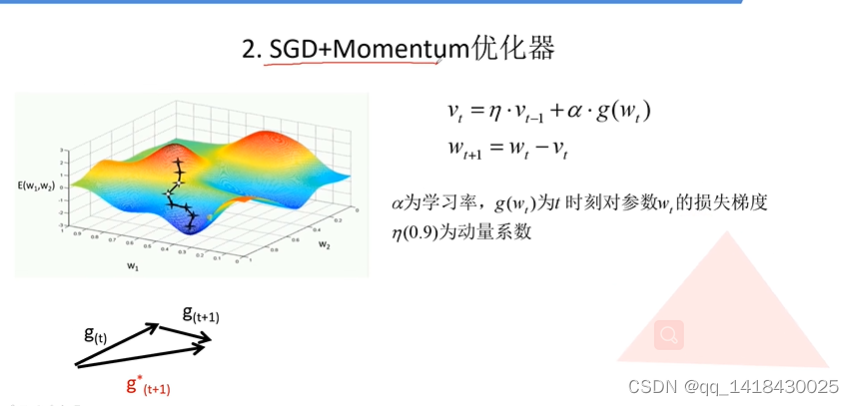

考虑了当前时刻和过去时刻的梯度方向,有效抑制噪声的干扰。

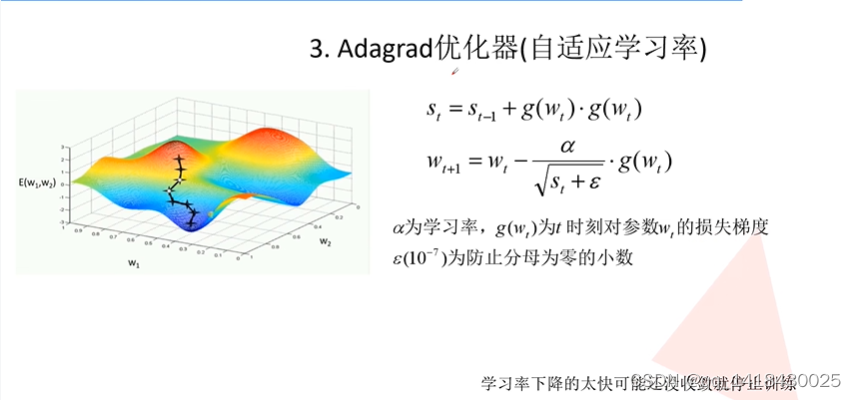

st是对损失梯度进行平方求和,st变大,a变小。

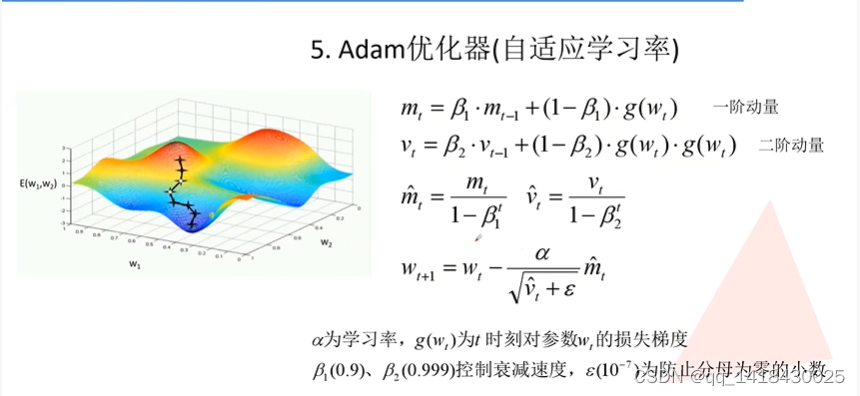

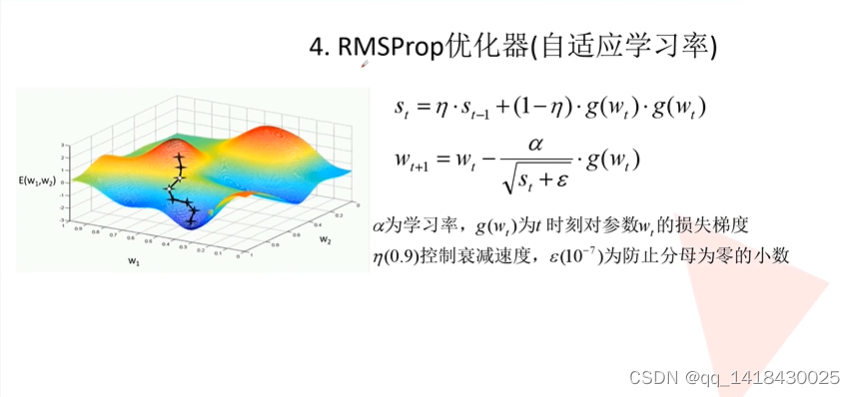

相比于Adagrad优化器,增加了两个系数控制衰减速度。