目录

概述

之前写的推导Canny边缘检测算法得到了大家的认可,我也是第一次拿到了双榜第一的成绩,给了我很大的鼓励。传统的检测算法在工业当中用处也颇多,由于学习的需要,我才在之前推导了Canny边缘检测的算法,它也是我最常用的一种,它的效果确实是较其他几种要好一点。所以这篇的目的是为了,学习其他的几种边缘检测的方法,并与Canny算法进行比较,来评估一下这几种算法实现效果的差异,并得到一个在什么样的条件下,使用哪种算法最好。

Sobel算子

它是一离散性差分算子,用来运算图像亮度函数的灰度之近似值。在图像的任何一点使用此算子,将会产生对应的灰度矢量或是其法矢量

Sobel卷积因子为:

该算子包含两组3*3的矩阵,分别为横向及纵向,将之与图像作平面卷积,即可分别得出横向及纵向的亮度差分近似值。如果以A代表原始图像,Gx与Gy分别代表横向及纵向边缘的图像灰度值,其公式如下:

具体的计算,请看下面:

Gx = (-1)*f(x-1, y-1) + 0*f(x,y-1) + 1*f(x+1,y-1)+(-2)*f(x-1,y) + 0*f(x,y)+2*f(x+1,y)+(-1)*f(x-1,y+1) + 0*f(x,y+1) + 1*f(x+1,y+1)

= [f(x+1,y-1)+2*f(x+1,y)+f(x+1,y+1)]-[f(x-1,y-1)+2*f(x-1,y)+f(x-1,y+1)]

Gy =1* f(x-1, y-1) + 2*f(x,y-1)+ 1*f(x+1,y-1)+0*f(x-1,y) 0*f(x,y) + 0*f(x+1,y)+(-1)*f(x-1,y+1) + (-2)*f(x,y+1) + (-1)*f(x+1, y+1)

= [f(x-1,y-1) + 2f(x,y-1) + f(x+1,y-1)]-[f(x-1, y+1) + 2*f(x,y+1)+f(x+1,y+1)]

其中f(a,b),表示图像(a,b)点的灰度值;

图像的每一个像素的横向及纵向灰度通过以下公式结合,来计算该点灰度的大小:

![]()

通常,为了提高效率,用不开方的近似值:

![]()

如果,梯度G大于某一阈值,则认为该点(x,y)为边缘点。

最后,用下面的式子来计算梯度方向:

![]()

Sobel算子根据像素点上下、左右邻近点灰度加权差,在边缘处达到极限这一现象来检测边缘。对噪声具有平滑的作用,提供较为精准的边缘方向信息,边缘定位精度不够高。当对精度要求不是很高时,是一种较为常用的边缘检测方法。

FFT算子

快速傅里叶变换FFT是离散性傅里叶变换DFT的一种快速检测方法,一般工程应用时,用的就是这种。

-

Numpy中的傅里叶变换

首先,我们将看看如何使用Numpy查找傅立叶变换。Numpy具有FFT软件包来执行此操作。

np.fft.fft2()为我们提供了频率的转换,它将是一个复杂的数组。它的第一个参数是输入图像,即灰度图像。第二个参数是可选的,它决定输出数组的大小。如果它大于输入图像的大小,则在计算FFT之前用零填充输入图像。如果小于输入图像,将裁切输入图像。如果未传递任何参数,则输出数组的大小将与输入的大小相同。

现在,一旦获得结果,零频率分量(DC分量)将位于左上角。如果要使其居中,则需要在两个方向上将结果都移动N/2。只需通过函数**np.fft.fftshift**()即可完成。(它更容易分析)。找到频率变换后,就可以找到幅度谱。

import cv2 as cv

import numpy as np

from matplotlib import pyplot as plt

img = cv.imread('Images/rgblena.jpg',0)

f = np.fft.fft2(img)

fshift = np.fft.fftshift(f)

magnitude_spectrum = 20*np.log(np.abs(fshift))

plt.subplot(121),plt.imshow(img, cmap = 'gray')

plt.title('Input Image'), plt.xticks([]), plt.yticks([])

plt.subplot(122),plt.imshow(magnitude_spectrum, cmap = 'gray')

plt.title('Magnitude Spectrum'), plt.xticks([]), plt.yticks([])

plt.show()

看,你可以在中心看到更多白色区域,这表明低频内容更多。

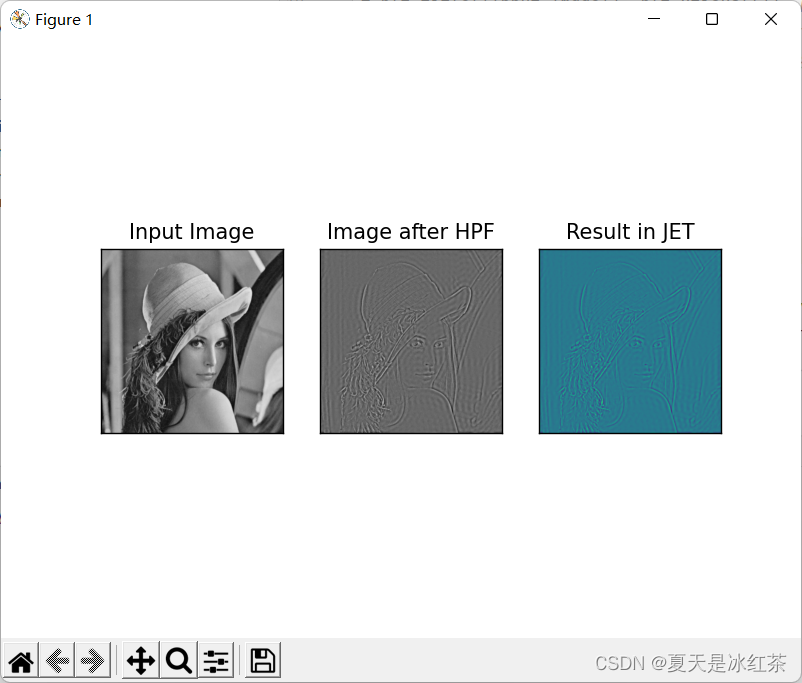

因此,发现了频率变换到现在,你可以在频域中进行一些操作,例如高通滤波和重建图像,即找到逆DFT。为此,您只需用尺寸为60x60的矩形窗口遮罩即可消除低频。然后,使用**np.fft.ifftshift**()应用反向移位,以使DC分量再次出现在左上角。然后使用**np.ifft2**()函数找到逆FFT。同样,结果将是一个复数。你可以采用其绝对值。

import cv2 as cv

import numpy as np

from matplotlib import pyplot as plt

img = cv.imread('Images/rgblena.jpg',0)

f = np.fft.fft2(img)

fshift = np.fft.fftshift(f)

rows, cols = img.shape

crow,ccol = rows//2 , cols//2

fshift[crow-30:crow+31, ccol-30:ccol+31] = 0

f_ishift = np.fft.ifftshift(fshift)

img_back = np.fft.ifft2(f_ishift)

img_back = np.real(img_back)

plt.subplot(131),plt.imshow(img, cmap = 'gray')

plt.title('Input Image'), plt.xticks([]), plt.yticks([])

plt.subplot(132),plt.imshow(img_back, cmap = 'gray')

plt.title('Image after HPF'), plt.xticks([]), plt.yticks([])

plt.subplot(133),plt.imshow(img_back)

plt.title('Result in JET'), plt.xticks([]), plt.yticks([])

plt.show()

-

OpenCV中的傅里叶变换

OpenCV为此提供了**cv.dft**()和**cv.idft**()函数。它返回与前一个相同的结果,但是有两个通道。第一个通道是结果的实部,第二个通道是结果的虚部。输入图像首先应转换为np.float32。我们来看看怎么做。

import numpy as np

import cv2 as cv

from matplotlib import pyplot as plt

img = cv.imread('Images/rgblena.jpg',0)

dft = cv.dft(np.float32(img),flags = cv.DFT_COMPLEX_OUTPUT)

dft_shift = np.fft.fftshift(dft)

magnitude_spectrum = 20*np.log(cv.magnitude(dft_shift[:,:,0],dft_shift[:,:,1]))

plt.subplot(121),plt.imshow(img, cmap = 'gray')

plt.title('Input Image'), plt.xticks([]), plt.yticks([])

plt.subplot(122),plt.imshow(magnitude_spectrum, cmap = 'gray')

plt.title('Magnitude Spectrum'), plt.xticks([]), plt.yticks([])

plt.show()

还可以使用**cv.cartToPolar**(),它在单个镜头中同时返回幅值和相位

现在我们要做DFT的逆变换。在上一节中,我们创建了一个HPF,这次我们将看到如何删除图像中的高频内容,即我们将LPF应用到图像中。它实际上模糊了图像。为此,我们首先创建一个高值(1)在低频部分,即我们过滤低频内容,0在高频区。

import numpy as np

import cv2

from matplotlib import pyplot as plt

img = cv2.imread('Images/rgblena.jpg',0)

dft = cv2.dft(np.float32(img),flags = cv2.DFT_COMPLEX_OUTPUT)

dft_shift = np.fft.fftshift(dft)

rows, cols = img.shape

crow,ccol = rows/2 , cols/2

# create a mask first, center square is 1, remaining all zeros

mask = np.zeros((rows,cols,2),np.uint8)

mask[int(crow-30):int(crow+30), int(ccol-30):int(ccol+30)] = 1

# apply mask and inverse DFT

fshift = dft_shift*mask

f_ishift = np.fft.ifftshift(fshift)

img_back = cv2.idft(f_ishift)

img_back = cv2.magnitude(img_back[:,:,0],img_back[:,:,1])

plt.subplot(121),plt.imshow(img, cmap = 'gray')

plt.title('Input Image'), plt.xticks([]), plt.yticks([])

plt.subplot(122),plt.imshow(img_back, cmap = 'gray')

plt.title('Magnitude Spectrum'), plt.xticks([]), plt.yticks([])

plt.show()

通常,OpenCV函数**cv.dft**()和**cv.idft**()比Numpy函数更快。但是Numpy函数更容易使用。那么关于性能方面我们就不做过多的分析。

FHT算子

在这里,我只找到了源代码:

来自这个博主:(1条消息) 哈尔(Haar)小波变换的原理及opencv源代码_kuweicai的博客-CSDN博客_haar函数

// verified on opencv4.2.0

# include<opencv.hpp>

# include<iostream>

using namespace std;

using namespace cv;

int main()

{

Mat img = imread("Lena.jpg", cv::IMREAD_GRAYSCALE);

int width = img.cols;

int height = img.rows;

int depth = 2;

int depthcount = 1;

Mat tmp = Mat::ones(img.size(), CV_32FC1);

Mat wavelet = Mat::ones(img.size(), CV_32FC1);

Mat imgtmp = img.clone();

imshow("src", imgtmp);

imgtmp.convertTo(imgtmp, CV_32FC1, 1.0 / 255);

while (depthcount <= depth)

{

height = img.rows / depthcount;

width = img.cols / depthcount;

//calculate horizen

for (int i = 0; i < height; i++) //row

{

for (int j = 0; j < width / 2; j++) // col

{

tmp.at<float>(i, j) = (imgtmp.at<float>(i, 2 * j) + imgtmp.at<float>(i, 2 * j + 1)) / 2; //mean

tmp.at<float>(i, j + width / 2) = (imgtmp.at<float>(i, 2 * j) - imgtmp.at<float>(i, 2 * j + 1)) / 2; //diff

}

}

// calculate vertical

for (int i = 0; i < height / 2; i++)

{

for (int j = 0; j < width; j++)

{

wavelet.at<float>(i, j) = (tmp.at<float>(2 * i, j) + tmp.at<float>(2 * i + 1, j)) / 2;

wavelet.at<float>(i + height / 2, j) = (tmp.at<float>(2 * i, j) - tmp.at<float>(2 * i + 1, j)) / 2;

}

}

imgtmp = wavelet;

depthcount++;

}

normalize(wavelet, wavelet, 0, 1, cv::NORM_MINMAX);

imshow("wavelet", wavelet);

waitKey(0);

return 0;

}最后的评估

Canny方法不易受噪声干扰,能够检测到真正的弱边缘。优点在于,使用两种不同的阈值分别检验强边缘与弱边缘,并且当弱边缘和强边缘相连时,才能将弱边缘包含在输出图像中,这个就是我上上篇中推导Canny边缘检测算法,这就是利用滞后的边界跟踪。

Sobel算子检测方法对于灰度渐变和噪声较多的图像处理效果较好,Sobel算子对边缘定位不是很准确,图像的边缘不止一个像素,如果对于精度要求不高,可以选择这个。

对于FFT与FHT,由于本人学识有限,在此不做评价。