大家好,我是小曾哥,今天主要给大家分享一篇本方向(智慧教育-计算机自适应测评)最相关的论文

论文题目:Fully Adaptive Framework: Neural Computerized Adaptive Testing for Online Education

完全自适应框架:用于在线教育的神经计算机化自适应测试

是由中科大陈恩红老师课题组发表在AAAI2022的一篇论文。

下载通道1:https://download.csdn.net/download/qq_36317312/85058672

下载通道2:https://www.aaai.org/AAAI22Papers/AAAI-3296.ZhuangY.pdf

文章目录

Abstract

计算机自适应测评(CAT)目标:用少量的选题准确测量学生在所需学科/领域的熟练程度。

主要组成部分:

1)认知诊断模型(CDM)根据学生以前的反应来估计她目前的熟练程度。

2)选择算法根据她在CDM中估计的熟练程度选择下一个问题。

直接开门见山,提出传统方法的缺点。

传统方法法不足:

1、首先,选择算法的效率严重依赖于熟练程度估计的准确性,不能直接捕捉学生与问题之间的复杂关系。

2、现有算法通常遵循不灵活的模型特定方式,即需要为其指定的CDM预先定义度量。

文章核心:本文提出了一种无度量、可学习的神经计算机自适应测试(NCAT)框架,该框架将CAT形式化地定义为一个强化学习问题,直接从实际数据中学习选择算法。

Introduction

类似内容可看:BOBCAT: 基于双层优化的计算机化自适应测验

在本文章中就主要介绍传统选题算法的局限性:

1、对于学生来说,选择算法的效率在很大程度上取决于当前估计 θ 的准确性,缺乏稳健性,可能使用单个 θ 来总结学生与问题之间的复杂交互导致严重的信息丢失。

2、对于 CDM,必须详细了解特定 CDM 如何工作以设计匹配的选择算法。【MAAT利用 CDM 的输出不确定性来实现与模型无关,但也忽略了单个 CDM 中的不同特征】

3、对于问题,这种预定义的算法通常在选择中具有个体“偏好”,这不可避免地影响曝光控制并降低测试安全性。

motivation:

贡献:提出了一个名为神经计算机自适应测试(NCAT)的完全自适应框架,而不是手工设计另一种复杂的选择算法。

1、为了使选择算法可学习并直接捕获给定 CDM 的学生交互和特征,我们将其重新定义为双层优化的目标,为了模拟 CAT 中的动态交互并有效解决优化问题,我们将其正式转化为等效的强化学习问题。

【将完全自适应选择算法定义为一个双层优化问题,并采用强化学习框架来解决它】

2、提出了一种具有双通道性能学习和矛盾学习模块的注意力神经策略,用于在真实的CAT环境下建模复杂的非线性关系。

3、在三个真实数据集上进行了广泛的实验,以证明我们的NCAT方法及其所学知识的有效性。

Related Work

NCAT Framework

从双层优化的角度将NCAT中的可学习选择算法形式化,然后将其转化为等价的强化学习问题来有效地解决。

问题描述

元组(Q,A) ----Q 代表问题,A 回答状况

问题组 J ={q1 , q2 , q3 , q4 |J}

一个完整的CAT系统包括两个组成部分:

1、CDM :通过预测考生答对问题的概率qj(二进制分类)来模拟考生的熟练程度,记为M(qj|θ)∈[0,1],其中j是题库中的索引。

2、问题选择算法 π 根据 M 中的当前估计 ^θ 从 J 中选择。更具体地说,在轮∈[1,T]中,CAT为学生选择一个问题qj(T)∼π(ˆθt−1)。收到回复j(T)后,M更新和估计新的熟练程度ˆθt。

定长和变长:在测试结束时让估计的熟练程度接近θ0,即ˆθT→θ0。

可学习选择算法

主要内容:可以直接从大规模学生回答数据中学习的双层优化问题的目标。

N : 表示响应数据集中的学生人数

通过N个学生的反应来训练选择算法π

对于每个学生,π依次选择一个问题{qj(1),…qj (t)},观察他们的回答以评估熟练程度,并利用它来优化π对一组元问题Γi,Ji为学生提供所有可用的考生问题, J i ∩ Γ i = ∅ \mathcal{J}_{i} \cap \Gamma_{i}=\emptyset Ji∩Γi=∅,支持集和查询集是为数据集中的每个学生随机选择的。

受到元学习方法的启发,将NCAT中的选择算法πφ重塑为双层优化目标,具体思想类似于之前BOBCAT: 基于双层优化的计算机化自适应测验这篇文章,感兴趣的同学可以看一下。

minimize ϕ 1 n ∑ i = 1 n ∑ t = 1 T 1 ∣ Γ i ∣ ∑ j ∈ Γ i l ( a i j , M ( q j ∣ θ ^ i t ) ) ( 2 ) s.t. θ ^ i t = arg min θ i ∑ j ∈ { j i 1 , … , j i t } l ( a i j , M ( q j ∣ θ i ) ) ( 3 ) \begin{aligned} &\underset{\phi}{\operatorname{minimize}} \frac{1}{n} \sum_{i=1}^{n} \sum_{t=1}^{T} \frac{1}{\left|\Gamma_{i}\right|} \sum_{j \in \Gamma_{i}} l\left(a_{i j}, \mathcal{M}\left(q_{j} \mid \hat{\theta}_{i}^{t}\right)\right) (2) \\ &\text { s.t. } \quad \hat{\theta}_{i}^{t}=\underset{\theta_{i}}{\arg \min } \sum_{j \in\left\{j_{i}^{1}, \ldots, j_{i}^{t}\right\}} l\left(a_{i j}, \mathcal{M}\left(q_{j} \mid \theta_{i}\right)\right) (3) \end{aligned} ϕminimizen1i=1∑nt=1∑T∣Γi∣1j∈Γi∑l(aij,M(qj∣θ^it))(2) s.t. θ^it=θiargminj∈{ ji1,…,jit}∑l(aij,M(qj∣θi))(3) where j i t ∼ π ( q j ( 1 ) , a i , j ( 1 ) , … , q j ( t − 1 ) , a i , j ( t − 1 ) ; ϕ ) . \text { where } \quad j_{i}^{t} \sim \pi\left(q_{j(1)}, a_{i, j(1)}, \ldots, q_{j(t-1)}, a_{i, j(t-1)} ; \phi\right) \text {. } where jit∼π(qj(1),ai,j(1),…,qj(t−1),ai,j(t−1);ϕ).

在内层优化(Eq.(3))中,学生 i 的支持集中由算法 π 根据她之前的反应顺序选择; 然后,我们最小化 二元交叉熵损失 l(·) 以估计外层的^θt 。 在外层优化(Eq.(2))中,我们最小化学生查询集上的二元交叉熵损失来学习目标选择算法 π 给定当前 ^θ(在内层估计)。

双层优化的优点:

(1)能力估计的误差主要是由所选问题的差异引起的,这进一步指导了π的优化。由于真实的θ0未知,我们利用查询集上的估计ˆθti的拟合来测量外部级别的这种误差。

(2)由于测试可能会根据不同的停止规则在任何时间/步骤停止,因此我们简化了目标,并将所有测试步骤相加以最小化损失,这些解决方案不同于之前基于双层的方法BOBCAT。

(3)算法π也是模型不可知的。更重要的是,通过优化该问题以进行有效选择,它可以自动适应给定的CDM。一旦学习了问题选择算法,它就不需要在CAT过程中进行更新,而是根据之前的回答自适应地选择下一个问题。

强化学习优化

强化学习简介

强化学习第一层结构:基本元素

Agent----与环境进行互动的主体(可以认为是玩家)

Environment----环境

Goal----目标

强化学习过程:是玩家在与环境的互动中为了达成一个目标而学习的过程

环境是什么?目标又是什么?

强化学习的第二层结构:主要元素

State----状态

Action----在一个状态下,玩家需要做出某种行动,叫做Action

Reward----Agent在一个状态之下采取了特定的行动之后所得到的即时的反馈

举个例子----围棋

1、围棋的状态比较简单,就是棋盘上的361个落子点多状态整体,对于每个落子点来说可以有三种状态:黑棋、白棋、空 ;那么整个围棋的状态就是3的361次方

2、在围棋中,黑棋先手,在当前状态是棋盘中没有落子,因此黑棋就有361种可能的行动,可以在任何一个位置进行落子。

3、当在棋盘中放置黑子后,那么目前的棋盘状态就已经发生改变,因此就在下一个状态的情况下,开始进行白棋落子,这样状态和动作的往复就构成了强化学习的主体部分

4、在围棋中,玩家的目标是赢得棋局,只有在达到赢棋的状态时才有一个大于0的奖励,可以认为赢棋的奖励为1,输棋或者和棋设置的奖励为0【奖励由最终的目标所决定的】

强化学习的第三层结构:核心元素

Policy----策略,在数学中可以是一个函数,输入某种状态,那么输出的就是一个行动

Value----价值,同样也是一个函数,策略函数就取决于价值函数

策略:在围棋中,将当前的棋盘的状态告诉这个策略函数,那么就会告诉你下一步应该在下在哪个位置,强化学习想达到的最终效果,就是一个好的策略

价值主要包括State Value 状态价值函数,输入状态,输出状态的价值(预期将来得到的所有奖励之和)

应用在计算机自适应测评(CAT)中,就是在选题算法模块;

学生S = Agent,选择的题目就是Action ,通过对题目的反应的情况,作为State,那么对于CAT中reward怎么定义是一个值得考虑的问题。

具体细节

我们注意到无度量选择算法πφ可以通过优化一个双层优化问题来学习。

min ϕ 1 n ∑ i = 1 n ∑ t = 1 T 1 ∣ Γ i ∣ ∑ j ∈ Γ i l ( a i j , M ( q j ∣ θ ^ i t ) ) ≜ max ϕ E i ∼ π ϕ [ ∑ t = 1 T − 1 ∣ Γ i ∣ ∑ j ∈ Γ i l ( a i j , M ( q j ∣ θ ^ i t ) ) ] = max ϕ E i ∼ π ϕ [ ∑ t = 1 T − L M ( Γ i , θ ^ i t ) ] \begin{aligned} & \min _{\phi} \frac{1}{n} \sum_{i=1}^{n} \sum_{t=1}^{T} \frac{1}{\left|\Gamma_{i}\right|} \sum_{j \in \Gamma_{i}} l\left(a_{i j}, \mathcal{M}\left(q_{j} \mid \hat{\theta}_{i}^{t}\right)\right) \\ \triangleq & \max _{\phi} \mathbb{E}_{i \sim \pi_{\phi}}\left[\sum_{t=1}^{T}-\frac{1}{\left|\Gamma_{i}\right|} \sum_{j \in \Gamma_{i}} l\left(a_{i j}, \mathcal{M}\left(q_{j} \mid \hat{\theta}_{i}^{t}\right)\right)\right] \\ =& \max _{\phi} \mathbb{E}_{i \sim \pi_{\phi}}\left[\sum_{t=1}^{T}-\mathcal{L}_{\mathcal{M}}\left(\Gamma_{i}, \hat{\theta}_{i}^{t}\right)\right] \end{aligned} ≜=ϕminn1i=1∑nt=1∑T∣Γi∣1j∈Γi∑l(aij,M(qj∣θ^it))ϕmaxEi∼πϕ⎣⎡t=1∑T−∣Γi∣1j∈Γi∑l(aij,M(qj∣θ^it))⎦⎤ϕmaxEi∼πϕ[t=1∑T−LM(Γi,θ^it)]

其中LM(·)代表的是给定预测变量M的元问题集上的平均二元交叉熵损失

双层优化问题在强化学习中转化为最大化预期累积奖励(即−LM(Γi,ˆθti)),将−LM(Γi,ˆθti)作为强化学习的Reward。

⟨ S , A , P , R , γ ⟩ \langle S, A, P, R, \gamma\rangle ⟨S,A,P,R,γ⟩

S:一组状态 st= {qj(1), ai,j(1), …, qj(t−1), ai,j(t−1)}

A:题库

P: 在st状态采取动作qj(T)后看到状态st+1的概率【(P(st+1|st,qj(T))】

R: t轮每个学生元问题集估计熟练度的负损失

给定学生先前的回答和特定的CDM,哪个问题最适合准确地测量其水平;实际上,学生回答的转换、熟练程度评估和选择算法的决策过程相互影响和依赖,演化为一个复杂的系统。因此,与将计算机辅助教学的动态作为一个整体进行优化相比,RL框架可以从长远的角度为不同的学生探索更多“最适合”的问题。

Attentive Neural Selection Algorithm

基于上述强化学习中的NCAT框架,用分层注意力神经网络实现了强化学习中的选择算法,用于建模学生与问题之间的复杂交互。

在图2(B)中,我们展示了它的体系结构,它主要由双通道性能学习(PL)组件、矛盾学习(CL)组件和策略层组成。

首先,PL分别捕获学生复杂的表现信息,因为对学生的正确和错误回答通常是不平衡的(即,错误回答通常比正确回答少得多)

第二, CL 识别并提取学生成绩中的矛盾,试图缓解干扰(即猜测和失误)的影响

第三,策略层进行下一步选择,利用Q-Learning的方法进行优化。

问题嵌入:

s t = { q j ( 1 ) , a i , j ( 1 ) , … , q j ( t − 1 ) , a i , j ( t − 1 ) } : 学 生 i 回 答 q j 的 结 果 s_{t}=\left\{q_{j(1)}, a_{i, j(1)}, \ldots, q_{j(t-1)}, a_{i, j(t-1)}\right\}:学生i回答qj的结果 st={

qj(1),ai,j(1),…,qj(t−1),ai,j(t−1)}:学生i回答qj的结果

E1:正确的嵌入矩阵;E0:错误的嵌入矩阵

双通道性能学习(PL)

为了更好地代表学生的表现(即观察st),我们首先通过使用如图2所示的双通道自我注意网络来分别处理正确和不正确的回答。假设k0和k1分别代表轮中不正确和正确的回答的数量。用z∈{0,1}表示回答的问题为两个嵌入矩阵,Ezt(1表示正确,否则为0)。 S t z = Attention ( E t z W 1 z , c , E t z W 1 z , k , E t z W 1 z , v ) \mathbf{S}_{t}^{z}=\operatorname{Attention}\left(\mathbf{E}_{t}^{z} \mathbf{W}_{1}^{z, c}, \mathbf{E}_{t}^{z} \mathbf{W}_{1}^{z, k}, \mathbf{E}_{t}^{z} \mathbf{W}_{1}^{z, v}\right) Stz=Attention(EtzW1z,c,EtzW1z,k,EtzW1z,v)

这些预测使模型更加灵活

Attention ( C , K , V ) = softmax ( C K ⊤ h ) V \operatorname{Attention}(\mathbf{C}, \mathbf{K}, \mathbf{V})=\operatorname{softmax}\left(\frac{\mathbf{C K}^{\top}}{\sqrt{h}}\right) \mathbf{V} Attention(C,K,V)=softmax(hCK⊤)V

其中C表示查询,K表示键,V表示值(每行表示一个问题)。

为了赋予模型非线性,并考虑不同潜在维度之间的相互作用,我们将逐点两层前馈网络应用于St

F t z = FFN ( S t z ) = ReLU ( S t z W ( 1 ) + b ( 1 ) ) W ( 2 ) + b ( 2 ) \mathbf{F}_{t}^{z}=\operatorname{FFN}\left(\mathbf{S}_{t}^{z}\right)=\operatorname{ReLU}\left(\mathbf{S}_{t}^{z} \mathbf{W}^{(1)}+\mathbf{b}^{(1)}\right) \mathbf{W}^{(2)}+\mathbf{b}^{(2)} Ftz=FFN(Stz)=ReLU(StzW(1)+b(1))W(2)+b(2)RELU 线性单位,权矩阵W(1),W(2)是Rd*d的形状,b代表偏置

{F0t,F1t}是此双通道性能学习组件的输出

矛盾学习(CL)

学生在计算机辅助测试中行为的复杂性主要体现在猜测和失误因素上:例如,当面对有4个选项的选择题时,即使学生没有掌握答案,也有25%的机会答对(即猜测因素);当面对简单的问题时,可能有很小的机会(例如5%)答错(即失误因素)。

当出现猜测或滑移因素时,正确的回答和不正确的回答之间可能会有一些矛盾。例如,学生答对了乘法题(较难),但回答错了加法题(较简单)。因此,可能的矛盾是:乘法可能是猜测的,也可能是加法中的滑移因子,或者两者兼而有之。

我们设计了一种新颖的双注意操作来捕捉正确和错误回答之间的矛盾:

α i j = W 2 0 , c q i 0 ⋅ ( W 2 1 , k q j 1 ) ⊤ h \alpha_{i j}=\frac{\mathbf{W}_{2}^{0, c} \mathbf{q}_{i}^{0} \cdot\left(\mathbf{W}_{2}^{1, k} \mathbf{q}_{j}^{1}\right)^{\top}}{\sqrt{h}} αij=hW20,cqi0⋅(W21,kqj1)⊤

其中αij是问题q0i和q1j的矛盾分数,权重矩阵w0,c2,w1,k2是形Rd×d,所有的αij形成分数矩阵A∈Rk0×k1

在这里类似于计算答对和答错题目之间的相似性,越相似,那么这题目之间的记录就容易出现猜测或者滑移的情况。

然后,分别从行维和列维两个维度用Softmax函数对矛盾得分进行归一化。

α ~ i j = exp ( α i j ) ∑ j = 1 k 1 exp ( α i j ) \widetilde{\alpha}_{i j}=\frac{\exp \left(\alpha_{i j}\right)}{\sum_{j=1}^{k_{1}} \exp \left(\alpha_{i j}\right)} α ij=∑j=1k1exp(αij)exp(αij) and α ~ i j = exp ( α i j ) ∑ i = 1 k 0 exp ( α i j ) \widetilde{\alpha}_{i j}=\frac{\exp \left(\alpha_{i j}\right)}{\sum_{i=1}^{k_{0}} \exp \left(\alpha_{i j}\right)} α ij=∑i=1k0exp(αij)exp(αij) form A ~ 0 , A ~ 1 ∈ R k 0 × k 1 \widetilde{\mathbf{A}}_{0}, \widetilde{\mathbf{A}}_{1} \in \mathbb{R}^{k_{0} \times k_{1}} A 0,A 1∈Rk0×k1 respectively

为了进一步提取矛盾问题对的信息,我们使用性能学习中生成的矩阵F0t和F1分别与分数矩阵A0、EA1(即具有Softmax的矩阵)进行双注意和前馈操作。

F t 01 = FFN ( A ~ 1 ⊤ F t 0 ) , F t 10 = FFN ( A ~ 0 F t 1 ) \mathbf{F}_{t}^{01}=\operatorname{FFN}\left(\widetilde{\mathbf{A}}_{1}^{\top} \mathbf{F}_{t}^{0}\right), \mathbf{F}_{t}^{10}=\operatorname{FFN}\left(\widetilde{\mathbf{A}}_{0} \mathbf{F}_{t}^{1}\right) Ft01=FFN(A

1⊤Ft0),Ft10=FFN(A

0Ft1)

其中F01t∈Rk1×d 和F10t∈Rk0×d 分别是两个通道中问题的矛盾特征矩阵

策略层

在多个注意块自适应地、分层地提取先前回答的信息之后,我们基于四个矩阵{F0t,F1t,F01t,F10t}来预测下一次选择的得分。

表示选择每个问题的预测累积奖励/值 Qφ(st,·)=[Qφ(st,q1),…,Qφ(st,Q|J|)],策略层由两个前馈层处理。

Q ϕ ( s t , ⋅ ) = ReLU ( u t W ( 1 ) + b ( 1 ) ) W ( 2 ) + b ( 2 ) Q_{\phi}\left(s_{t}, \cdot\right)=\operatorname{ReLU}\left(\mathbf{u}_{t} \mathbf{W}^{(1)}+\mathbf{b}^{(1)}\right) \mathbf{W}^{(2)}+\mathbf{b}^{(2)} Qϕ(st,⋅)=ReLU(utW(1)+b(1))W(2)+b(2)

通过使用该框架,在传统的RL算法中,选择Q值最大的问题和估计的Qφ(st,·)来产生选择。

问题选择(Question Selection):选择问题的概率与其在给定状态下的Q值成正比

Pr ( q j ∣ s t ) = e Q ( s t , q j ) / ν ∑ q ∈ J e Q ( s t , q ) / ν \operatorname{Pr}\left(q_{j} \mid s_{t}\right)=\frac{e^{Q\left(s_{t}, q_{j}\right) / \nu}}{\sum_{q \in \mathcal{J}} e^{Q\left(s_{t}, q\right) / \nu}} Pr(qj∣st)=∑q∈JeQ(st,q)/νeQ(st,qj)/ν

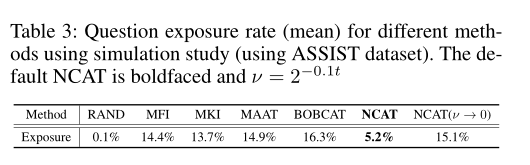

ν是在测试过程中缓慢降低的参数、以便在接近尾声时进行更贪婪的选择,通过在测试开始时引入随机性,可以根据不同的起始点来丰富选择的问题和测试路径。随着测试的进行,选择的确定性不断增加。

当ν→为0时,公式(6)等同于Arg Maxqφ,显然,完全随机化是最简单的曝光控制方法,可以产生相同的曝光率。然而,它与选择“最佳匹配”问题以加快测量过程的想法相冲突。

测量精度和曝光率之间的平衡将在后续的实验中进一步研究。

Policy Learning

我们使用Q-Learning学习策略权重φ

在第三步中,选择代理观察状态,并使用ε-贪婪策略w选择问题qj(t)。

我们将经验(st,qj(t),ai,j(t),st1)存储在一个大的回放缓冲区中,在小批量训练中采集样本。通过调整φ使均方损失函数最小化,我们改进了值函数qφ(st,qj(t))

l ( ϕ ) = E ( s t , q j ( t ) , a i , j ( t ) , s t + 1 ) ∼ M [ ( y t − Q ϕ ( s t , q j ( t ) ) ) 2 ] y t = r i ( s t , q j ( t ) ) + γ max q j ( t + 1 ) ∈ J i Q ϕ ( s t + 1 , q j ( t + 1 ) ) \begin{aligned} l(\phi) &=\mathbb{E}_{\left(s_{t}, q_{j(t)}, a_{i, j(t)}, s_{t+1}\right) \sim \mathrm{M}}\left[\left(y_{t}-Q_{\phi}\left(s_{t}, q_{j(t)}\right)\right)^{2}\right] \\ y_{t} &=r_{i}\left(s_{t}, q_{j(t)}\right)+\gamma \max _{q_{j(t+1)} \in \mathcal{J}_{i}} Q_{\phi}\left(s_{t+1}, q_{j(t+1)}\right) \end{aligned} l(ϕ)yt=E(st,qj(t),ai,j(t),st+1)∼M[(yt−Qϕ(st,qj(t)))2]=ri(st,qj(t))+γqj(t+1)∈JimaxQϕ(st+1,qj(t+1))

EXPERIMENTS

实验设置

数据集:ASSIST、NIPS-EDU和EXAM

ASSSIT:在线辅导系统ASSISTments,记录学生关于数学和与问题相关的知识概念的实践日志.

NIPS-EDU:NeurIPS 2020教育挑战赛中的数据集

Exam1收集自在线教育系统,该系统为学生提供日常作业、考试和学习评估。它收集了初中生的数学习题记录。

训练、测试、评估:对所有数据集进行5倍交叉验证;对于每个折叠,我们分别使用60%-20%-20%的学生进行培训、验证和测试。我们将每个学生回答的问题划分为培训(Ji70%)和元(Γi,30%)问题集。

在测试中,1)我们使用不同的方法选择问题;2) CDM用相应的响应更新估计;3) 评估CDM在元集Γi上预测二元值学生反应的表现。因此,我们使用准确度(ACC)和ROC下面积(AUC)作为指标来评估不同选择算法的性能。

比较方法:CAT中的选择算法需要依赖于上述认知诊断模型(CDM)。我们的实验主要涉及两个经典的CDM:传统的项目反应理论(Embretson和Reise 2013)和最近提出的深度学习模型(例如NCDM(Wang et al.2020a))。

MFI:使用最广泛的选择策略之一,选择具有最大Fisher信息的策略。此方法仅依赖于IRT

KLI:它使用Kullback-Leibler信息来测量两个连续的熟练程度后验值之间的差异。

BOBCAT(Ghosh和Lan 2021):这是CAT第一个学习数据驱动选择算法并提出近似梯度估计方法的双层优化框架。它对潜在的CDM是不可知的。

MAAT(Bi等人,2020):它提出了一种基于主动学习的方法,通过计算每个问题引起的预期模型变化(EMC)来衡量问题的信息量。

RAND:随机选择策略是量化其他方法改进的基准。

精度(AUC/ACC)比较

(1)我们可以看到,NCAT在三个基准数据集和所有步骤的准确性和AUC方面取得了最佳性能,显著优于最先进的方法。这意味着我们提出的方法可以快速捕捉学生的反应模式,为他们选择最合适的问题,并使这种策略适应新学生。

(2) NCAT和BOBCAT都显著优于其他预固定选择算法(如MAAT)。这表明,从数据中显式学习选择算法可以提高CAT的效率。与BOBCAT相比,NCAT强化学习框架能够利用我们提出的注意机制提高选择效率。

知识点覆盖率

E在每个测试步骤中,他们所选问题中所涵盖的知识概念(如数学中的代数和几何)的比例

Cov ( π ) = 1 ∣ K ∣ ∑ k ∈ K 1 [ k ∈ J t ] \operatorname{Cov}(\pi)=\frac{1}{|K|} \sum_{k \in K} \mathbb{1}\left[k \in \mathcal{J}_{t}\right] Cov(π)=∣K∣1k∈K∑1[k∈Jt]

在NCAT中,覆盖率在测试期间增长相对较快,接近1的极限。直观地说,在选定的问题中最大限度地扩大概念覆盖范围,使学生的测量和诊断更加全面。结果表明,在RL框架下探索和增加选择中的概念多样性可以提高CAT的准确性

复杂运动交互(RQ3)

行为记录中的矛盾:

Q2335(正确)和q2348(不正确)之间的矛盾得分高于其他配对,并且正确比不正确更难。这表明在q2335中可能存在猜测因素,在q2348中可能存在滑移因素,或者两者兼而有之。同时,虽然q2335和q4804的难度与上述相似,但得分要低得多。这是直观的,它们之间的知识概念的关联性低于q2335和q2348之间的关联性,从而忽略了它们之间的矛盾。

这些观察结果表明,我们提出的NCAT可以提供一种很好的方式来捕捉问题和学生之间的复杂关系,以便进行更好的选择。

熟练程度的估计和猜测和失误。

人工构建学生的熟练程度θ0并产生相应的反应,用于水平估计。因此,我们使用均方误差(MSE)对所有构建的学生进行评估.

我们用简单的IRT进行这一操作,并利用在整个数据集上学习的熟练程度参数作为基本事实,而不是生成它们。我们可以看到,即使在存在多重扰动的情况下,NCAT框架在MSE度量上也表现良好,进一步证实了其在熟练程度估计中的高准确性和鲁棒性。

M S E = E ∥ θ ^ − θ 0 ∥ MSE = \mathbb{E}\left\|\hat{\theta}-\theta_{0}\right\| \\ MSE=E∥∥∥θ^−θ0∥∥∥

消融实验

NCA T-C和NCA T-P:它们是NCAT的变体,分别只使用矛盾学习和绩效学习模块。

NCA T-C 仅仅捕捉学生观察到的成绩存在矛盾,但禁止通过性能学习生成矩阵,这大大降低了其准确性。

NCAT-P的表现比默认的差,因为它忽略了学生成绩中的扰动,这使我们能够安全地得出结论:考虑到矛盾方面,对学生与问题之间的复杂交互进行建模是可取的。

ν→0表示策略是确定性的,它选择具有最大Q值的问题。

不足为奇的是,尽管其结果略好于默认设置,但NCA T结合表3中的结果实现了精确度和曝光控制之间的平衡。

结论

在本文中,我们提出了一个完全自适应的CAT框架,称为NCAT,它为在线教育提供了一种从真实数据中学习选择算法的通用方法。具体来说,为了克服手动设计的选择算法的局限性,NCAT被重新编码并在有效的强化学习环境中解决。此外,本文还提出了一种专注的神经选择算法,用于模拟测试中复杂的非线性交互作用。大量实验表明,NCAT可以成功地捕捉学生与问题之间的复杂关系(例如猜测和失误因素),并准确测量学生的熟练程度,缩短考试时间。

到此为止,本篇文章讲解结束,还是建议大家看论文原文,如果有不懂的问题,欢迎在评论区进行沟通交流,小曾哥有时间尽量给大家解答!

如果觉得有收获,还请不要吝啬你手里的赞,谢谢小伙伴们了!