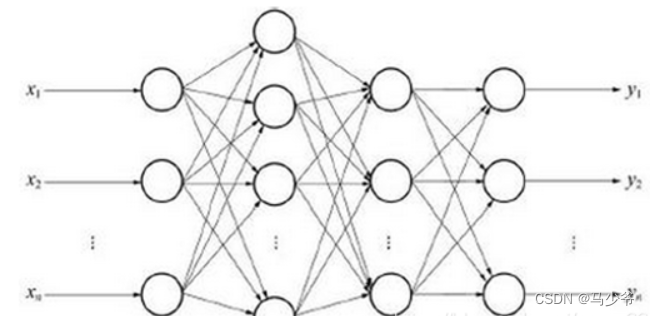

PNN,Probabilistic Neural Networks,即概率神经网络[43~45]是一种基于贝叶斯决策规则的神经网络技术,其神经网络的训练期望误差较小,是一种基于统计原理的人工神经网络。概率神经网络以Parzen窗口函数为激活函数,其同时包含了径向基神经网络与经典的概率密度估计算法的优势,因此在识别与分类方面,与传统的BP神经网络相比具有较为明显的性能优势。 其结构如下:

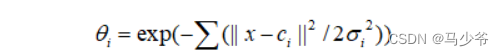

从图的结构可知,PNN概率神经网络从结构上划分主要包括PNN输入层,PNN样本层,PNN求和层以及PNN竞争输出层四个网络层次。其中样本层的主要功能是将输入的信号进行加权求和运算,并通过一个激活函数运算后送给下一层,其中激活函数为高斯函数,即:

其中,Ci为径向基函数的中心,delta_i表示特性函数第i个分量对弈的开关参数。

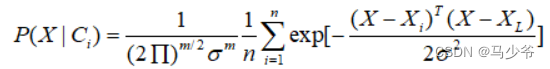

概率神经网络的求和层中各个网络单元需要和对应类别的模式单元相连接,而各个单元需要根据Parzen方法求和估计各类的概率,即其条件概率为:

其中,公式中变量表示类别,变量X表示识别样本,变量表示类别i的模式样本(在概率神经网络中做为权值),变量m表示向量维数,变量表示平滑参数,变量n表示类i的模式样本数量。

和传统的神经网络相比,PNN神经网络最大的优势在于其不需要进行多次计算,就可以获得收敛的Bayes优化解。因此,在进行调试识别的时候,采用PNN神经网络,可以以较少的训练次数获得所期望的测试结果。

概率神经网络的优点

训练容易,收敛速度快,从而非常适用于实时处理。在基于密度函数核估计的PNN网络中,每一个训练样本确定一个隐含层神经元,神经元的权值直接取自输入样本值。可以实现任意的非线性逼近,用PNN网络所形成的判决曲面与贝叶斯最优准则下的曲面非常接近。

隐含层采用径向基的非线性映射函数,考虑了不同类别模式样本的交错影响,具有很强的容错性。只要有充足的样本数据,概率神经网络都能收敛到贝叶斯分类器,没有BP网络的局部极小值问题。

隐含层的传输函数可以选用各种用来估计概率密度的基函数,且分类结果对基函数的形式不敏感。

扩充性能好。网络的学习过程简单,增加或减少类别模式时不需要重新进行长时间的训练学习。

各层神经元的数目比较固定,因而易于硬件实现。

**

1、神经网络优缺点**

优点: 神经网络有很强的非线性拟合能力,可映射任意复杂的非线性关系,而且学习规则简单,便于计算机实现。具有很强的鲁棒性、记忆能力、非线性映射能力以及强大的自学习能力,因此有很大的应用市场。

缺点:

(1)最严重的问题是没能力来解释自己的推理过程和推理依据。

(2)不能向用户提出必要的询问,而且当数据不充分的时候,神经网络就无法进行工作。

(3)把一切问题的特征都变为数字,把一切推理都变为数值计算,其结果势必是丢失信息。

(4)理论和学习算法还有待于进一步完善和提高。

2、SVM的优缺点

优点:

(1)非线性映射是SVM方法的理论基础,SVM利用内积核函数代替向高维空间的非线性映射;

(2)对特征空间划分的最优超平面是SVM的目标,最大化分类边际的思想是SVM方法的核心;

(3)支持向量是SVM的训练结果,在SVM分类决策中起决定作用的是支持向量.

(4)SVM 是一种有坚实理论基础的新颖的小样本学习方法.它基本上不涉及概率测度及大数定律等,因此不同于现有的统计方法.从本质上看,它避开了从归纳到演绎的传统过程,实现了高效的从训练样本到预报样本的“转导推理”,大大简化了通常的分类和回归等问题.

(5)SVM 的最终决策函数只由少数的支持向量所确定,计算的复杂性取决于支持向量的数目,而不是样本空间的维数,这在某种意义上避免了“维数灾难”.

(6)少数支持向量决定了最终结果,这不但可以帮助我们抓住关键样本、“剔除”大量冗余样本,而且注定了该方法不但算法简单,而且具有较好的“鲁棒”性.这种“鲁棒”性主要体现在:

①增、删非支持向量样本对模型没有影响;

②支持向量样本集具有一定的鲁棒性;

③有些成功的应用中,SVM 方法对核的选取不敏感

SVM的缺点:

1)支持向量机算法对大规模训练样本难以实施,这是因为支持向量算法借助二次规划求解支持向量,这其中会设计m阶矩阵的计算,所以矩阵阶数很大时将耗费大量的机器内存和运算时间。

2)经典的SVM只给出二分类的算法,而在数据挖掘中,一般要解决多分类的分类问题,而支持向量机对于多分类问题解决效果并不理想。

3)现在常用的SVM理论都是使用固定惩罚系数C,但是正负样本的两种错误造成的损失是不一样的。