杨净 发自 凹非寺

量子位 | 公众号 QbitAI

人类的预测能力+ViT,会产生什么样的化学反应?

会让机器人的行动规划能力又快又准。

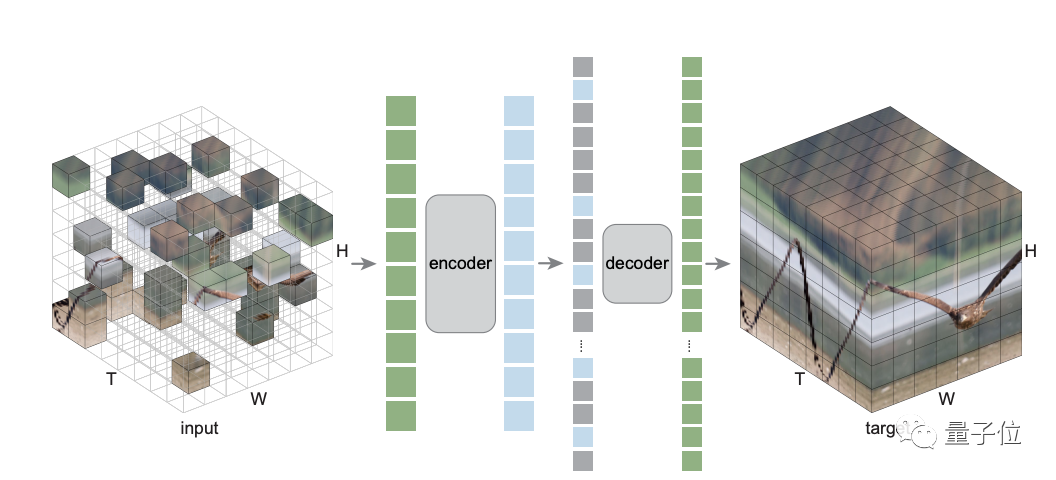

这是李飞飞团队的最新研究——MaskViT,通过MVM,掩码视觉建模对Transformer进行预训练,从而建立视频预测模型。

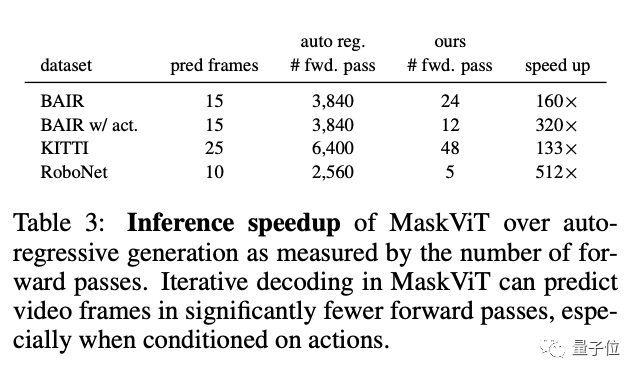

结果显示,MaskViT不仅能生成256*256视频,还可以让机器人行动规划的推理速度最高提高了512倍。

来看看这是项什么样的研究?

从人类身上找灵感

神经科学领域的研究表明,人类的认知、感知能力是有一种预测机制来支持的。

这种对世界的预测模型,可以用来模拟、评估和选择不同的可能行动。

对人类来说,这一过程是快速和准确的。

如果能赋予机器人类似的预测能力。那么他们就可以在复杂的动态环境中快速规划、执行各类任务。

比如,通过视觉模型来预测控制,也许就是一种方式,但也对算力和准确性提出了更高的要求。

于是,李飞飞团队就想到了最近诸多进展的ViT架构,以及以何恺明MAE为代表的基于MVM,Masked Visual Modeling这一自监督预训练表征。

但具体要操作起来,仍有不少的技术挑战。

一方面,全局注意力机制的复杂度与输入序列长度的平方呈正比,导致视频处理成本过高。

另一方面,视频预测任务和自回归掩码视觉预训练之间存在不一致。实际测试时,模型必须从头预测完整的未来帧序列,导致视频预测质量不好。

基于这样的背景,李飞飞团队提出了MaskViT——通过掩码视觉建模对Transformer进行预训练,从而建立视频预测模型。

具体有两种设计决策。

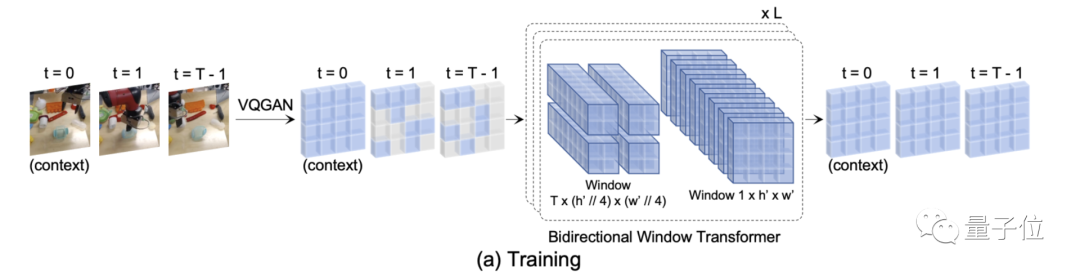

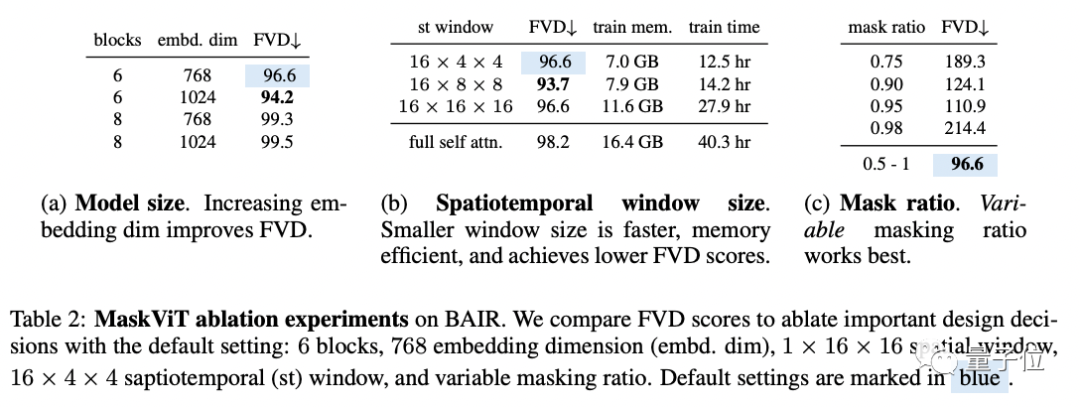

首先,为了提高记忆和训练效率,使用了两种类型的窗口注意力:空间注意力和时空注意力。

其次,训练过程中掩码的token比例是可变的。

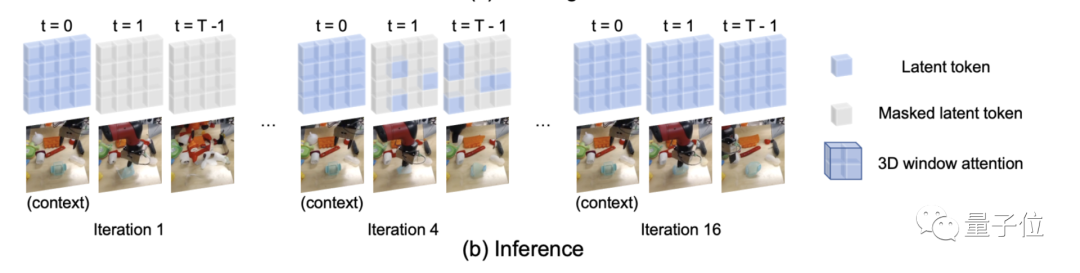

在推理阶段,视频是通过迭代细化生成的,其中按照掩码调度函数逐步降低掩码率。

实验结果

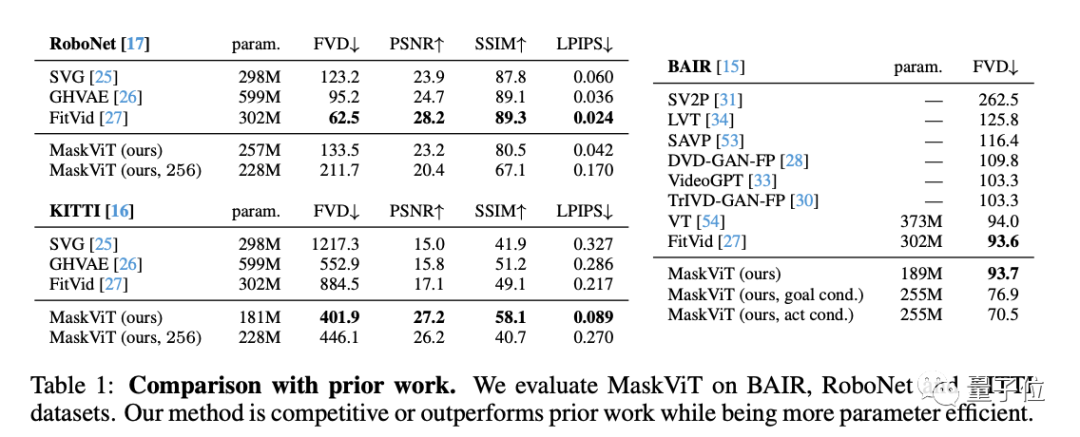

研究团队在三个不同数据集,以及四个不同指标来评估了MaskViT。

结果显示,跟以往先进的方法比较,MaskViT都表现出了更好的性能,可生成分辨率达256 × 256的视频。

还在BAIR进行了消融实验。

随后,团队还展示了真实机器人使用MaskViT进行实时规划的效果。

推理速度最高可提升512倍。

研究人员表示,本次工作表明,可以通过最小的领域知识,利用掩码视觉建模的一般框架,赋予像智能体强大的预测模型。

但同时表示,也具有一定的局限性。

比如在每帧量化时会出现闪烁伪影,尤其是在RoboNet这种有静态背景的视频中。

还有如果要扩大视频预测的规模,也仍然具有挑战性,特别是那种有大量摄像机运动的场景。

未来,他们将探索把这一视频预测方法整合到更复杂的规划算法中。

值得一提的是,在今年5月,何恺明团队曾提出过视频版MAE,并发现最佳掩蔽率高达 90%。

论文链接:

https://arxiv.org/abs/2206.11894

项目链接:

https://maskedvit.github.io/

何恺明论文:

https://arxiv.org/abs/2205.09113