写在前面:之前学习的都是简单的预测问题,涉及的函数是一维线性函数,在本节内容中,要开始介绍稍微复杂一点的神经网络了,参数w不再是1个,而是很多个!

1 梯度下降引入

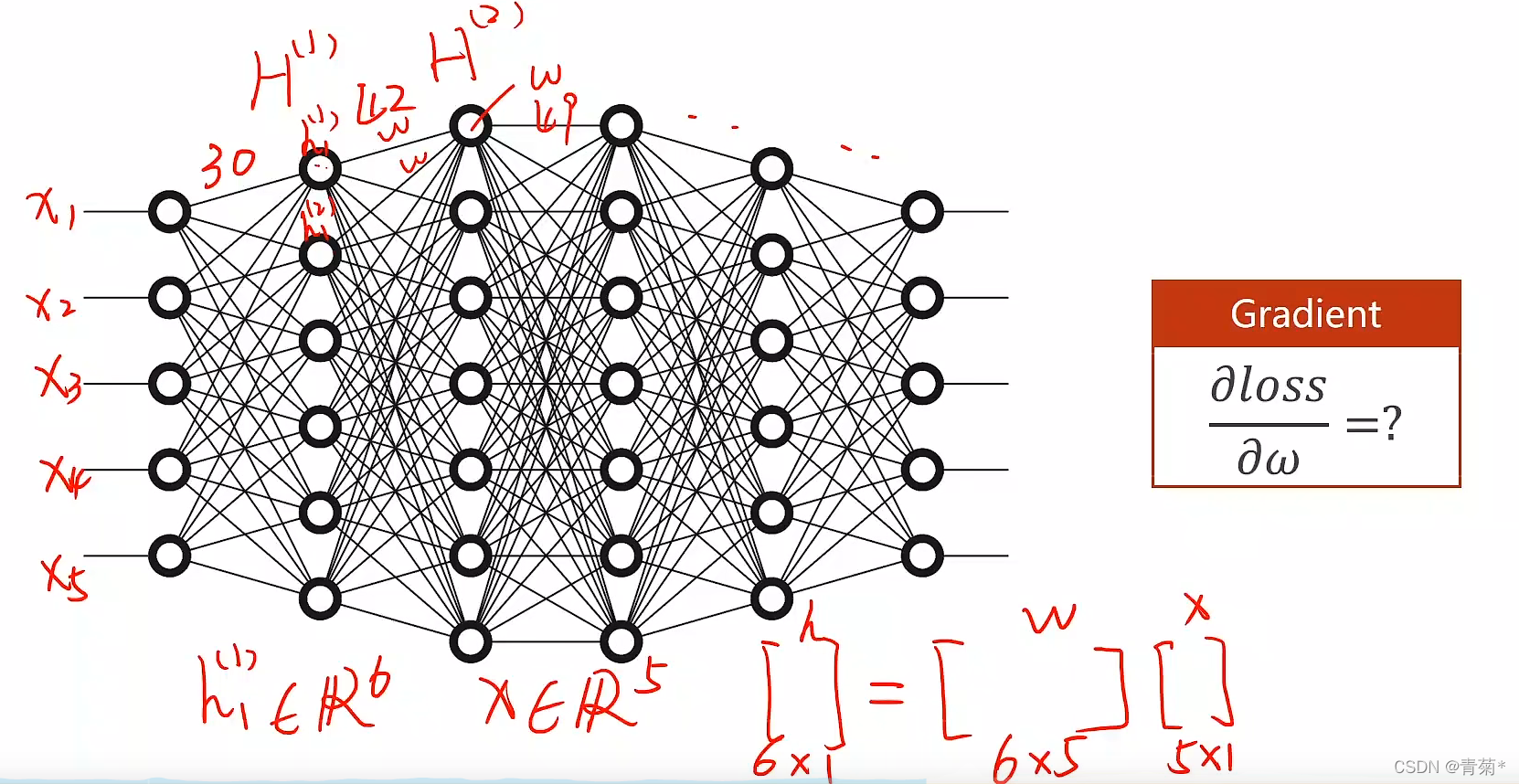

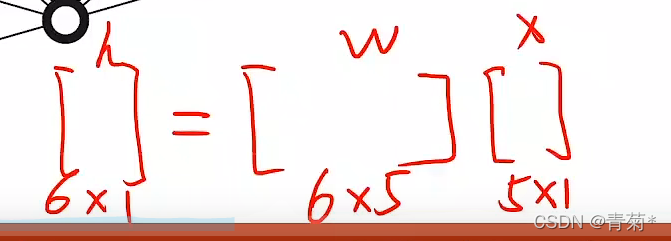

- 在第一列的五个圆圈和六个圆圈之间,我们可以看到有30条线。第一列的五个圆圈表示51的输入x,第二列表示第一层的61输出,那么中间

- 很显然是一个6*5的权重矩阵。也就是说,这里一共有30个参数。

是否能做这样一个算法,将整个网络看成一个计算图,可以在计算图上传播梯度,最后根据链式法则把梯度求出来,这种算法呢,就可以称之为反向传播算法。

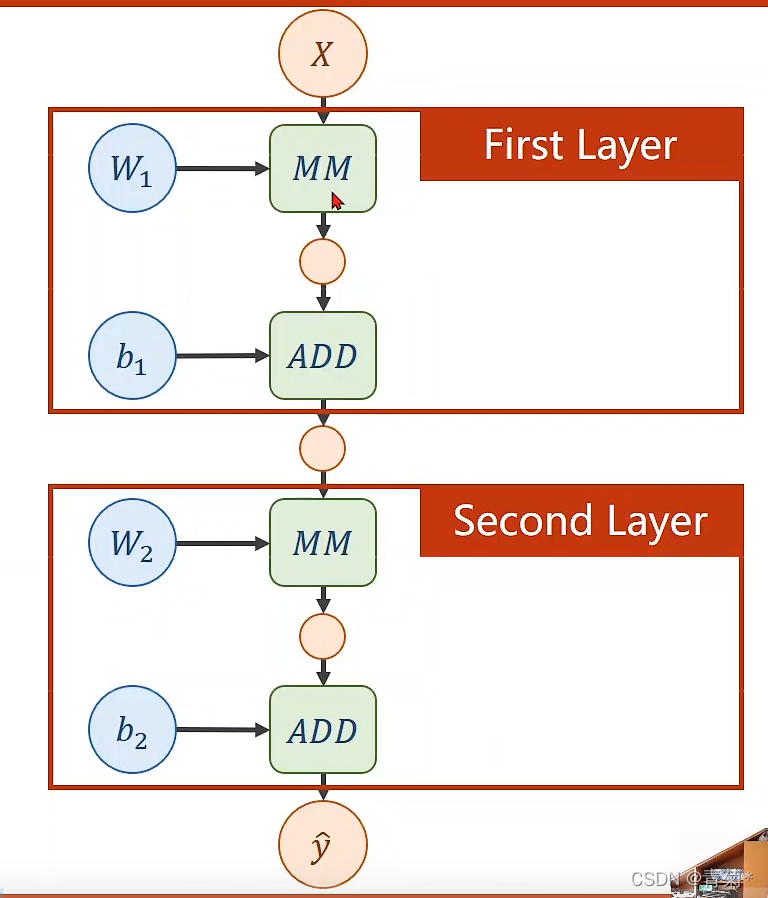

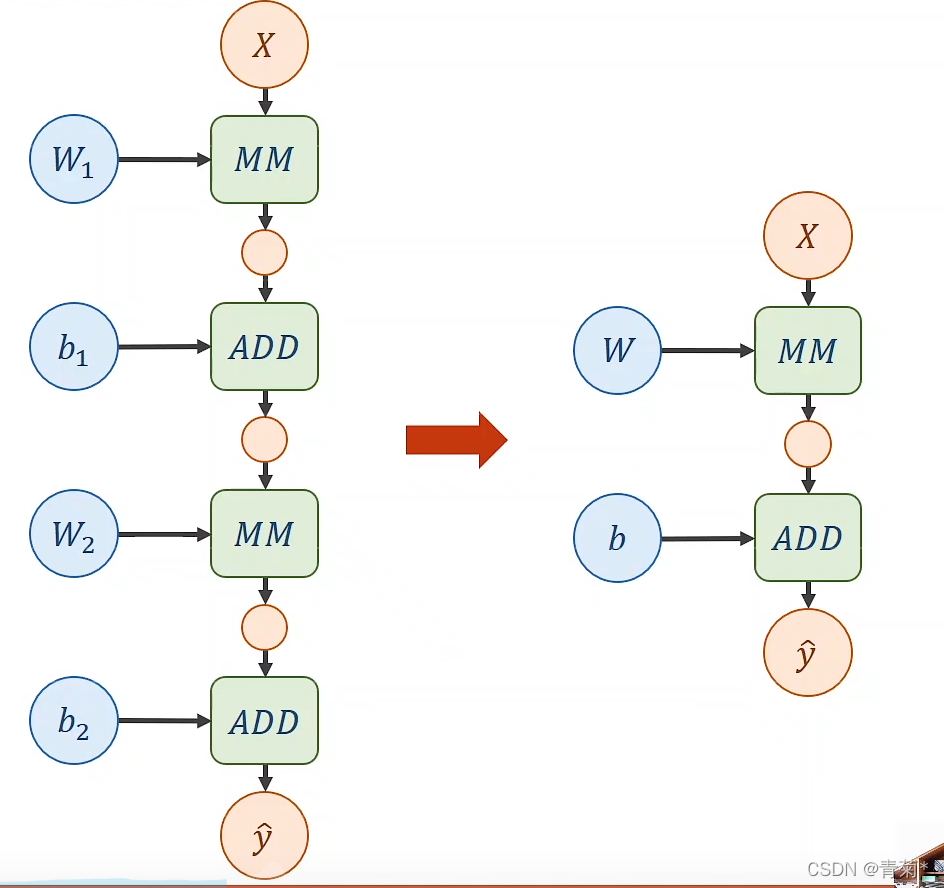

2 计算图

- 其中,MM表示矩阵乘法。

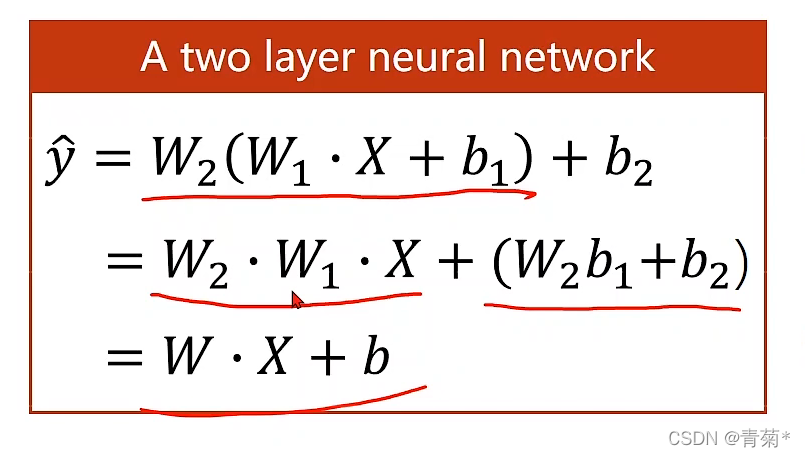

- 但是,对于这样的两层直接输入输出的网络层来说,按照上图的方式可以进行化简,并最终可以化简得到一个线性层。(所以,这两层完全没有意义,其实就是相当于一层)

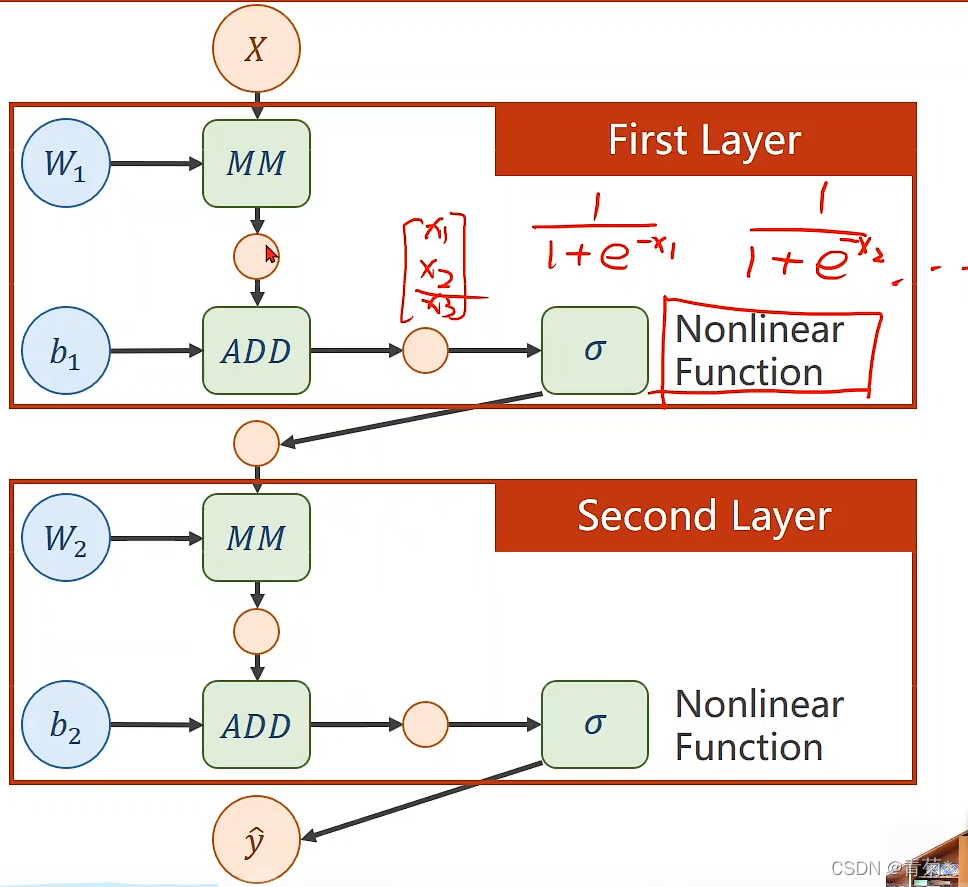

- 因此,我们就要在第一层结束之后,加一个非线性的函数。如下图所示。

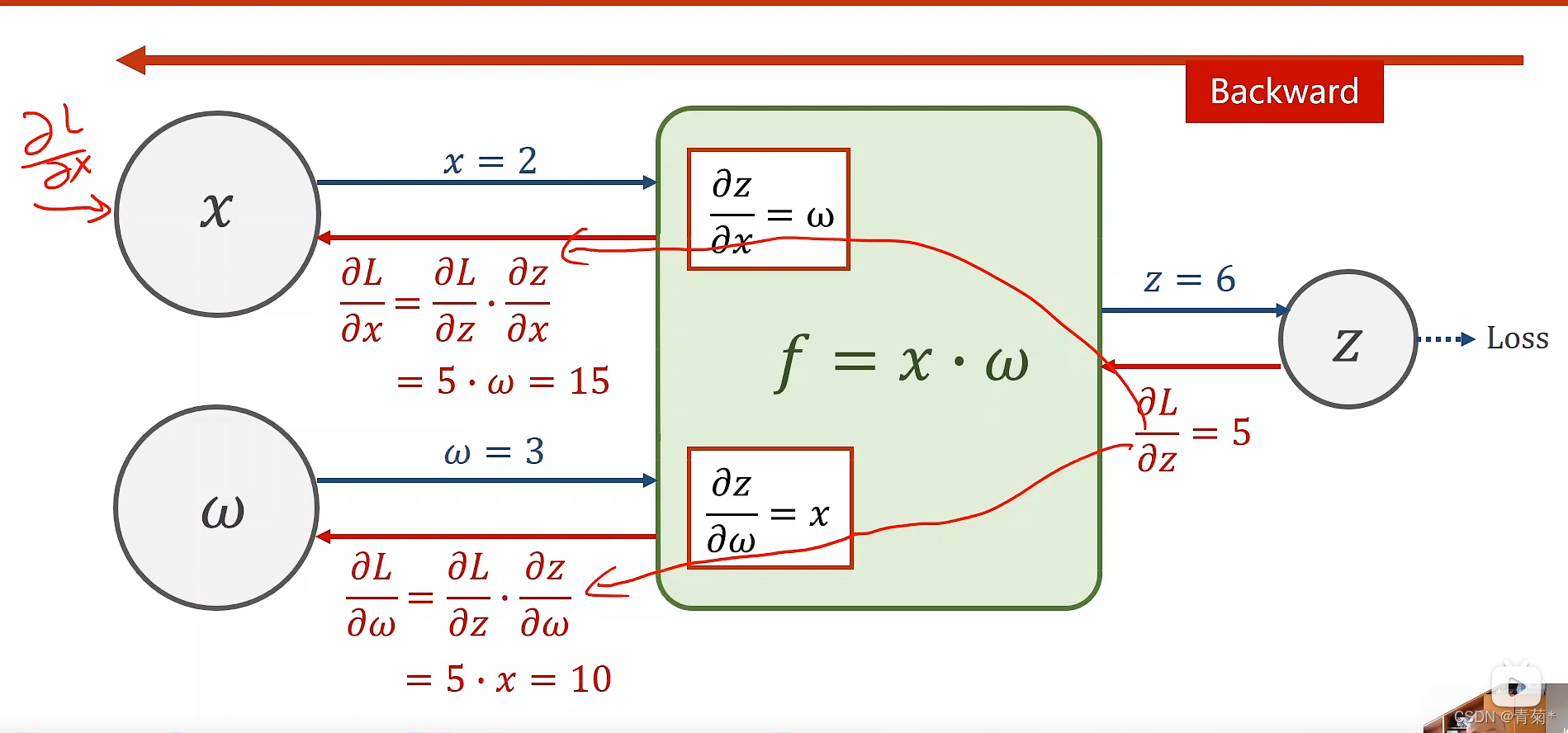

3 链式求导

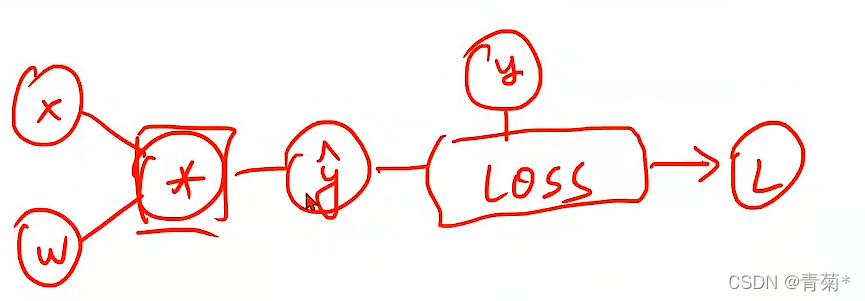

- 前向传播的过程很好理解,就是 f = w ∗ x f=w*x f=w∗x,算loss的过程这里省略。

- 反向传播呢,就是在算出loss之后,需要求出loss对z的导数,然后在算出f的时候,记录下z对x的导数和x对w的导数,然后在往前,根据链式法则得到loss对x的导数和loss对w的导数!

导数是存储在变量中的,不是计算模块中的

扫描二维码关注公众号,回复:

14307189 查看本文章

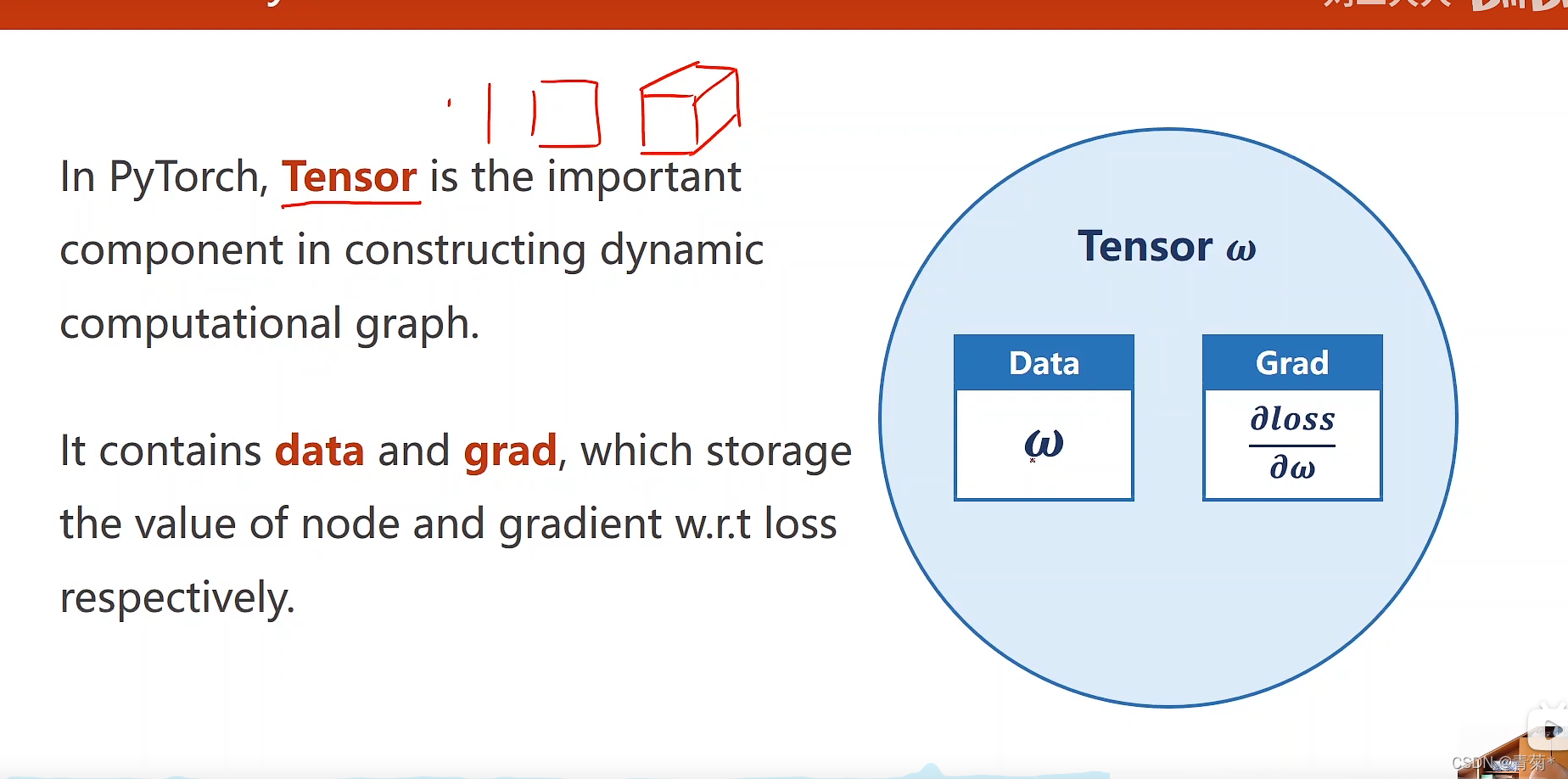

4 PyTorch中的Tensor

- Tensor有两个数据成员,data和Grad。

4.1 代码片段学习

import torch

w = torch.Tensor([1.0])

w.requires_grad = True

- w是一个参数,这里随机初始化为1.0,是一个0维的常量。

- 并且要求它去计算梯度(grad)【一般是默认不计算的】

def forward(x):

return x * w

- forward函数作用:数乘。w是Tensor向量,x不清楚是否是Tensor,这里在计算时就会对函数做一个强制类型转换。

def loss(x, y):

y_pred = forward(x)

return (y_pred - y) ** 2

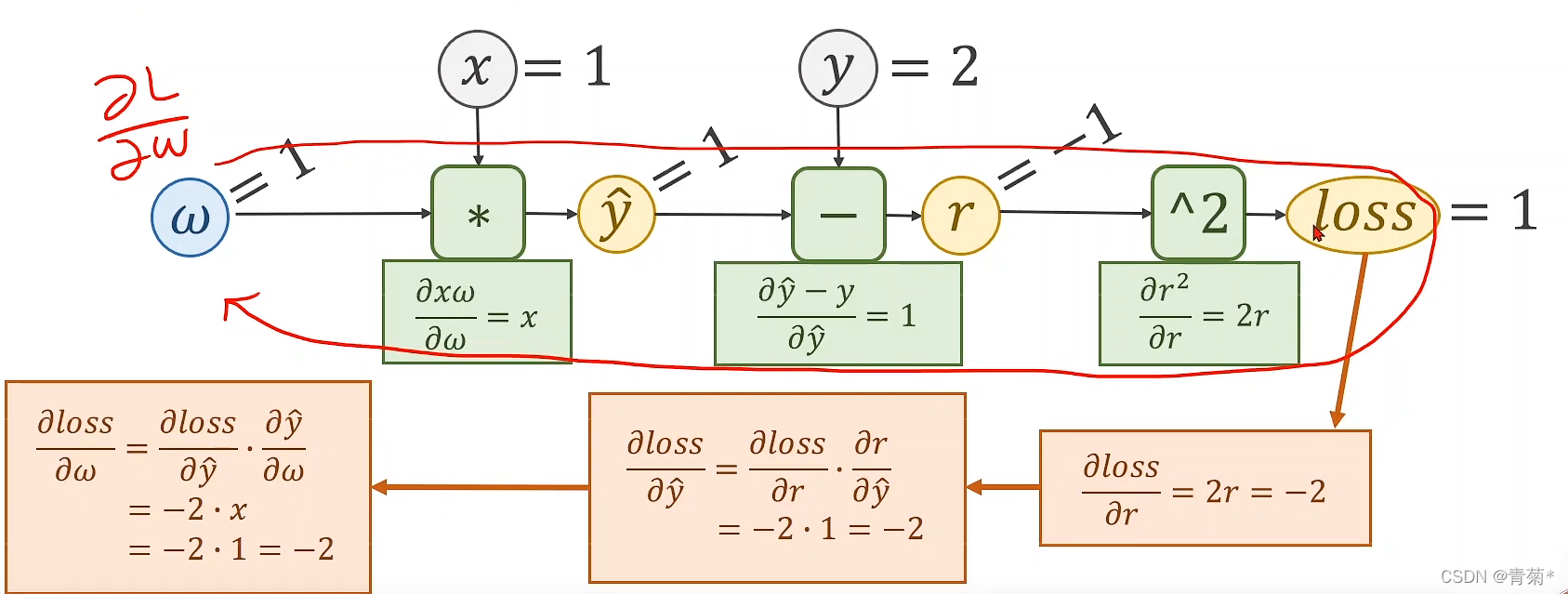

- 这个计算loss的过程,要能够用计算图去表示出来。

for epoch in range(100):

for x, y in zip(x_data, y_data):

l = loss(x, y)

l.backward() # .grad 会累积数据的

print(

w.grad.data.zero_() # 在更新之后,需要把梯度数据清零

张量是不能直接去进行加法计算的,Tensor做加法会生成计算图,导致内存消耗。一定要加上 .item

5 整体代码

- 可以全部复制粘贴到.py文件中,可以直接运行

import torch

import matplotlib.pyplot as plt

x_data = [1.0, 2.0, 3.0]

y_data = [2.0, 4.0, 6.0]

w = torch.Tensor([1.0])

w.requires_grad = True

def forward(x):

return w * x

def loss(x, y):

y_pred = forward(x)

return (y_pred - y) ** 2

print("在模型计算之前对于x=4的预测是:", 4, forward(4).item)

epoch_list = []

loss_list = []

for epoch in range(100):

for x, y in zip(x_data, y_data):

l = loss(x, y)

l.backward()

print('\tgrad:', x, y, w.grad.item())

w.data = w.data - 0.01 * w.grad.data

w.grad.data.zero_()

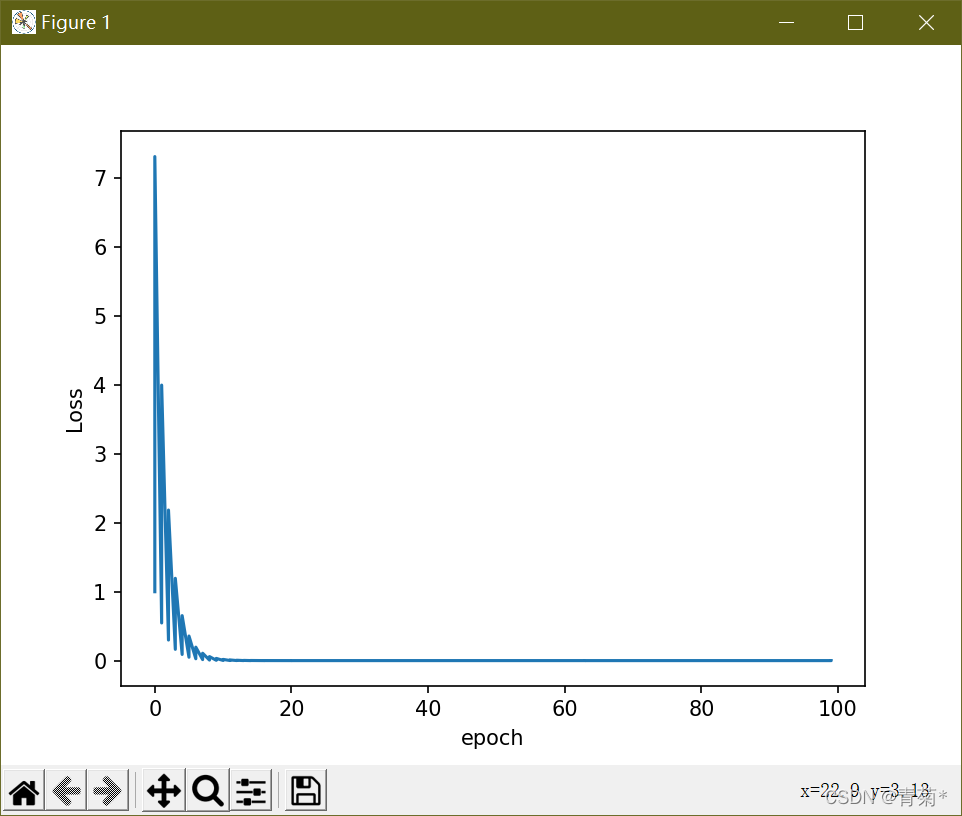

epoch_list.append(epoch)

loss_list.append(l.item())

print("process:", epoch, l.item())

print("在模型计算之后对于x=4的预测是:", 4, forward(4).item())

plt.plot(epoch_list, loss_list)

plt.ylabel('Loss')

plt.xlabel('epoch')

plt.show()

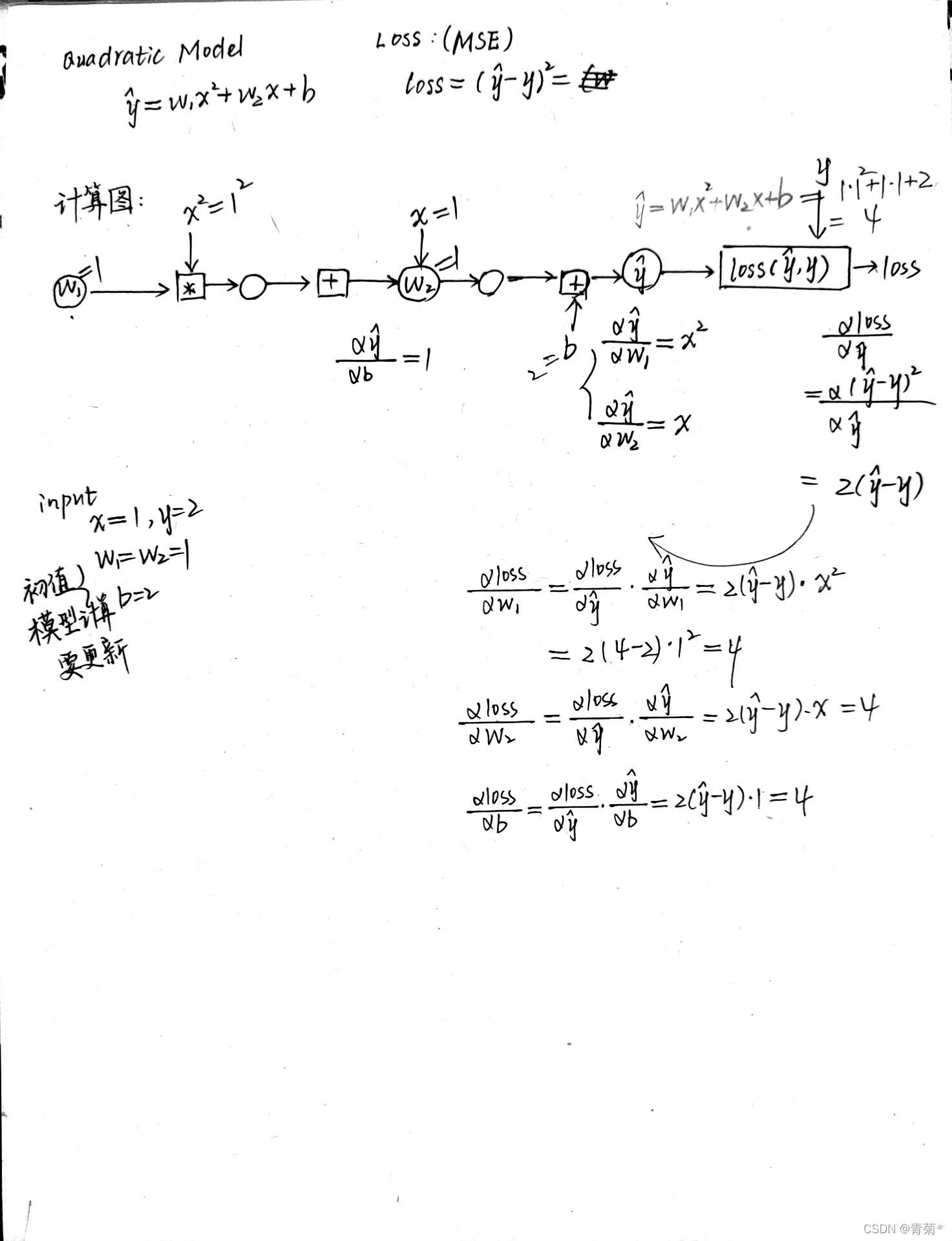

6 二次方程的练习

6.1 手写计算图

- 这里计算出了loss对w1 w2 b 三个参数的梯度都是4。

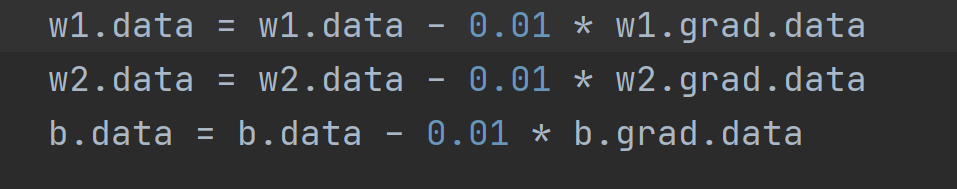

- 权重更新如下图所示:

6.2 完整代码

- 可以直接运行

import torch

import matplotlib.pyplot as plt

x_data = [1.0, 2.0, 3.0]

y_data = [2.0, 4.0, 6.0]

# 预测模型:y_pred = w1*x^2 + w2*x +b

# 以下是参数

w1 = torch.Tensor([1.0])

w1.requires_grad = True

w2 = torch.Tensor([1.0])

w2.requires_grad = True

b = torch.Tensor([2.0])

b.requires_grad = True

def forward(x):

return w1 * x * x + w2 * x + b

def loss(x, y):

y_pred = forward(x)

return (y_pred - y) ** 2

print("在模型计算之前对于x=4的预测是:", forward(4).item)

epoch_list = []

loss_list = []

for epoch in range(100):

for x, y in zip(x_data, y_data):

l = loss(x, y)

l.backward()

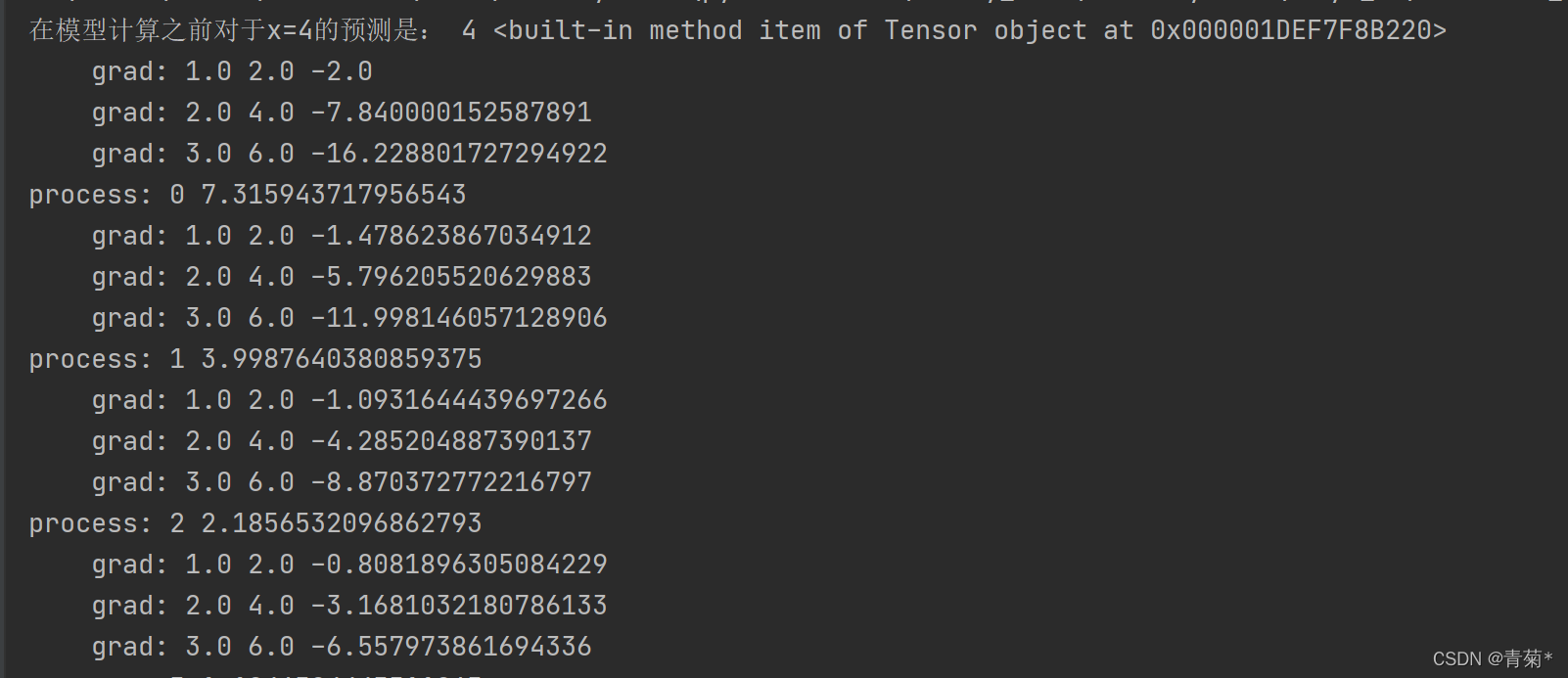

print('\tgrad:', x, y, w1.grad.item(), w2.grad.item(), b.grad.item())

w1.data = w1.data - 0.01 * w1.grad.data

w2.data = w2.data - 0.01 * w2.grad.data

b.data = b.data - 0.01 * b.grad.data

w1.grad.data.zero_()

w2.grad.data.zero_()

b.grad.data.zero_()

epoch_list.append(epoch)

loss_list.append(l.item())

print("process:", epoch, l.item())

print("在模型计算之后对于x=4的预测是:", forward(4).item())

plt.plot(epoch_list, loss_list)

plt.ylabel('Loss')

plt.xlabel('epoch')

plt.show()

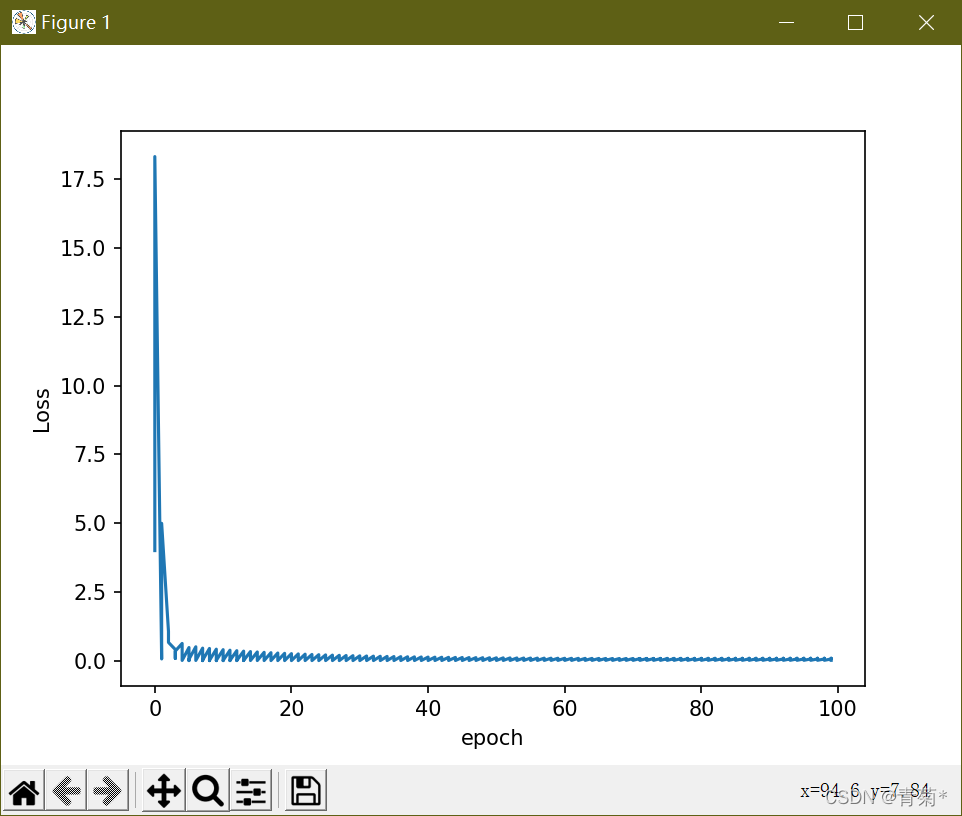

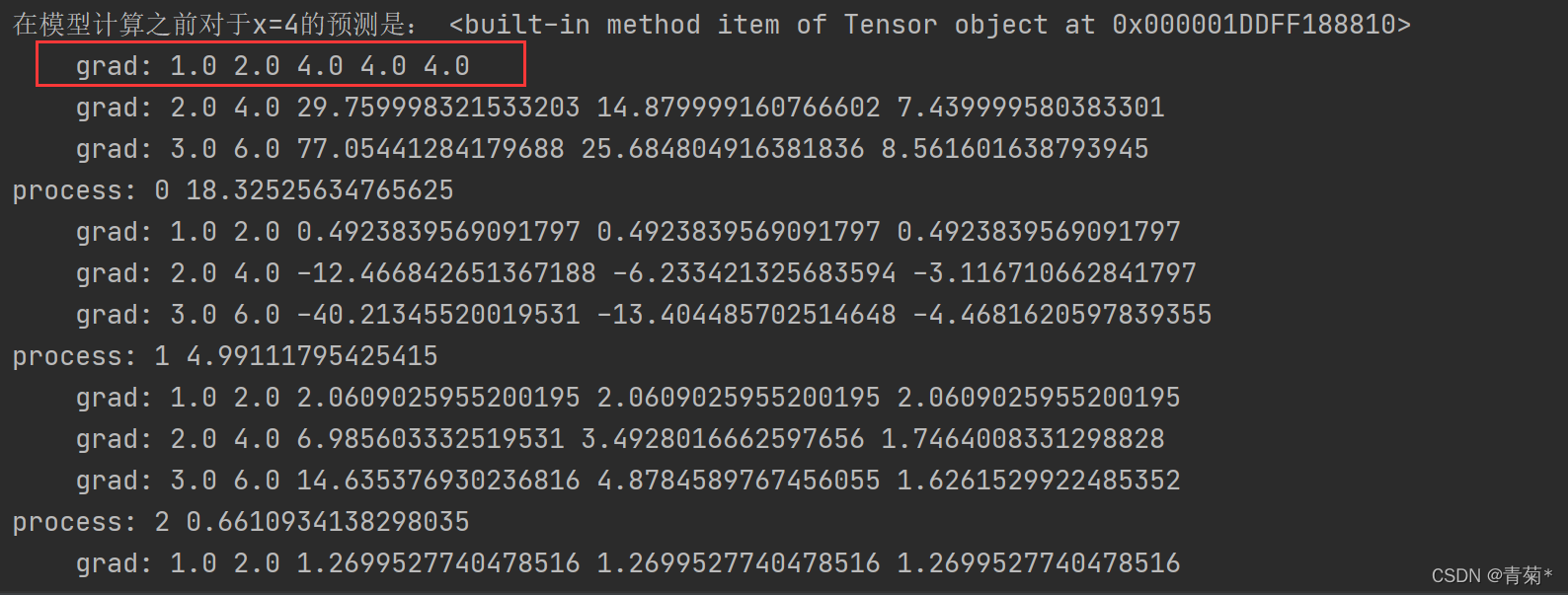

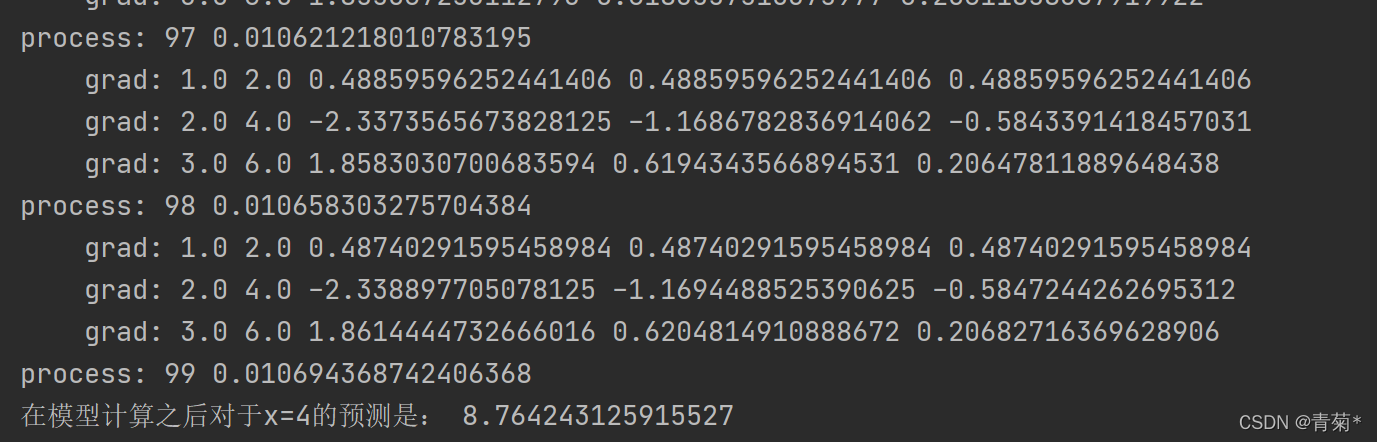

- 展示输出结果:

- 红色框住的地方是loss对三个参数的梯度,这里看是和手算一样的结果,可以初步证明程序正确!

- 模型最后将x=4预测为 8.76+

学习资料:刘二大人