梯度更新,简单模型,解析式做

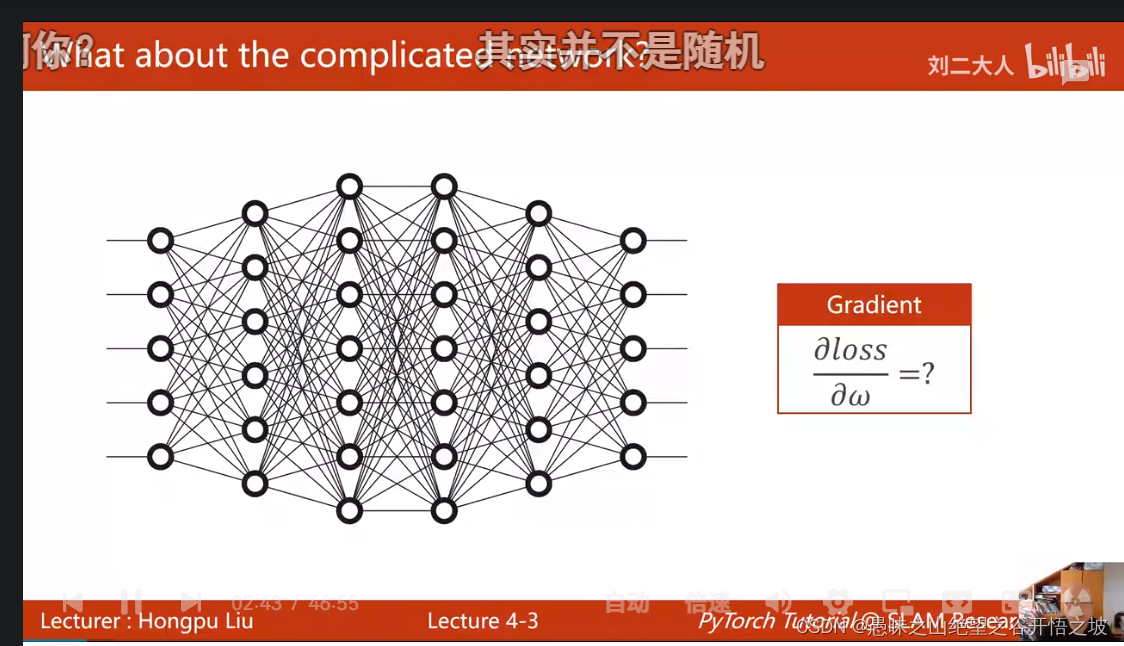

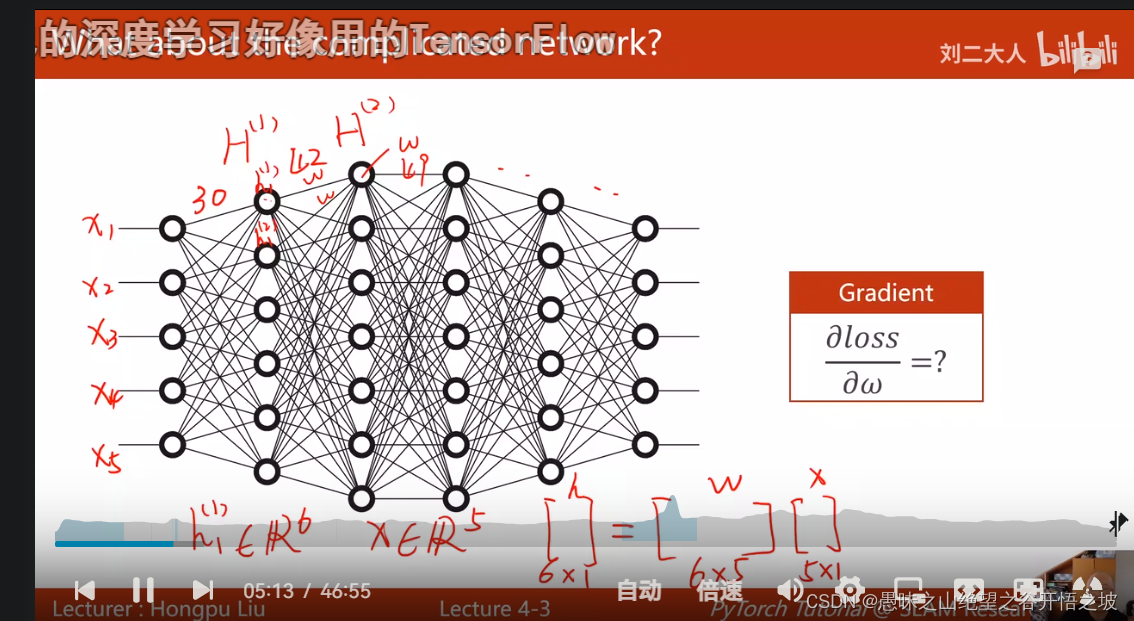

复杂模型

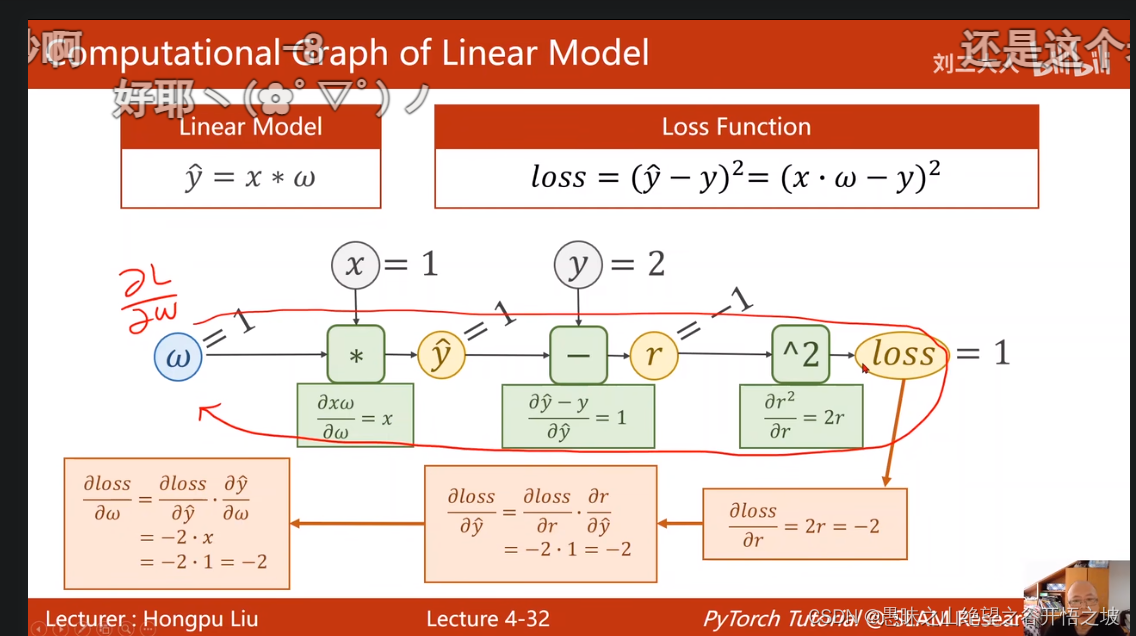

通过计算图图的方式,方向传播求出来

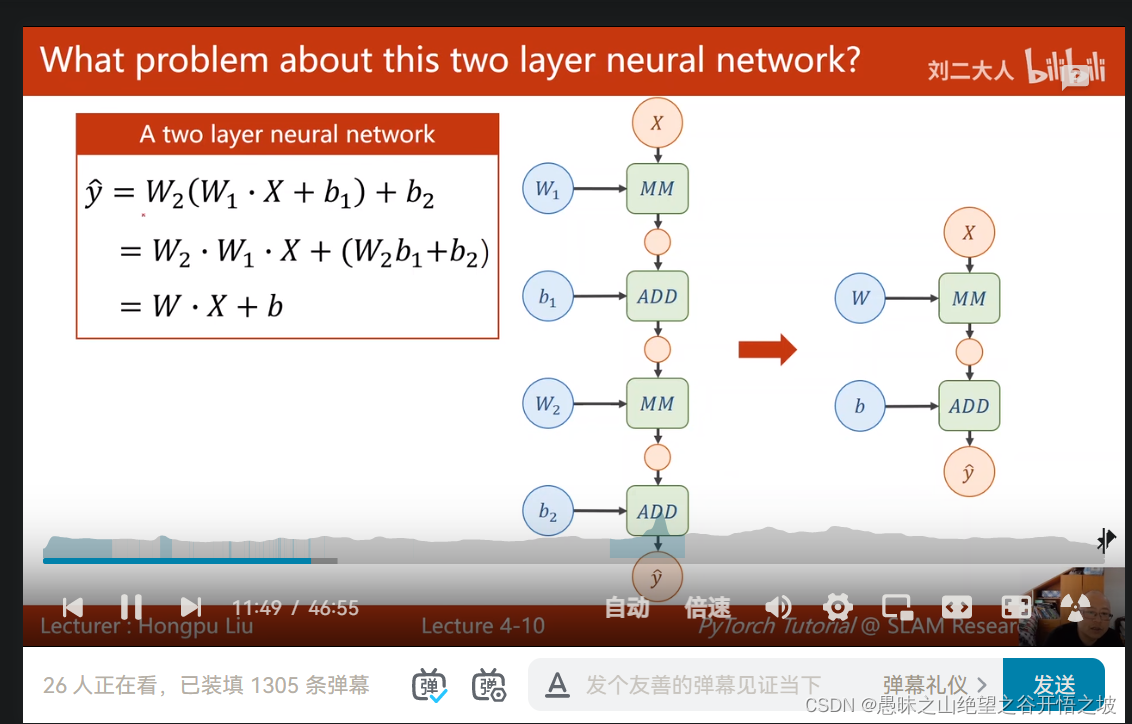

两层线性网络存在的问题,多少层叠加最好都是线性层,叠加就没意义了

张量的每个值增加一个非线性函数

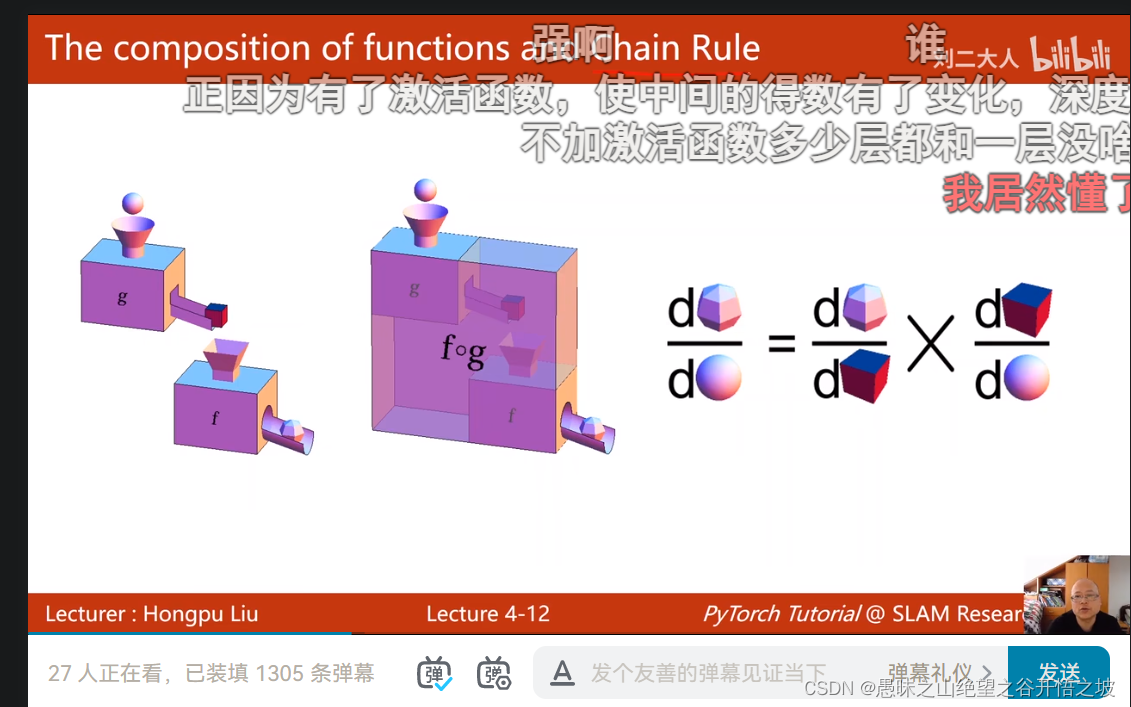

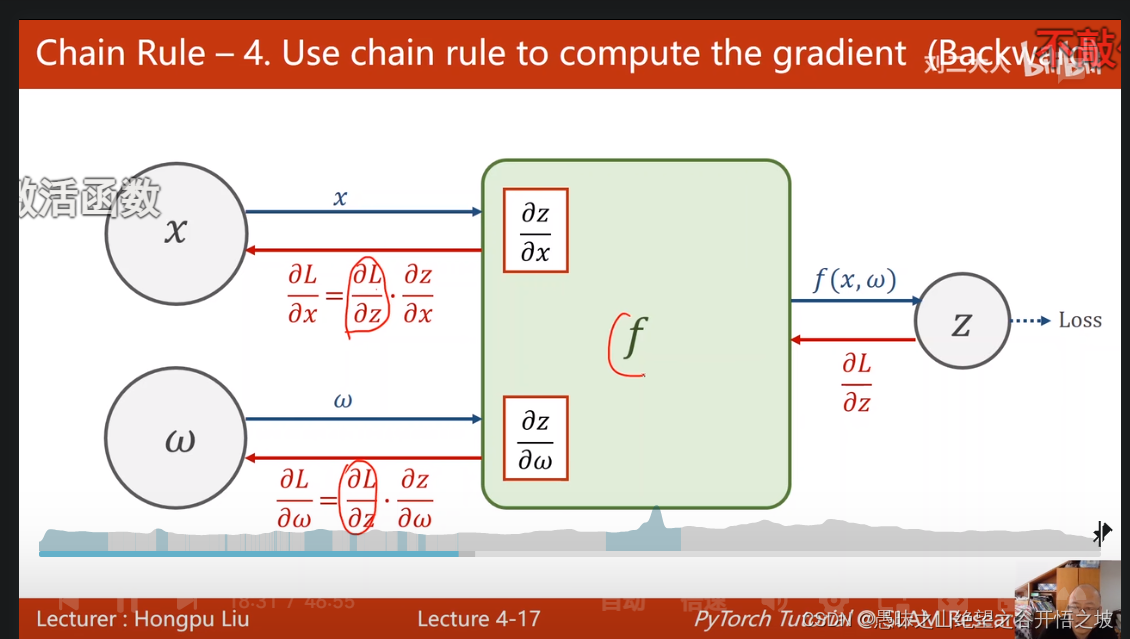

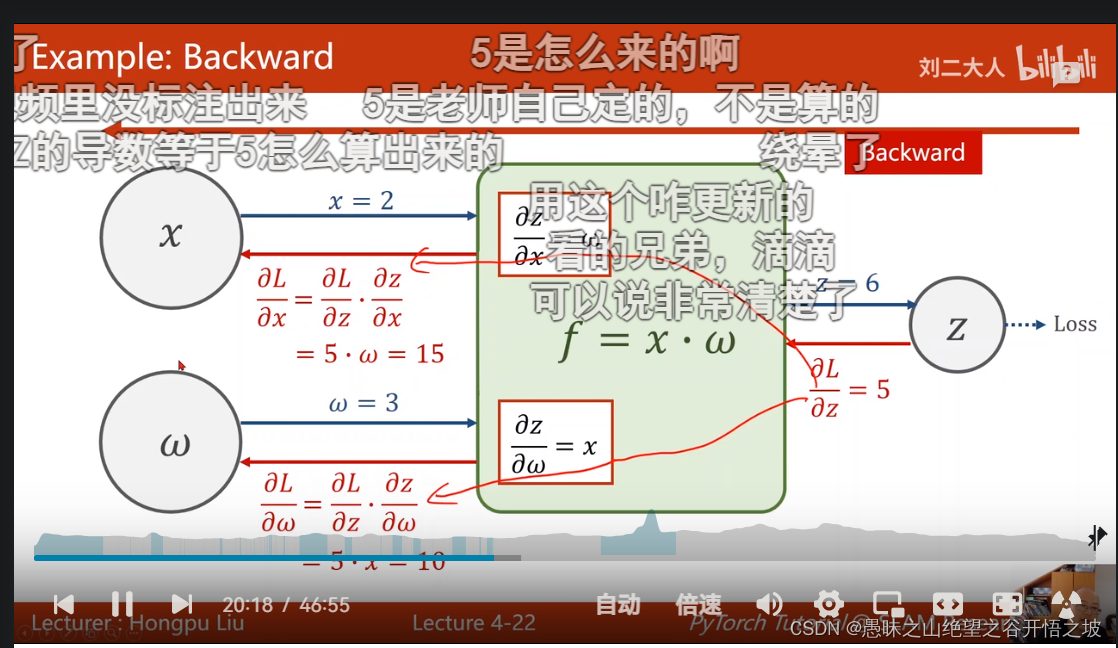

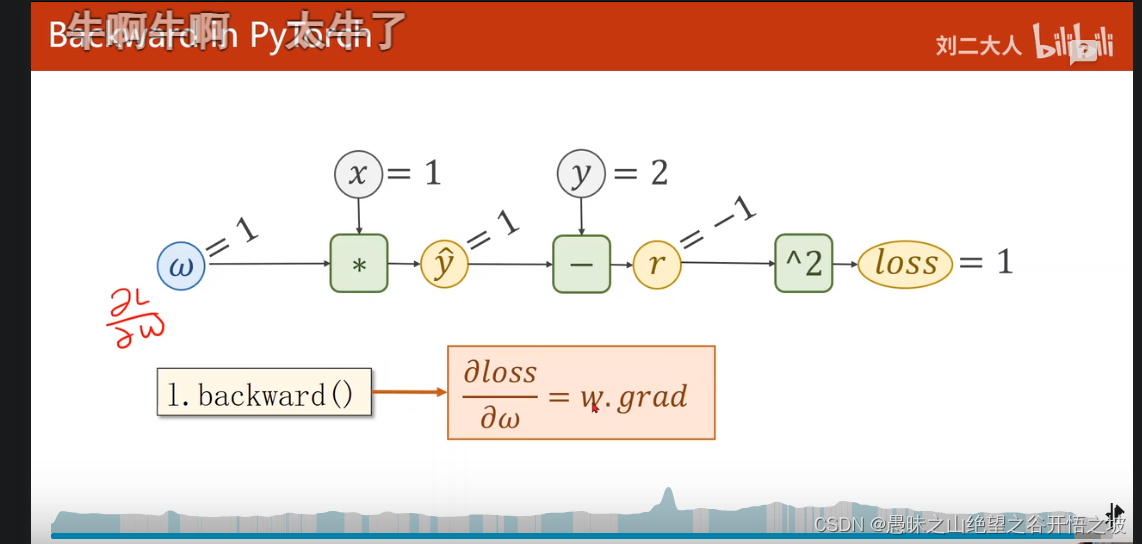

链式求导法则

链式求导法则,矩形框里面的局部梯度导数,正向求损失的时候梯度就提前算好了,提前把梯度存储好了,pytorch存到变量里面

前馈和反馈

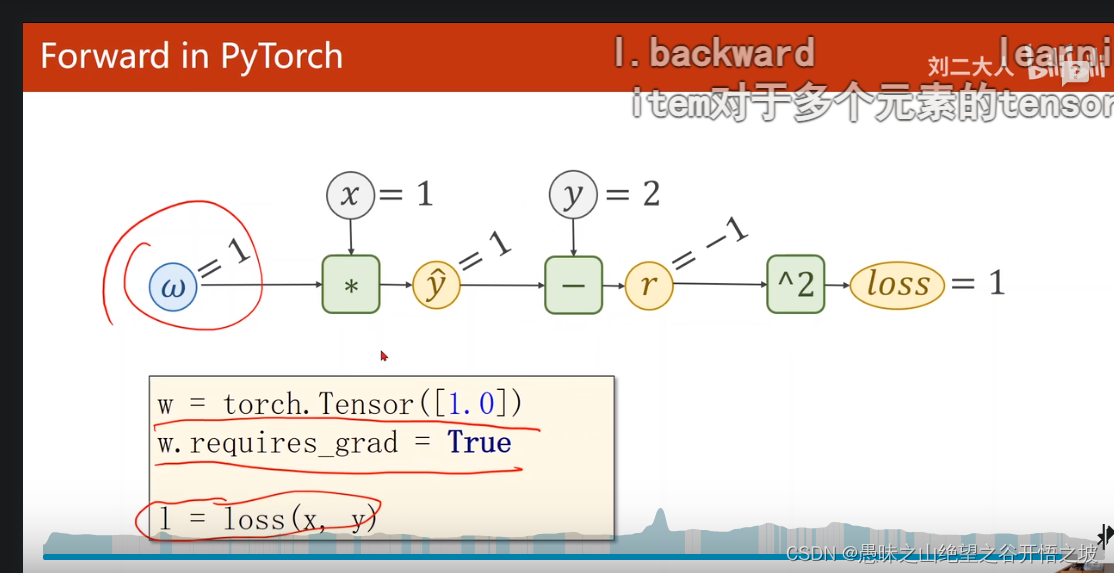

最简单的线性模型

张量,参数数据w和梯度,构建模型,本质上就是在构建计算图

pytorch的定义

人》计算机》语言》图

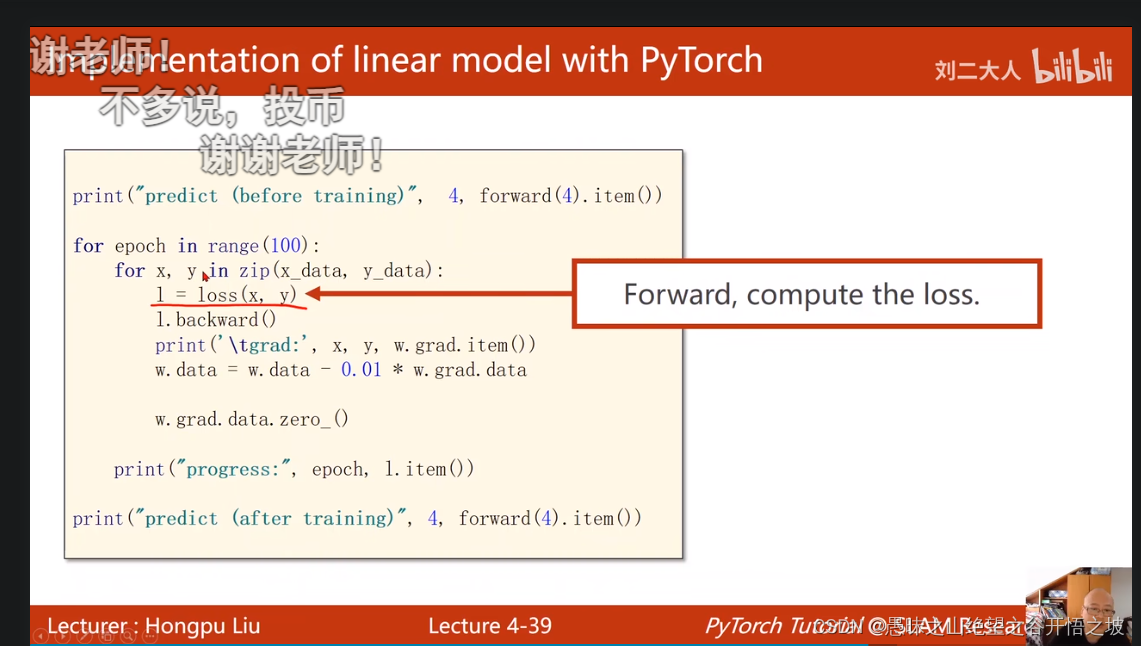

代码,前馈和反馈,张量是有函数的,张量也有参数,转换成标量,张量操作是在构建计算图,占内存

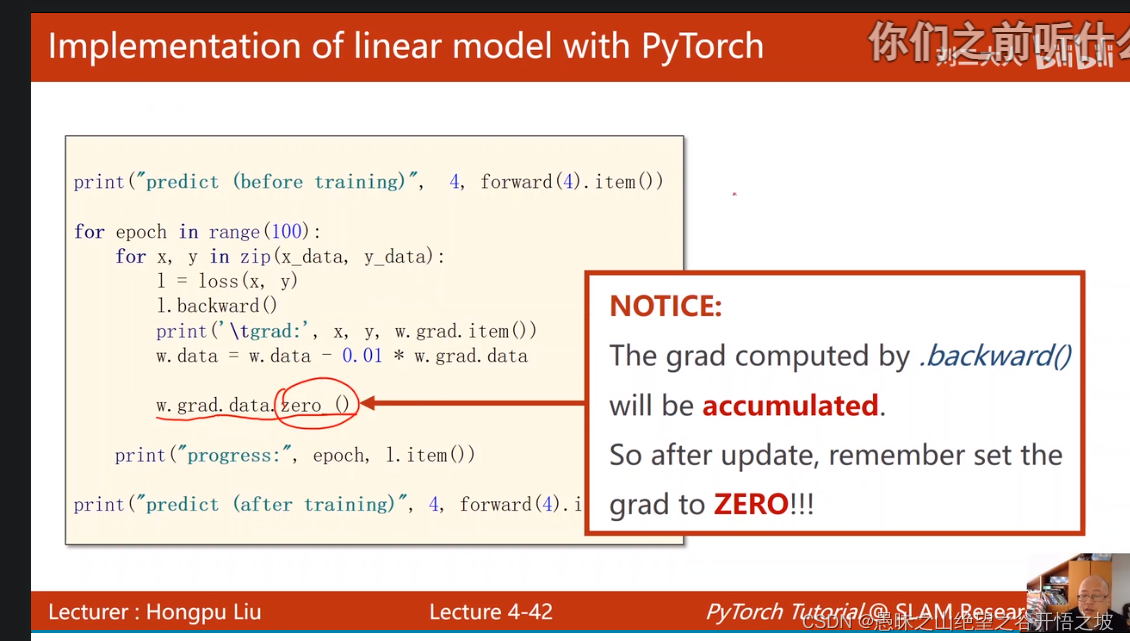

可以额外手动配置清零,有些时候需要累加是不需要清零的

W的梯度要清零,昨晚更新导数还在,如果不清,下次会把上次的结果做累加

计算图

反向

4-《PyTorch深度学习实践》-反向传播

猜你喜欢

转载自blog.csdn.net/qq_15821487/article/details/126166513

今日推荐

周排行