3.4 Temporal Attention

时间注意力可以看作是一种动态的时间选择机制,决定何时注意,因此通常用于视频处理。以前的工作[171],[172]经常强调如何捕获短期和长期跨帧特征依赖。在这里,我们首先总结了有代表性的时间注意力机制,并指定了表5中描述为等式1的过程 g ( x ) g(x) g(x)和 f ( g ( x ) , x ) f(g(x), x) f(g(x),x)。然后根据图4中的顺序讨论各种这样的机制。

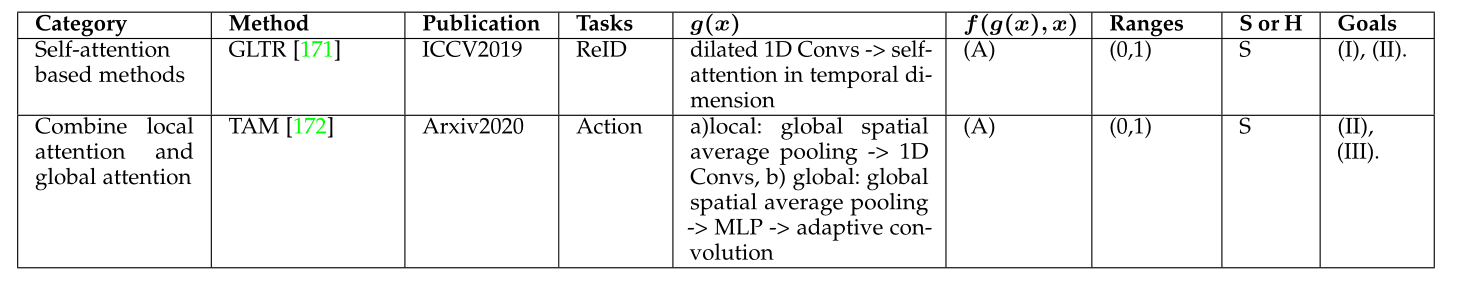

按日期排序的代表性时间注意力机制。Reid=重新识别,行动=行为识别。范围是指注意力地图的范围。S或H表示软注意或硬注意。 g ( x ) g(x) g(x)和 f ( g ( x ) , x ) f(g(x), x) f(g(x),x)是由等式1描述的注意过程。(A) 通过注意力地图聚合信息。(I)利用多尺度短期时间上下文信息(II)捕获长期时间特征相关性(III)捕获局部时间上下文

3.4.1 Self-attention and variants

RNN和时间池化或权值学习已被广泛应用于视频表示学习中,以捕获帧间的交互,但这些方法在效率或时态关系建模方面都有局限性。

为了克服这些问题,Li等人[171]提出了一种全局时间表示法(GLTR),以利用视频序列中的多尺度时间线索。GLTR由用于局部时间上下文学习的空洞时间金字塔(DTP)和用于捕获全局时间交互的时间自注意力模块组成。DTP采用空洞卷积,空洞率逐渐增加,以覆盖不同的时间范围,然后将各种输出连接起来,以聚合多尺度信息。给定输入的逐帧特征 F = { f 1 , … f T } F=\left\{f_{1}, \ldots f_{T}\right\} F={

f1,…fT},DTP 可以写成:

{ f 1 ( r ) , … , f T ( r ) } = DConv ( r ) ( F ) f t ′ = [ f t ( 1 ) ; … f t ( 2 n − 1 ) … ; f t ( 2 N − 1 ) ] \begin{aligned} \left\{f_{1}^{(r)}, \ldots, f_{T}^{(r)}\right\} &=\operatorname{DConv}^{(r)}(F) \\ f_{t}^{\prime} &=\left[f_{t}^{(1)} ; \ldots f_{t}^{\left(2^{n-1}\right)} \ldots ; f_{t}^{\left(2^{N-1}\right)}\right] \end{aligned} {

f1(r),…,fT(r)}ft′=DConv(r)(F)=[ft(1);…ft(2n−1)…;ft(2N−1)]

其中DConv ( r ) ( ⋅ ) { }^{(r)}(\cdot) (r)(⋅)表示具有空洞率 r r r的空洞卷积。自注意力机制采用卷积层,然后通过批规范化和ReLU激活,基于输入特征图 F ′ = F^{\prime}= F′= { f 1 ′ , … f T ′ } \left\{f_{1}^{\prime}, \ldots f_{T}^{\prime}\right\} {

f1′,…fT′}来生成 Q ∈ R d × T Q \in \mathbb{R}^{d \times T} Q∈Rd×T, K ∈ R d × T K \in \mathbb{R}^{d \times T} K∈Rd×T, V ∈ R d × T V \in \mathbb{R}^{d \times T} V∈Rd×T,可以写成

F out = g ( V Softmax ( Q T K ) ) + F ′ F_{\text {out }}=g\left(V \operatorname{Softmax}\left(Q^{T} K\right)\right)+F^{\prime} Fout =g(VSoftmax(QTK))+F′

其中 g g g表示通过卷积实现的线性映射。

来自相邻帧的短期时间上下文信息有助于区分视觉上相似的区域,而长期时间信息有助于克服遮挡和噪声。GLTR结合了这两个模块的优点,增强了表示能力并抑制了噪声。它可以整合到任何先进的CNN主干网中,学习整个视频的全局描述符。然而,自注意机制具有二次时间复杂性,限制了其应用。

3.4.2 TAM

为了高效灵活地捕捉复杂的时间关系,Liu等人[172]提出了一种时间自适应模块(TAM)。它采用自适应核代替自注意力来捕获全局上下文信息,时间复杂度低于GLTR[171]。

TAM 有两个分支,一个局部分支和一个全局分支。给定输入特征图 X ∈ R C × T × H × W X \in \mathbb{R}^{C \times T \times H \times W} X∈RC×T×H×W,首先将全局空间平均池化 GAP 应用于特征图,以确保 TAM 具有低计算成本。然后,TAM 中的局部分支在整个时间域上使用多个具有 ReLU 非线性的 1D 卷积来生成位置敏感的重要性图,以增强逐帧特征。局部分支可以写成

s = σ ( Conv1D ( δ ( Conv1D ( GAP ( X ) ) ) ) ) X 1 = s X \begin{aligned} s &=\sigma(\operatorname{Conv1D}(\delta(\operatorname{Conv1D}(\operatorname{GAP}(X))))) \\ X^{1} &=s X \end{aligned} sX1=σ(Conv1D(δ(Conv1D(GAP(X)))))=sX

与局部分支不同,全局分支是位置不变的,并且专注于基于每个通道中的全局时间信息生成通道自适应内核。对于第$c $个通道,内核可以写为

Θ c = Softmax ( F C 2 ( δ ( F C 1 ( GAP ( X ) c ) ) ) ) \Theta_{c}=\operatorname{Softmax}\left(\mathrm{FC}_{2}\left(\delta\left(\mathrm{FC}_{1}\left(\operatorname{GAP}(X)_{c}\right)\right)\right)\right) Θc=Softmax(FC2(δ(FC1(GAP(X)c))))

其中 Θ c ∈ R K \Theta_{c} \in \mathbb{R}^{K} Θc∈RK, K K K是自适应内核大小。最后,TAM 将自适应内核 Θ \Theta Θ与 X out 1 X_{\text {out }}^{1} Xout 1进行卷积:

Y = Θ ⊗ X 1 Y=\Theta \otimes X^{1} Y=Θ⊗X1

在局部分支和全局分支的帮助下,TAM 可以捕捉视频中复杂的时间结构,并以较低的计算成本增强每帧特征。由于其灵活性和轻量级设计,TAM 可以添加到任何现有的 2D CNN 中。