摘要

在风格样式迁移任务中取得进展的主要障碍是训练数据的不足。在本文中,我们研究如何扩充平行数据,并为此任务提出了简单的数据扩充方法,以通过易于访问的模型和系统获得有用的句子对。实验表明,当我们使用增强的平行数据对模型进行预训练时,它们在很大程度上有助于改善风格样式的迁移,从而在GYAFC基准数据集中提供了最新的结果。

1.介绍

风格样式迁移(FST)的定义是将一种风格样式的文本自动转换为另一种风格的文本的任务。例如,在给定非正式句子的情况下,FST旨在保留与样式无关的内容并输出正式句子。

先前的工作倾向于利用诸如seq2seq模型之类的神经网络来应对这一挑战,因为它们功能强大,且相对于传统基于规则的方法具有巨大性能提升。但是,神经网络方法的性能仍然受到训练数据不足的限制:用于FST训练的公共平行语料库GYAFC仅包含约10万个句子对,很难满足具有数百万个参数的神经模型的需要。

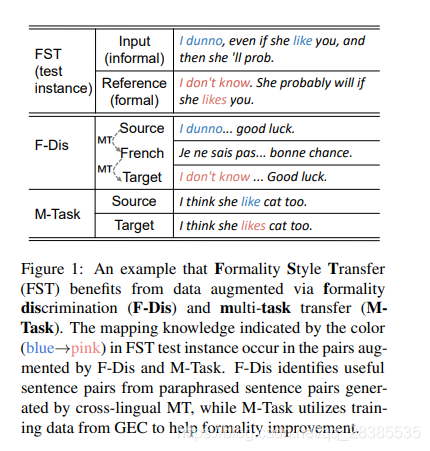

为了解决FST的数据缺失的问题,我们提出使用三种特定的数据增强方法来增强平行数据,以帮助提高模型的泛化能力并减少过拟合的风险。除了将机器翻译(MT)中广泛使用的反向翻译(BT)方法应用于FST之外,我们的数据扩充方法还包括风格判断(F-Dis)和多任务迁移(M-Task) 。它们在生成平行数据方面既新颖又有效,该平行数据引入了无法从原始训练数据中获得的其他风格迁移的知识。具体来说,F-Dis从跨语言MT生成的释义对中识别有用的对; 而M-Task任务则利用语法错误校正(GEC)任务的训练数据来改善风格,如图1所示。

实验结果表明,我们提出的数据增强方法可以为FST收集大量的增强平行数据。事实证明,增强的平行数据很有用,并且在用于模型的预训练时,可以极大地帮助改善风格样式的迁移,从而使模型可以在GYAFC基准数据集中获得最新的结果。

2.方法

2.1 风格样式迁移的数据增强

我们研究了三种用于风格样式迁移的数据增强方法:反向翻译,风格判断和多任务迁移。我们专注于由【非正式→正式】风格的迁移,因为它在实际应用场景中更为实用。

2.1.1 反向翻译

反向翻译(BT)的最初想法是训练一个目标到源的seq2seq模型并使用该模型从目标单语句子生成源语言句子,建立合成的平行句子。我们将其概括为我们的基本数据扩充方法,并使用原始平行数据在形式到非正式方向上训练seq2seq模型。然后,我们可以向该模型提供正式的句子,该句子应该能够产生非正式的对应语句。正式输入和非正式输出语句可以配对以建立增强的平行数据。

2.1.2 风格判断

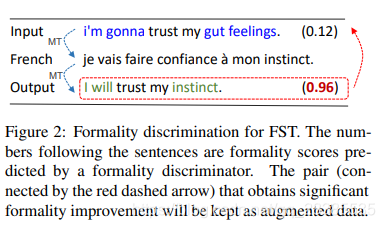

根据观察,非正式语句在MT模型进行往返翻译后,非正式语句趋于成为正式语句,这时因为MT模型主要接受新闻等正式文本的训练,我们提出了一种新的方法,称为风格判别,用于通过跨语言MT模型的方式生成非正式源句的正式改写。一个典型的示例如图2所示。

为此,我们收集了许多可能非正式的英语句子(例如,从在线论坛中)。形式上,我们将收集的句子表示为 S = { s i } i = 1 ∣ S ∣ \mathcal S=\{\textbf s_i\}^{|S|}_{i=1} S={

si}i=1∣S∣,其中 s i \textbf s_i si表示第 i i i个句子。我们首先将它们翻译成主要语言(例如法语),然后再将其翻译回英语,如图2所示。这样,我们为每个句子 s i ∈ S \textbf s_i∈\mathcal S si∈S获得了一个重写的句子 s i ′ \textbf s'_i si′。

为了验证 s i ′ \textbf s'_i si′是否比 s i \textbf s_i si更为正式,我们引入了风格判别器,在我们的实验中是使用卷积神经网络(CNN)来量化句子的正式水平。我们在FST语料库(例如GYAFC)中使用句子及其风格标签对风格判别器进行了训练。从而选择其中 s i ′ \textbf s'_i si′大大改善 s i \textbf s_i si正式性的平行句对 ( s i , s i ′ ) (\textbf s_i,\textbf s'_i) (si,si′)作为扩充数据。结果数据集 T a u g \mathcal T_{aug} Taug是这样的一组平行句对:

T a u g = { ( s i , s i ′ ) ∣ P + ( s i ′ ) − P + ( s i ) ≥ σ } (1) \mathcal T_{aug}=\{(\textbf s_i,\textbf s'_i)|P_+(\textbf s'_i)-P_+(\textbf s_i)\ge \sigma\}\tag{1} Taug={

(si,si′)∣P+(si′)−P+(si)≥σ}(1)

其中 P + ( x ) P_+(\textbf x) P+(x)是判别器预测的句子 x \textbf x x是正式的概率,而 σ σ σ是增强数据选择的阈值。这样,我们可以获得有用的平行数据,这些数据包含不在原始并行数据中的有价值的重写知识。

2.1.3 多任务迁移

除了使用人工生成的句子对进行反向翻译和风格判别的数据增强之外,我们还引入了多任务迁移,该迁移使用了来自其他seq2seq任务的带标注句子对。我们观察到非正式文本通常是不合语法的,而正式文本几乎在语法上是正确的。因此,理想的FST模型应具有检测和重写非语法文本的能力,该能力已由先前的经验研究验证,表明使用最新的语法错误校正(GEC)模型对FST模型的输出进行后处理可以改善结果。受此观察的启发,我们建议通过利用GEC训练数据作为增强的平行数据来帮助从形式上将知识从GEC转移到FST。图1中显示了一个示例,其中GEC的带标注的数据提供了知识,以帮助模型重写包含错误语法化的非正式句子。

2.2 使用增强数据进行预训练

通常,大量的增强平行数据可以帮助seq2seq模型更好地学习上下文表示,句子生成和源-目标对齐。当增强的平行数据可用时,先前对seq2seq任务的研究倾向于使用原始训练数据和增强数据同时训练seq2seq模型。但是,增强数据通常比原始训练数据更嘈杂且价值较低。在同步训练中,海量扩充数据往往会使原始数据的知识被稀释,并引入不必要甚至错误的编辑知识,这对于我们的任务而言是不希望的。

为了更好地利用增强数据,我们偷吃首先使用增强平行数据对模型进行预训练,然后使用原始训练数据对模型进行微调。在我们的预训练和微调(PT&FT)方法中,扩充后的数据与原始数据没有得到同等对待;相反,它只是作为先验知识,可以在微调阶段进行更新甚至覆盖。通过这种方式,模型可以更好地从原始数据中学习,而不会被增强的数据所淹没或分散。此外,将增强数据和原始数据划分为不同的训练阶段可以使模型对增强数据中的噪声变得更加宽容,从而降低了对增强数据的质量要求,并使模型可以使用噪声更大的增强数据甚至其他任务的训练数据。