声明:语音合成论文优选系列主要分享论文,分享论文不做直接翻译,所写的内容主要是我对论文内容的概括和个人看法。如有转载,请标注来源。

欢迎关注微信公众号:低调奋进

Enhancing Monotonicity for Robust Autoregressive Transformer TTS

本文是清华大学在interspeech 2020上发表优化transformerTTS,使其更加鲁棒,具体的文章链接

https://www.isca-speech.org/archive/Interspeech_2020/pdfs/1751.pdf

1 研究背景

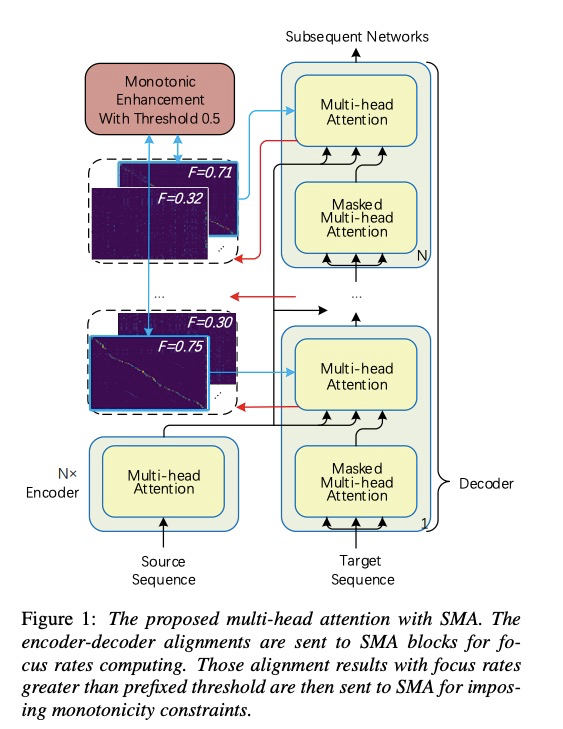

基于transformer的tts系统如下图所示,因为transformer缺少对句子时序性的信息,因此常出现漏字,跳字的问题。本文通过把stepwise monotnoic attention应用到transfomer中因此使transformerTTS更加鲁棒,实验结果显示合成的语音质量MOS提高,而且系统更加鲁棒。

2 详细设计

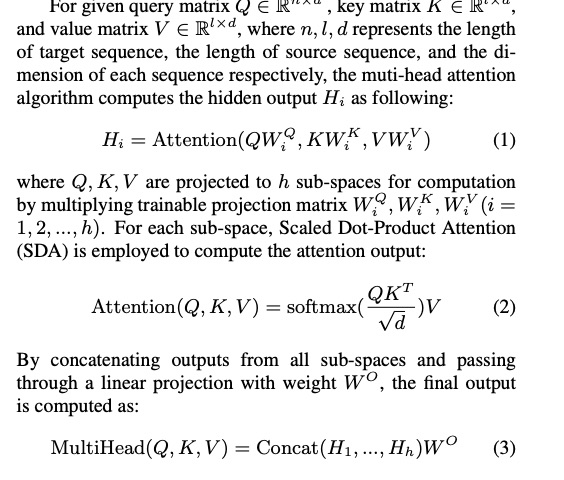

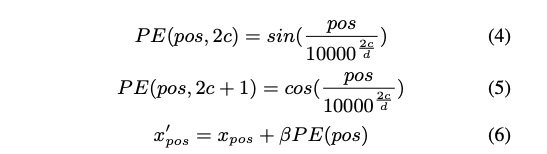

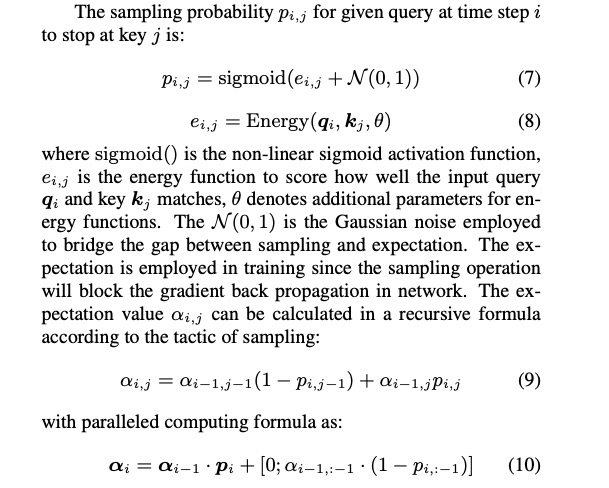

首先看一下multi-head attention的计算公式1~3,其中为了添加位置信息添加position embeddig公式为4~6。而stepwise 的公式为7~10,具体可参考我另一篇文章(https://mp.weixin.qq.com/s?__biz=MzAxNjY3NjQwOQ==&mid=2247484211&idx=1&sn=643435511da3be606d7f2d184e971e79&chksm=9bf06065ac87e973e2d43ef9cead4b81eded725468d9d8894f4c86c37dfd215bc2e874317269&token=2030848745&lang=zh_CN#rd)

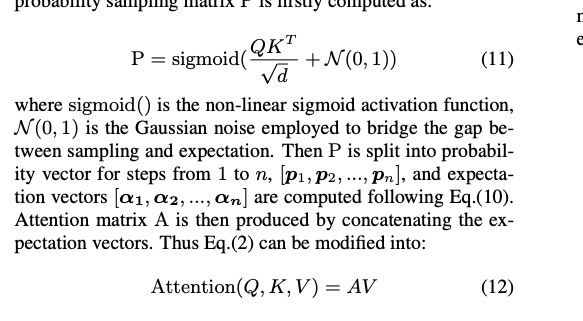

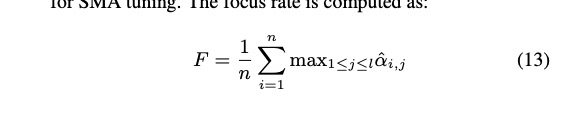

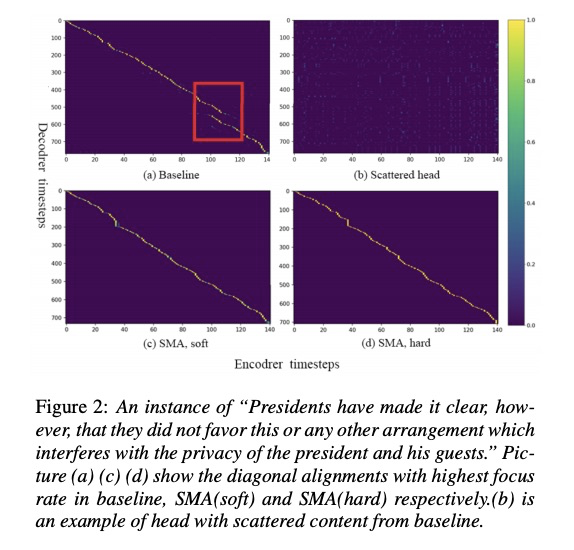

接下来本文使用stepwise monotonic attention 修改multi-head attention的部分SMA tuned,则上面的公式2修改成公式11。另外比较有意思的是图1展示的attention的选择,该部分主要是使选择的attention符合对角线。它先使用公式13来计算attention矩阵的focus rate,只有大于0.5才被选择。另外本文的训练方法分为两步:1)先训练一个普通的transformerTTS,使其attention几乎对角线 2)在预训练的transformerTTS上进行SMA tuned微调。

3 实验

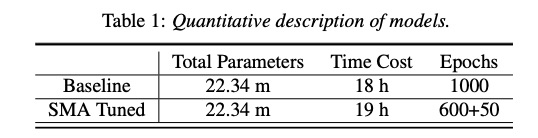

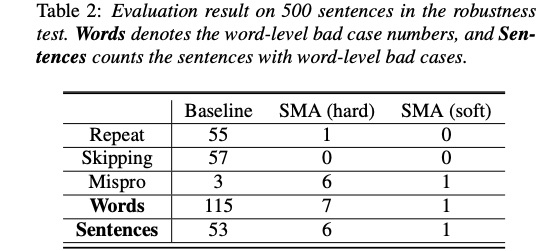

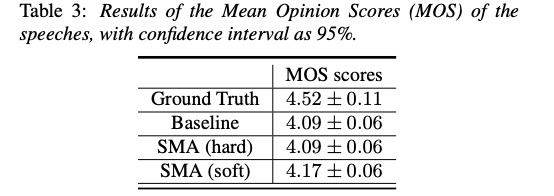

先看一下本文的SMA tuned 和原始transformerTTS(baseline)的训练时间对比为table1所示,时间稍微慢些。然后使用500句子进行鲁棒性测试(table2),可以看到SMA的各类问题出现次数大大减少,其中图2也展示了SMA(c和d)对齐效果。table3可以看到SMA的soft生成音频的MOS比baseline较高。

4 总结

本文通过把stepwise monotnoic attention应用到transfomer中因此使transformerTTS更加鲁棒,实验结果显示合成的语音质量MOS提高,而且系统更加鲁棒。