✌ learning_curve函数的使用

1、✌ 原理

该函数是用来画学习曲线,可以直接返回训练样本、训练集分数、测试集分数

内部是根据交叉验证来获得分数的

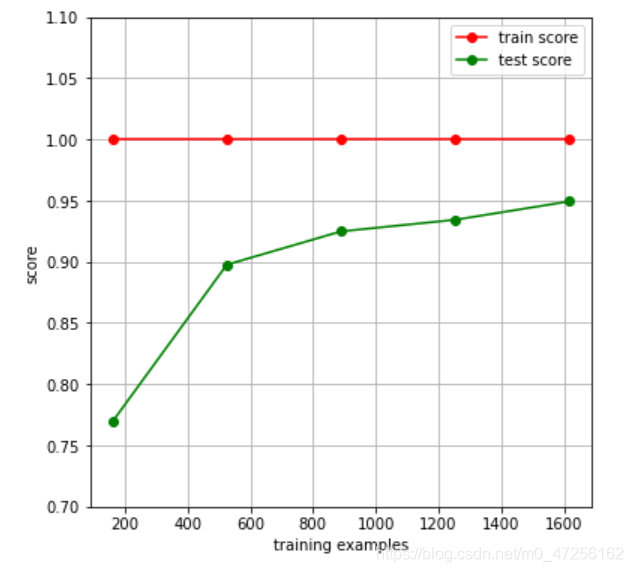

学习曲线就是通过画出不同训练集大小时训练集和交叉验证的准确率,可以看到模型在新数据上的表现,进而来判断模型是否方差偏高或偏差过高,以及增大训练集是否可以减小过拟合。

2、✌ 函数形式

sklearn.model_selection.learning_curve(estimator, X, y, groups=None, train_sizes=array([0.1, 0.33, 0.55, 0.78, 1. ]), cv=’warn’, scoring=None, exploit_incremental_learning=False, n_jobs=None, pre_dispatch=’all’, verbose=0, shuffle=False, random_state=None, error_score=’raise-deprecating’)

3、✌ 重要参数

estimator:

需要传入模型对象,例如:RandomForestRegression()、SVC(gamma=0.001)

x:

需传入特征矩阵

y:

需传入标签

cv:

可以传多种格式参数:

(1)、整数:指定KFold中的折数,如cv=5,意为将x特征矩阵分为5份,最终分数也会有5份

(2)、None:默认为3折交叉验证

(3)、分割器:例如ShuffleSplit(n_splits=50,test_size=0.2,random_state=0)

即按照传入分割器进行分割

n_jobs:

需要同时运行的CPU数,如果是-1,则调用所有CPU进行计算

4、✌ 函数返回值

train_sizes_abs:

返回生成的训练的样本数,如[ 10 , 100 , 1000 ]

train_scores:

返回训练集分数,该矩阵为( len ( train_sizes_abs ) , cv分割数 )维的分数,

每行数据代表该样本数对应不同折的分数

test_scores:

同train_scores,只不过是这个对应的是测试集分数

5、✌ 代码示例

学习曲线就是通过画出不同训练集大小时训练集和交叉验证的准确率,可以看到模型在新数据上的表现,进而来判断模型是否方差偏高或偏差过高,以及增大训练集是否可以减小过拟合。

✌ 导库

from sklearn.datasets import load_digits # 导入手写数字集

from sklearn.model_selection import learning_curve # 导入学习曲线类

✌ 加载数据

fig,ax=plt.subplots(1,1,figsize=(6,6)) # 设置画布和子图

data=load_digits()

x,y=data.data,data.target # 加载特征矩阵和标签

✌ 画图

train_sizes,train_scores,test_scores=learning_curve(RandomForestClassifier(n_estimators=50),x,y,cv=10,n_jobs=4)

# 设置分类器为随机森林,x,y,5折交叉验证,cpu同时运算为4个

ax.set_ylim((0.7,1.1)) # 设置子图的纵坐标的范围为(0.7~1.1)

ax.set_xlabel("training examples") # 设置子图的x轴名称

ax.set_ylabel("score")

ax.grid() # 画出网图

ax.plot(train_sizes,np.mean(train_scores,axis=1),'o-',color='r',label='train score')

# 画训练集数据分数,横坐标为用作训练的样本数,纵坐标为不同折下的训练分数的均值

ax.plot(train_sizes,np.mean(test_scores,axis=1),'o-',color='g',label='test score')

ax.legend(loc='best') # 设置图例

plt.show()