因为学习原因,需要了解压缩感知。

找了几篇文章看了一下,结合之前稀疏表征的相关经验,简单的理解了一下,此处做个笔记,便于自己之后复习,也便于大家对压缩感知有一个初步的了解。

压缩感知的大体思路

面对实际中的信号,它可能数据规模十分的巨大,从而不便于传输与存储,所以我们需要对该信号进行一个压缩,然后将其进行传输或存储,之后再将其进行还原。

在现有的传统的信号处理模式中,信号要采样、压缩然后再传输,接收端要解压再恢复原始信号。

这里采样需要遵守奈奎斯特采样定律,而实际中采样的频率往往还高于奈奎斯特的2倍,从而导致采样的数据量其实也很大。

之后便是对采样得到的数据进行压缩,将数据交换到一个变换域上,然后将此变换域上的数值较大的数据保留下来,而大部分数值较小的数据被丢弃。如此之后,作为主要特征的信息便被提取出来,而大部分次要特征的信息被丢弃。由此便是对输入信号的压缩。

而压缩感知与传统的采样+压缩的模式不同的是,它首先不遵从奈奎斯特采样定理,其次,它并没有分为采样和压缩,应该说,压缩感知的采样就是压缩。

采样之后将采样的数据直接传输,之后在接收端便可以通过适当的重构算法进行重构

从奈奎斯特到压缩感知

下面就从熟悉的奈奎斯特来引入压缩感知。

奈奎斯特抽样定理指若频带宽度有限的,要从抽样信号中无失真地恢复原信号,抽样频率应大于2倍信号最高频率。

这是百度百科对于奈奎斯特定理的定义。

因为信号与系统已经是很久之前学的了,所以记得不是很深。

只记得是对频带宽度有限的信号,采样频率要大于2倍。

在频域上采样的频率要大于2倍最高频率,那么在时域上就要采样的时间间隔就要小于1/2的最小周期。

如此一来,从时域上看,在能够恢复出原始信号的要求上来看,较为密集的采样是避免不了的了。

同时,在实际中,采样的频率会更高,不止是2倍,可能是5倍,8倍甚至更高,那么此时,整体的采样时间间隔就会更小,采样会更密集。如此,采样的数据量就会很大。

在遵从奈奎斯特采样定理时,我们可以发现,这里有两个重要的点。

一个是2倍;一个是以一定频率进行采样。

以一定频率进行采样,其实就是在时域上进行等距离采样。

那么如果不等距离采样,是不是就不用遵循奈奎斯特定理了呢?

是的,压缩感知就是如此诞生的。

当对信号进行随机不等间距采样时,发现也是可以得

随机不等间距采样,使得频谱不再是整齐地搬移,而是一小部分一小部分胡乱地搬移,频率泄露均匀地分布在整个频域,因而泄漏值都比较小,从而有了恢复的可能。

因为是随机采样,所以频域上不是以固定周期进行延拓,会产生大量不相关的干扰值,这里也就是因为对原始信号进行的随机采样,间距不等,很可能频率远小于奈奎斯特要求,从而在频率上产生了大量的交叠。

但是原始信号的非零值还是存在的,而且可以通过阈值检测出来。之后再计算检测出的较大值所带来的干扰,消除干扰,降低阈值,迭代的去将原信号中频域非零值给提取出来。

所以,压缩感知的核心点在于,其不遵从奈奎斯特采样定理。而这原因在于,压缩感知的采样是随机的,不等间距的,故不用管奈奎斯特。

不过压缩感知也是有要求的,它需要保证信号是稀疏的。

一旦信号不稀疏,进行违背奈奎斯特的随机非等间距采样时,频域上的交叠会导致难以恢复原始信号。

在压缩感知过程中,如果将采样频率降低,使得其很小,那么采样的时域间隔就会相对很大,加上一定方式的随机采样,此时采样得到的数据量就会很小,从而实现了一种压缩。

这里采样即压缩。

压缩感知公式

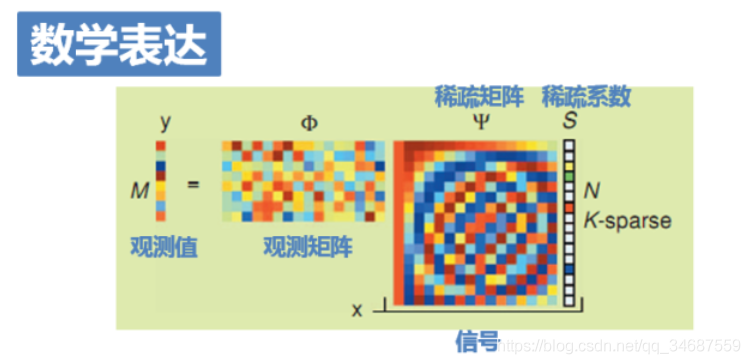

一般的,压缩感知的数学公式为 y = Φ x y=\Phi x y=Φx 其中 y y y是观测值,也就是我们随机的采样值, 而 Φ \Phi Φ是观测矩阵,也就是我们采样的规则, x x x 是我们的原始信号。

从这个公式我们来理解压缩感知。

从右到左,是采样的过程,已知 Φ \Phi Φ 和 x x x 求解 y y y ,对于原始信号,我们通过观测矩阵所描述的观测(采样)方式,从而获得了观测值(采样值)。当我们处理信号为稀疏信号时,那么便可以保证在采样阶段,观测值的数据量是远小于原始信号。

而从左到右,就是重构的过程,已知 y y y 和 Φ \Phi Φ 求解 x x x。

而在实际中,我们的信号 x x x 往往并不稀疏,那么此时便对其进行处理,使其变得稀疏,比如进行正交变换, x = Ψ s x = \Psi s x=Ψs 前者是正交变换矩阵,后者是信号被投影到的另一个空间的向量,它满足稀疏性。如此我们的公式便成了 y = Φ x = Φ Ψ s y=\Phi x = \Phi \Psi s y=Φx=ΦΨs 进一步,对待信号 x x x ,不仅可以进行正交变换,还可以进行稀疏分解,通过字典和稀疏码来表示信号 x x x,从而我们的公式便成了 y = Φ x = Φ D ∗ s y=\Phi x=\Phi D*s y=Φx=ΦD∗s 其中 D D D 是字典, s s s是对应的稀疏码。

(此处便是稀疏表征的概念,稀疏表征所起到的作用就是对于并不稀疏的信号,通过正交变换或者什么投影的方式,或者字典学习等,获取该信号的稀疏表示,从而适用于后序的压缩感知的进行。稀疏表征是压缩感知的前提之一,它是包含在压缩感知中的。)

针对上面说的信号的压缩感知来说,这里的 Φ \Phi Φ 就是对信号的随机采样的方式,而 Ψ \Psi Ψ 是对信号进行傅里叶变换,将其从时域转换到频域,使得信号变换到频域,变得稀疏,而 y y y 就是采样的结果

至此,我们便可以将前两个矩阵合并,从而最终的公式写成 y = Θ s y=\Theta s y=Θs Θ \Theta Θ我们称做传感矩阵。

进行采样是比较简单的,原始信号根据采样方式进行采样即可。

但重构比较麻烦。

问题即为,已知 y y y 和 Θ \Theta Θ,求解 s s s。

当 y y y 与 s s s 同一维度时,可以轻松解出 s s s。

而当 y y y 维度小于 s s s 时,边可以根据 s s s 的rip特性重构。(这里rip特性是有限等距性质)

参考资料

https://zhuanlan.zhihu.com/p/22445302

https://www.zhihu.com/question/28552876?sort=created