目录

前言:

这一篇论文是12年的论文可是引用量高达6w的论文,他是计算机视觉工作的基石。

因此非常有必要读一下

下面是从他开始衍生的算法

卷积层的计算

小窗口称之为感受页

池化层

(池化、下采样)

可以防止过拟合

神经网络的构造

为什么神经网络要用激活函数呢?

因为激活函数是非线性的,正是因为非线性的激活函数才为神经网络这个模型引入了非线性,他才能解决非线性的分类问题

然而传统的像Sigmoid和tanh这种饱和函数,不饱和的激活函数可以解决梯度消失的问题。

下图通过两个神经元完成神经网络的输出

softmax归一化

在这篇论文中有个有趣的地方

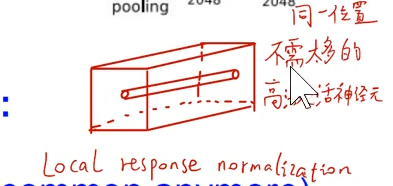

局部响应归一化

每一个值进行归一化,可以有效的抑制局部神经元

举个具体例子

LNN局部响应归一化

可以达到效果:

抑制附近的激活

然而,LRN层已经被推翻,并没有任何X用

数据扩充可以有效防止,减少过拟合的方法

Dropout

随机掐死,每一个dropout层都有0.5的被置换为1

如无必要,不要增加实体--- 剃刀原理

参考文献:

- b站豪哥

- AlexNet论文