一、服务器

- 操作系统:CentOS Linux release 7.6.1810 (Core)

二、JAVA

- JDK1.8:oraclce官网下载jdk-8u261-linux-x64.tar.gz

- 命令行环境:配置/etc/profile命令行环境

export JAVA_HOME=/usr/local/java/jdk1.8.0_261

export PATH=$JAVA_HOME/bin:$PATH

三、HDFS

下载hadoop安装包,这里我下载的是hadoop2.10版本,https://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-2.10.0/hadoop-2.10.0.tar.gz

我们将使用用户hadoop来运行HDFS

- 新增hadoop用户

useradd hadoop

- 配置hadoop的shell环境

vi /home/hadoop/.bashrc

export JAVA_HOME=/usr/local/java/jdk1.8.0_261

export HADOOP_HOME=/home/hadoop/bigdata/hadoop

export HADOOP_USER_NAME=hadoop

export PATH=$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

- ssh无密码登录配置

$ ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

$ chmod 0600 ~/.ssh/authorized_keys

配置好之后通过"ssh localhost"的方式确认可以不输入密码自动登录

ssh localhost

- 配置core-site.xml 和 hdfs-site.xml

- core-site.xml:

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost</value>

</property>

</configuration>

- hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

- 启动HDFS

bin/hdfs namenode -format#格式化文件系统

sbin/start-dfs.sh#启动名称节点和数据节点

通过jps命令查看java的进程,应该有三个,分别对应NameNode, SecondaryNameNode, DataNode。

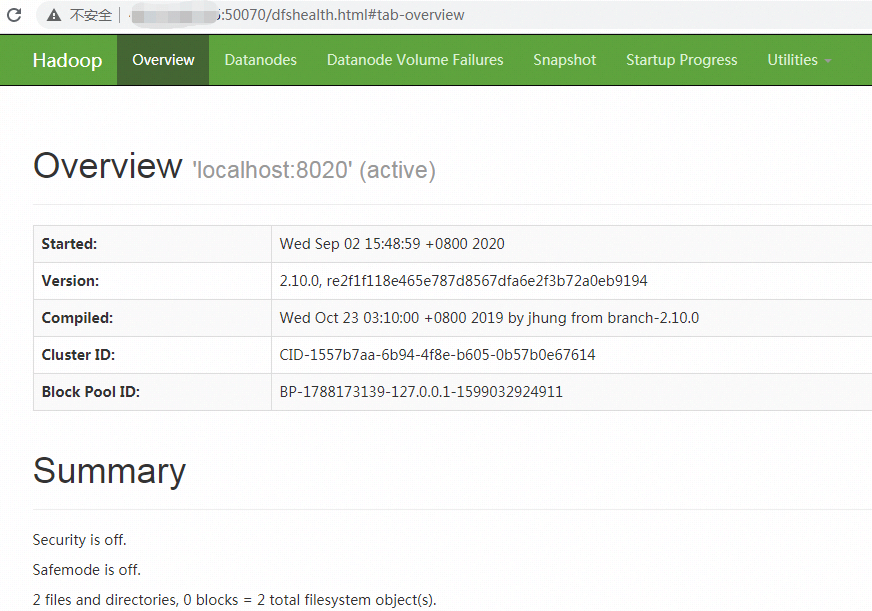

访问web网页查看名称节点状态,这里需要注意如果是hadoop2的话端口是50070,如果是hadoop3的话端口是9870,我下载的是hadoop2,所以端口是50070。

停止HDFS

sbin/stop-dfs.sh

参考

- https://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-common/SingleCluster.html#Standalone_Operation

- https://blog.csdn.net/xuexueloveair/article/details/90300603